在ubuntu下使用Eclipse搭建Hadoop开发环境

一、安装准备

1、JDK版本:jdk1.7.0(jdk-7-linux-i586.tar.gz)

2、hadoop版本:hadoop-1.1.1(hadoop-1.1.1.tar.gz)

3、eclipse版本:Eclipse Java EE IDE for Web Developers.

Version: Juno Service Release 1

Build id: 20120920-0800(eclipse-jee-juno-SR1-linux-gtk.tar.gz)

4、eclipse与hadoop集成插件:hadoop-eclipse-plugin-1.1.1.jar

5、操作系统:ubuntu10.10

注:jdk、hadoop、eclipse、hadoop-eclipse-plugin存在兼容问题,建议大家按上面的版本进行实践(本人在搭建该环境时吃了不少亏~~)。

二、安装操作

1、安装JDK,此步省略…(不懂的点击这里 )。

2、安装hadoop,此步省略…(不懂的点击这里 )。

3、安装eclipse,操作步骤如下:

1)、把安装文件拷贝到home目录下

cp eclipse-jee-juno-SR1-linux-gtk.tar.gz /home

2)、安装eclipse(即解压就可使用)

tar -zxvf eclipse-jee-juno-SR1-linux-gtk.tar.gz

4)、启动eclipse,并创建workspace作为eclipse的工作空间

cd /home/eclipse #切换到eclipse目录下

./eclipse

三、配置Eclipse、Hadoop开发环境

第一步:安装Eclipse-Hadoophadoop集成插件

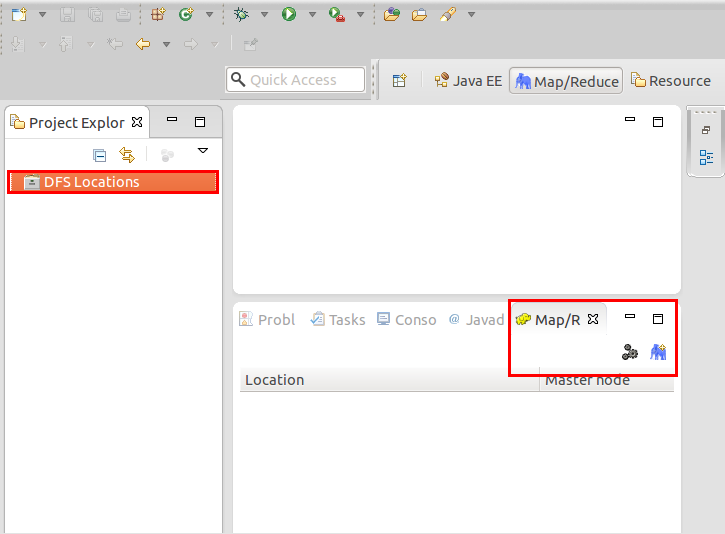

把hadoop-eclipse-plugin-1.1.1.jar插件放到/home/eclipse/plugins中,然后重新启动Eclipse如下图。

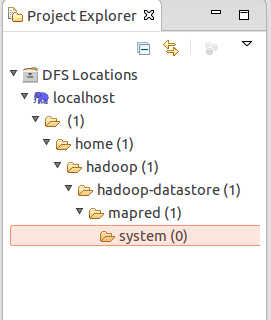

细心的你从上图左侧“Project Explorer”下面发现“DFS Locations”,说明Eclipse已经识别刚才放入的Hadoop Eclipse插件了。

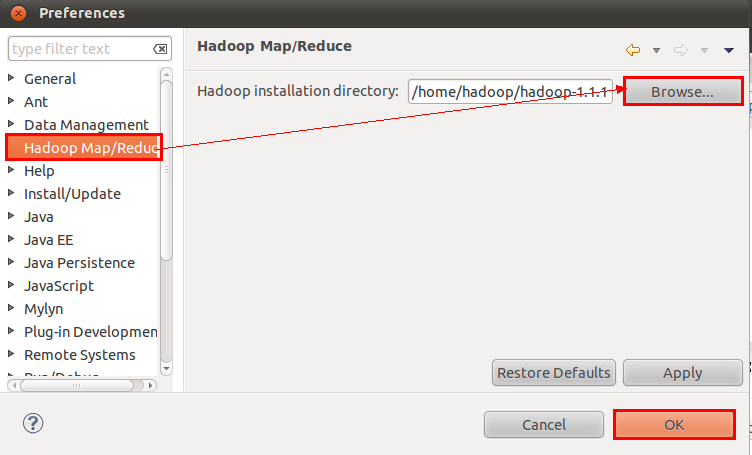

第二步:在Eclipse中指定Hadoop的安装目录

选择“Window”菜单下的“Preference”,然后弹出一个窗体,在窗体的左侧中找到“Hadoop Map/Reduce”选项,点击此选项,选择Hadoop的安装目录(如我的Hadoop目录:/home/hadoop/hadoop-1.1.1)。结果如下图:

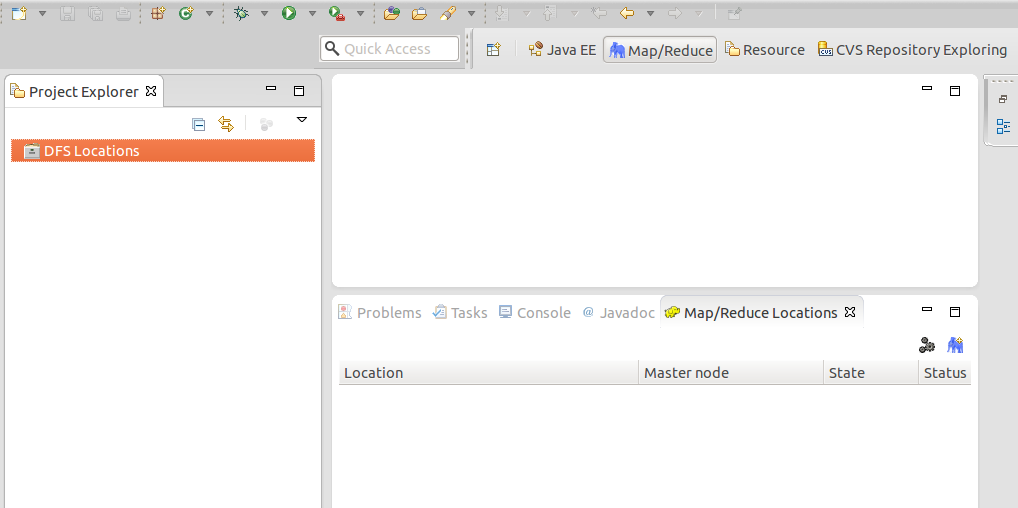

第三步:切换“Map/Reduce”工作目录

有两种方法:

1)、选择“Window”菜单下选择“Open Perspective–>Other”,弹出一个窗体,从中选择“Map/Reduce”选项即可进行切换。

2)、在Eclipse软件的右上角,点击图标“![]() ”中的“

”中的“![]() ”,从中选择“Map/Reduce”,然后点击“OK”即可确定。

”,从中选择“Map/Reduce”,然后点击“OK”即可确定。

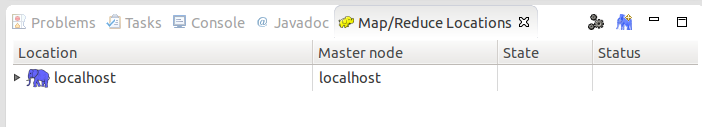

切换到“Map/Reduce”工作目录下的界面如下图所示。

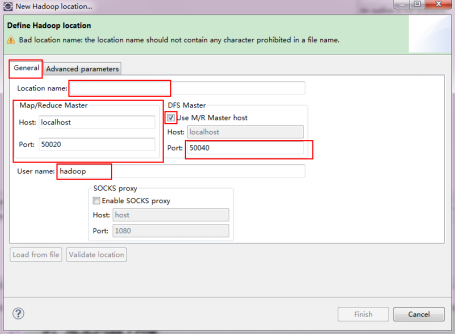

第四步:配置DFS Locations

建立与Hadoop集群的连接,在Eclipse软件下面的“Map/Reduce Locations”进行右击,弹出一个选项,选择“New Hadoop Location ”,然后弹出一个窗体。

注意上图中的红色标注的地方,是需要我们关注的地方。

Location Name:可以任意填,标识一个“Map/Reduce Location”

Map/Reduce Master

Host:xx.xx.xx.xx(Master.Hadoop的IP地址,即/home/hadoop/hadoop-1.1.1/conf/mapred-site.xml中ip)

Port:xx(即/home/hadoop/hadoop-1.1.1/conf/mapred-site.xml中端口)

DFS Master

Use M/R Master host:前面的勾上。(因为我们的NameNode和JobTracker都在一个机器上。)

Host:xx.xx.xx.xx(/home/hadoop/hadoop-1.1.1/conf/core-site.xml中ip)

Port:xxxx (/home/hadoop/hadoop-1.1.1/conf/core-site.xml中端口)

User name:hadoop(操作hadoop的用户)

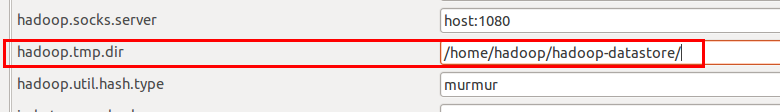

接着点击“Advanced parameters”从中找到“hadoop.tmp.dir”,修改成为我们Hadoop集群中设置的地址,我们的Hadoop集群是“/home/hadoop/hadoop-datastore/”,这个参数在“core-site.xml”进行了配置。

再从中找到“fs.default.name”,修改成为我们Hadoop集群中设置的地址,我们的Hadoop集群是“hdfs://localhost:54310”,这个参数在“core-site.xml”进行了配置。

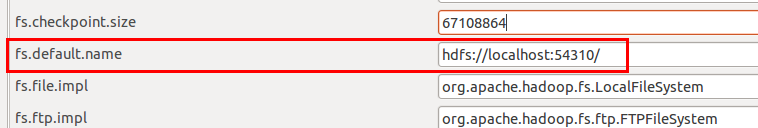

点击“finish”之后,会发现Eclipse软件下面的“Map/Reduce Locations”出现一条信息, 就是我们刚才建立的“Map/Reduce Location ”。

第五步:查看HDFS文件系统

查看HDFS文件系统,点击Eclipse软件左侧的“DFS Locations”下面的“localhost”,就会展示出HDFS上的文件结构(记得要先启动hadoop,不然看不到效果)。

到此为止,我们的Hadoop Eclipse开发环境已经配置完毕。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· winform 绘制太阳,地球,月球 运作规律

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· 写一个简单的SQL生成工具

· AI 智能体引爆开源社区「GitHub 热点速览」