docker网络

Docker网络

理解Docker0

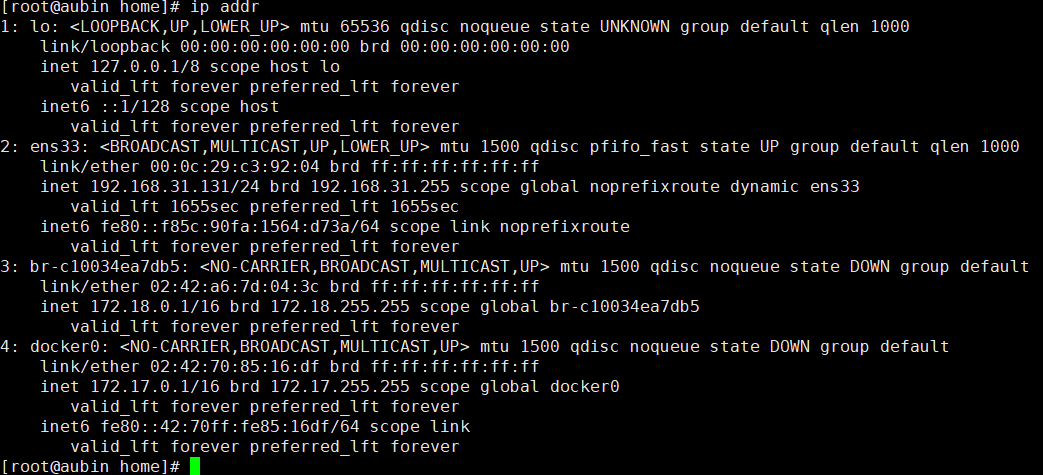

清空Docker0

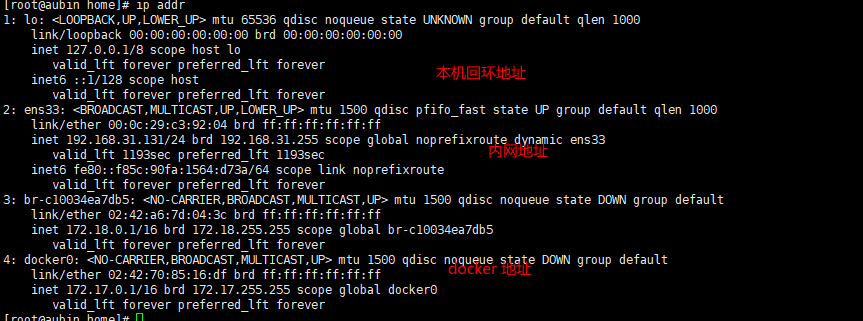

三个网路

lo:本地回环地址

docker0就是docker0地址,也就是docker的地址

dockre使用的是桥接模式,使用的技术是evth_pair技术,

#问题 docker 是如何处理容器网络访问的

docker run -d -P --name tomcat01 tomcat:9.0

# 查看容器内部的网络地址

[root@aubin home]# docker exec -it 7b573b2f6c1e ip addr

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

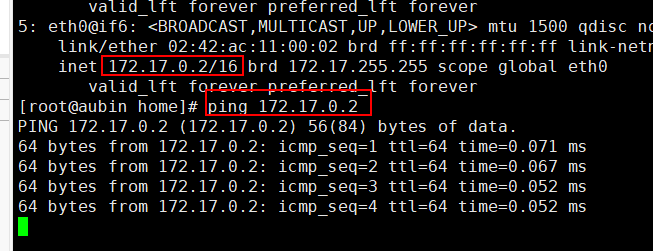

5: eth0@if6: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

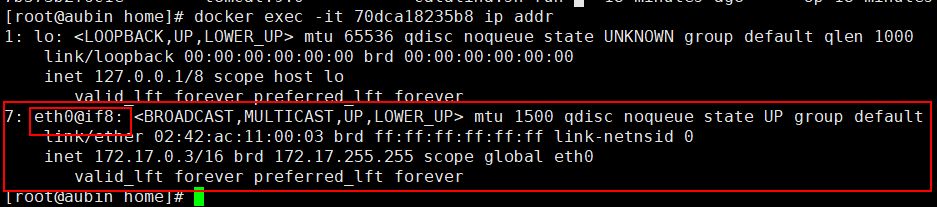

# 可以看到有两个网卡 一个是回环地址,另一个eth0@if6 ip地址,这个就是Docker分配的。

# 思考 我们的linux能ping通容器内部的ip地址(猜测是可以的,不然我们怎么能访问呢?)

我们来 看一下

linux可以ping通docker容器内部。

原理

只要是在同一个网段,就是可以ping 通的。

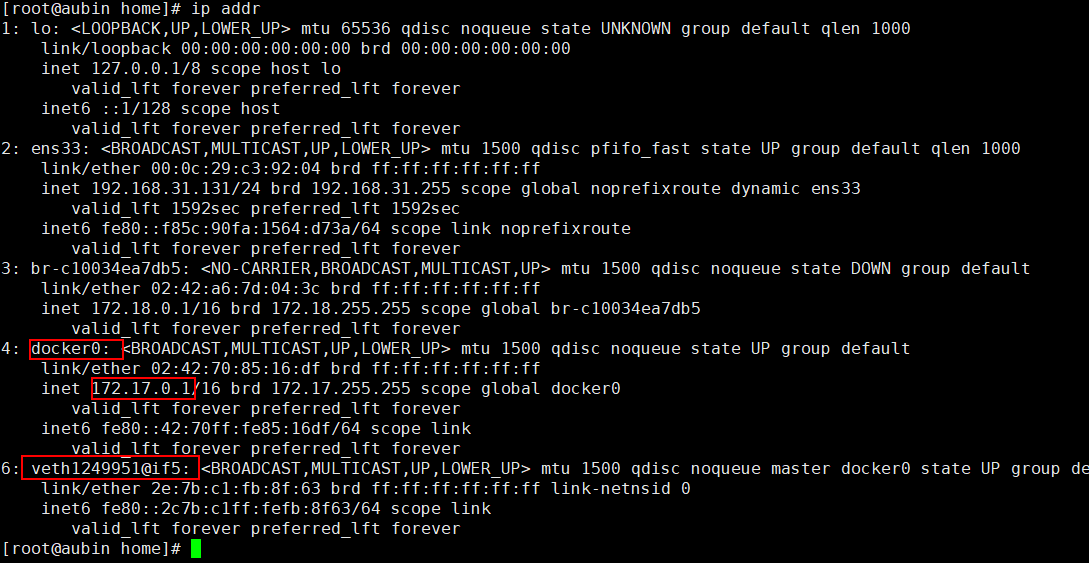

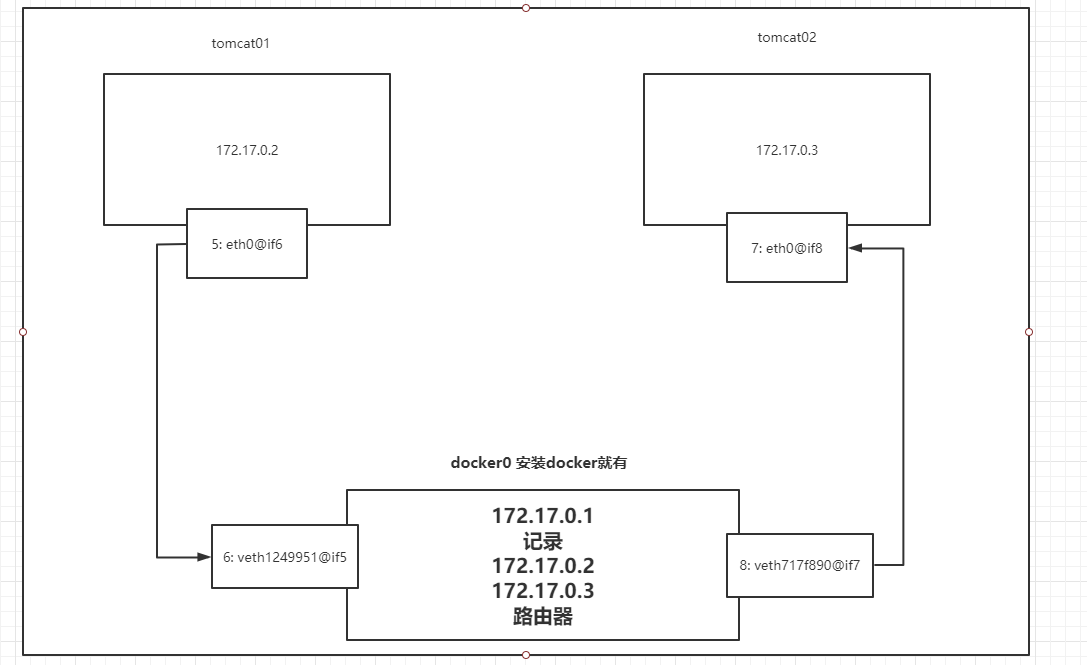

1、我们每启动一个Docker容器,docker就会给docker容器分配一个ip,我们只要安装了docker,就会有一个网卡docker0桥接模式,使用的是evth-pair技术。

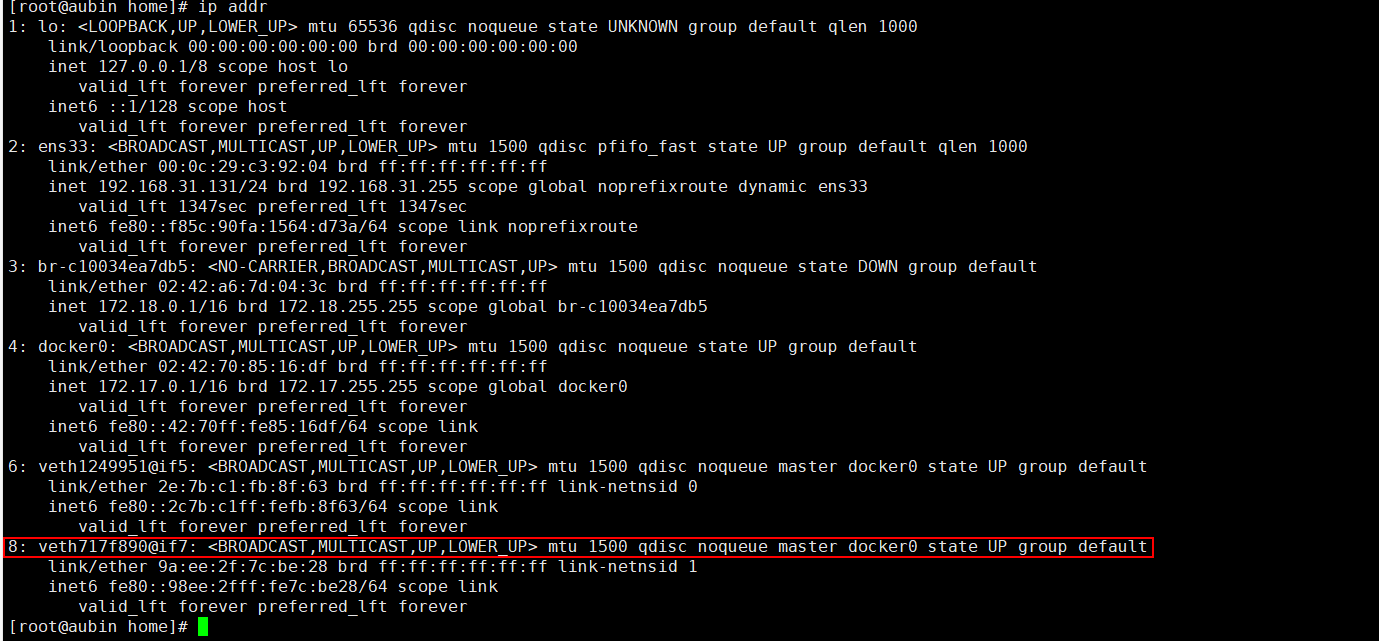

可以看出,相比较于上面的多了一个网卡veth1249951@if5,和我们在容器内部看到的eth0@if6 有些相似。猜测,这就类似于在同一个网段。

2、在启动一个容器测试,发现又多了一个网卡

发现这个容器带来的网卡,都是成对出现的。

evth-pair 就是一对的虚拟设备接口,他们都是成对出现的,一段连着协议,一段彼此连接。正因为有这个特性,evth-pair充当一个桥梁,连接各种虚拟网络设备的。

3、测试tocmat01和tomcat02是否可以ping通

[root@aubin home]# docker exec -it tomcat01 ping 172.17.0.3

PING 172.17.0.3 (172.17.0.3) 56(84) bytes of data.

64 bytes from 172.17.0.3: icmp_seq=1 ttl=64 time=0.066 ms

64 bytes from 172.17.0.3: icmp_seq=2 ttl=64 time=0.060 ms

64 bytes from 172.17.0.3: icmp_seq=3 ttl=64 time=0.060 ms

64 bytes from 172.17.0.3: icmp_seq=4 ttl=64 time=0.062 ms

结论:容器和容器之间是可以相互ping通的

网络模型图:

结论:tomcat01和tomcat02 是共用的一个路由器——docker0.

所有的容器不指定网络的情况下,都是docker0路由的,docker会给我们的容器分配一个默认的可用ip

小结

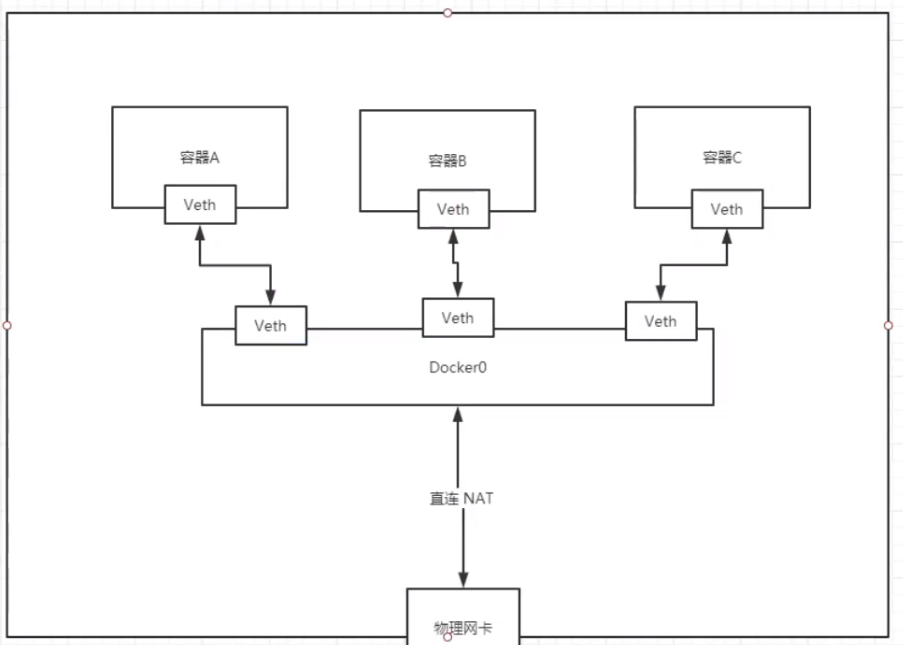

Docker使用的是Linux的桥接,宿主机中是一个Docker容器的网桥 Docker 0

Docker中的所有网络接口都是虚拟的,虚拟的转发效率高。

只要容器删除,对应的一对网桥就会删除。

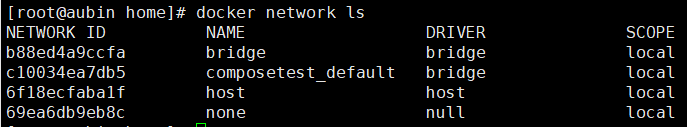

docker network ls 列出所有网络

docker network inspect NETWORKID 查看对应的网络的详细信息

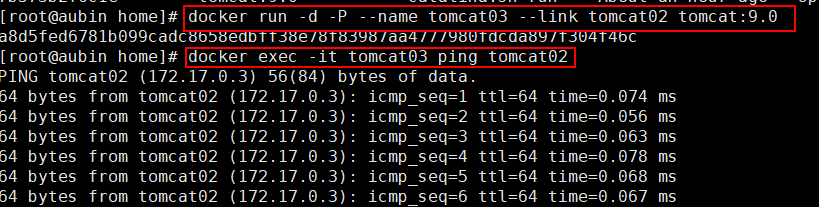

--link

思考:我们编写一个微服务,里面有database url=ip 这样的地址连接,如果重启docker,就会分配一个新的ip地址,那么我们直接写在配置文件中,每次修改都很麻烦,有什么办法可以解决吗?

我们可以像微服务一样,直接写服务名,他会自动的帮我们去找到对应的mysql。这个方法就是使用--link命令

我们直接ping是ping不通的。

[root@aubin home]# docker exec -it tomcat01 ping tomcat02

ping: tomcat02: Name or service not known

下面我们就来解决这个问题

run -d -P --name tomcat03 --link tomcat02 tomcat:9.0

docker exec -it tomcat03 ping tomcat02

通过--link 就可以解决了网络连通问题。

反向能够ping通吗?

[root@aubin home]# docker exec -it tomcat02 ping tomcat03

ping: tomcat03: Name or service not known

可以看到,反向是ping不同的。

利用docker network ls列出所有网络

[root@aubin home]# docker network ls

NETWORK ID NAME DRIVER SCOPE

b88ed4a9ccfa bridge bridge local

c10034ea7db5 composetest_default bridge local

6f18ecfaba1f host host local

69ea6db9eb8c none null local

bridge就是本地网卡

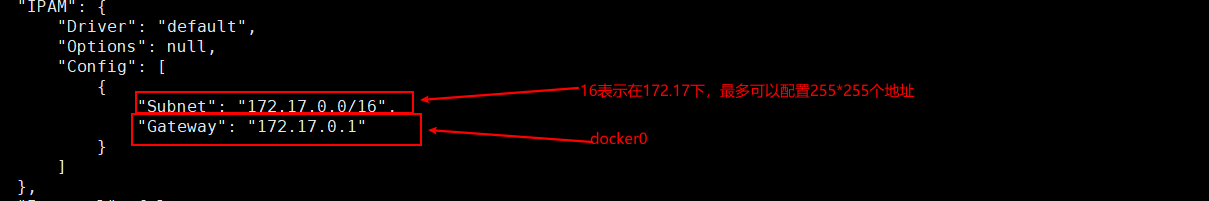

我们利用docker network inspect NETWORKID查看具体的信息

查看本地网卡bridge

[root@aubin home]# docker network inspect b88ed4a9ccfa

[

{

"Name": "bridge",

"Id": "b88ed4a9ccfab41a56d54bbd15d7598f40210994738164eaa55ce64bbd783e22",

"Created": "2020-10-25T02:37:37.229220309+08:00",

"Scope": "local",

"Driver": "bridge",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": null,

"Config": [

{

"Subnet": "172.17.0.0/16",

"Gateway": "172.17.0.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {

"70dca18235b8c91fd79662d0afab1240e5c3eb0a3fea3fda1fc3f3604b220e59": {

"Name": "tomcat02",

"EndpointID": "9bcdf4a21bbbea463588febae858efe1c6ba79b3ff0cc5b80616da7de01ff9e8",

"MacAddress": "02:42:ac:11:00:03",

"IPv4Address": "172.17.0.3/16",

"IPv6Address": ""

},

"7b573b2f6c1efa59c9bc9fedb86b74494b3404c20a16ba904f1242a0c4d3bc4e": {

"Name": "tomcat01",

"EndpointID": "57db083f84c4fd54af2e4d7507b6bc66a5c11a327c8f48a30fce7d3e628596b2",

"MacAddress": "02:42:ac:11:00:02",

"IPv4Address": "172.17.0.2/16",

"IPv6Address": ""

},

"a8d5fed6781b099cadc8658edbff38e78f83987aa4777980fdcda897f304f46c": {

"Name": "tomcat03",

"EndpointID": "e8bc55768b9be233a5c758f86b169d801fcd1778a2cb8a5d82dd7531ab3920dd",

"MacAddress": "02:42:ac:11:00:04",

"IPv4Address": "172.17.0.4/16",

"IPv6Address": ""

}

},

"Options": {

"com.docker.network.bridge.default_bridge": "true",

"com.docker.network.bridge.enable_icc": "true",

"com.docker.network.bridge.enable_ip_masquerade": "true",

"com.docker.network.bridge.host_binding_ipv4": "0.0.0.0",

"com.docker.network.bridge.name": "docker0",

"com.docker.network.driver.mtu": "1500"

},

"Labels": {}

}

]

--link本质探究

[root@aubin home]# docker exec -it tomcat03 cat /etc/hosts

127.0.0.1 localhost

::1 localhost ip6-localhost ip6-loopback

fe00::0 ip6-localnet

ff00::0 ip6-mcastprefix

ff02::1 ip6-allnodes

ff02::2 ip6-allrouters

172.17.0.3 tomcat02 70dca18235b8

172.17.0.4 a8d5fed6781b

[root@aubin home]# docker exec -it tomcat02 cat /etc/hosts

127.0.0.1 localhost

::1 localhost ip6-localhost ip6-loopback

fe00::0 ip6-localnet

ff00::0 ip6-mcastprefix

ff02::1 ip6-allnodes

ff02::2 ip6-allrouters

172.17.0.3 70dca18235b8

可以看出tomcat03的host文件中绑定了tomcat02的地址,所以可以ping通,而tomcat02中没有配置,所以没有ping通。

现在使用Docker不建议使用--link命令了,需要自定义网络,就是不使用docker0。

docker0问题:不支持容器名连接访问。

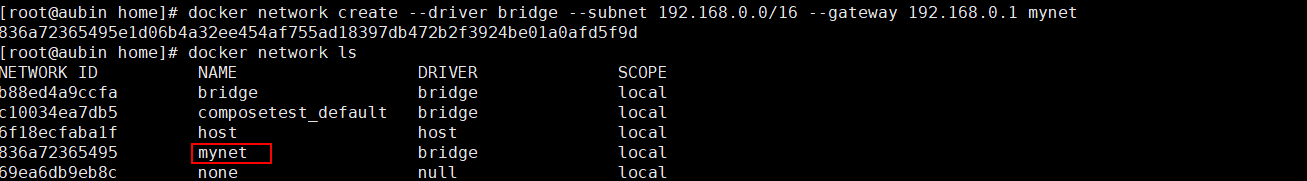

自定义网络

查看所有的Docker网络

网络模式:

bridge:桥接模式(默认)

none:不配置网络

host:和宿主机共享网络

container:容器内网络联通(不建议使用)

自己创建网卡:

在创建之前要清空我们的docker容器,这样好测试

docker rm -f $(dcoker ps -qa)

这时,网卡就回到了初始的状态

然后,我们就自己创建网卡。

# 我们直接启动的命令 是有一个默认的 --net bridge参数。而这个就是我们的docker0

docker run -d -P --name tomcat01 tomcat:9.0

docker run -d -P --name tomcat01 --net bridge tomcat:9.0

# docker0特点: 默认的网络,域名不能访问, --link可以打通连接

# 我们可以自定义一个网络

创建网络的命令

[root@aubin home]# docker network create --help

Usage: docker network create [OPTIONS] NETWORK

Create a network

Options:

--attachable Enable manual container attachment

--aux-address map Auxiliary IPv4 or IPv6 addresses used by Network driver (default map[])

--config-from string The network from which copying the configuration

--config-only Create a configuration only network

-d, --driver string Driver to manage the Network (default "bridge")

--gateway strings IPv4 or IPv6 Gateway for the master subnet

--ingress Create swarm routing-mesh network

--internal Restrict external access to the network

--ip-range strings Allocate container ip from a sub-range

--ipam-driver string IP Address Management Driver (default "default")

--ipam-opt map Set IPAM driver specific options (default map[])

--ipv6 Enable IPv6 networking

--label list Set metadata on a network

-o, --opt map Set driver specific options (default map[])

--scope string Control the network's scope

--subnet strings Subnet in CIDR format that represents a network segment

创建网络

# 这条命令就是创建了 一个名为mynet 子网掩码为192.168.0.0/16,路由ip为192.168.0.1的网络

# --driver bridge

# --subnet 192.168.0.0/16 192.168.0.2 192.168.255.255

# --gateway 192.168.0.1

docker network create --driver bridge --subnet 192.168.0.0/16 --gateway 192.168.0.1 mynet

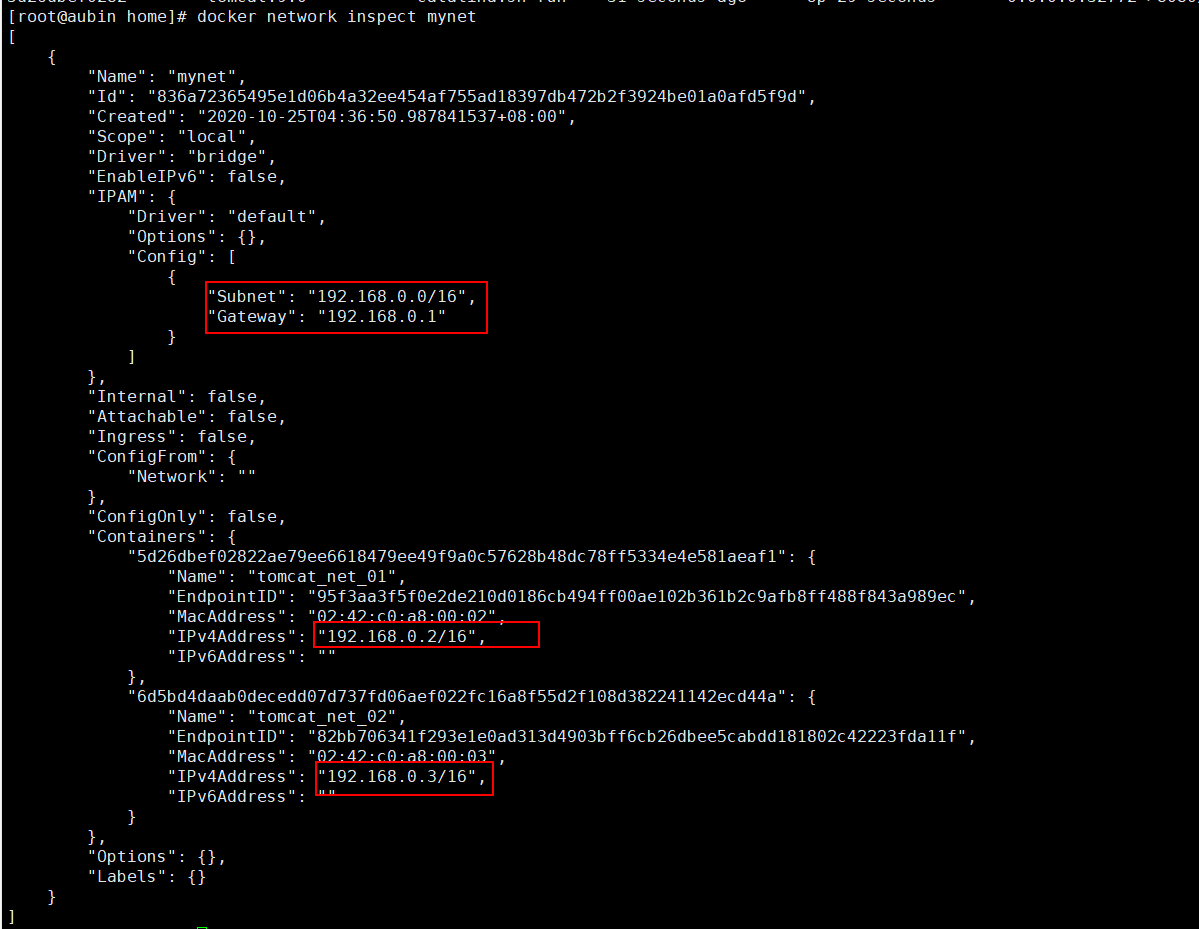

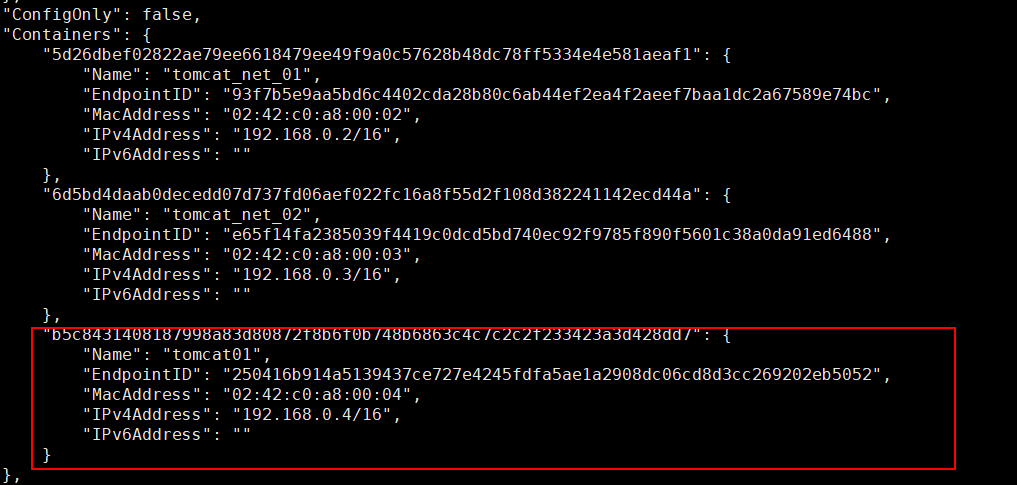

查看我们的网络docker network inspect mynet,到这里,我们自己的网络就创建好了。

[root@aubin home]# docker network inspect mynet

[

{

"Name": "mynet",

"Id": "836a72365495e1d06b4a32ee454af755ad18397db472b2f3924be01a0afd5f9d",

"Created": "2020-10-25T04:36:50.987841537+08:00",

"Scope": "local",

"Driver": "bridge",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": {},

"Config": [

{

"Subnet": "192.168.0.0/16",

"Gateway": "192.168.0.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {},

"Options": {},

"Labels": {}

}

]

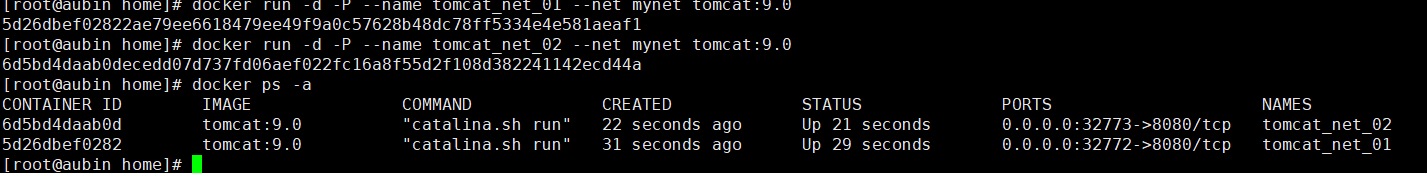

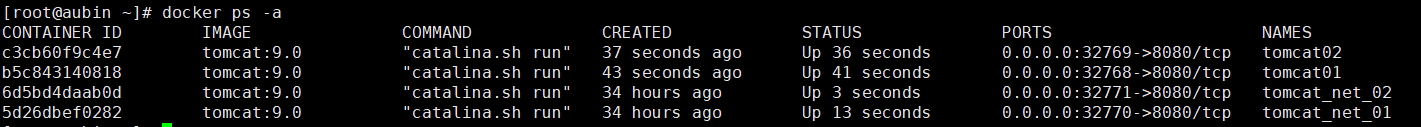

启动一个容器发布到我们自己创建好的网络中

docker run -d -P --name tomcat_net_01 --net mynet tomcat:9.0

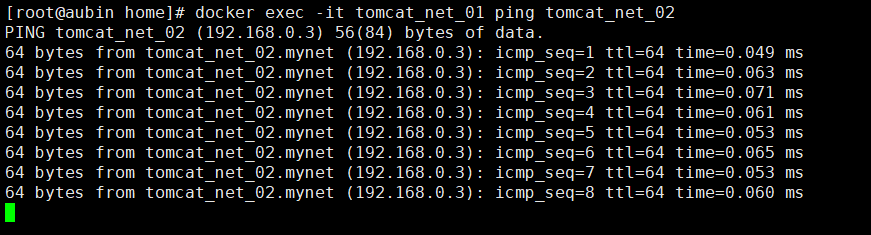

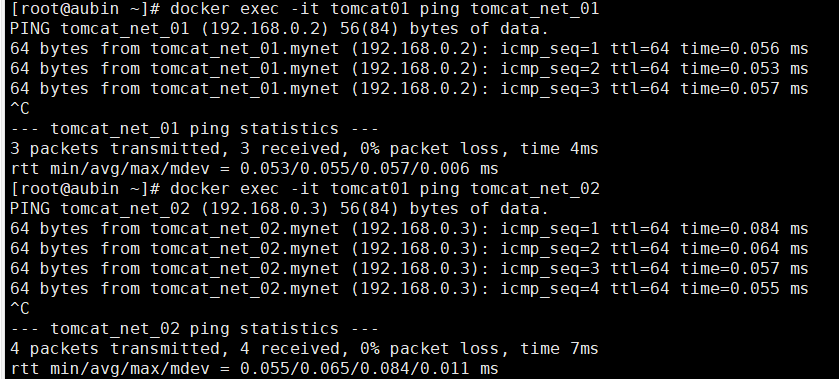

默认的情况下通过容器名是ping不通的,这里我们来试一下,看看能不能ping通

可以看出,是可以ping通的!!!

我们自定义的网络docker都已经帮我们维护好了对应的关系,推荐我们平时这样使用网络。

好处:不同的集群使用不同的网络,保证集群是安全和健康的

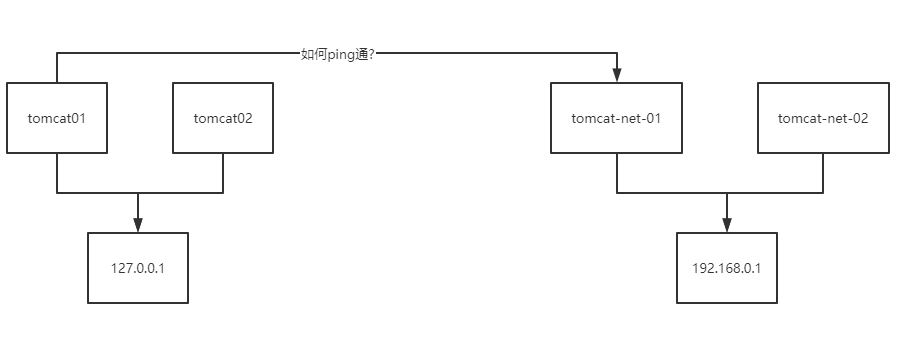

网络联通

如何让不在一个网段的容器之间ping通呢?

当然,我们直接无法ping通,那我们可不可以让tomcat01联通到路由呢?

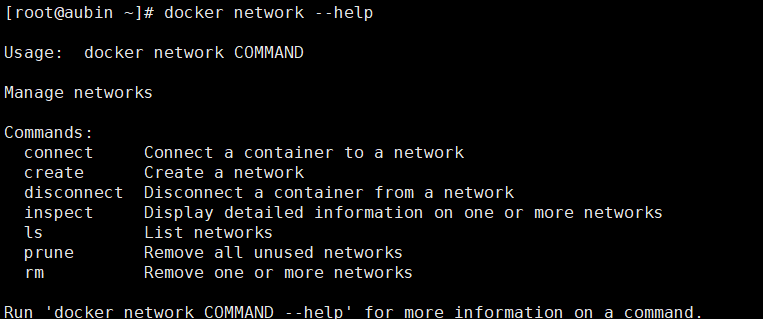

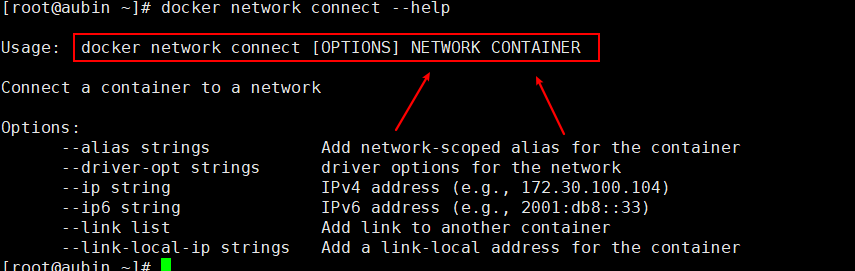

我们查看一下帮助文档

可以看到docker network 帮助文档中有个connect命令——将容器连接到网络.

测试打通tomcat01---->mynet

# 将tomcat01 连接到mynet网络

docker network connect mynet tomcat01

我们来查看mynet的网络信息

docker network inspect mynet

可以看到tomcat01已经加入到了mynet这个网络中了。这种情况在官方叫做一个容器两个ip

测试:能tomcat01是否能连接tomcat_net_01/tomcat_net_02

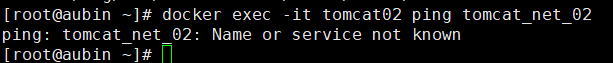

结果:tomcat01可以ping通mynet网络中的容器,tomcat02还是无法ping通。

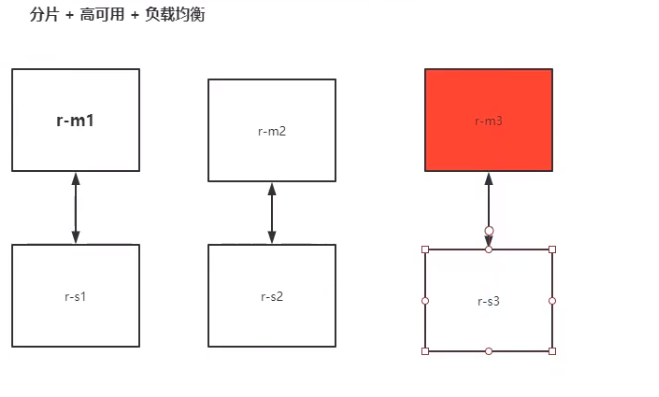

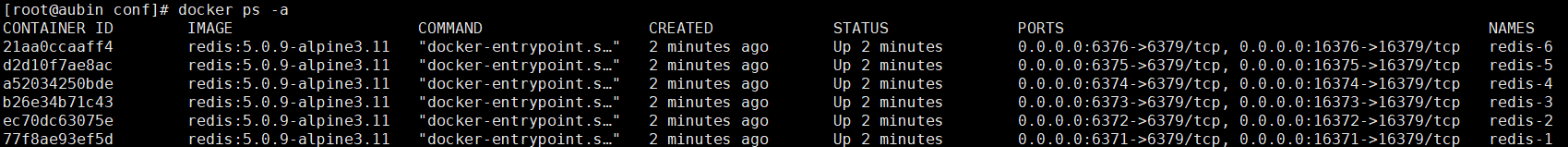

实战:部署Redis集群

有6台redis服务器,m为主机,r为从机,如果主机挂了,从机要替代主机工作。

1、启动redis

相关的shell脚本

# 创建网卡

docker network create redis --subnet 172.38.0.0/16

[root@aubin ~]# docker network create redis --subnet 172.38.0.0/16

b3c447ee5af4cb44e7d3cfef808c482460d565c32412f8bdf385da44b426f900

[root@aubin ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

9e7eafbb261f bridge bridge local

c10034ea7db5 composetest_default bridge local

6f18ecfaba1f host host local

836a72365495 mynet bridge local

69ea6db9eb8c none null local

b3c447ee5af4 redis bridge local

[root@aubin ~]# docker network inspect redis

[

{

"Name": "redis",

"Id": "b3c447ee5af4cb44e7d3cfef808c482460d565c32412f8bdf385da44b426f900",

"Created": "2020-10-26T15:19:23.852492453+08:00",

"Scope": "local",

"Driver": "bridge",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": {},

"Config": [

{

"Subnet": "172.38.0.0/16"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {},

"Options": {},

"Labels": {}

}

]

编写redis配置文件相关的shell脚本

# 通过脚本创建6个redis配置

for port in $(seq 1 6);\

do \

# 创建redis的配置文件

mkdir -p /mydata/redis/node-${port}/conf

touch /mydata/redis/node-${port}/conf/redis.conf

cat << EOF >/mydata/redis/node-${port}/conf/redis.conf

port 6379

bind 0.0.0.0

cluster-enabled yes

cluster-config-file nodes.conf

cluster-node-timeout 5000

cluster-announce-ip 172.38.0.1${port}

cluster-announce-port 6379

cluster-announce-bus-port 16379

appendonly yes

EOF

done

# 启动redis的shell脚本

for port in $(seq 1 6);

do

docker run -p 637${port}:6379 -p 1637${port}:16379 --name redis-${port} \

-v /mydata/redis/node-${port}/data:/data \

-v /mydata/redis/node-${port}/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.1${port} redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

done

# 或者一个个写

docker run -p 6372:6379 -p 16372:16379 --name redis-2 \

-v /mydata/redis/node-2/data:/data \

-v /mydata/redis/node-2/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.12 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6373:6379 -p 16373:16379 --name redis-3 \

-v /mydata/redis/node-3/data:/data \

-v /mydata/redis/node-3/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.13 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6374:6379 -p 16374:16379 --name redis-4 \

-v /mydata/redis/node-4/data:/data \

-v /mydata/redis/node-4/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.14 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6375:6379 -p 16375:16379 --name redis-5 \

-v /mydata/redis/node-5/data:/data \

-v /mydata/redis/node-5/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.15 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

docker run -p 6376:6379 -p 16376:16379 --name redis-6 \

-v /mydata/redis/node-6/data:/data \

-v /mydata/redis/node-6/conf/redis.conf:/etc/redis/redis.conf \

-d --net redis --ip 172.38.0.16 redis:5.0.9-alpine3.11 redis-server /etc/redis/redis.conf

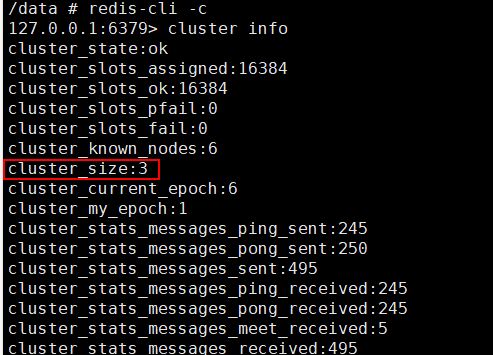

2、创建集群

[root@aubin conf]# docker exec -it redis-1 /bin/sh

/data # ls

appendonly.aof nodes.conf

# --cluster-replicas 集群切片

redis-cli --cluster create 172.38.0.11:6379 172.38.0.12:6379 172.38.0.13:6379 172.38.0.14:6379 172.38.0.15:6379 172.38.0.16:6379 --cluster-replicas 1

/data # redis-cli --cluster create 172.38.0.11:6379 172.38.0.12:6379 172.38.0.13:6379 172.38.0.14:6379 172.38.0.15:6379 172.38.0.16:6379 --cluster-replicas 1

>>> Performing hash slots allocation on 6 nodes...

Master[0] -> Slots 0 - 5460

Master[1] -> Slots 5461 - 10922

Master[2] -> Slots 10923 - 16383

Adding replica 172.38.0.15:6379 to 172.38.0.11:6379

Adding replica 172.38.0.16:6379 to 172.38.0.12:6379

Adding replica 172.38.0.14:6379 to 172.38.0.13:6379

M: e6deb53d6e5419109ba62fdeea071928f940746d 172.38.0.11:6379

slots:[0-5460] (5461 slots) master

M: 779fa83ff7745e8c8f0926a735c0b7c7c91e4f9f 172.38.0.12:6379

slots:[5461-10922] (5462 slots) master

M: c8ec1a95830f2548a4c2419dbb3b105614c77d2c 172.38.0.13:6379

slots:[10923-16383] (5461 slots) master

S: ab02fa95b2a40518a110cd77368815e6990bfea6 172.38.0.14:6379

replicates c8ec1a95830f2548a4c2419dbb3b105614c77d2c

S: 432e32892ca7397bee43a33a819b81d8dafdc692 172.38.0.15:6379

replicates e6deb53d6e5419109ba62fdeea071928f940746d

S: 66244ee01d908b775c0d26bf005c66dea0760444 172.38.0.16:6379

replicates 779fa83ff7745e8c8f0926a735c0b7c7c91e4f9f

Can I set the above configuration? (type 'yes' to accept): yes

>>> Nodes configuration updated

>>> Assign a different config epoch to each node

>>> Sending CLUSTER MEET messages to join the cluster

Waiting for the cluster to join

...

>>> Performing Cluster Check (using node 172.38.0.11:6379)

M: e6deb53d6e5419109ba62fdeea071928f940746d 172.38.0.11:6379

slots:[0-5460] (5461 slots) master

1 additional replica(s)

S: 432e32892ca7397bee43a33a819b81d8dafdc692 172.38.0.15:6379

slots: (0 slots) slave

replicates e6deb53d6e5419109ba62fdeea071928f940746d

M: c8ec1a95830f2548a4c2419dbb3b105614c77d2c 172.38.0.13:6379

slots:[10923-16383] (5461 slots) master

1 additional replica(s)

S: 66244ee01d908b775c0d26bf005c66dea0760444 172.38.0.16:6379

slots: (0 slots) slave

replicates 779fa83ff7745e8c8f0926a735c0b7c7c91e4f9f

S: ab02fa95b2a40518a110cd77368815e6990bfea6 172.38.0.14:6379

slots: (0 slots) slave

replicates c8ec1a95830f2548a4c2419dbb3b105614c77d2c

M: 779fa83ff7745e8c8f0926a735c0b7c7c91e4f9f 172.38.0.12:6379

slots:[5461-10922] (5462 slots) master

1 additional replica(s)

[OK] All nodes agree about slots configuration.

>>> Check for open slots...

>>> Check slots coverage...

[OK] All 16384 slots covered.

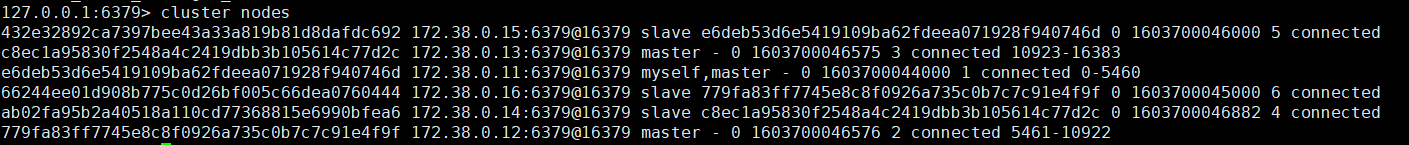

三主三从:11、12、13为主,14、15、16为从

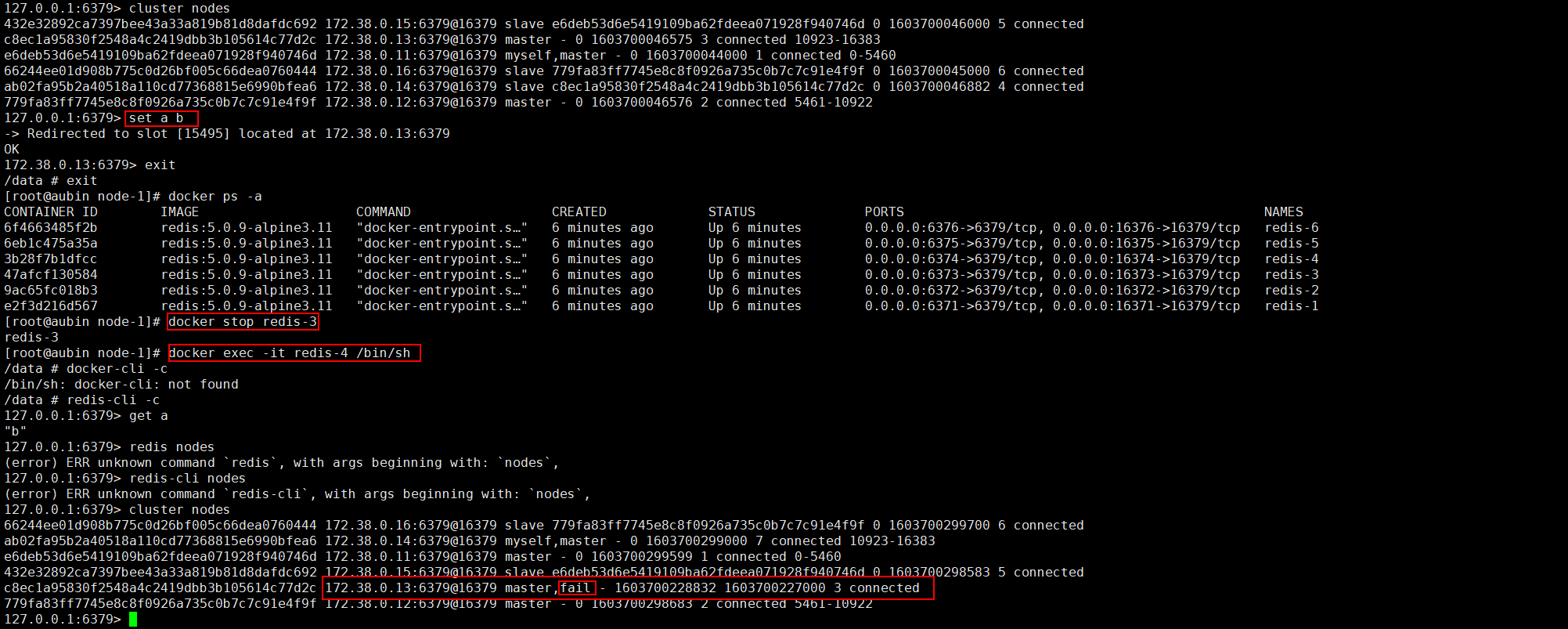

我们设置一个值

set a b

我们将13这台机器停止了,看看还能不能获取值。停止13,进入14,然后获取值,可以看到,获取到了值。查看节点信息,13这台机器已经停止。

浙公网安备 33010602011771号

浙公网安备 33010602011771号