爬虫综合大作业

作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3159

爬虫综合大作业

- 选择一个热点或者你感兴趣的主题。

- 选择爬取的对象与范围。

- 了解爬取对象的限制与约束。

- 爬取相应内容。

- 做数据分析与文本分析。

- 形成一篇文章,有说明、技术要点、有数据、有数据分析图形化展示与说明、文本分析图形化展示与说明。

- 文章公开发布。

参考:

爬了一下天猫上的Bra购买记录,有了一些羞羞哒的发现...

Python做了六百万字的歌词分析,告诉你中国Rapper都在唱些啥

分析了42万字歌词后,终于搞清楚民谣歌手唱什么了

十二星座的真实面目

唐朝诗人之间的关系到底是什么样的?

中国姓氏排行榜

三.爬虫注意事项

1.设置合理的爬取间隔,不会给对方运维人员造成压力,也可以防止程序被迫中止。

- import time

- import random

- time.sleep(random.random()*3)

2.设置合理的user-agent,模拟成真实的浏览器去提取内容。

- 首先打开你的浏览器输入:about:version。

- 用户代理:

- 收集一些比较常用的浏览器的user-agent放到列表里面。

- 然后import random,使用随机获取一个user-agent

- 定义请求头字典headers={’User-Agen‘:}

- 发送request.get时,带上自定义了User-Agen的headers

3.需要登录

发送request.get时,带上自定义了Cookie的headers

headers={’User-Agen‘:

'Cookie': }

4.使用代理IP

通过更换IP来达到不断高 效爬取数据的目的。

headers = {

"User-Agent": "",

}

proxies = {

"http": " ",

"https": " ",

}

response = requests.get(url, headers=headers, proxies=proxies)

对豆瓣电影评论,评分,点赞数进行爬取并进行分析:

https://movie.douban.com/subject/26266893/comments?start=0&limit=20&sort=new_score&status=P

首先对网页元素进行分析:

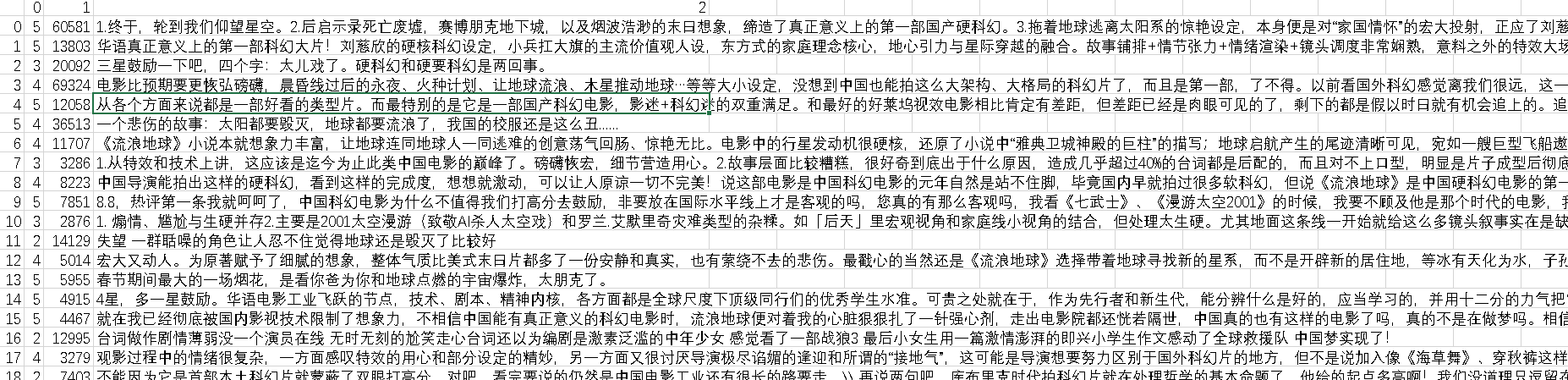

将爬取的数据存为.csv文件:

import requests from bs4 import BeautifulSoup from fake_useragent import UserAgent import pandas as pd def getcom(url): ua = UserAgent().random headers={'User-Agent':ua} response=requests.get(url=url,headers=headers) soup=BeautifulSoup(response.text,'lxml') s=soup.find_all('div',class_='comment-item') u = [] for s1 in s: o=s1.find('span',class_='comment-info').find_all('span')[1].attrs['class'][0][7] w=s1.find('span',class_='votes').get_text() q=s1.find('span',class_='short').get_text().replace("\n", "") u.append([o,w,q]) comment = pd.DataFrame(u) comment.to_csv('comment.csv')

生成的.csv用excell打开:

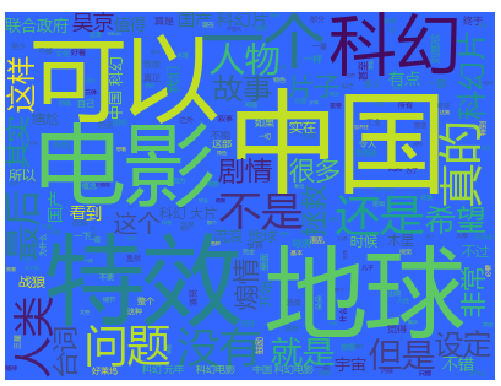

生成词云: