学习进度笔记18

今天完成了老师布置的spark实验报告5的第一部分,利用spark操作json文件,具体内容如下:

《Spark 编程基础(Scala 版)

实验 5 Spark SQL 编程初级实践

一、实验目的

(1)通过实验掌握 Spark SQL 的基本编程方法;

(2)熟悉 RDD 到 DataFrame 的转化方法;

(3)熟悉利用 Spark SQL 管理来自不同数据源的数据。

二、实验平台

操作系统: Ubuntu16.04

Spark 版本:2.1.0

数据库:MySQL

三、实验内容和要求

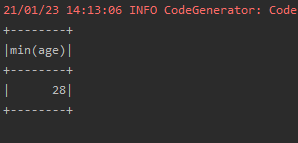

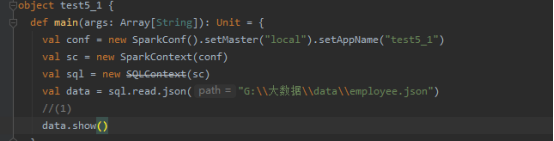

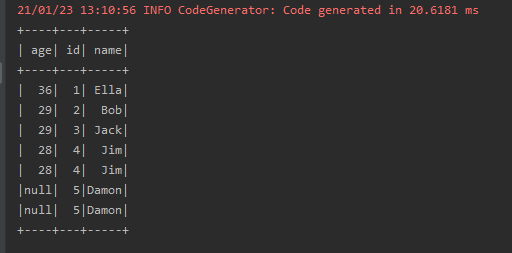

1.Spark SQL 基本操作

将下列 JSON 格式数据复制到 Linux 系统中,并保存命名为 employee.json。

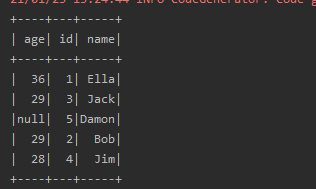

{ "id":1 , "name":" Ella" , "age":36 }

{ "id":2, "name":"Bob","age":29 }

{ "id":3 , "name":"Jack","age":29 }

{ "id":4 , "name":"Jim","age":28 }

{ "id":4 , "name":"Jim","age":28 }

{ "id":5 , "name":"Damon" }

{ "id":5 , "name":"Damon" }

为 employee.json 创建 DataFrame,并写出 Scala 语句完成下列操作:

(1) 查询所有数据;

(2) 查询所有数据,并去除重复的数据;

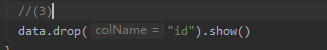

(3) 查询所有数据,打印时去除 id 字段;

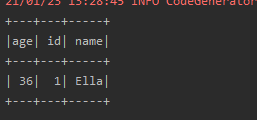

(4) 筛选出 age>30 的记录;

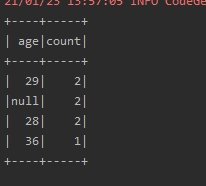

(5) 将数据按 age 分组;

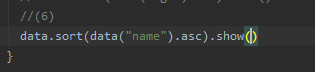

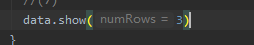

(6) 将数据按 name 升序排列;

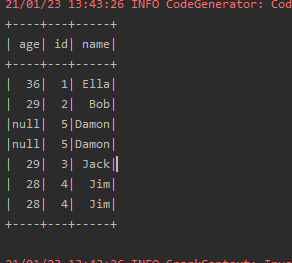

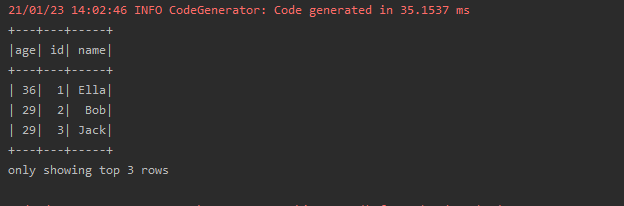

(7) 取出前 3 行数据;

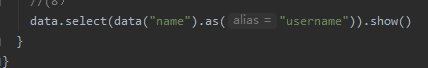

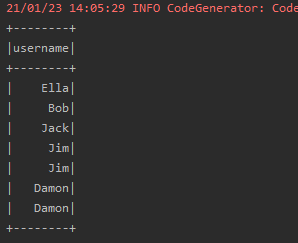

(8) 查询所有记录的 name 列,并为其取别名为 username;

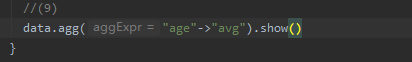

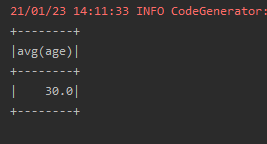

(9) 查询年龄 age 的平均值;

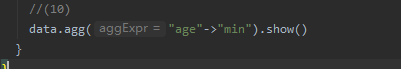

(10) 查询年龄 age 的最小值。