Sqlite3文件数据库与内存数据库的性能差异

这不是一个有说服力的测试,算是我的体验吧

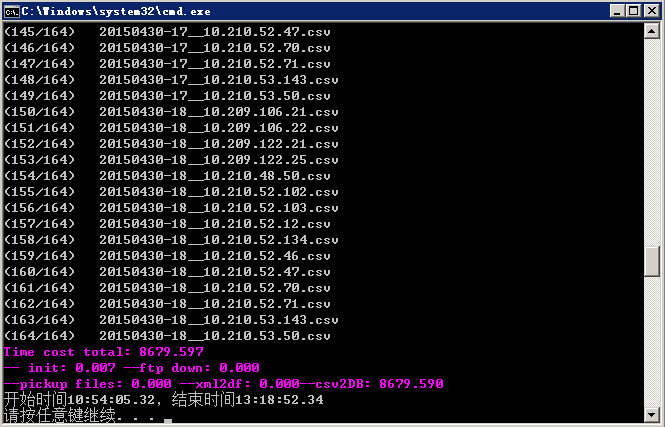

通过pandas.read_csv函数将总共1.44GB的164个csv文件依次(转为dataframe对象,并新增2条series,再将该dataframe通过 pandas.to_sql函数写成1.23GB的sqlite数据库文件,从导入第四个文件后,就越来越慢,怀疑是缓存不足,总共花费两个多小时。

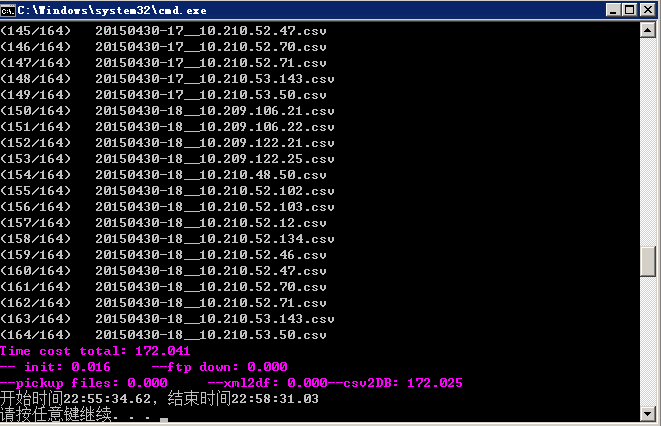

而sqlite3.connect(':memory:')写入内存数据库仅需2分钟多,当然还没转储到磁盘,相信转储花的时间应该也不多。

峰回路转:

在查找如何将内存数据写入文件的时候发现,pandas的to_sql方法默认是带index写入的,这种大量insert语句操作导致了导入越来越慢

修改语句为 data.to_sql(filename[0:11],conn,if_exists='append',index=False)

无index,csv-》内存数据库-》写入文件

无index,csv-》写入文件

结论:无index插入是必须的,先写内存数据库再倒到文件,还是直接写文件,看文件的数据量和计算机的内存做取舍。

浙公网安备 33010602011771号

浙公网安备 33010602011771号