hdfs长时间写入数据报错

问题描述:

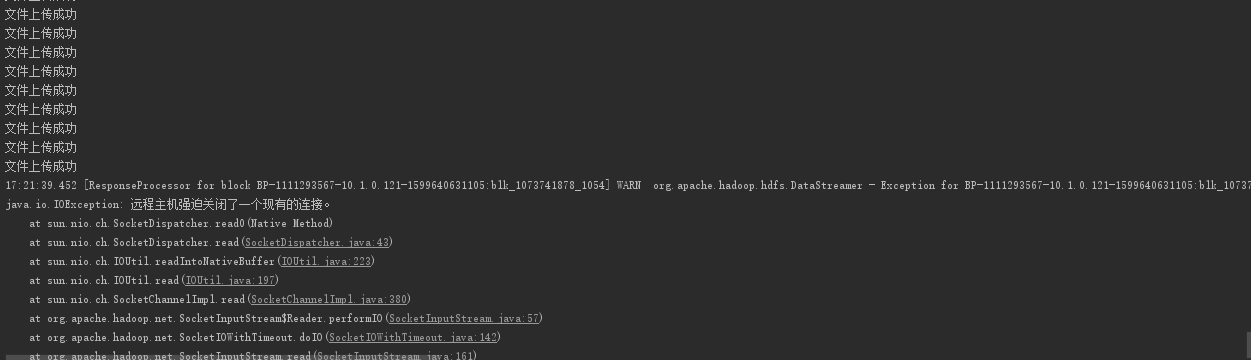

客户要导入一批数据到hdfs,程序运行一会后报错:远程主机强制关闭了一个现有链接

提示信息说无可用datanode,但是之前已经上传了一些文件了,查了些资料说是 DataNode写入策略问题导致失败

解决办法:

conf.set("dfs.client.block.write.replace-datanode-on-failure.policy","NEVER");

conf.set("dfs.client.block.write.replace-datanode-on-failure.enable","true");

在代码中加入这两句配置,还不清楚具体什么作用,也会报上面的错误,但是这次会跳过继续往下执行。。然后就是收集下没有导入的数据。之后再重新导入。

原文地址:https://blog.csdn.net/wangweislk/article/details/78890163

生下来活下去, HELLO WORLD!

请多指教

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】博客园2025新款「AI繁忙」系列T恤上架,前往周边小店选购

【推荐】凌霞软件回馈社区,携手博客园推出1Panel与Halo联合会员

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步