stream引发的bug 之 凭空消失的kafka消费数据

最近在一个批次消费kafka数据的场景里。 上游推送100w条数据。 下游消费了97万条。无任何报错

于是围绕着kafka配置一顿鼓捣。

搞不定。

又在想是不是报错了,但是异常被我代码吞了。检查并无此情况。

当我在想我可能入错行,打算回家养猪的时候。

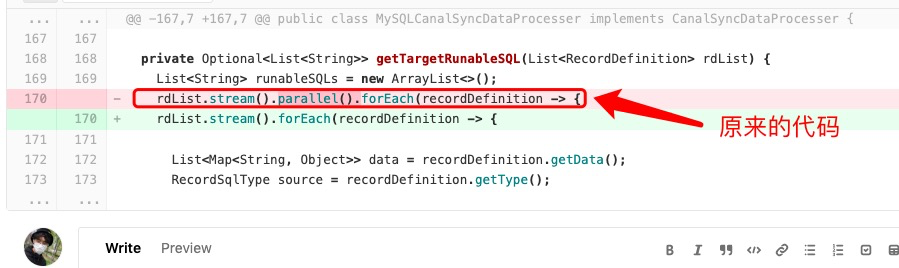

有一个代码块映入眼帘

好吧。。。

使用线程安全的list或者去掉并行流。

这里测试发现100万数据速度直接使用单线程流式处理就能达到预期。。。

ok 删掉并行

ps: 不是标题党,真的和 kafka有那么一点关系。。。真的不是蹭它的关键字

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 25岁的心里话

· 闲置电脑爆改个人服务器(超详细) #公网映射 #Vmware虚拟网络编辑器

· 零经验选手,Compose 一天开发一款小游戏!

· 因为Apifox不支持离线,我果断选择了Apipost!

· 通过 API 将Deepseek响应流式内容输出到前端