2-分词器

分词器的作用是什么?

ES在创建倒排索引时需要对文档分词;在用户搜索时,需要对用户输入内容分词。但默认的分词规则对中文处理并不友好。处理中文分词,一般会使用IK分词器。https://github.com/medcl/elasticsearch-analysis-ik

IK分词器有几种模式?

ik_smart:智能切分,粗粒度

ik_max_word:最细切分,细粒度

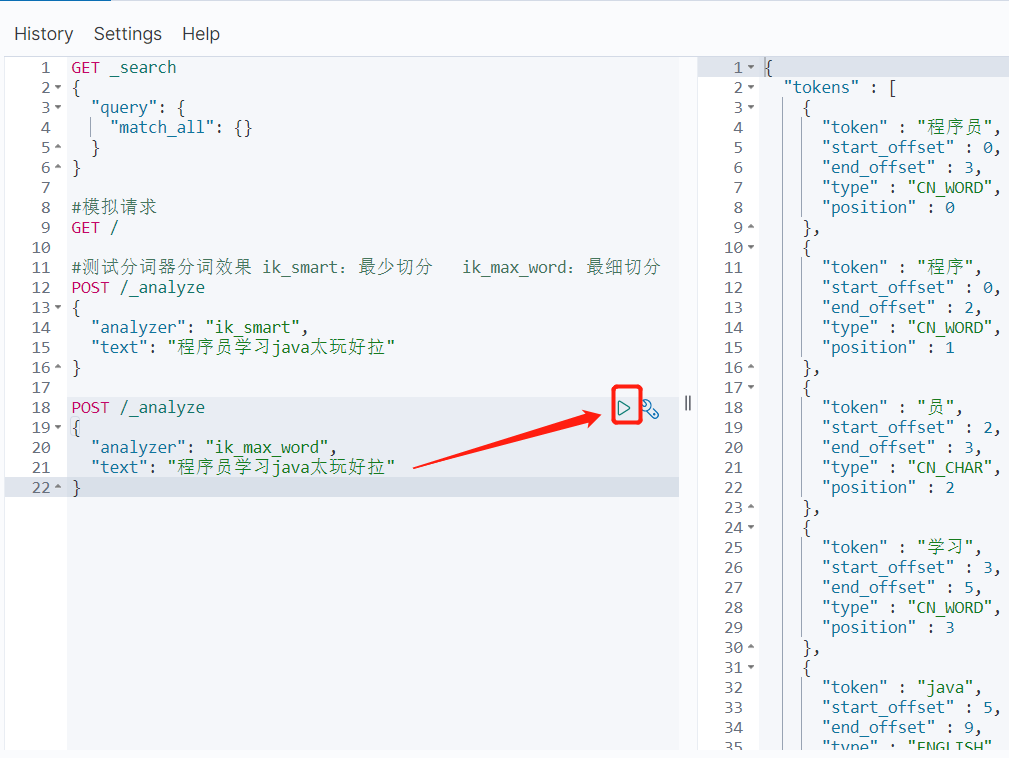

两种分词器示例

#测试分词器分词效果 ik_smart:最少切分 ik_max_word:最细切分 POST /_analyze { "analyzer": "ik_smart", "text": "程序员学习java太玩好拉" } POST /_analyze { "analyzer": "ik_max_word", "text": "程序员学习java太玩好拉" }

IK分词器如何拓展词条?如何停用词条?

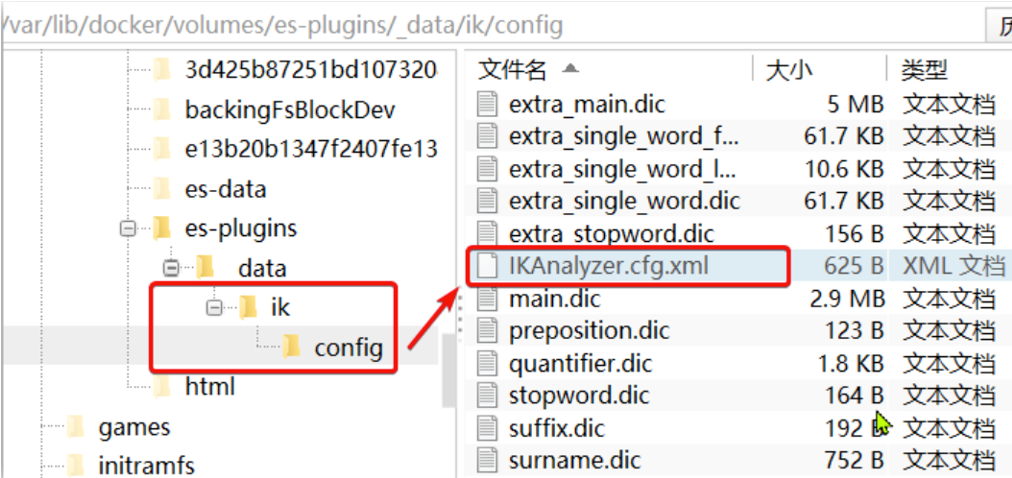

要拓展或者禁用ik分词器的词库,只需要修改一个ik分词器目录中的config目录中的IkAnalyzer.cfg.xml文件:

/var/lib/docker/volumes/es-plugins/_data/ik/config

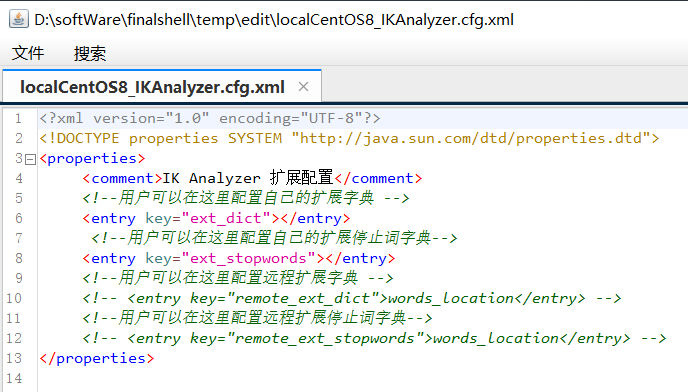

打开,修改前

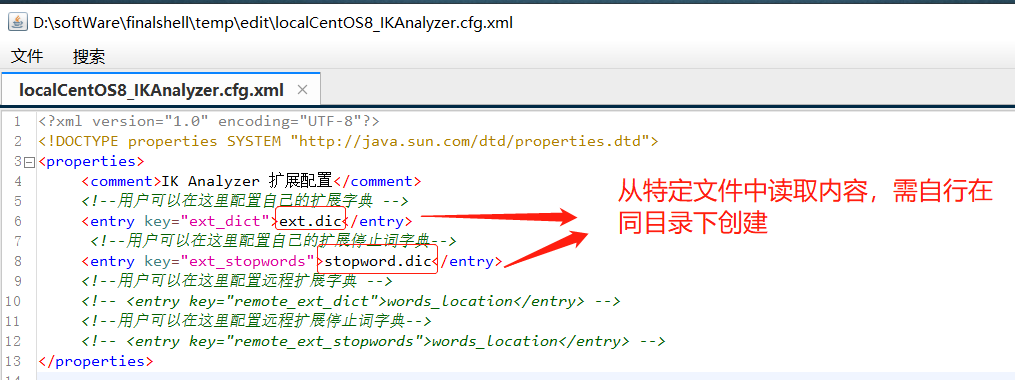

修改,添加需要读取的文件

stopword.dic文件已存在,无需创建

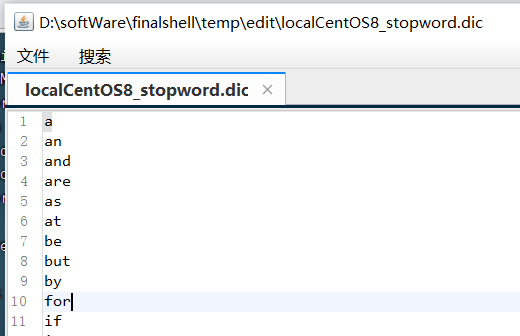

注意,里面应该一个词一行

注意修改好后需要重启elasticsearch

docker restart es

# 查看 日志

docker logs -f es

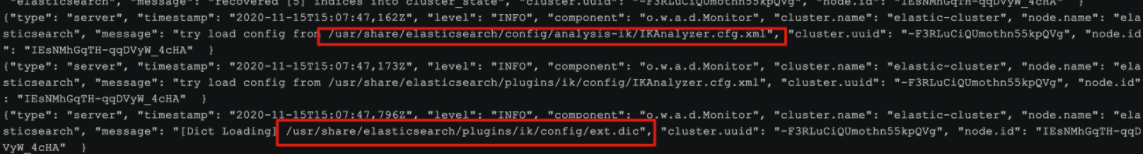

日志中已经成功加载ext.dic配置文件

感谢您的阅读,如果您觉得阅读本文对您有帮助,请点一下“推荐”按钮。本文欢迎各位转载,但是转载文章之后必须在文章页面中给出作者和原文连接。

希望本文章对您有帮助,您的转发、点赞是我的创作动力,十分感谢。更多好文推荐,请关注我的微信公众号--JustJavaIt

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App

· 张高兴的大模型开发实战:(一)使用 Selenium 进行网页爬虫

2020-07-24 JVM -- GC介绍