Springboot 使用langchain4j 访问qwen2:7b模型

一、模型部署

1、官网下载Ollama:https://ollama.com,选择自己系统对应的安装包进行下载安装

2、配置模型下载路径

1、一般默认情况安装位置: Linux:/var/lib/ollama/models Windows:C:\Usersx用户名>.o11ama\models

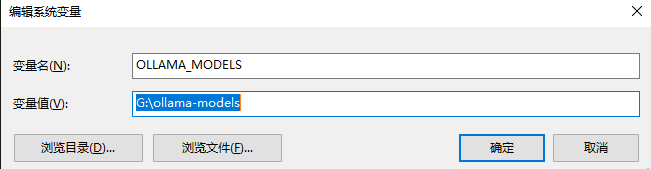

2、windows 改变下载位置 环境变量--->系统环境变量--->添加变量名OLLMAM_MODELS 变量值:自定义的模型存储位置

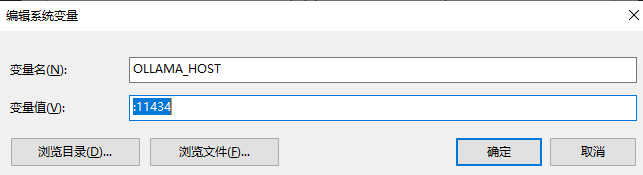

3、设置访问端口 添加变量 OLLAMA_HOST 变量值 :11434(默认端口)

4、重启电脑后打开命令行输入 ollama -v 查看 ollama版本。有版本号说明安装成功

5、部署启动模型,在ollama官网中,点击models,然后搜索qwen2,选择7b

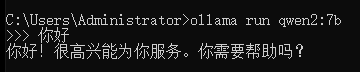

6、复制启动命令,然后打开命令面板点击粘贴,如果模型不存在将会进行下载,如果存在则直接可以提问

启动:

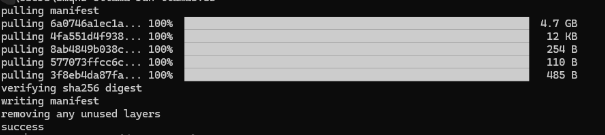

下载::

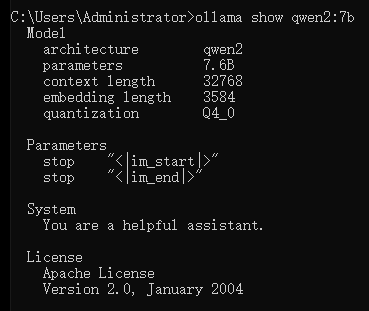

查看:

3、Springboot中测试模型

1、添加依赖(版本根据自己项目来,我这里是 0.33.0

<dependency> <groupId>dev.langchain4j</groupId> <artifactId>langchain4j-ollama</artifactId> <version>${langchain4j.version}</version> </dependency <dependency> <groupId>dev.langchain4j</groupId> <artifactId>langchain4j-core</artifactId> <version>${langchain4j.version}</version> </dependency> <dependency> <groupId>dev.langchain4j</groupId> <artifactId>langchain4j</artifactId> <version>${langchain4j.version}</version> </dependency> <dependency> <groupId>dev.langchain4j</groupId> <artifactId>langchain4j-embeddings</artifactId> <version>${langchain4j.version}</version> </dependency> <dependency>

2、测试

package com.langchain4j; import dev.langchain4j.model.ollama.OllamaChatModel; import dev.langchain4j.service.AiServices; import dev.langchain4j.service.SystemMessage; import java.time.Duration; public class OpenAiDemo1 { interface Assistant { @SystemMessage("请用英语回答") String chat(String userMessage); } static OllamaChatModel qwen = OllamaChatModel.builder() .baseUrl("http://127.0.0.1:11434") .modelName("qwen2:7b") .temperature(0d) .timeout(Duration.ofSeconds(30)) .maxRetries(3) .logRequests(true) .logResponses(true) .build(); public static void main(String[] args) { Assistant assistant = AiServices.create(Assistant.class, qwen); String answer = assistant.chat("你好"); System.out.println(answer); } }

小白技术分享

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix