【python爬虫】利用selenium和Chrome浏览器进行自动化网页搜索与浏览

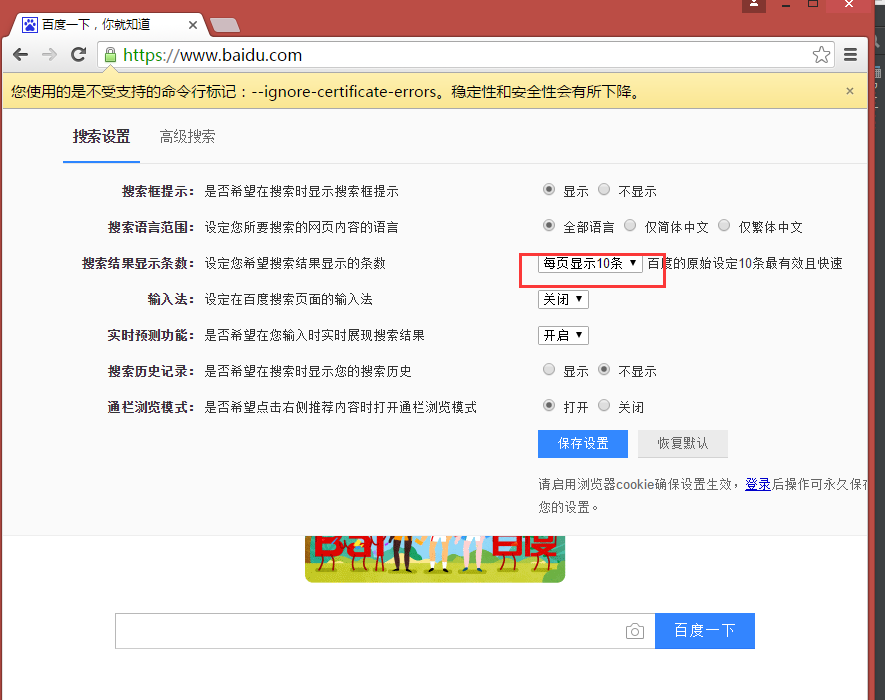

功能简介:利用利用selenium和Chrome浏览器,让其自动打开百度页面,并设置为每页显示50条,接着在百度的搜索框中输入selenium,进行查询。然后再打开的页面中选中“Selenium - 开源中国社区”,并打开页面

知识简介:

selenium的作用:

1).最初用于网站自动化测试,近几年,用于获取精确的网站快照。

2).可以直接运行在浏览器上,让浏览器自动加载页面,获取需要的数据,还可以页面截屏,或者判断网站上某些动作是否发生。

项目步骤:

1.利用google的Chrome浏览器时要安装chromedriver驱动程序。

下载地址:

下载完后最好和你的python文件放到一起,以便于后面调用。

2.安装selenium(如果已经安装请忽略此步骤)

windows用户直接用pip install selenium命令安装。

3.代码展示:

from selenium import webdriver from time import sleep # 后面是你的浏览器驱动位置,记得前面加r'','r'是防止字符转义的 driver = webdriver.Chrome(r'C:\Python34\chromedriver_x64.exe') # 用get打开百度页面 driver.get("http://www.baidu.com") # 查找页面的“设置”选项,并进行点击 driver.find_elements_by_link_text('设置')[0].click() # 打开设置后找到“搜索设置”选项,设置为每页显示50条 driver.find_elements_by_link_text('搜索设置')[0].click() sleep(2) m = driver.find_element_by_id('nr') sleep(2) m.find_element_by_xpath('//*[@id="nr"]/option[3]').click() sleep(2) # 处理弹出的警告页面 driver.find_element_by_class_name("prefpanelgo").click() sleep(2) driver.switch_to_alert().accept() sleep(2) # 找到百度的输入框,并输入“selenium” driver.find_element_by_id('kw').send_keys('selenium') sleep(2) # 点击搜索按钮 driver.find_element_by_id('su').click() sleep(2) # 在打开的页面中找到“Selenium - 开源中国社区”,并打开这个页面 driver.find_elements_by_link_text('Selenium - 开源中国社区')[0].click()

4.以下页面操作都是自动完成