第二周神经网络基础

1、二分分类

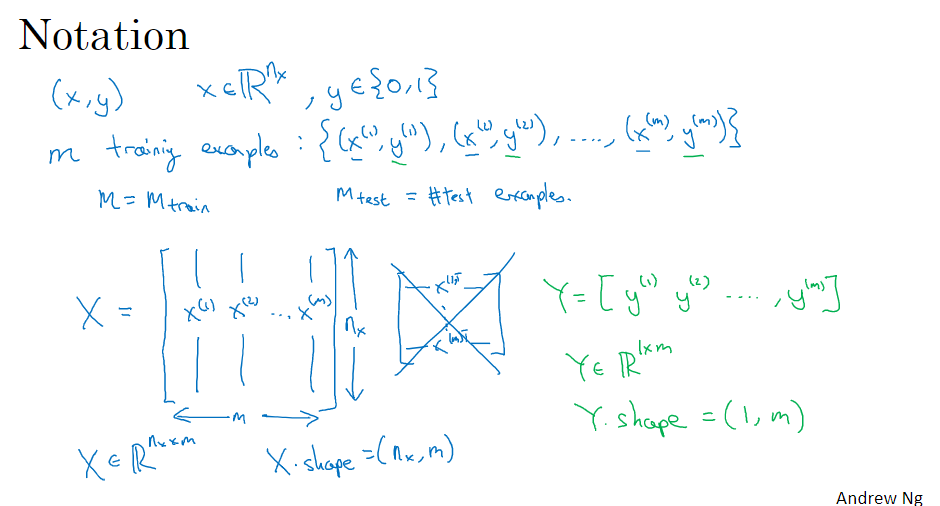

计算机保存一张图片要保存三个独立矩阵,分别对应图片中的红绿蓝三个颜色通道,如果图片是64X64输入,那么就有三个64X64的矩阵分别对应图片中的红绿蓝三种像素的亮度。要把这些像素亮度值都提取出来放入一个特征向量x,为了把这些像素值提取出放入特征向量以表示这张图片就要把所有像素值提取出来,最后得到一个很长的特征向量,用n=nx=12288来表示输入的特征向量x的维度。

在二分分类问题中目标是训练出一个分类器,它以输入特征向量x预测输出的结果标签y是1还是0

(x(1),y(1))表示样本一

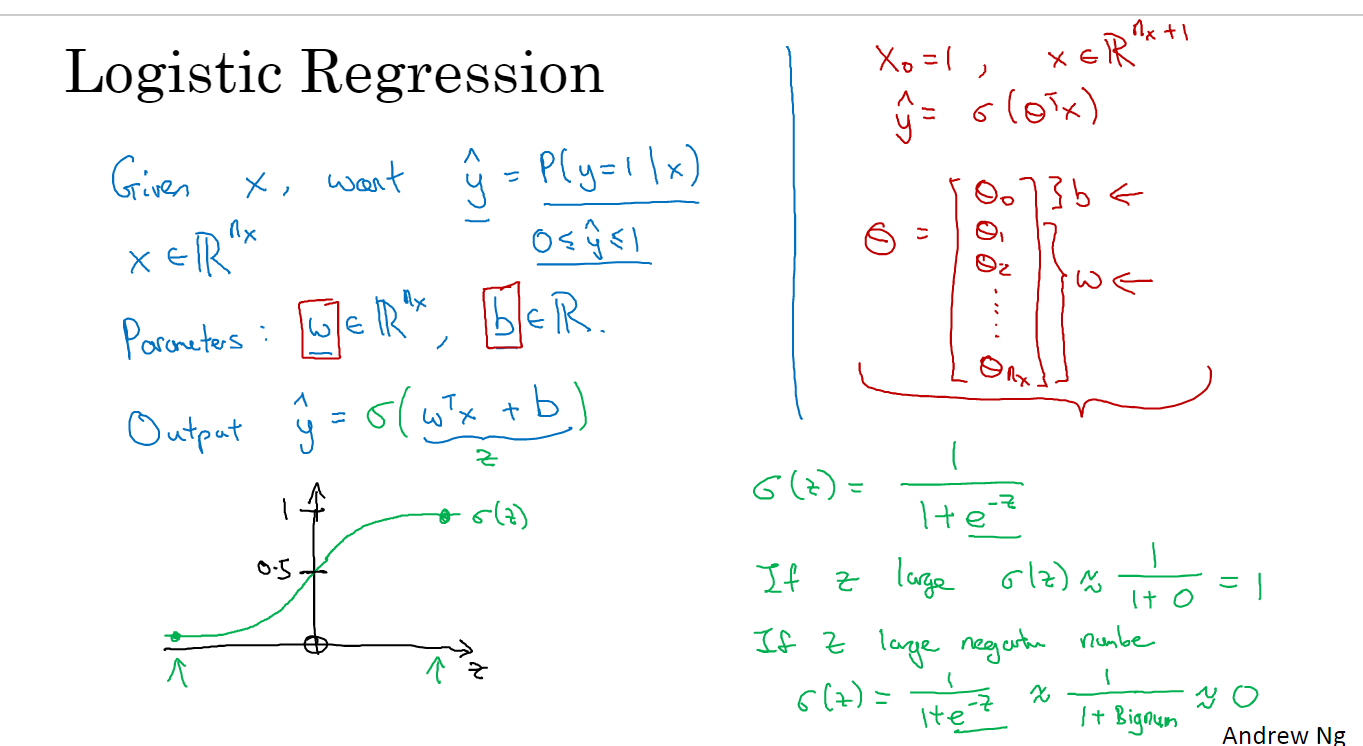

2、logistic回归

这是一个学习算法,用在监督学习问题中输出y标签是0或1时这是一个二元分类问题,logistic回归的目标是尽量减少预测和训练数据之间的误差

例子:猫和没有猫

给定一幅由特征向量x表示的图像,该算法将评估猫出现在该图像中的概率

Given x,y帽=P(y=|x),where0<=y帽<=1

logistic回归使用的参数为

输入特征向量:x∈R^nx,其中nx为特征数

训练标签:y∈0,1

权值:w∈R^nx,其中nx为特征数

阈值:b∈R

输出:y=σ(w^(T)x+b)

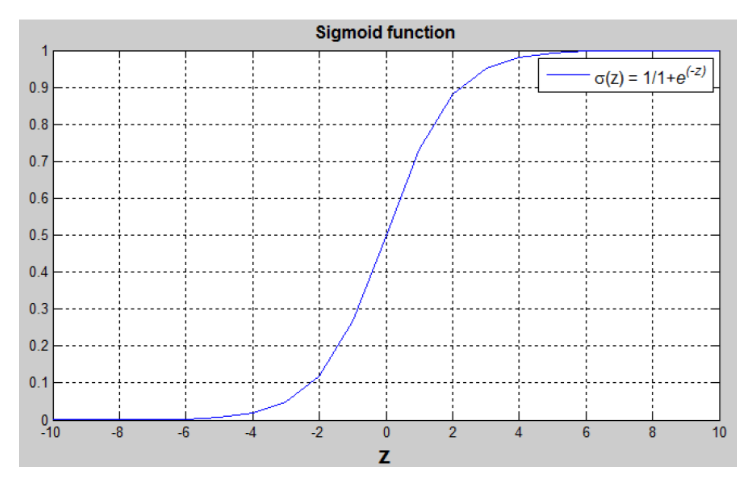

s函数:s=σ(w(T)x+b)=σ(z)=1/(1+e(-Z))

w^(T)x+b是一个线性方程(ax+b),但由于我们正在寻找[0,1]之间的概率约束,使用s型函数。如图所示,函数的界在[0,1]之间

从图表中可以看出:

如果z是一个大的正数那么σ(z)=1

如果z是小负数或者大负数那么σ(z)=0

如果z=0,那么σ(z)=0.5

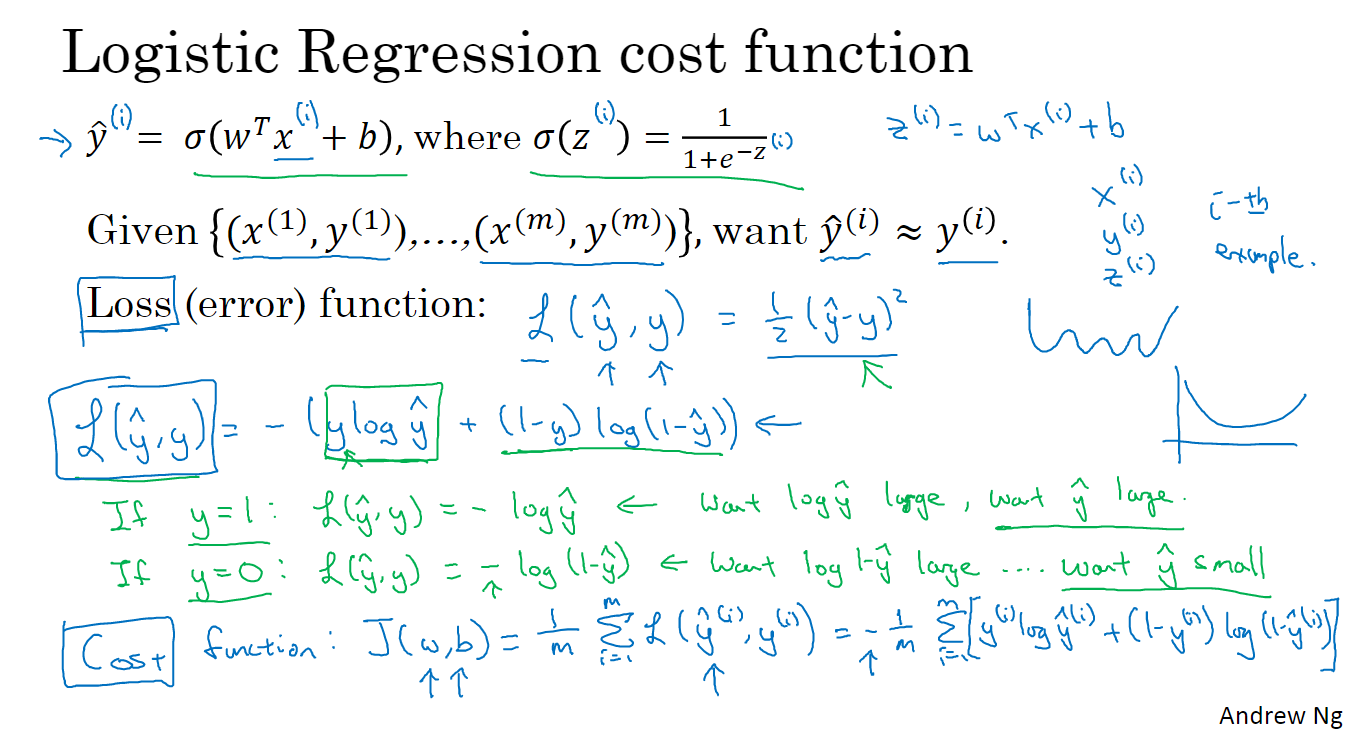

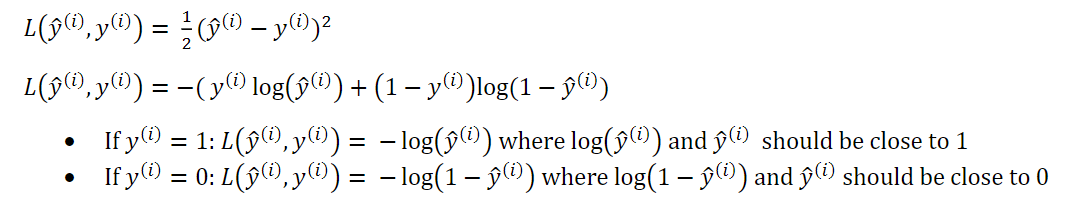

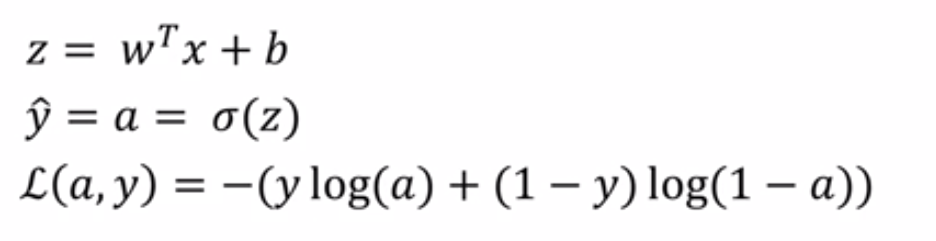

3、logistic回归损失函数

为了训练参数w和b,我们需要定义一个成本函数

损失(失误)功能:

损失函数测量预测

和期望输出

之间的差异,换句话说损失函数计算单个训练示例的误差

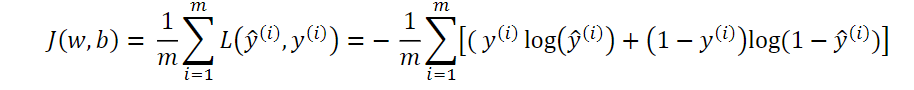

成本函数:

成本函数是整个训练集的损失函数的平均值。我们将找到使整个成本函数最小化的参数w和b

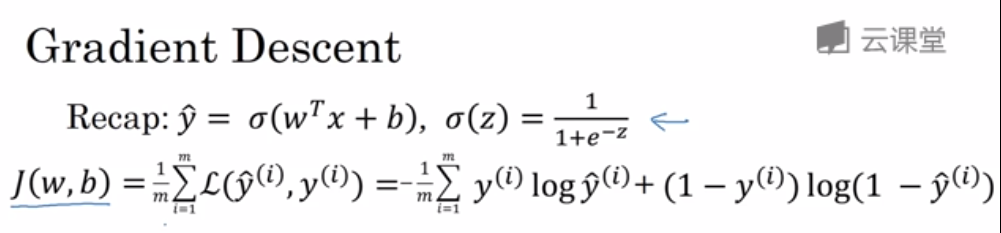

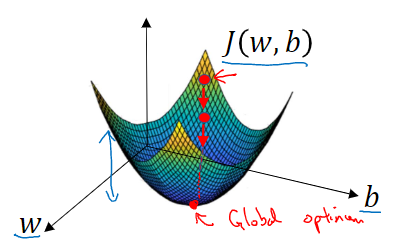

4、梯度下降法

损失函数是衡量单一训练样例的效果

成本函数用于衡量参数w和b的效果在全部训练集上来衡量

成本函数j是参数w和b的函数,它被定义为平均值,即1/m的损失函数之和,损失函数可以衡量算法的效果(要找到使得成本函数J(w,b)尽可能小的w和b)

成本函数J是一个凸函数

通常用0来初始化w和b,但是对于logistic回归我们通常不这么做,但是由于函数是凸函数所有无论从哪里初始化都应该达到同一点,或大致相同的点

梯度下降法是朝着最陡的下坡方向走一步。在坡度下降一步后或许在那里停下因为它试图沿着最快下降的方向往下走

7、8计算图

dvar在代码中表示导数

9、logistic回归中的梯度下降法

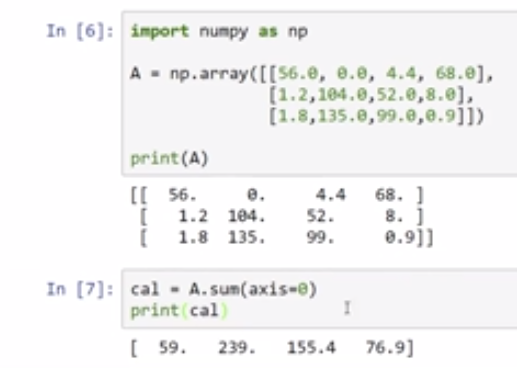

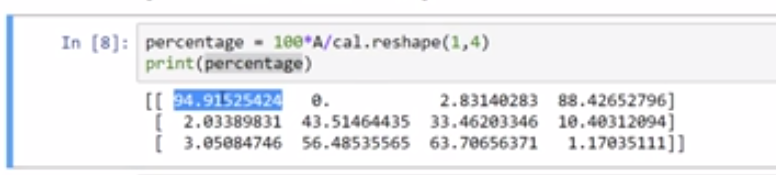

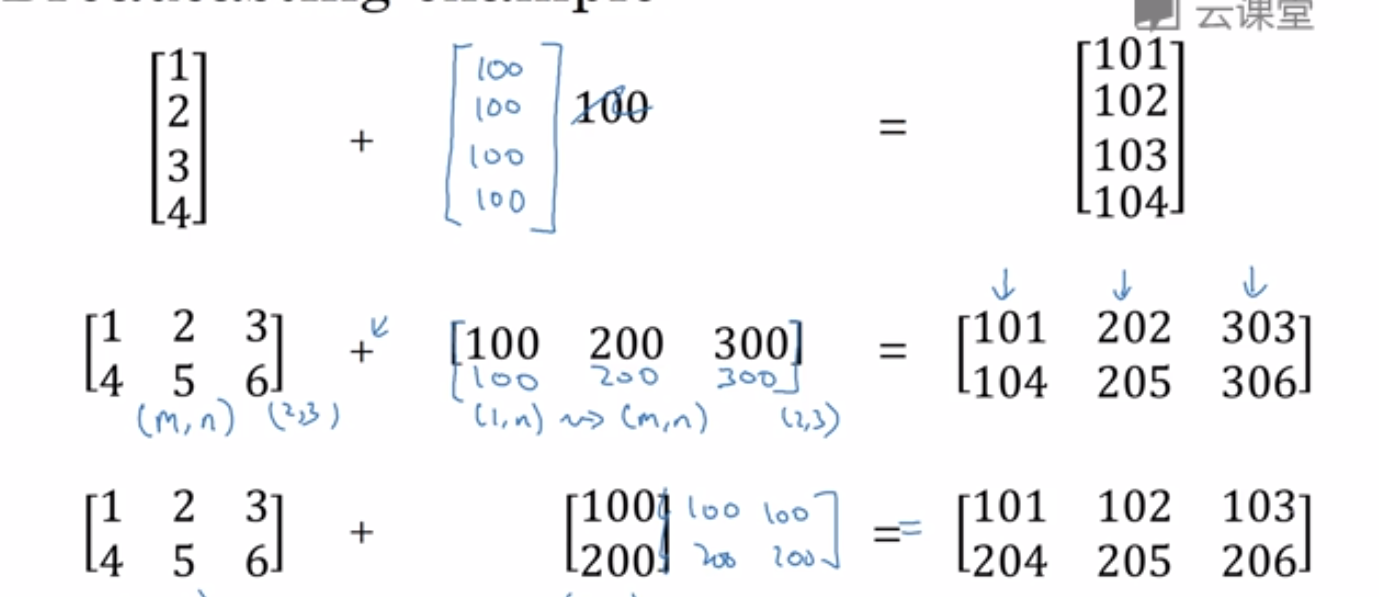

15、python中的广播

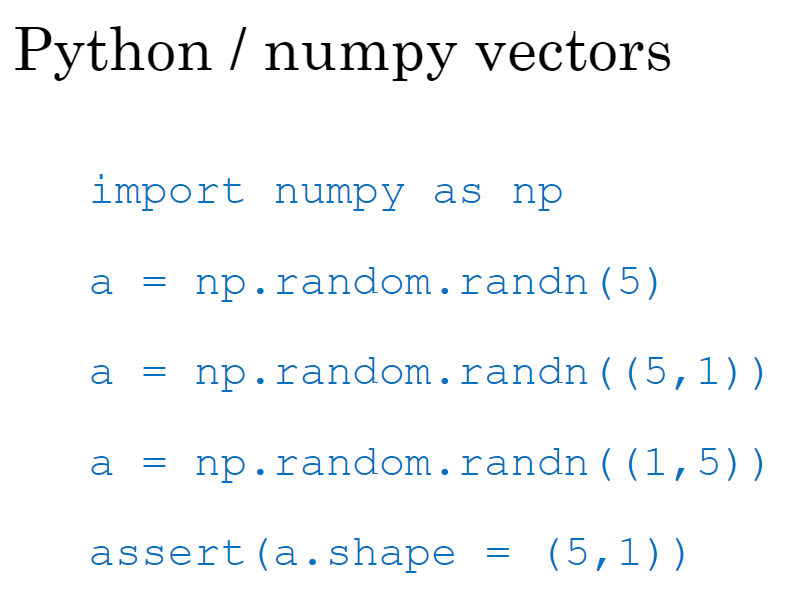

16、关于python/numpy vectors