mac上spark环境配置(离线安装)

mac上spark环境配置(离线安装)

配置环境信息:

- MacOS BIG SUR 11.2.1 (20D74)

- java-1.8 .0_291

- scala-2.12.8

- spark-2.4.8

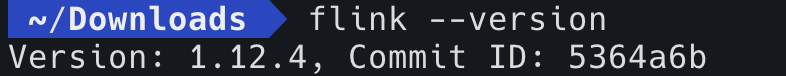

- flink-1.12.4

注:采取其他版本不保证能安装成功,可能会出现JDK版本低等问题。

参考链接:

1、https://zhuanlan.zhihu.com/p/125549332

2、https://www.jianshu.com/p/d7c94372020c

一、安装java 1.8

首先从官网(https://www.oracle.com/java/technologies/javase/javase-jdk8-downloads.html),下载dmg安装包,使用dmg的好处在于,不用自己配置java环境变量,安装完成后即可使用。

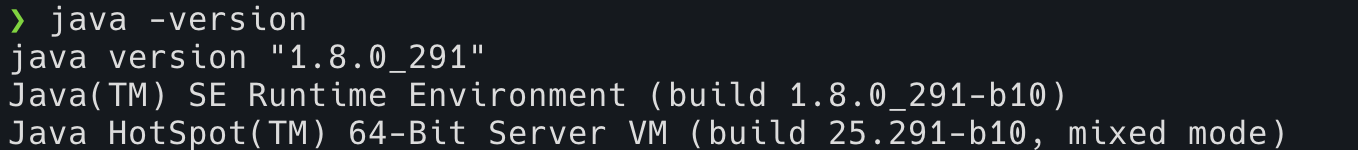

安装完成后,输入java -version,出现如下提示代表安装成功。

注:此版本的java不支持scala2.11,安装scala2.11会报错,报错信息如下:

Error occurred during initialization of VM

java/lang/NoClassDefFoundError: java/lang/Object

二、安装scala 2.12.8

1、brew安装方式的不足

mac上安装scala可以使用brew进行安装,命令如下:

# 搜索scala版本

brew search scala

# 安装

brew install scala@2.12

注:使用brew安装scala,会存在一些问题,本人遇到的问题是:brew安装的scala版本是jdk16版本的,不是jdk8版本的,安装的版本过高,后面安装完spark后,会报错。报错信息如下:

A fatal error has been detected by the Java Runtime Environment

SIGSEGV (0xb) at pc=0x0071902b, pid=7052, tid=3078032240

RE version: 8.0_21-b06

[java] # Java VM: Java HotSpot(TM) Client VM (1760-b16 mixed mode, sharing linux-x86 )

2、离线安装方式

首先从官网(https://www.scala-lang.org/download/scala2.html)下载scala 2.12.8。

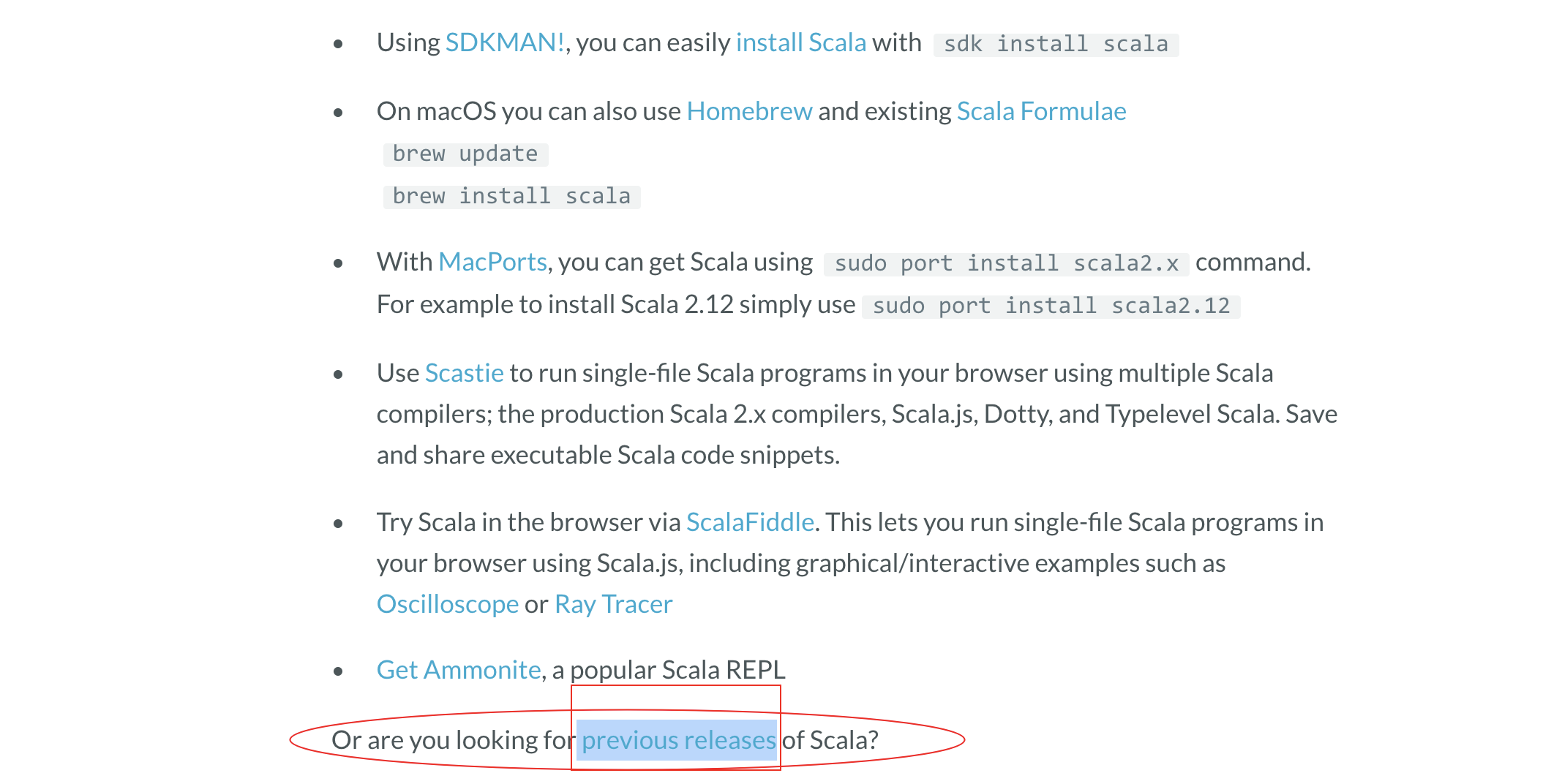

进去后是最新版本的scala,需要点击下图中的previous releases。

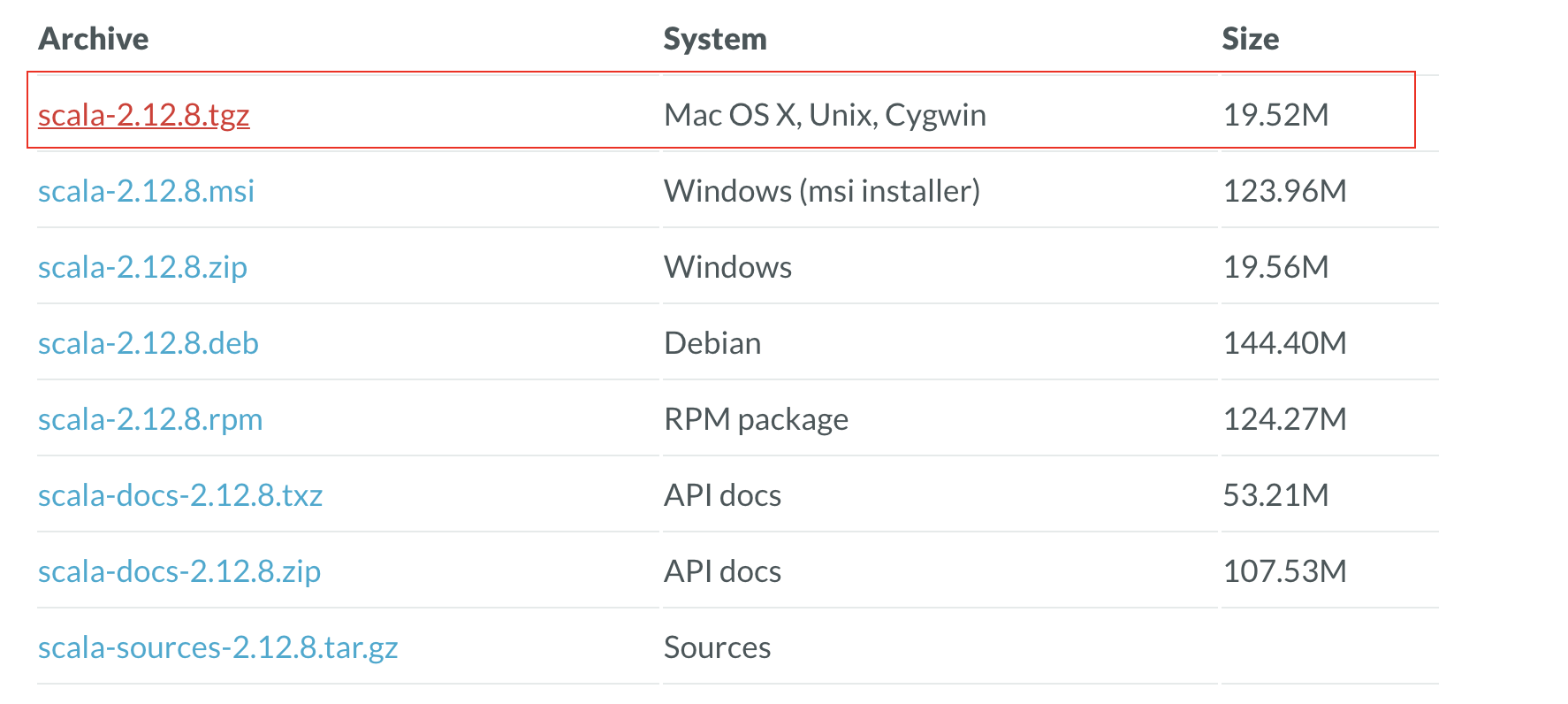

然后选择Scala 2.12.8

进去后,拉到最下面,选择图中标注的版本进行下载。

首先,解压文件,移动到指定目录并重命名。

d ~/Download/

tar -zxvf scala-2.12.8.tgz

mv scala-2.12.8 /usr/local/scala

放置好了后,开始配置bash环境变量:

命令行输入:vim ~/.bash_profile进行编辑,增加环境变量:

SCALA_HOME=/usr/local/scala

export PATH=$PATH:$SCALA_HOME/bin

#使环境变量生效,在命令行执行

source ~/.bash_profile

若安装了zsh,则其环境变量配置方法如下:

命令行输入:vim ~/.zshrc进行编辑,增加环境变量:

SCALA_HOME=/usr/local/scala

export PATH=$PATH:$SCALA_HOME/bin

#使环境变量生效,在命令行执行

source ~/.zshrc

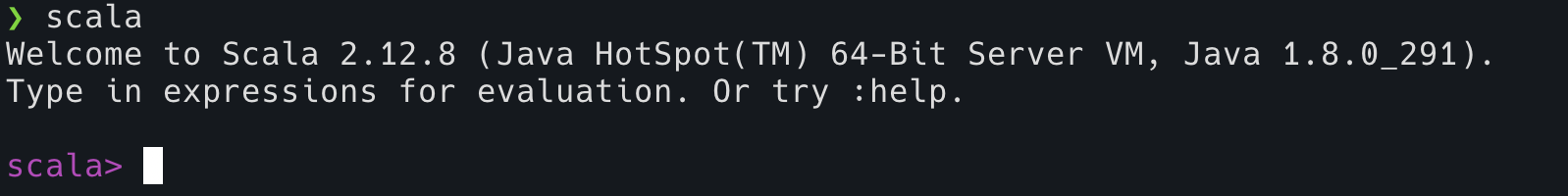

验证:安装完成后输入Scala命令,出现如下提示代表成功。

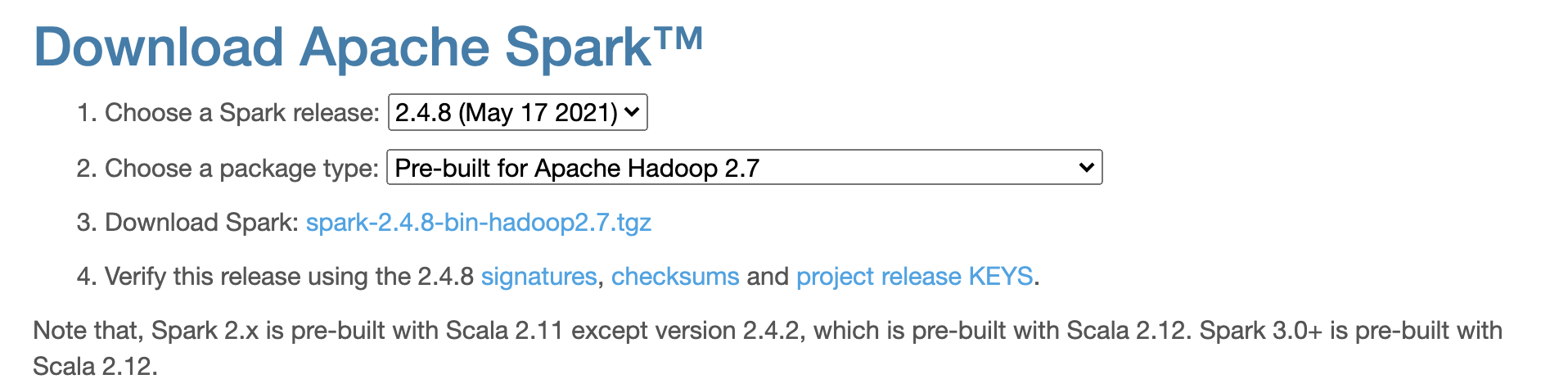

三、安装Spark

进入Spark官网(https://spark.apache.org/downloads.html)下载spark2.4.8

解压文件,移动到指定的位置并重命名。

cd ~/Downloads/

# 解压

tar -zvxf spark-3.0.0-preview2-bin-hadoop2.7.tgz

移动到指定的位置并重命名

mv ~/Downloads/spark-3.0.0-preview2-bin-hadoop2.7 /usr/local/spark

上述步骤操作完后,开始进行环境变量配置。

1.对于原生终端,环境变量配置方式如下:

# 打开配置文件

vim ~/.bash_profile

# 在配置文件中添加下面三行代码

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/bin

export PYSPARK_PYTHON=python3

# 更新配置文件

source ~/.bash_profile

2.对于zsh终端,环境变量配置方式如下:

# 打开配置文件

vim ~/.zshrc

# 在配置文件中添加下面三行代码

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/bin

export PYSPARK_PYTHON=python3

# 更新配置文件

source ~/.zshrc

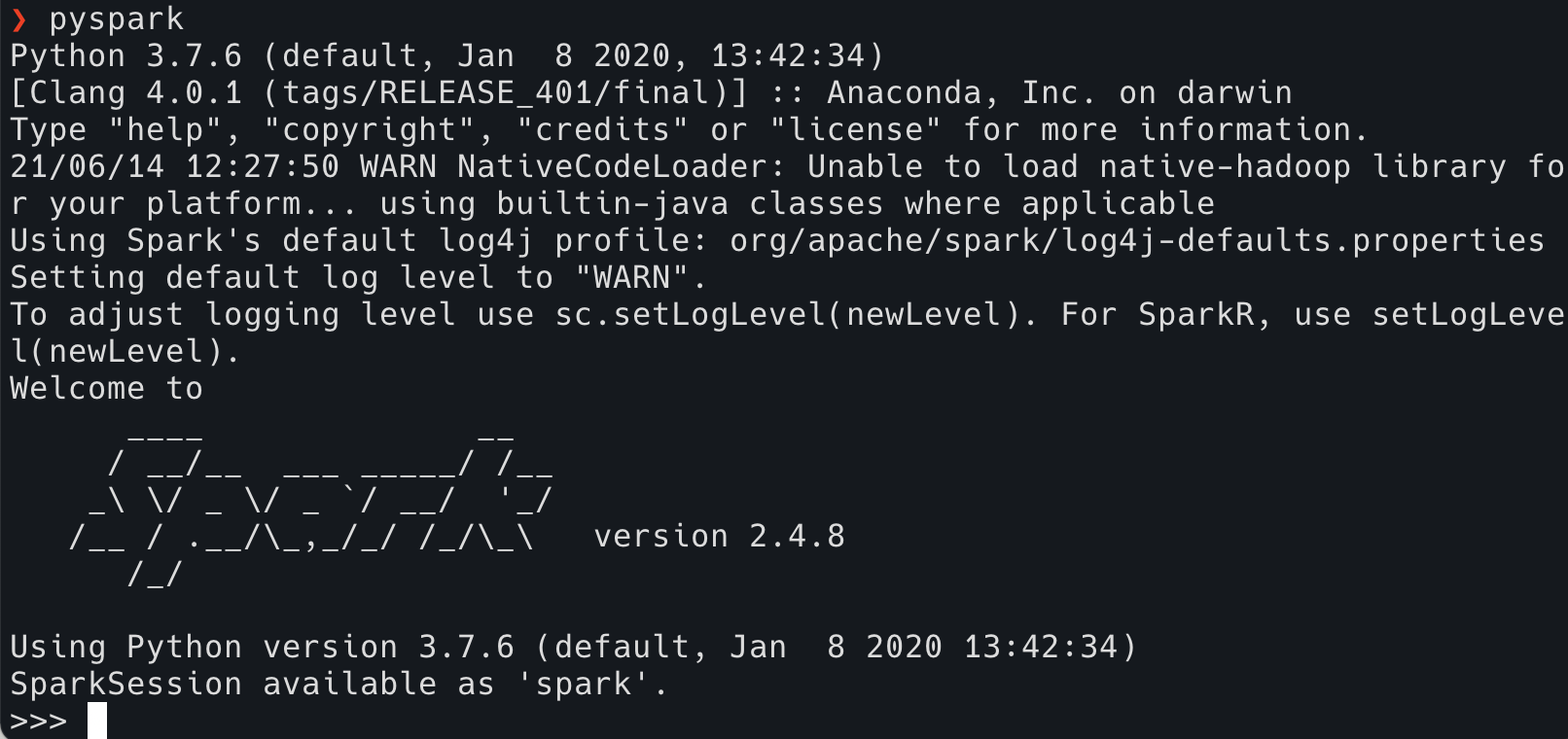

验证阶段

首先验证python3版本的spark,输入pyspark,出现如下界面,代表安装成功。

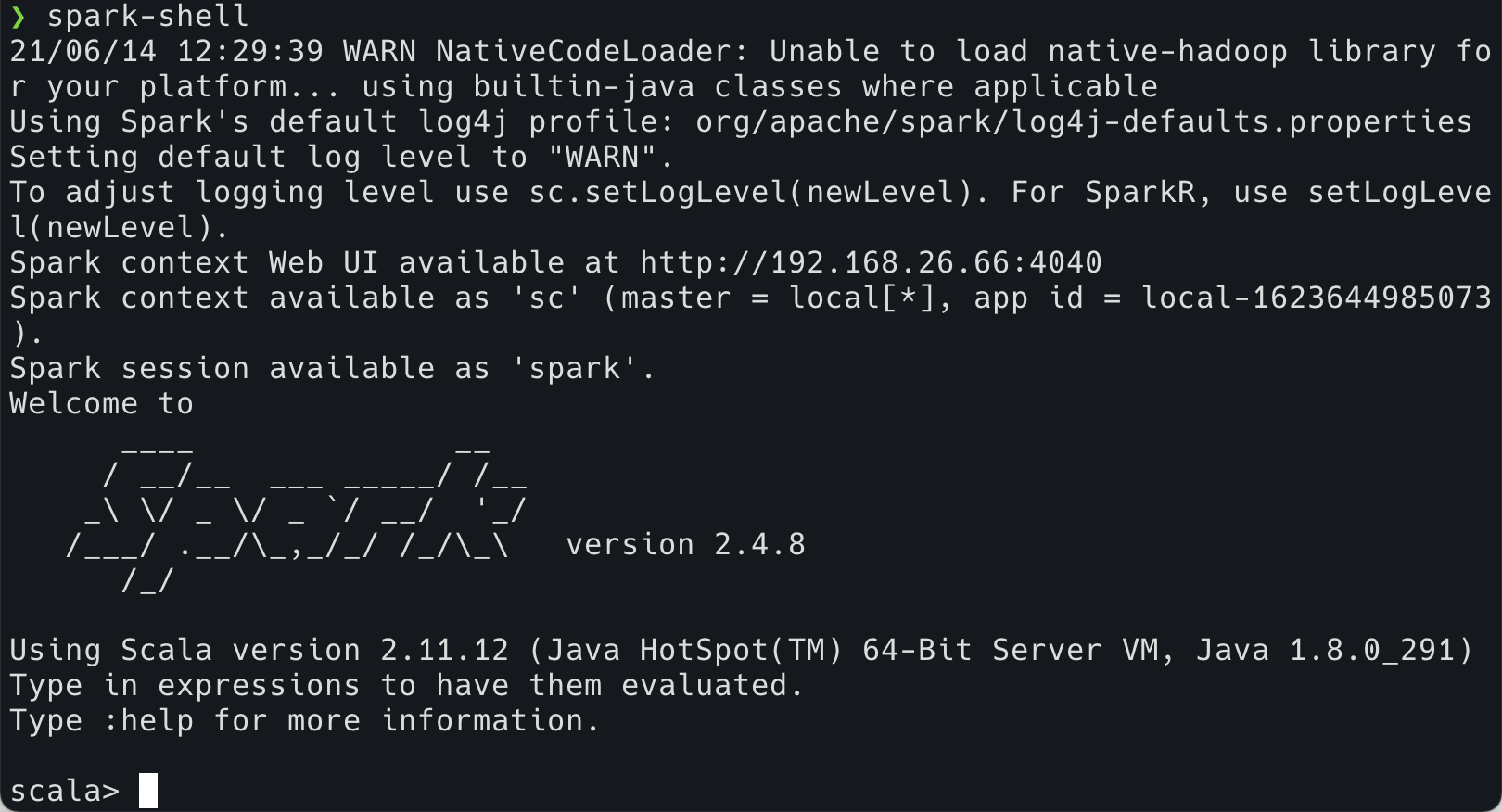

若是使用scala版本的spark,则可以输入spark-shell进行验证出现如下界面代表安装成功。

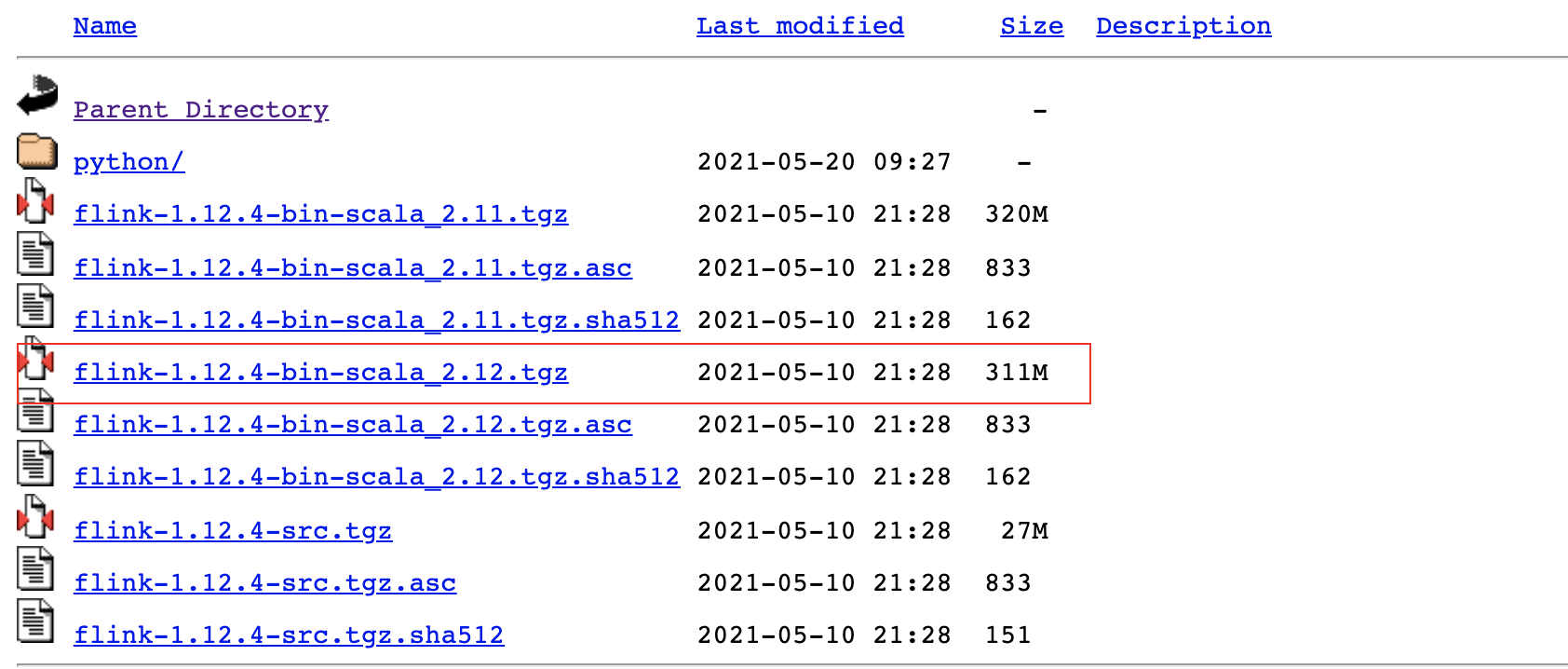

4、安装flink

进入网址(https://archive.apache.org/dist/flink/flink-1.12.4/)下载如图所示的flink版本。

下载完成后进行解压,移动到指定的位置并重命名。

cd ~/Downloads/

# 解压

tar -zvxf flink-1.12.4-bin-scala_2.12.tgz

移动到指定的位置并重命名

mv ~/Downloads/flink-1.12.4 /usr/local/flink

进行环境变量的配置

# 打开配置文件

vim ~/.bash_profile

# 在配置文件中添加下面三行代码

export FLINK=/usr/local/flink

export PATH=$PATH:$FLINK_HOME/bin

# 更新配置文件

source ~/.bash_profile

输入flink —version查看版本号

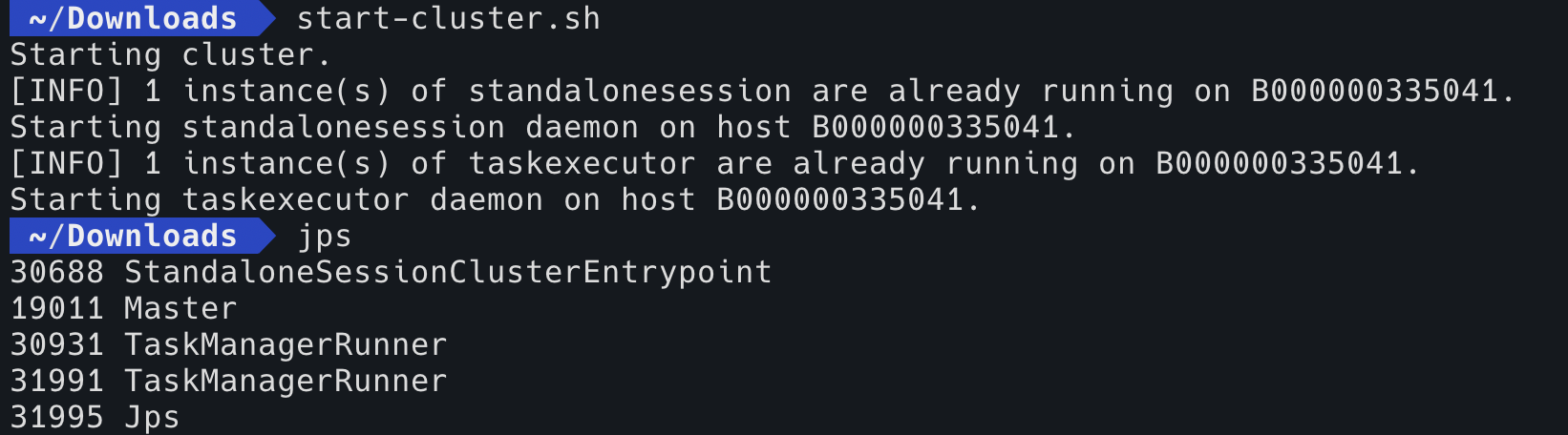

输入start-cluster.sh启动进程,jps查看进程。

浙公网安备 33010602011771号

浙公网安备 33010602011771号