经典的损失函数:交叉熵和MSE

经典的损失函数:

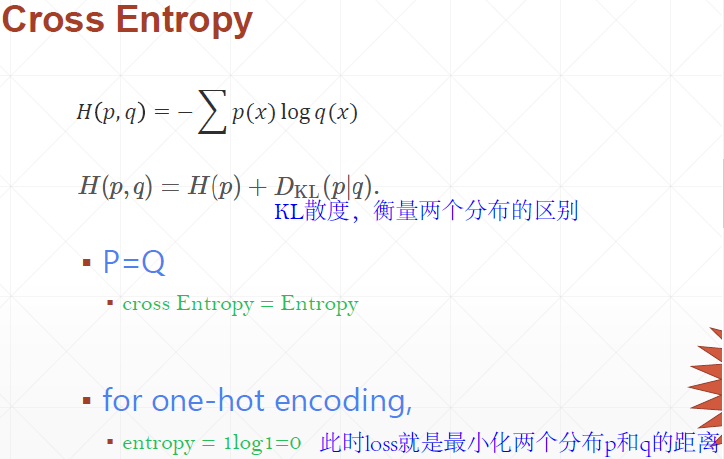

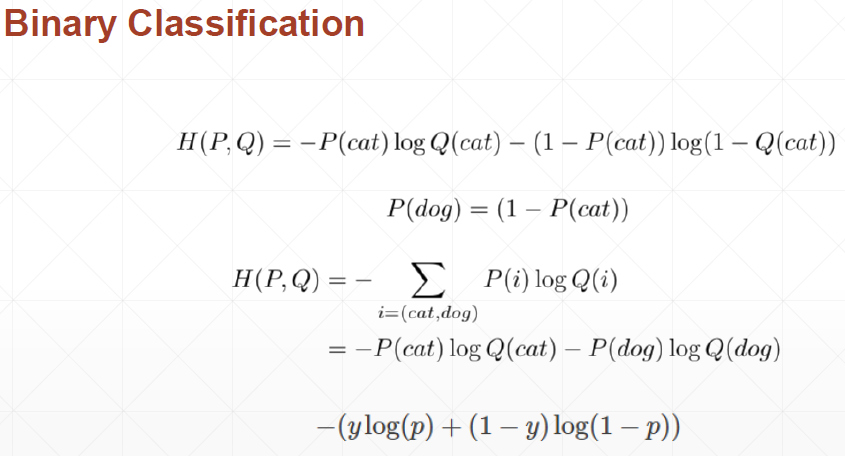

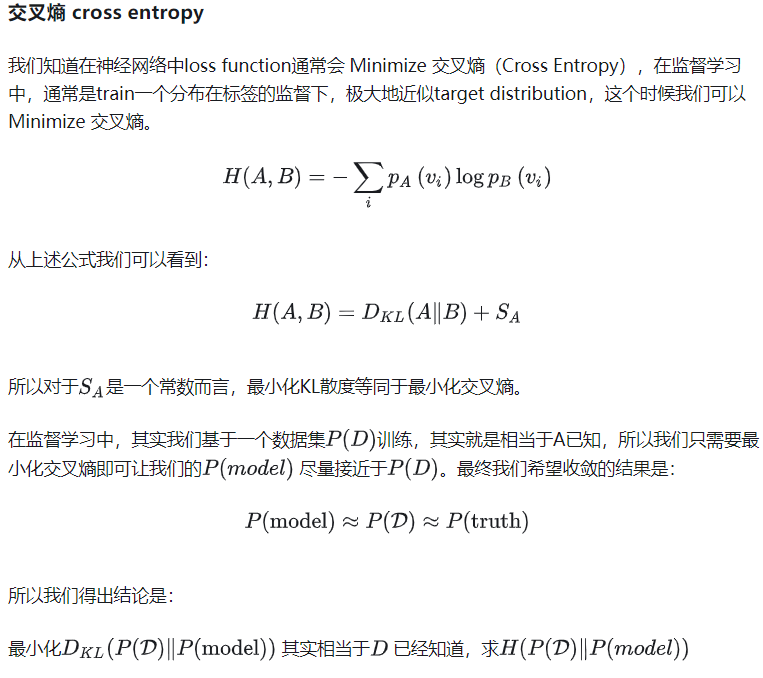

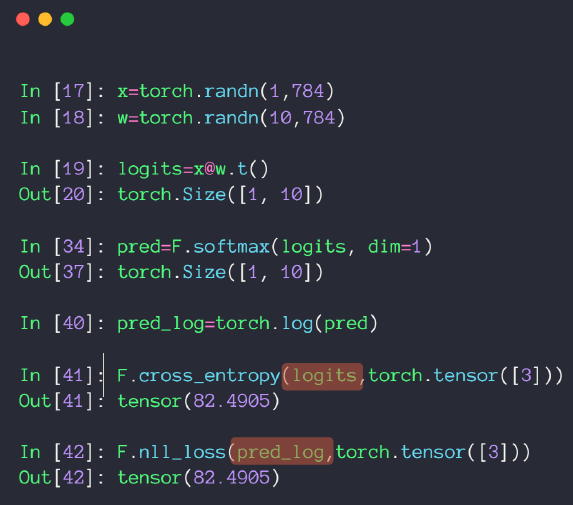

①交叉熵(分类问题):判断一个输出向量和期望向量有多接近。交叉熵刻画了两个概率分布之间的距离,他是分类问题中使用比较广泛的一种损失函数。概率分布刻画了不同事件发生的概率。

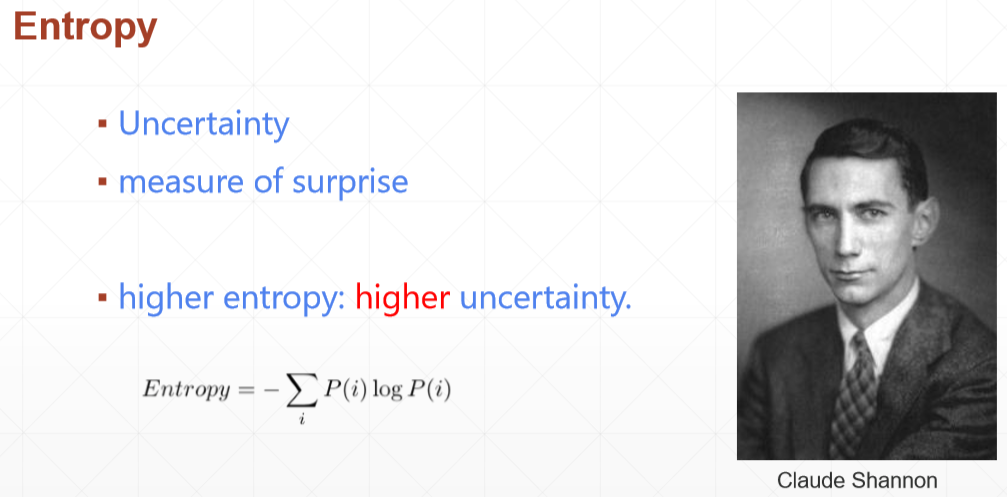

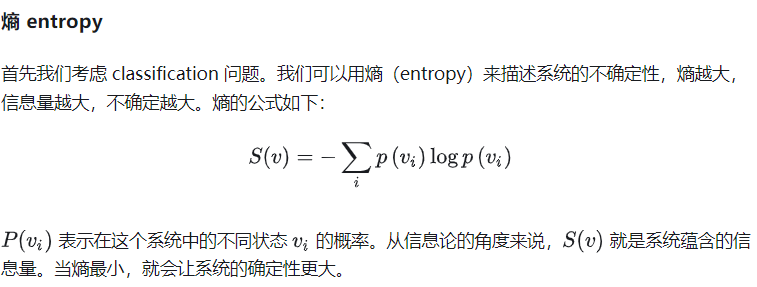

熵的定义:解决了对信息的量化度量问题,香农用信息熵的概念来描述信源的不确定度,第一次用数学语言阐明了概率与信息冗余度的关系。

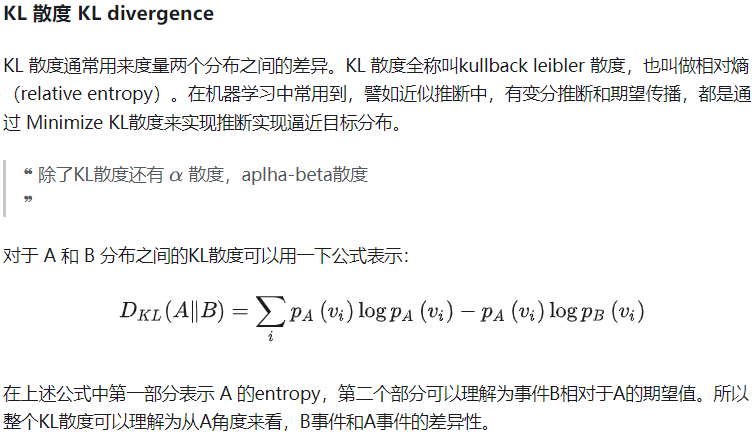

交叉熵和KL散度的区别?参考

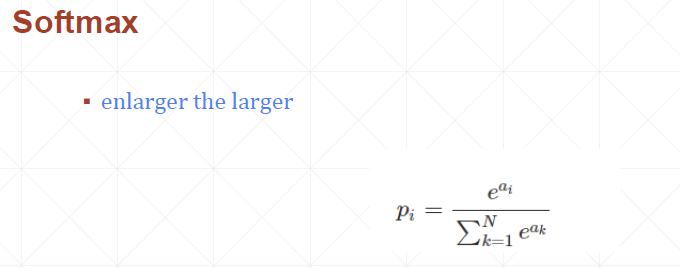

Softmax:原始神经网路的输出被作用在置信度来生成新的输出,新的输出满足概率分布的所有要求。这样就把神经网络的输出变成了一个概率分布,从而可以通过交叉熵来计算预测的概率分布和真实答案的概率分布之间的距离。

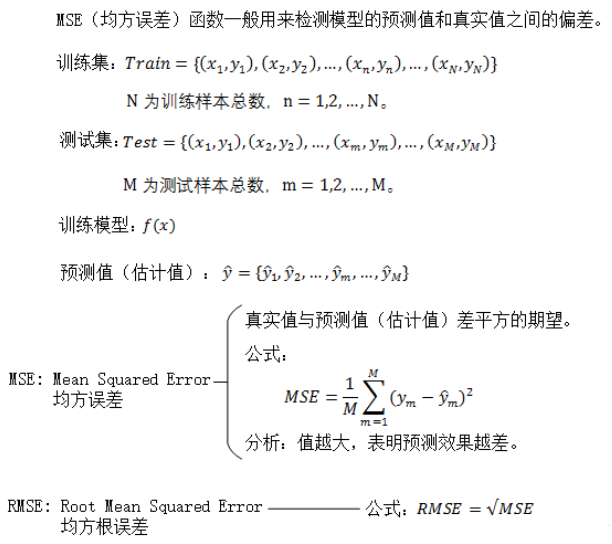

②回归问题解决的是对具体数值的预测。这些问题需要预测的不是一个事先定义好的类别,而是一个任意的实数。解决回归问题的神经网络一般只有一个输出结点,这个结点的输出值就是预测值。对于回归问题,最常用的损失函数就是均方误差(MSE,mean squared error):

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 记一次.NET内存居高不下排查解决与启示

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

2018-07-03 光速测定与引力波探测概述

2018-07-03 模电Multisim仿真Rb变化对Q点和电压放大倍数的影响