pytorch中的relu,sigmiod,tanh等激励函数(激活函数)

什么是激励函数(激活函数):

在神经网络中原本输入输出都是线性关系,但现实中,许多的问题是非线性的(比如,房价问题中,房价不可能随着房子面积的增加一直线性增加),这个时候就神经网络的线性输出,再经过激励函数,便使得原本线性的关系变成非线性了,增强了神经网络的性能。

常用的激励函数(激活函数):

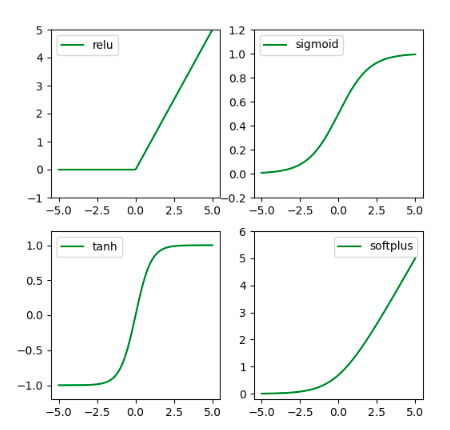

relu,sigmoid,tanh,softmax,softplus

torch 实现激励函数(激活函数):

torch 实现激励函数(激活函数):

"""

作者:Troublemaker

功能:activation_function

日期:2020/3/20 17:16

脚本:activation function.py

"""

import torch

import torch.nn.functional as F

from torch.autograd import Variable

import matplotlib.pyplot as plt # 为了方便找展示,用了matplotlib

# 生成数据

tensor_data = torch.linspace(-5, 5, 200)

variable_data = Variable(tensor_data)

np_data = variable_data.data.numpy()

# 激活函数 (转为numpy是为了画图)

relu_function = torch.relu(variable_data).data.numpy()

sigmoid_function = torch.sigmoid(variable_data).data.numpy()

tanh_function = torch.tanh(variable_data).data.numpy()

softplus_function = F.softplus(variable_data).data.numpy()

# 使用matplotlib作图

plt.figure(1, figsize=(6, 6))

plt.subplot(221)

plt.plot(np_data, relu_function, c="green", label="relu")

plt.ylim(-1, 5)

plt.legend(loc="best")

plt.subplot(222)

plt.plot(np_data, sigmoid_function, c="green", label="sigmoid")

plt.ylim(-0.2, 1.2)

plt.legend(loc="best")

plt.subplot(223)

plt.plot(np_data, tanh_function, c="green", label="tanh")

plt.ylim(-1.2, 1.2)

plt.legend(loc="best")

plt.subplot(224)

plt.plot(np_data, softplus_function, c="green", label="softplus")

plt.ylim(-0.2, 6)

plt.legend(loc="best")

plt.show()

效果图:

————————————————

版权声明:本文为CSDN博主「troublemaker、」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/weixin_44912159/article/details/104994863