Apache Hudi 流转批 场景实践

背景

在某些业务场景下,我们需要一个标志来衡量hudi数据写入的进度,比如:Flink 实时向 Hudi 表写入数据,然后使用这个 Hudi 表来支持批量计算并通过一个 flag 来评估它的分区数据是否完整从而进一步写入分区数据进行分区级别的ETL,这也就是我们通常说的流转批。

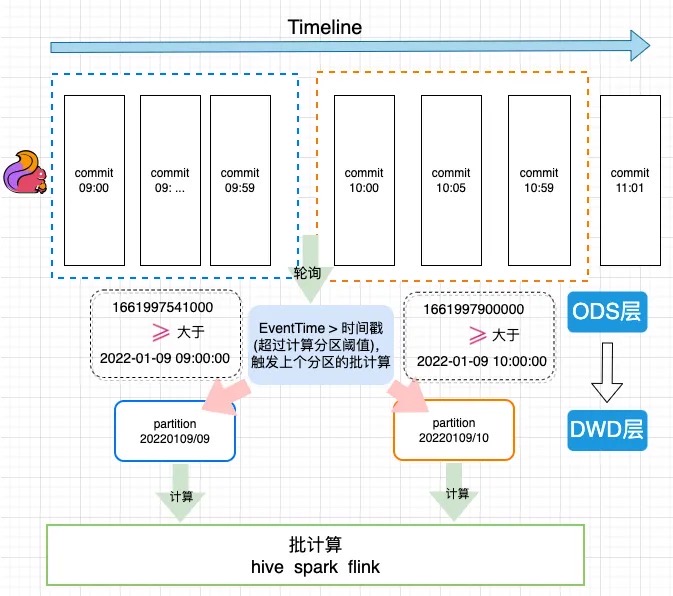

EventTime计算原理

图中Flink Sink包含了两个算子。第一个writer 算子,它负责把数据写入文件,writer在checkpoint触发时,会把自己写入的最大的一个时间传到commit算子中,然后commit算子从多个上游传过来的时间中选取一个最小值作为这一批提交数据的时间,并写入HUDI表的元数据中。

案例使用

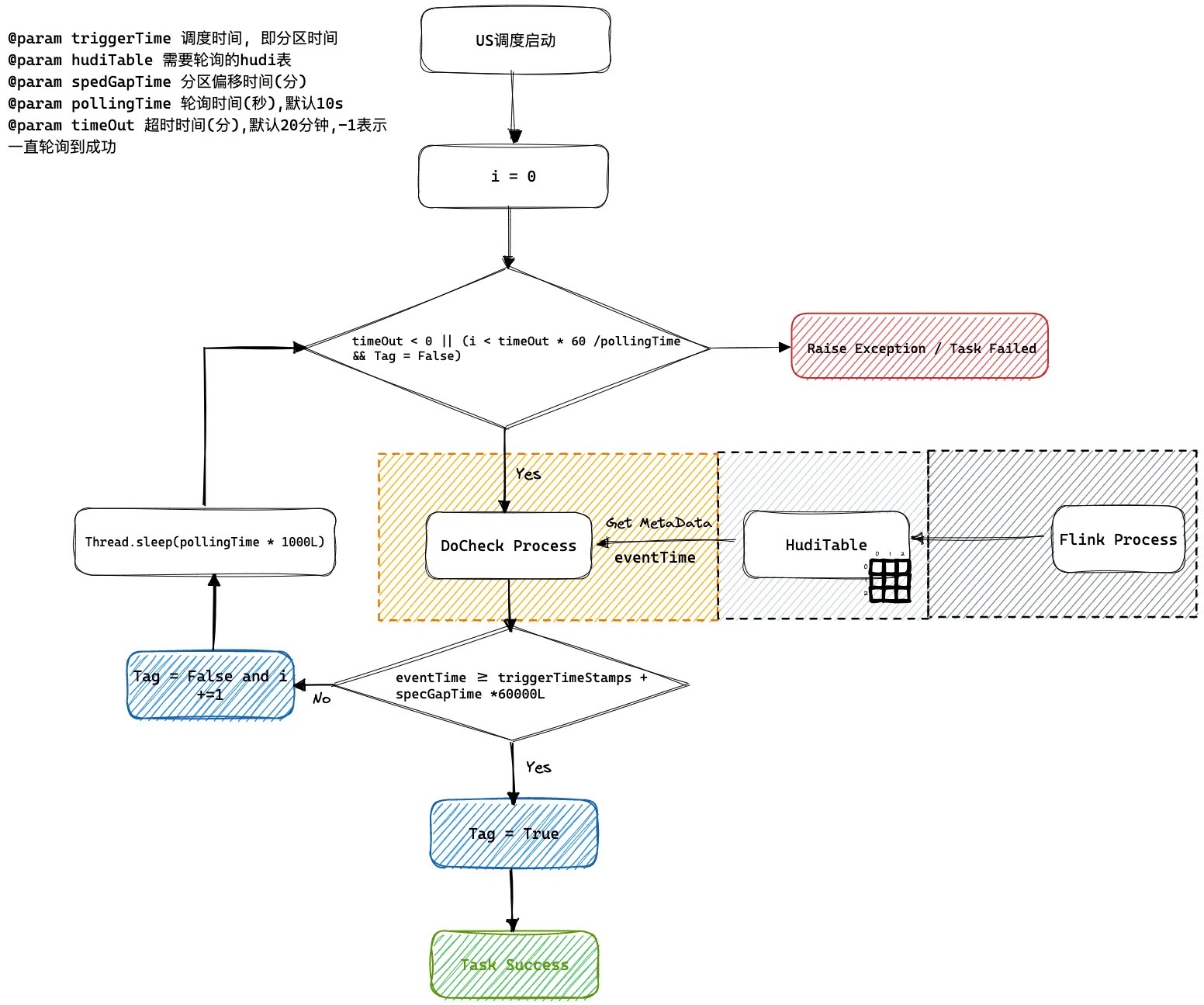

我们的方案是将这个进度值(EventTime)存储为 hudi 提交(版本)元数据的属性里,然后通过访问这个元数据属性获取这个进度值。在下游的批处理任务之前加一个监控任务去监控最新快照元数据。如果它的时间已经超过了当前的分区时间,就认为这个表的数据已经完备了,这个监控任务就会成功触发下游的批处理任务进行计算,这样可以防止在异常场景下数据管道或者批处理任务空跑的情况。

下图是一个flink 1分钟级别入库到HUDI ODS表, 然后通过流转批计算写入HUDI DWD表的一个执行过程。

US调度系统轮询逻辑

如何解决乱序到来问题, 我们可以通过设置spedGapTime来设置允许延迟到来的范围默认是0 不会延迟到来。

Maven pom 依赖

针对此功能特性的Hudi依赖版本如下

<dependencies>

<dependency>

<groupId>org.apache.hudi</groupId>

<artifactId>hudi-flink1.13-bundle</artifactId>

<version>0.12.1</version>

</dependency>

</dependencies>

<dependencies>

<dependency>

<groupId>org.apache.hudi</groupId>

<artifactId>hudi-flink1.15-bundle</artifactId>

<version>0.12.1</version>

</dependency>

</dependencies>

如何设置EventTime

能够解析的字段类型及格式如下:

| 类型 | 示例 |

|---|---|

| TIMESTAMP(3) | 2012-12-12T12:12:12 |

| TIMESTAMP(3) | 2012-12-12 12:12:12 |

| DATE | 2012-12-12 |

| BIGINT | 100L |

| INT | 100 |

Flink API

用户只需要设置flink conf指定时间字段作为时间推进字段

Map<String, String> options = new HashMap<>();

// 这里省略其他表字段

options.put(FlinkOptions.EVENT_TIME_FIELD.key(), "ts");

HoodiePipeline.Builder builder = HoodiePipeline.builder(targetTable)

.column("id int not null")

.column("ts string")

.column("dt string")

.pk("id")

.partition("dt")

.options(options);

Flink SQL

通过设置hoodie.payload.event.time.field指定需要计算的eventtime的字段

create table hudi_cow_01(\n" +

" uuid varchar(20),\n" +

" name varchar(10),\n" +

" age int,\n" +

" ts timestamp(3),\n" +

" PRIMARY KEY(uuid) NOT ENFORCED\n" +

")\n" +

" with (\n" +

// 这里省略其他参数

" 'hoodie.payload.event.time.field' = 'ts'\n"

")

如何读取EventTime

Spark SQL

call show_commit_extra_metadata(table => 'hudi_tauth_test.hudi_cow_01', metadata_key => 'hoodie.payload.event.time.field');

Java API

代码获取片段如下

Option<HoodieCommitMetadata> commitMetadataOption = MetadataConversionUtils.getHoodieCommitMetadata(metaClient, currentInstant);

if (!commitMetadataOption.isPresent()) {

throw new HoodieException(String.format("Commit %s not found commitMetadata in Commits %s.", currentInstant, timeline));

}

// 获取到当前版本的时间进度

String eventTime = commitMetadataOption.get().getExtraMetadata().get(FlinkOptions.EVENT_TIME_FIELD.key());

System.out.println("current eventTime: " + eventTime);

输出结果如下

current eventTime: 1667971364742

PS:如果您觉得阅读本文对您有帮助,请点一下“推荐”按钮,您的“推荐”,将会是我不竭的动力!

作者:leesf 掌控之中,才会成功;掌控之外,注定失败。

出处:http://www.cnblogs.com/leesf456/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文连接,否则保留追究法律责任的权利。

如果觉得本文对您有帮助,您可以请我喝杯咖啡!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!