本地部署DeepSeek

1.下载Ollama

Ollama是一个集成主流AI大模型的网站,使用是免费的,地址为:https://ollama.com/

GitHub 地址:https://github.com/ollama/ollama

打开之后点击Download按钮下载并且安装。

安装完成后在本地控制台输入ollama

lee@localhost ~ % ollama

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

查看ollaa版本ollama -v

lee@localhost ~ % ollama -v

ollama version is 0.5.7

查看本地安装的模型ollama list

lee@localhost ~ % ollama list

NAME ID SIZE MODIFIED

deepseek-r1:latest 0a8c26691023 4.7 GB 16 hours ago

我本地已经安装过deepseek-r1

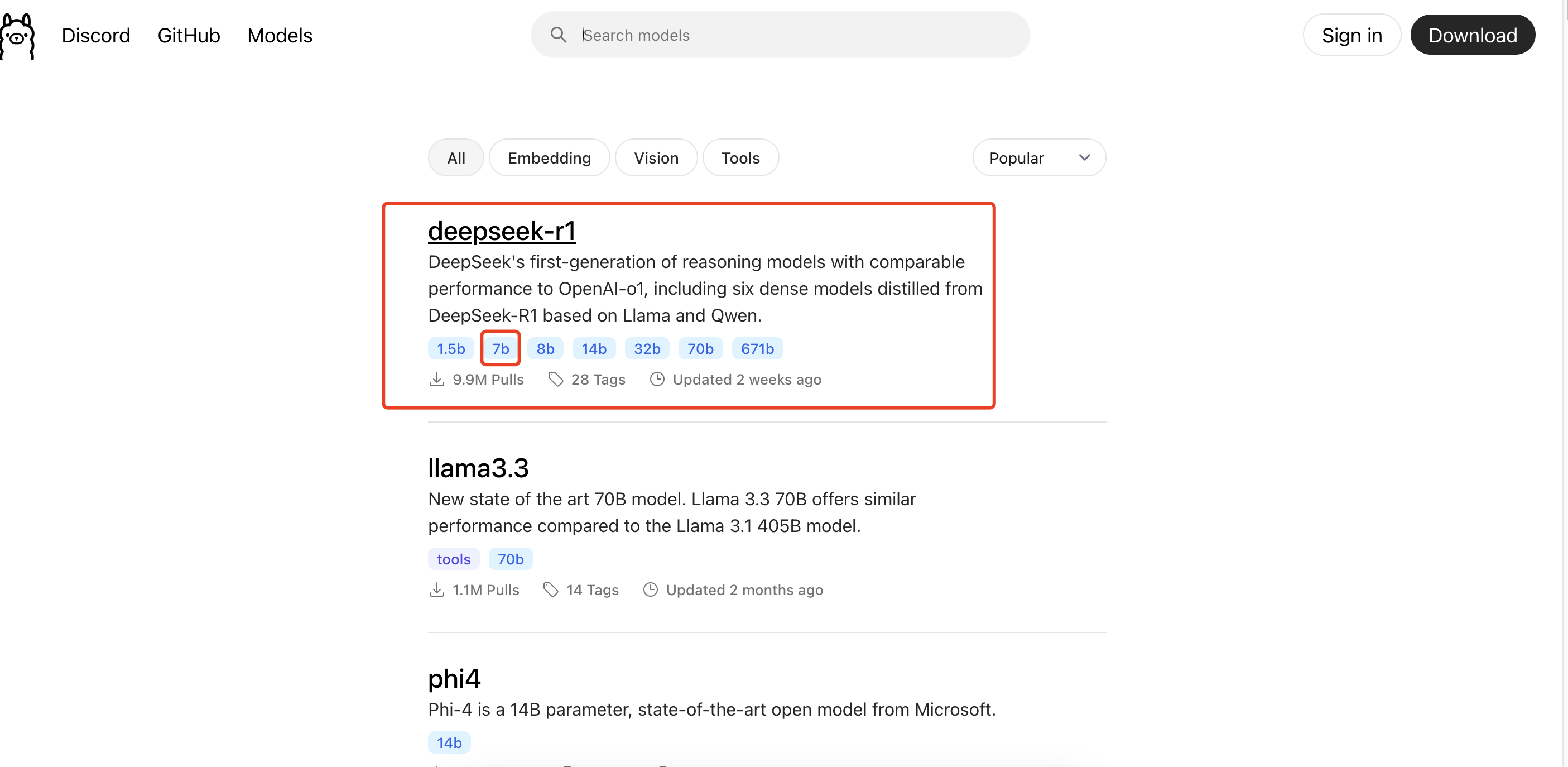

2.选择合适的DeepSeek版本并且安装

安装好Ollama之后就可以研究下载哪个版本的DeepSeek了,可供下载的有很多版本,其中比较推荐的是R1和V3。

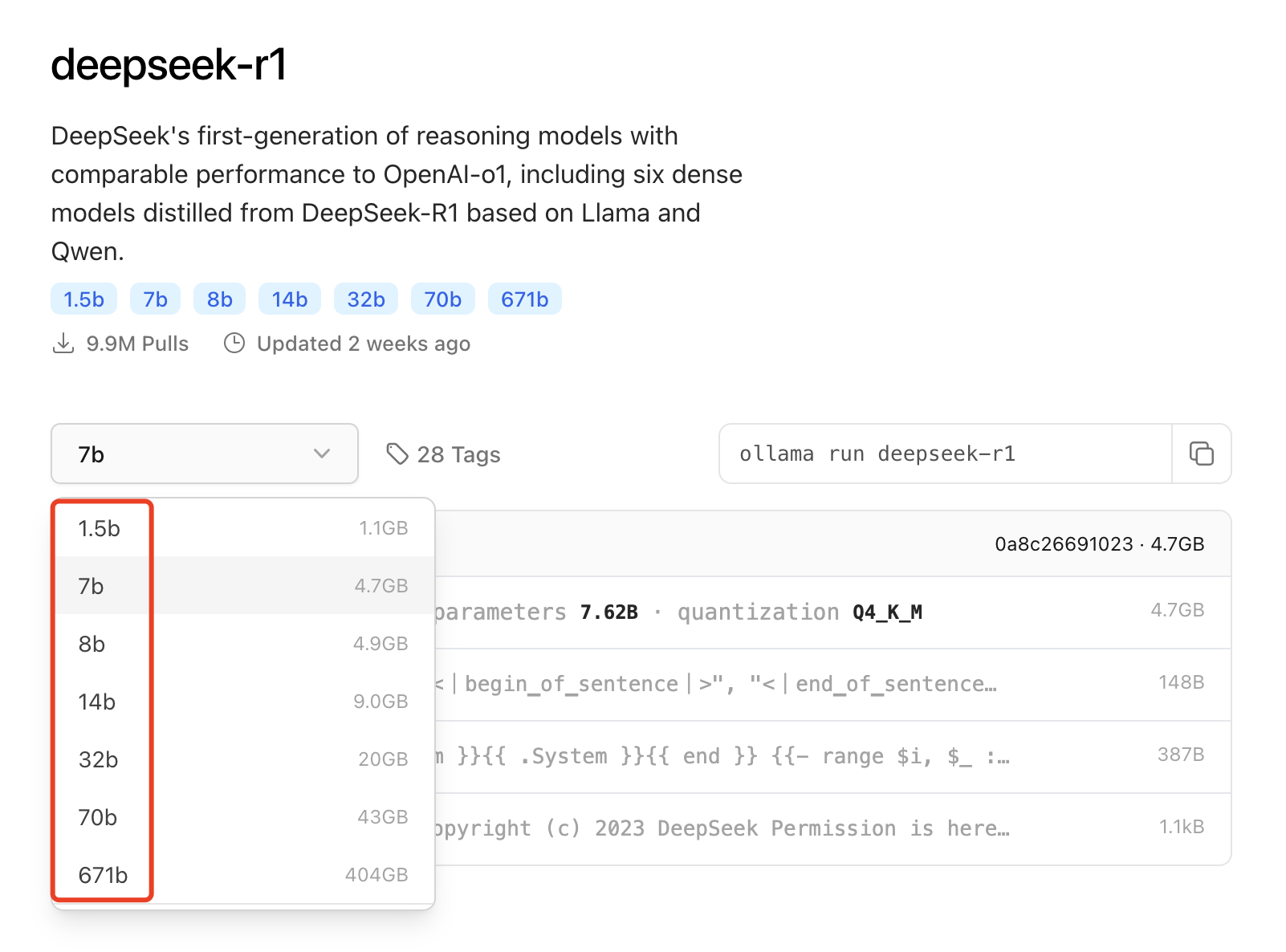

这两个的不同点为R1提供了从1.5B到671B不同大小的模型,而V3只有671B,而671B需要的电脑性能单个电脑几乎不可能满足,所以建议大家可以直接安装并且部署R1模型。

可以看到R1有7个版本,其中最小的是1.5b,它需要的内存大小为1.1GB,这个要求几乎所有的电脑都可以满足,可以作为尝试。

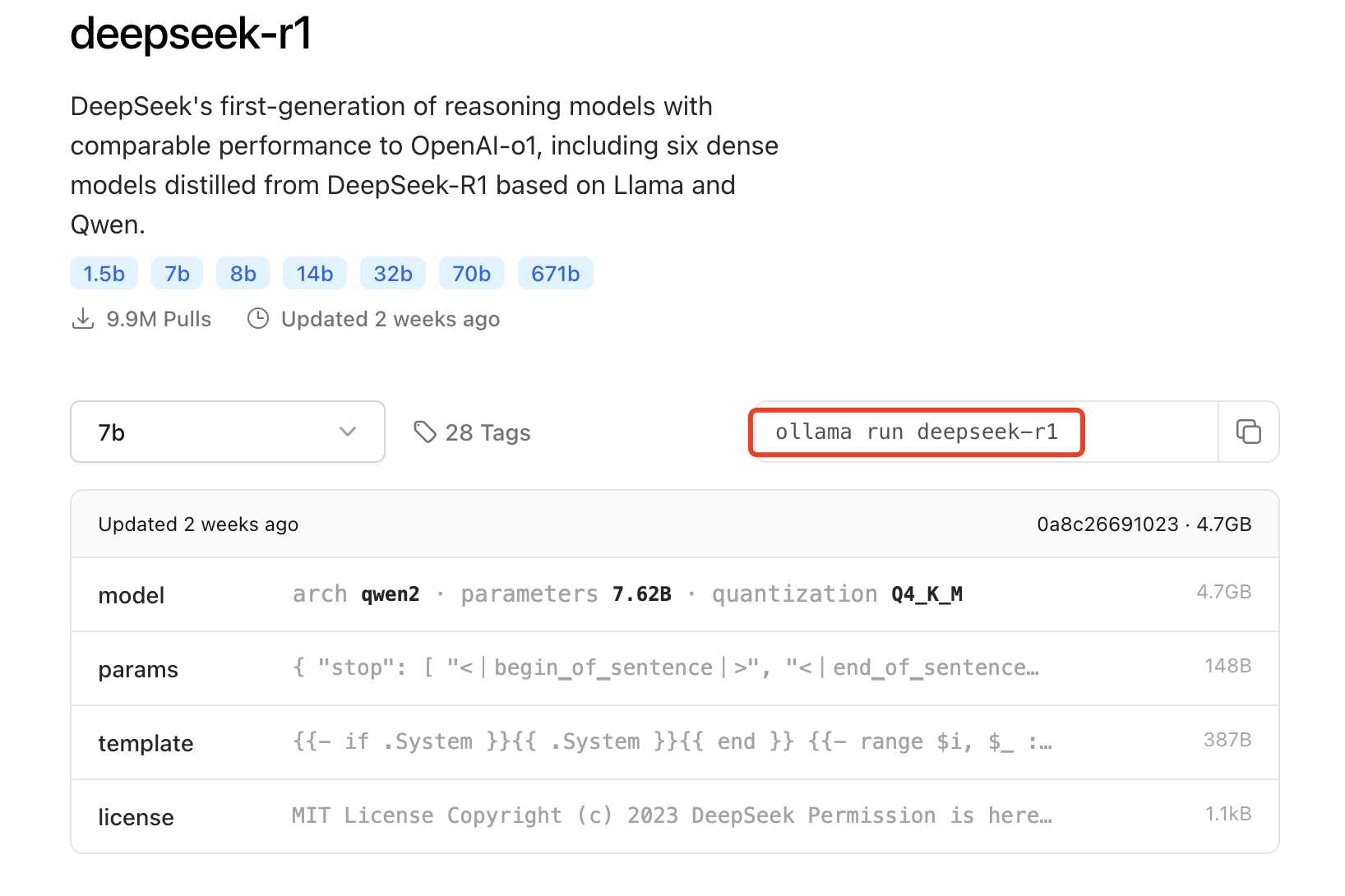

3.打开命令行并输入安装代码

选择7b,复制安装代码

终端输入安装代码ollama run deepseek-r1等待安装

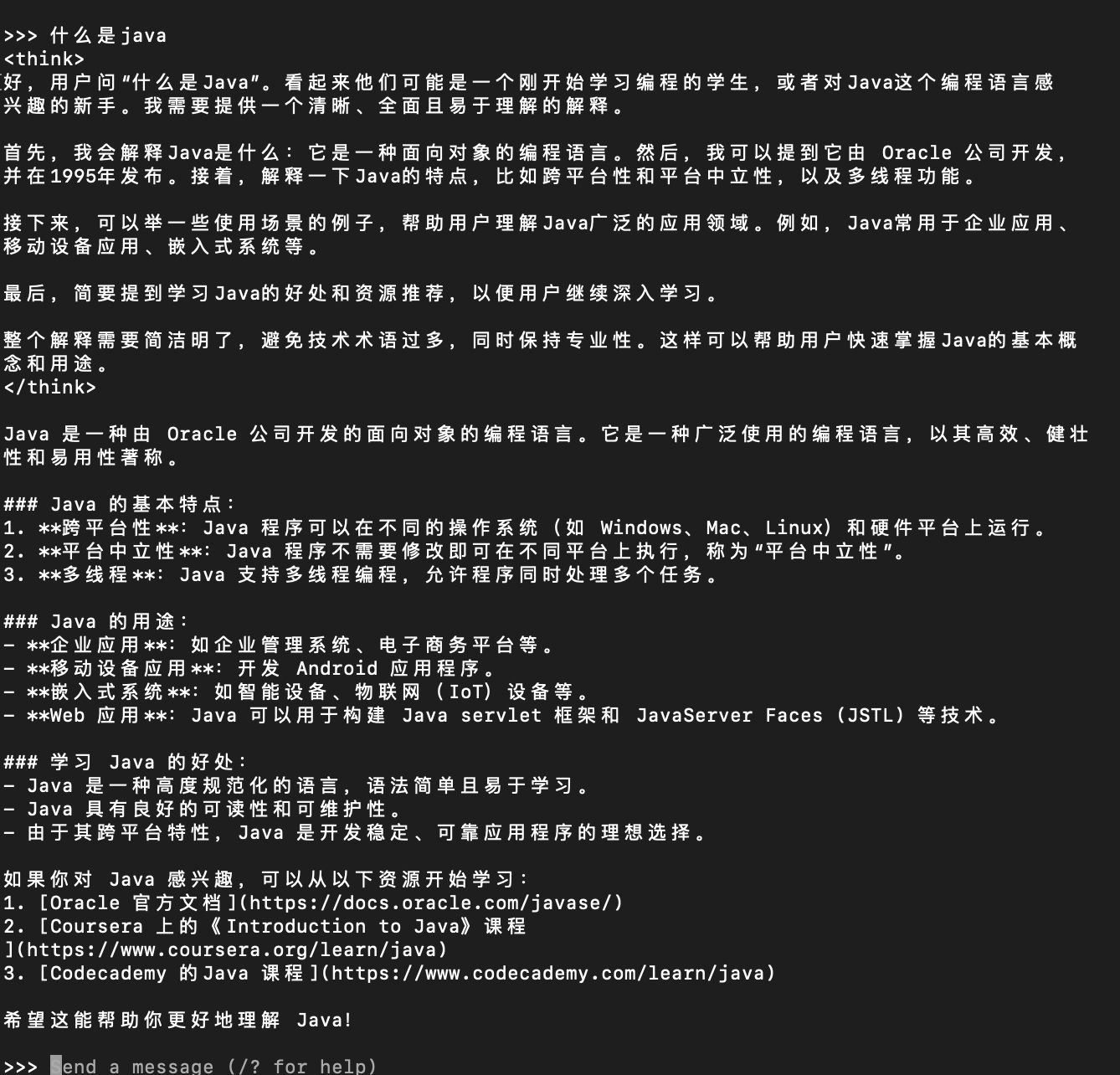

输入问题

浙公网安备 33010602011771号

浙公网安备 33010602011771号