idea中运行hadoop的案例使用打jar包的方式操作(HDFS java API)

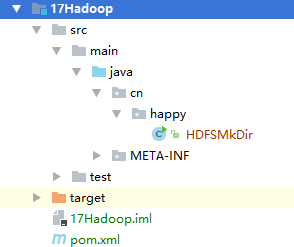

1.项目架构

创建quistart项目

2.导入jar包

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd"> <parent> <artifactId>Y2166</artifactId> <groupId>cn.happy</groupId> <version>1.0-SNAPSHOT</version> </parent> <modelVersion>4.0.0</modelVersion> <artifactId>17Hadoop</artifactId> <packaging>jar</packaging> <name>17Hadoop</name> <url>http://maven.apache.org</url> <properties> <project.build.sourceEncoding>UTF-8</project.build.sourceEncoding> </properties> <dependencies> <dependency> <groupId>junit</groupId> <artifactId>junit</artifactId> <version>4.3</version> <scope>test</scope> </dependency> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-common</artifactId> <version>2.8.0</version> <scope>provided</scope> </dependency> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-mapreduce-client-jobclient</artifactId> <version>2.8.0</version> <scope>provided</scope> </dependency> <dependency> <groupId>org.apache.hadoop</groupId> <artifactId>hadoop-hdfs</artifactId> <version>2.2.0</version> </dependency> <dependency> <groupId>commons-cli</groupId> <artifactId>commons-cli</artifactId> <version>1.2</version> </dependency> </dependencies> </project>

4个

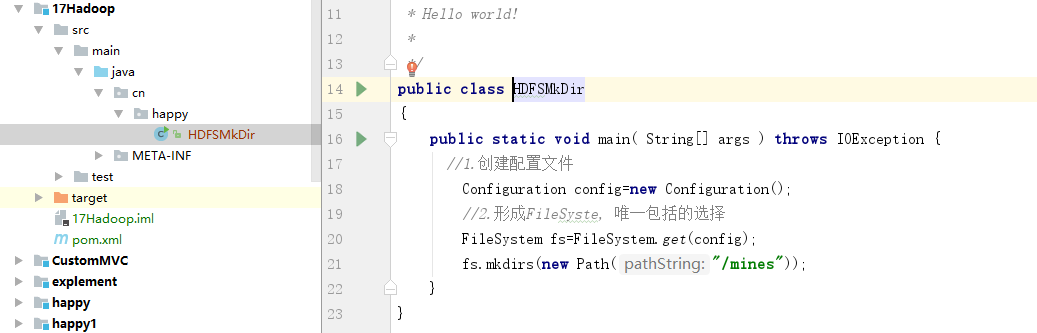

3.正如上图中新建HDFSMkDir类

package cn.happy; import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; import java.io.IOException; /** * Hello world! * */ public class HDFSMkDir { public static void main( String[] args ) throws IOException { //1.创建配置文件 Configuration config=new Configuration(); //2.形成FileSyste, 唯一包括的选择 FileSystem fs=FileSystem.get(config); fs.mkdirs(new Path("/mines")); } }

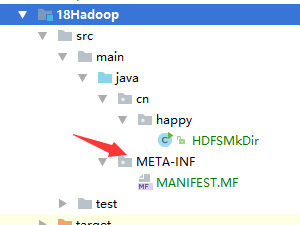

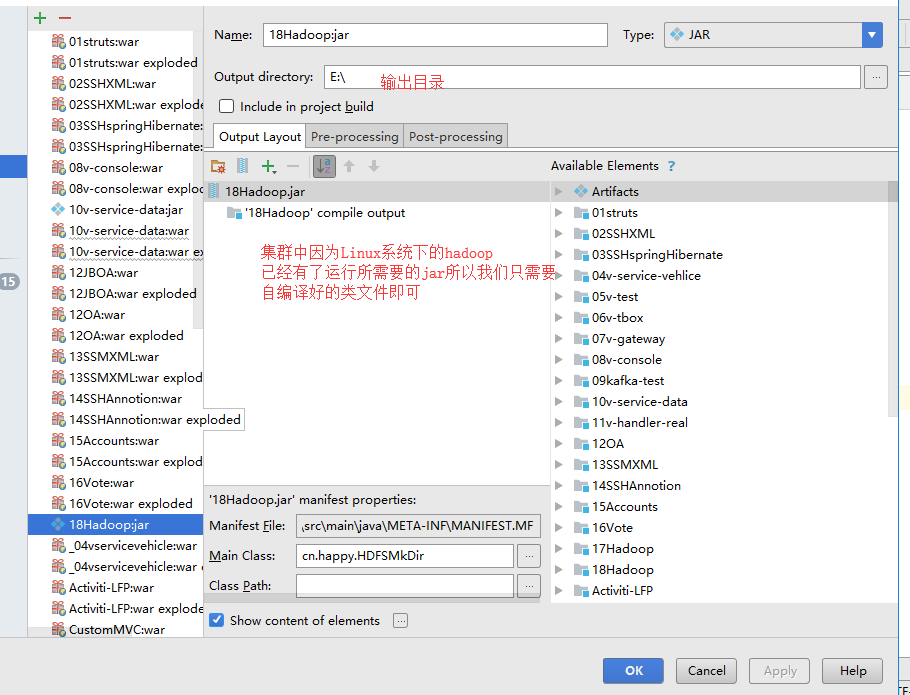

4.开始打jar包

到此为止打包完成

在你的E盘会看到jar因为刚才选择输出的目录是E盘

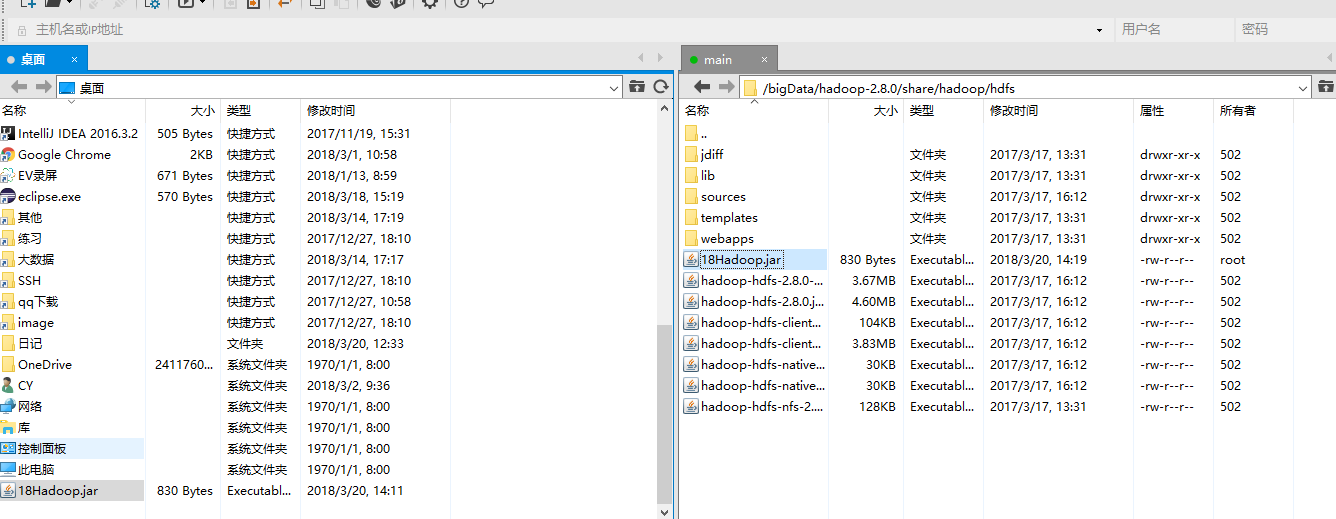

5.我们把打包好的jar通过xftp上传到Linux中

最好放到这里因为......

6.运行jar

[root@main hdfs]# hadoop jar 18Hadoop.jar cn.happy.HDFSMkDir

[root@main hdfs]#

访问网址你的主机地址:50070打卡页面会发现有我们通过HDFS API创建的mines目录

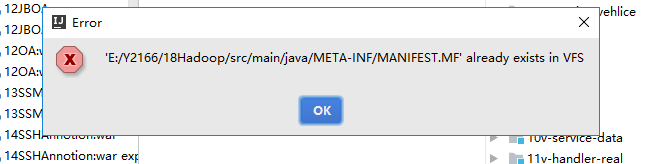

7.但是还没完,如果我们修改了项目在想在打jar包的化idea回报一个错误

解决办法有两种

1.原来的出输出目录下的jar输出目录删掉重新生成

2.把这个文件删掉