基于 Keras 实现图像风格转移

Style Transfer 这个方向火起来是从2015年Gatys发表的Paper A Neural Algorithm of Artistic Style(神经风格迁移) , 这里就简单提一下论文的主要思想。

论文概述

Gatys这篇论文的核心思想就是 —— 图片的内容和风格是可以分离的,可以通过神经网络的方式,将图片的风格进行自由交换。

如果内容和风格是可以分离的,那么风格的迁移即可转化成这样一个问题:让生成图片的内容与内容来源图片尽可能相似,让图片的风格与风格来源图片尽可能相似。

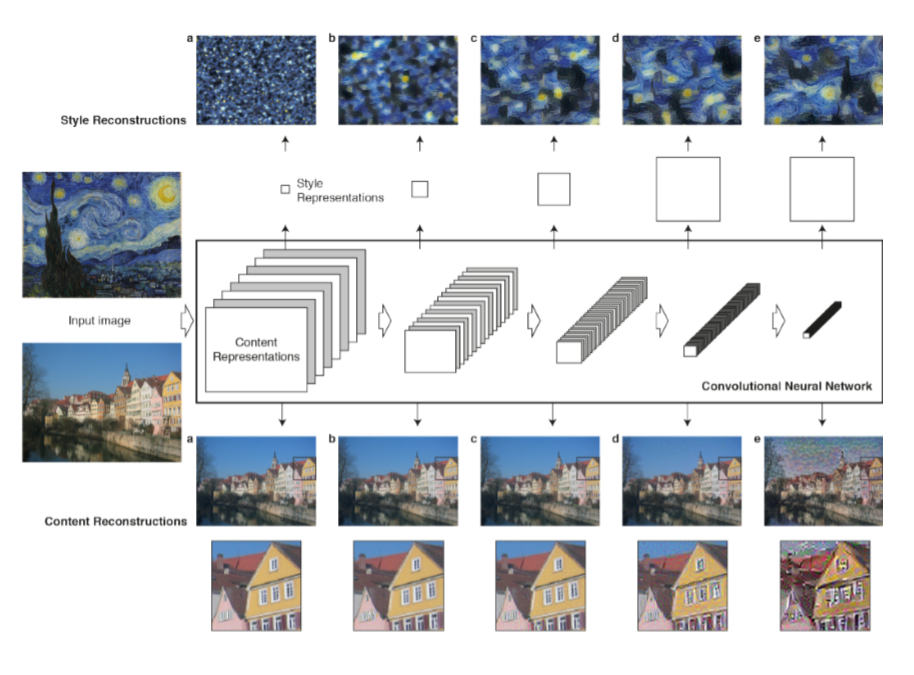

那么如何才能将图片的风格提取出来呢?Gatys发现纹理能够描述一个图像的风格,也就是说只要提取出图片的纹理就可以了。那么如何又提取出图像的纹理呢,Gatys发现VGG19网络其实就相当于一堆局部特征识别器,他在VGG19的基础上套了一个格拉姆矩阵(Gram matrix)用来计算不同局部特征的相关性,把它变成里一个统计模型,这样图像纹理提取已经完成了。剩下的就比较轻松了,前文提到VGG19 相当于一堆局部特征识别器,于是Gatys直接把局部特征看作近似的图像内容,这样就得到了一个将图像内容与纹理分开的系统。而将内容与纹理合成的方法就是Google 由2015年夏天首次发布的 DeepDream 方法,找到能让合适的特征提取神经元被激活的图片即可。

至此, A Neural Algorithm of Artistic Style 的主要思想已经解释完了。

实现

神经风格迁移的一般步骤:

- 创建一个网络,它能够同时计算风格参考图像、目标图像和生成图像的 VGG19 层激活。

- 使用这三张图像上计算的层激活来定义之前所述的损失函数,为了实现风格迁移,需要将这个损失函数最小化。

- 设置梯度下降过程来将这个损失函数最小化。