CNN

计算机视觉领域三大顶级国际会议:

1. 国际计算机视觉和模式识别大会(Computer Vision and Pattern Recognition,CVPR)

2. 国际计算机视觉大会(International Conference on Computer Vision,ICCV)

3.欧洲计算机视觉大会(European Conference on Computer Vision,ECCV)

LeNet

用于字符识别

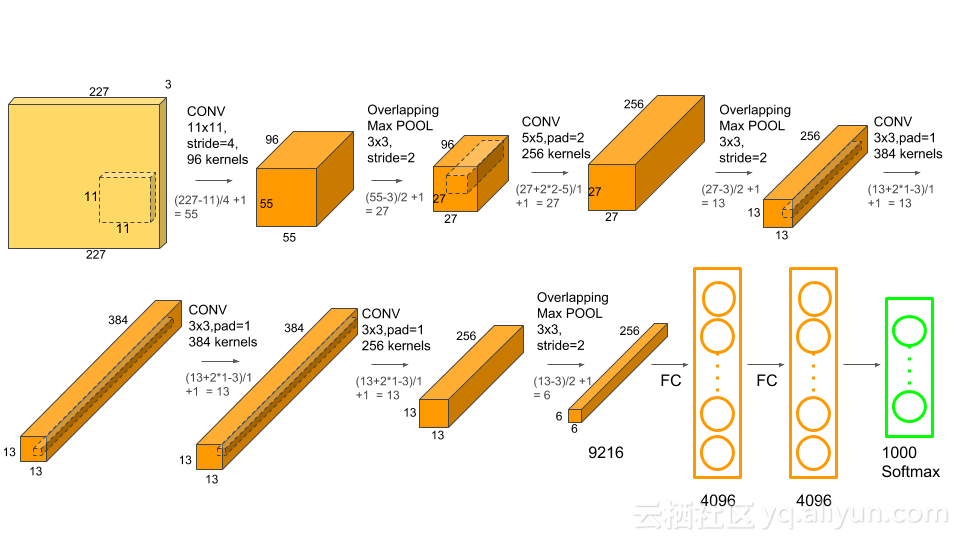

Alex-Net

使用ReLU激活函数;使用Dropout和数据增强减少过拟合;使用重叠的最大池化;LRN(Local Response Normalization)层,对局部神经元的活动创建竞争机制;CUDA训练加速;

在所有的卷积层和全连接层之后,都应用了ReLU非线性函数。首先第一和第二个卷积层都应用ReLU非线性函数,然后进行局部标准化,最后执行pooling操作方法。

数据增强使用的方法:镜像图像;随机裁剪原始图像;Dropout

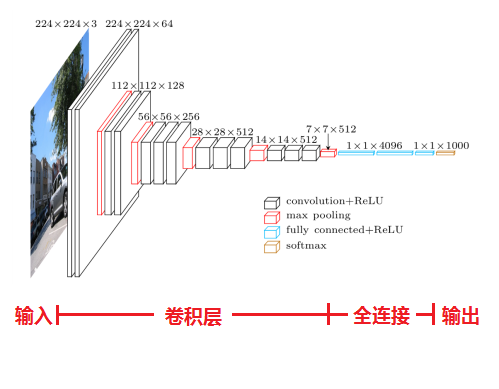

VGG-Net

使用了更小的3*3卷积核和更深的网络,一方面可以减少参数,另一方面相当于进行了更多的非线性映射,可以增加网络的拟合/表达能力。VGG的作者认为两个3x3的卷积堆叠获得的感受野大小,相当一个5x5的卷积;而3个3x3卷积的堆叠获取到的感受野相当于一个7x7的卷积。这样可以增加非线性映射,也能很好地减少参数(例如7x7的参数为49个,而3个3x3的参数为27)

相比AlexNet的3x3的池化核,VGG全部采用2x2的池化核。

VGG网络第一层的通道数为64,后面每层都进行了翻倍,最多到512个通道,通道数的增加,使得更多的信息可以被提取出来。

残差网络ResNet

卷积神经网络的压缩

低秩近似:将一个权重矩阵表示为多个低秩矩阵的组合。

数据扩充

图像水平翻转、随机抠取、尺度变换、旋转、色彩抖动、Fancy PCA、监督式数据扩充

网络参数初始化

在卷积神经网络求解时,常采用批处理的随机梯度下降法(mini-batch SGD),不同批处理之间按照无放回抽样遍历所有样本,遍历一次训练样本称为“一轮epoch”。

Pooling汇合层:最大汇合、平均汇合、随机汇合