论文阅读:gUNet

题目:Rethinking Performance Gains in Image Dehazing Networks

paper: https://arxiv.org/pdf/2209.11448v1.pdf

code: https://github.com/idkiro/gunet

摘要:图像去雾是低层视觉中的一个活跃话题,随着深度学习的快速发展,许多图像去雾网络被提出。尽管这些网络的工作良好,但提高图像去叠性能的关键机制仍不清楚。出于这个原因,我们不打算提出一个具有奇特模块的去雾网络;相反,我们对流行的U-Net进行最小的修改以获得紧凑的去雾网络。具体来说,使用选通机制将U-Net中的卷积块替换为剩余块,使用选择性内核融合主路径和跳过连接的特征图,并调用生成的U-Net变体gUNet。因此,gUNet以显著降低的开销,在多个图像去叠数据集上优于最先进的方法。最后,通过广泛的消融研究验证了这些关键设计对图像去雾网络性能增益的影响。

论文的动机:大多数基于学习的方法倾向于设计复杂的网络架构以提高网络的表达能力,虽然这些网络能够取得不错的效果,但是提高图像去雾的关键机制不清楚。因此作者没有提出特殊模块,旨在用最小的修改获得优秀的性能。

主要思想:在去雾网络的发展历史上,有两个方法带来了显著的性能提升。一个是引入提取多尺度特征的方法,另一个是引入注意力机制的深度网络。其他作品很多都是在这两种方案上进行完善和扩充,使得网络更加复杂而不易部署。因此考虑在简单网络的基础上,从这两个方面重新设计,获取简单而有效的网络。

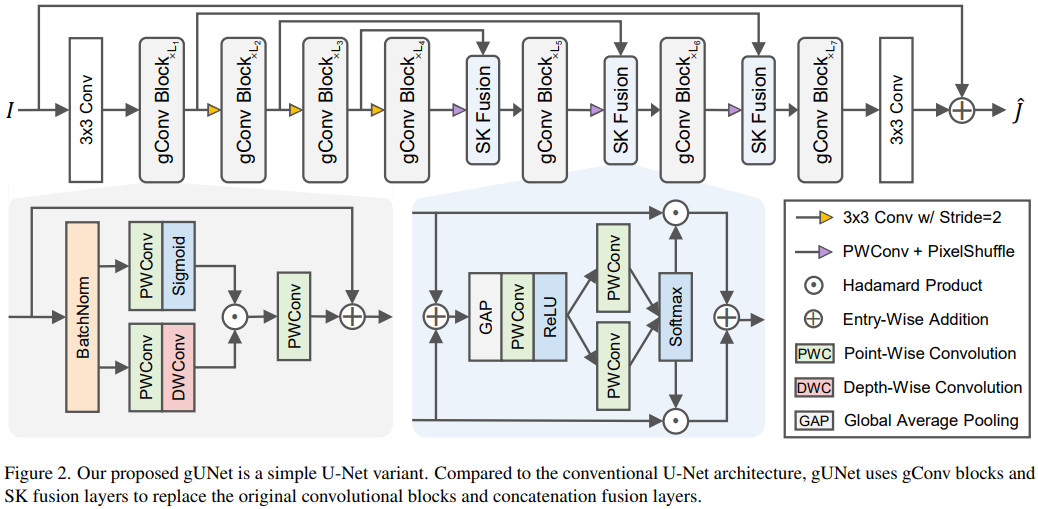

网络的总体架构:

针对如何提取多尺度信息:采用U-Net作为基础架构,能够生成不同尺寸的特征图,从未提取多尺度特征。引入局部残差和全局残差有助于提取多尺度信息。在不显著增加参数量和计算成本的前提下为了使网络更深,使用深度可分离卷积有效地聚集信息特征。

针对如何利用注意力机制来提高网络地表达能力:大气散射模型方程中,大气光A是共享的全局变量,t(x)是与位置相关的局部变量。在FFA网络中通道注意力机制能够有效提取计算A所需要的信息,因此设计了SK融合模块,动态融合来自不同路径的特征图,起到通道注意力机制相同的效果,有效提取A所需的信息。提取t(x)所需信息的任务可以由像素注意力模块来实现,旨在使网络更关注信息特征。而GLU中的门控机制具有类似的作用,因此在卷积块中引入了门控机制,使其充当像素注意模块和非线性激活函数,这样也可以省去传统的激活函数。

gConv块:

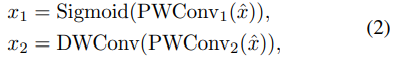

gConv主要基于gMLP和GLU。假设x是特征图,我们首先使用BatchNorm通过ˆx=BatchNorm(x)对其进行规格化。为了进行推断,BatchNorm使用训练中跟踪的统计数据的指数移动平均值。它可以与相邻的线性层合并,更符合轻量级网络的要求。此外,BatchNorm没有LayerNorm的缺陷,它破坏了DehazeFormer中提到的空间相关性。

其中PWConv表示逐点卷积层,DWConv表示深度卷积层。然后,我们使用x1作为x2的选通信号,然后使用另一个PWConv进行投影,并将输出与恒等式快捷方式x相加,其公式如下:

SK Fusion:

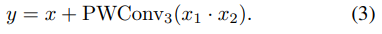

SK融合层是SK模块的简单修改。类似的想法可以在MIRNet和DehazeFormer中找到。假设两个特征图是x1和x2,其中x1是跳过连接的特征图,x2是主路径的特征图。首先使用PWConv层f(·)将x1投影到ˆx1=f(x1)。使用全局平均池GAP(·)、MLP(PWConv ReLU PWConv)Fmlp(·),softmax函数和分裂运算来获得融合权重:

最后,通过y=a1ˆx1+a2x2融合ˆx1,x2。为了减少参数数量,MLP的两个PWConv层是降维和增维层。

其他:为什么使用BatchNorm,而不是LayerNorm。BatchNorm使用训练中跟踪的统计数据的指数移动平均值。它可以与相邻的线性层合并,更符合轻量级网络的要求。此外,BatchNorm没有LayerNorm的缺陷,它破坏了DehazeFormer中提到的空间相关性。

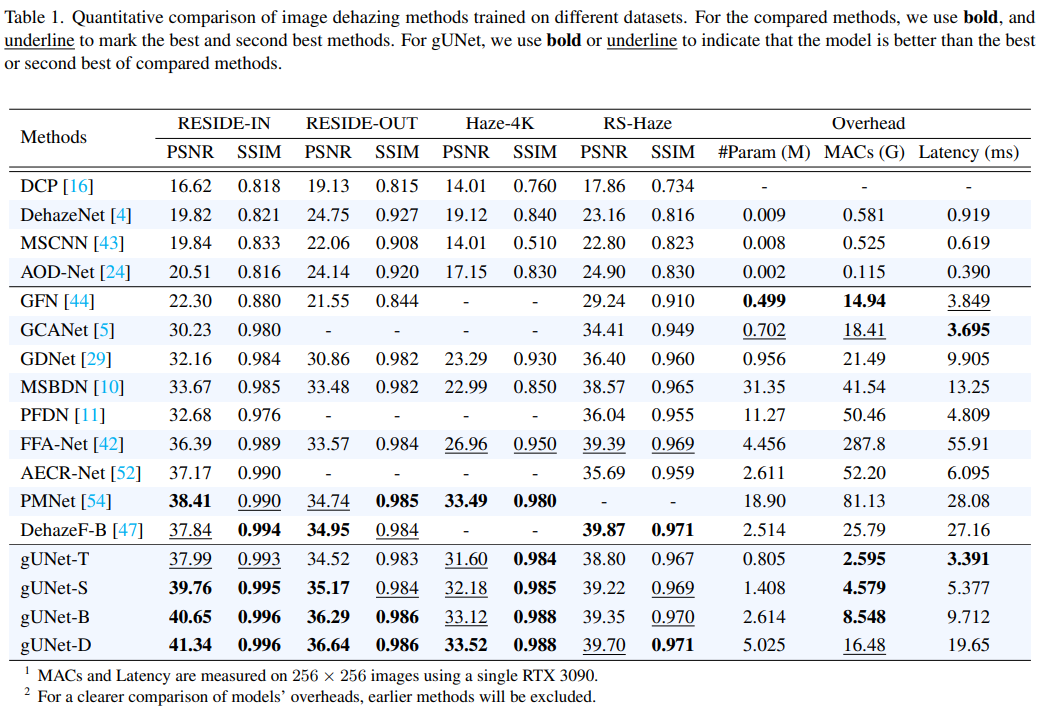

实验结果:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列1:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

· 【杂谈】分布式事务——高大上的无用知识?