SwinIR

SwinIR: Image Restoration Using Swin Transformer

摘要

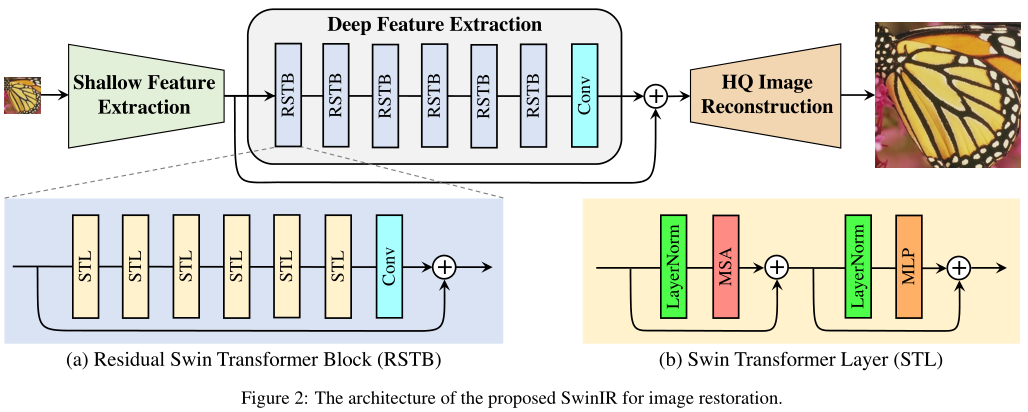

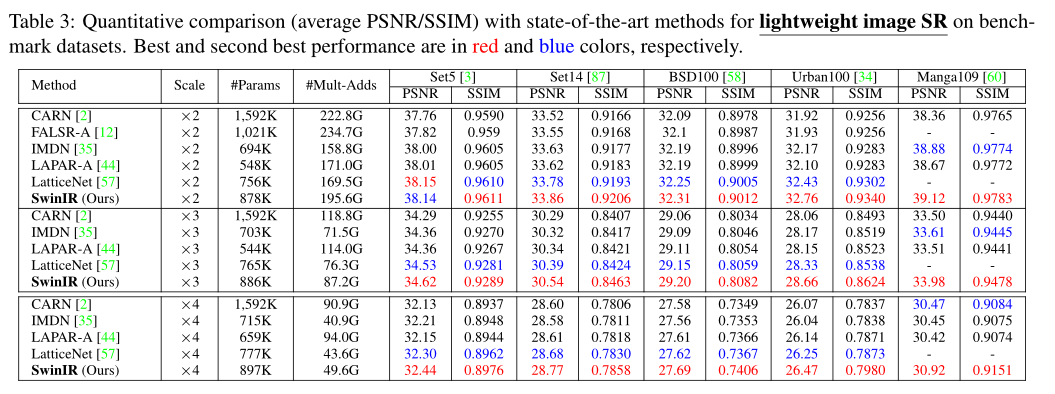

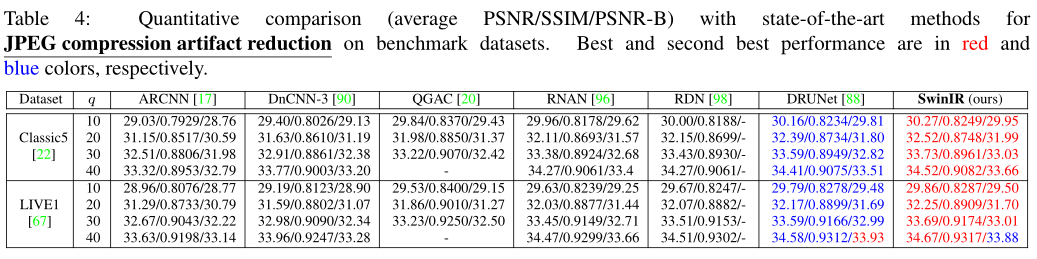

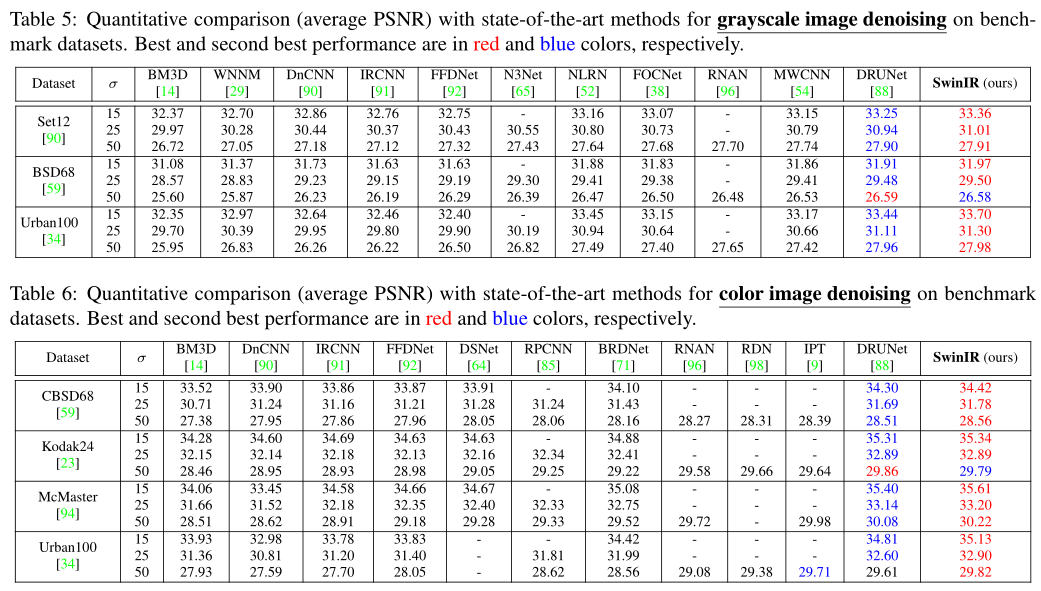

图像恢复是一个长期存在的低水平视觉问题,其目的是从低质量图像(例如缩小比例、噪声和压缩图像)中恢复高质量图像。虽然最先进的图像恢复方法是基于卷积神经网络的,但很少有人尝试使用在高级视觉任务中表现出出色性能的Transformer。在本文中,我们提出了一种基于Swin变换的用于图像恢复的强基线模型SwinIR。SwinIR由三部分组成:浅层特征提取、深度特征提取和高质量图像重建。特别是,深度特征提取模块由几个剩余的Swin Transformer(RSTB)组成,每个RSTB都有几个Swin Transformer层和一个剩余连接。我们在三个代表性任务上进行了实验:图像超分辨率(包括经典、轻型和真实世界的图像超分辨率)、图像去噪(包括灰度和彩色图像去噪)和JPEG压缩伪影减少。实验结果表明,SwinIR在不同任务上的性能优于最先进的方法,最高可达0.14∼0.45dB,而参数总数最多可减少67%

问题

-

大多数基于CNN的方法专注于精细的架构设计,如残余学习和密集连接。 它们通常面临两个基本问题,这两个问题源于基本卷积层。首先,图像和卷积核之间的交互与内容无关。使用相同的卷积核来恢复不同的图像区域可能不是最佳选择。其次,在局部处理原则下,卷积对长程依赖建模无效。

-

Transformer设计了一种自注意力机制来捕捉语境之间的全局交互,作为CNN的替代方案,它在几个视觉问题上表现出了良好的性能。然而,用于图像恢复的视觉Transformer通常将输入图像分割成固定大小的面片(例如48×48),并独立处理每个面片。这种策略会产生两个缺点。首先,边界像素不能利用邻接像素进行图像恢复。其次,恢复的图像可能会在每个面片周围引入边界伪影。虽然这个问题可以通过面片重叠来缓解,但它会带来额外的计算负担。

网路

Network Architecture

在特征提取结束时使用卷积层可以将卷积运算的感应偏差引入基于Transformer的网络,并为后期的浅层和深层特征聚合奠定更好的基础。

RSTB

Residual Swin Transformer Block

这种设计有两个好处。首先,虽然Transformer可以被视为空间变化卷积的特定实例,但具有空间不变性滤波器的共解层可以增强SwinIR的平移等效性。其次,残差连接提供了从不同块到重建模块的基于身份的连接,允许聚合不同级别的特征。

STL

Swin Transformer layer

Swin Transformer层(STL)基于原始Transformer层的标准多头自注意力。主要区别在于局部注意和窗口移位机制。

Loss

image SR: L1 pixel loss

classical and lightweight image SR: L1 pixel loss

real-world image SR: a combination of pixel loss, GAN loss and perceptual loss

image denoising and JPEG compression artifact reduction: Charbonnier loss

创新

-

图像内容和注意力权重之间基于内容的交互,可以解释为空间变化卷积

-

长程依存关系建模是通过移位窗口机制实现的

实验

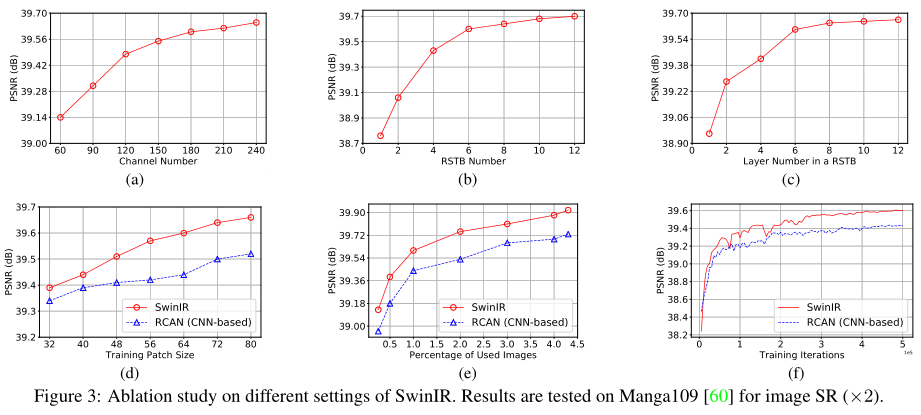

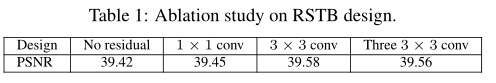

Ablation Study

Impact of channel number, RSTB number and STL number.

Impact of patch size and training image number; model convergence comparison.

Impact of residual connection and convolution layer in RSTB.

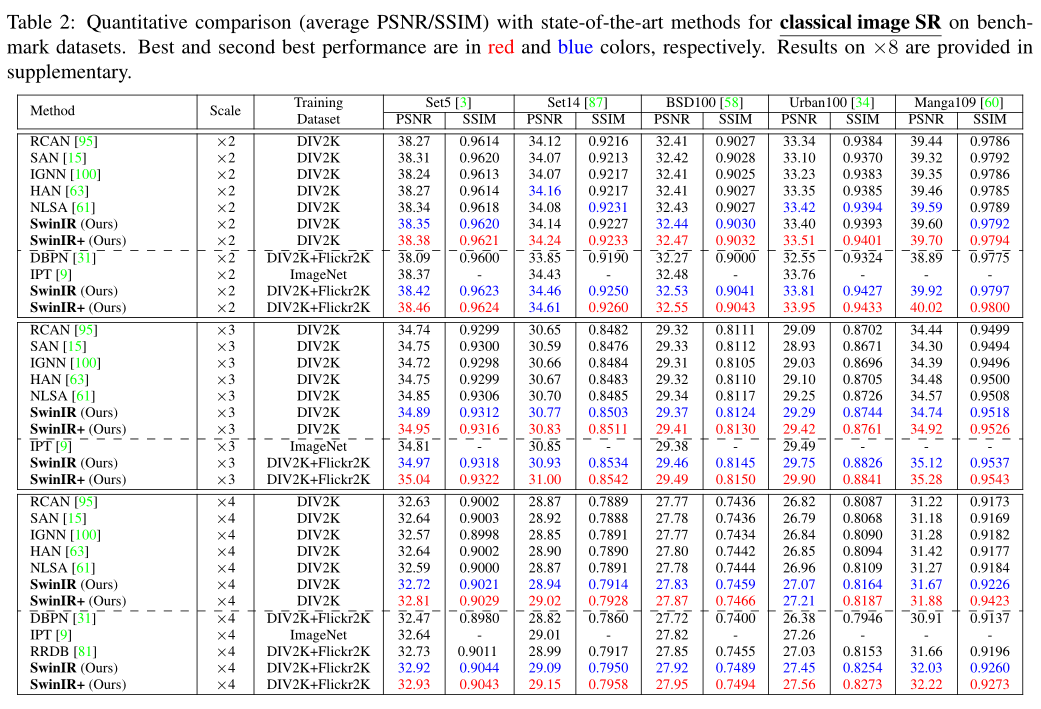

Comparison with SOTA

本文提出了一种基于Swin变换的图像恢复模型SwinIR。该模型由三部分组成:浅层特征提取、深度特征提取和HR重构模块。特别是,我们使用一堆剩余的Swin变换块(RSTB)进行深度特征提取,每个RSTB由Swin变换层、卷积层和剩余连接组成。大量实验表明,SwinIR在三种代表性的图像恢复任务和六种不同设置上达到了最先进的性能:经典图像SR、轻型图像SR、真实图像SR、灰度图像去噪、彩色图像去噪和JPEG压缩伪影减少,这证明了所提SwinIR的有效性和通用性。未来,我们将把该模型扩展到其他恢复任务,如图像去模糊和去雨。

-

Transformer通过探索不同区域之间的全局交互来学习关注重要的图像区域

-

Swin Transformer融合了CNN和Transformer的优点。一方面,由于局部注意力机制,它具有CNN处理大尺寸图像的优势。另一方面,它具有Transformer的优点,可以用移位窗口方案建模长期依赖。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列1:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

· 【杂谈】分布式事务——高大上的无用知识?