【深度学习】学习率的一些问题思考

下午炼丹的时候, 遇到两个问题:

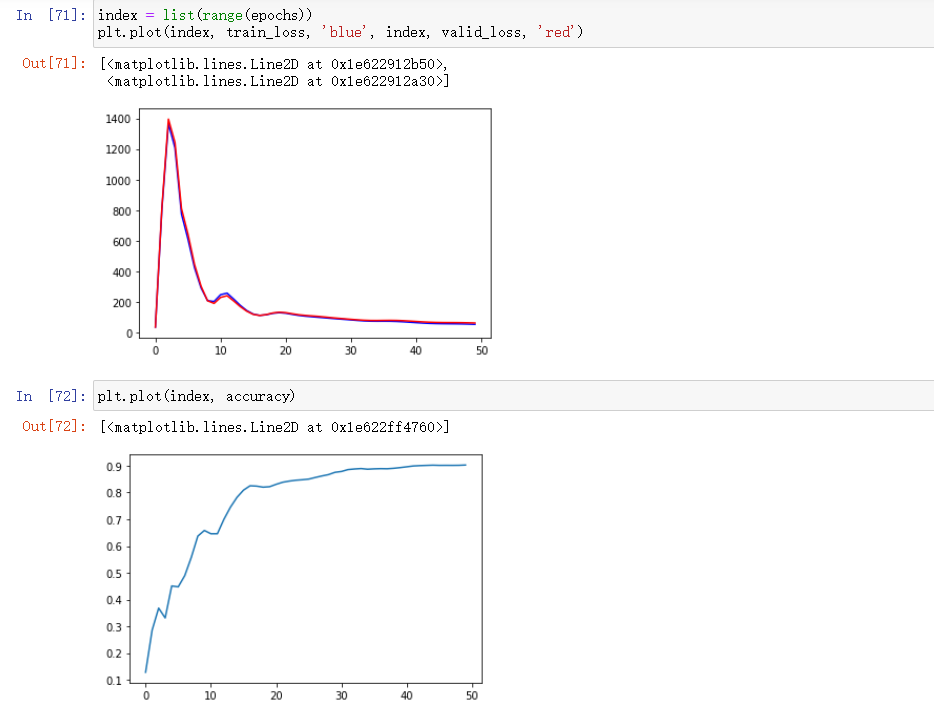

精度很正常的向上攀升, 但是损失函数确实先急剧上升, 再缓缓下降趋于平滑

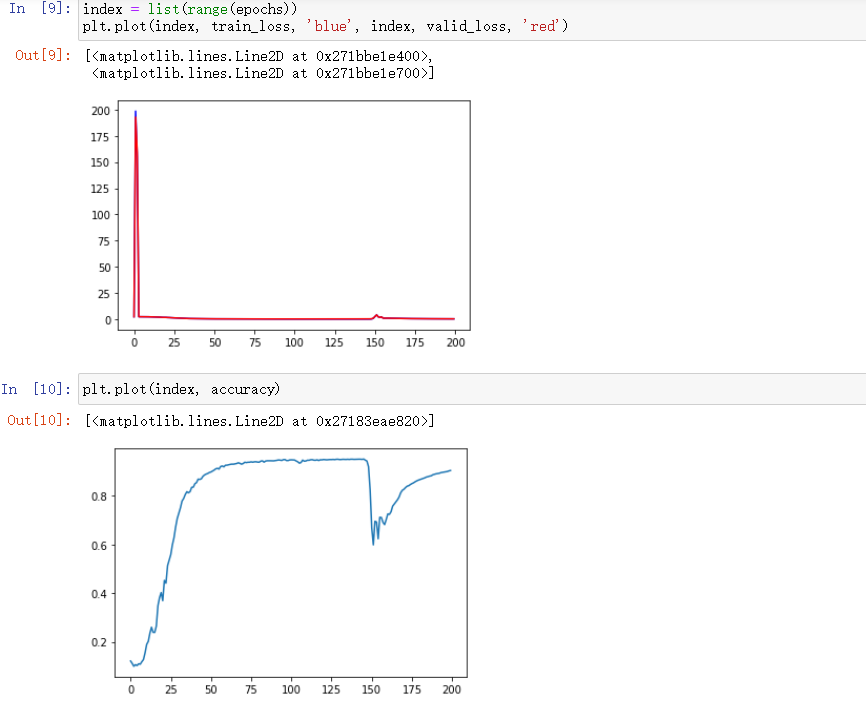

损失函数和精度趋于稳定后的突然抖动

其实都是学习率的原因, 我用的优化器是adam,adam对学习率的敏感度较低, 学习率设成1e-2, 1e-3, 1e-4即可。

一开始设成0.5对Adam太大了,如果是sgd的话设成0.5比较合适。

至于第一幅图, 神经网络在初始化时其实已经有一个相对较小的损失函数了(初始的权重值在一个合理范围内), 而过大的学习率反而使得权重跑出了这个合理范围

浙公网安备 33010602011771号

浙公网安备 33010602011771号