【深度学习】注意力机制 - 李宏毅PPT笔记

李宏毅ML-self attention PPT笔记

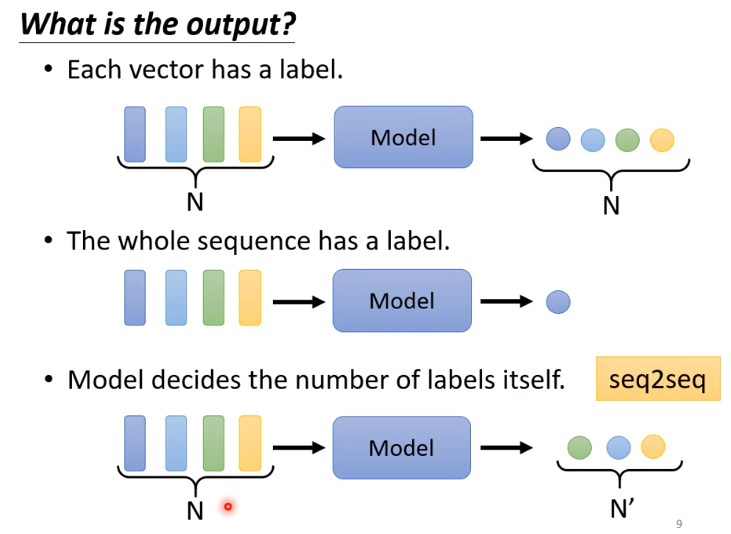

任务:

输入一个向量序列: [v1, v2, ......,vn]

输出一个相同长度的向量序列, 如词性标注

输出一个向量, 如情感分析

输出任意长度的向量序列, seq2seq

比如考虑序列标注问题, 不能孤立看一个个输入的向量, 而是要考虑整个序列。

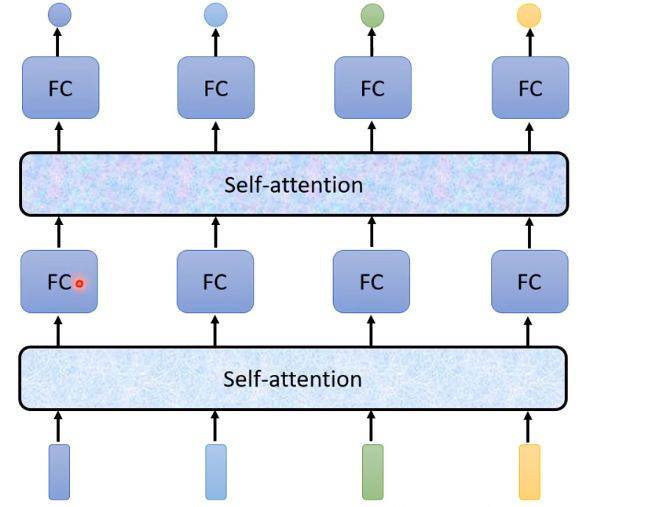

self-attention考虑一整个输入序列后, 再输入到全连接层中

可以交替使用self-attention layer和fully connected layer

self-attention layer处理整个序列, fully connected layer处理单个资讯

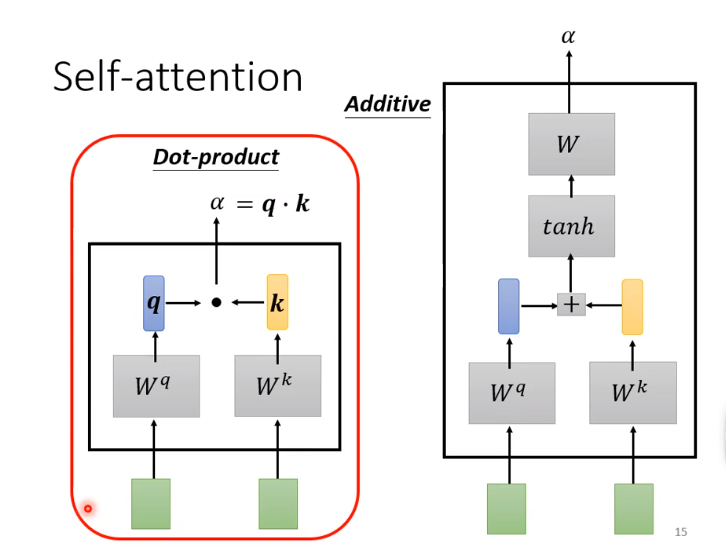

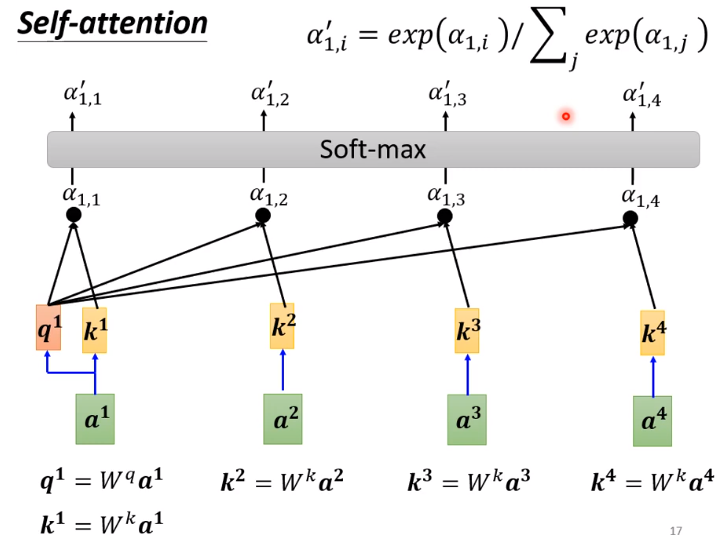

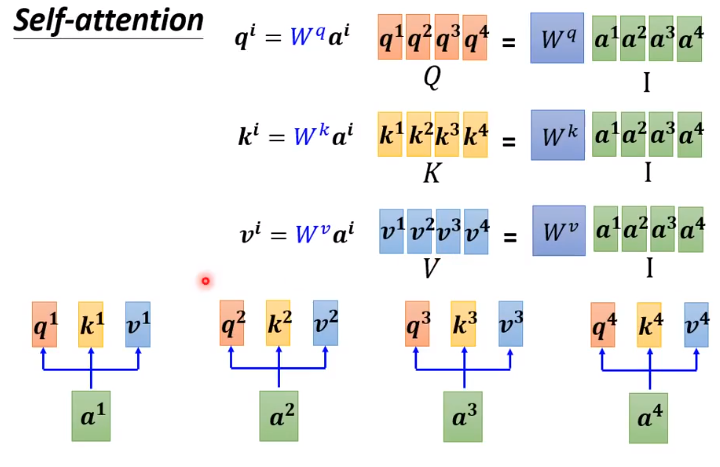

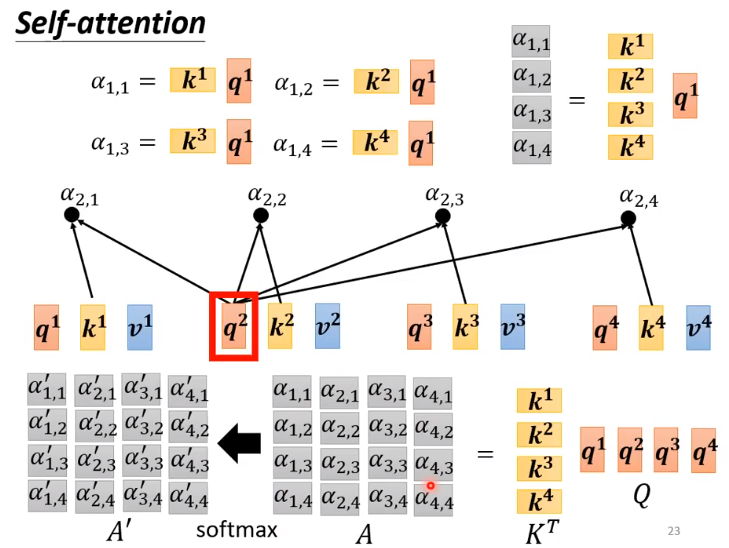

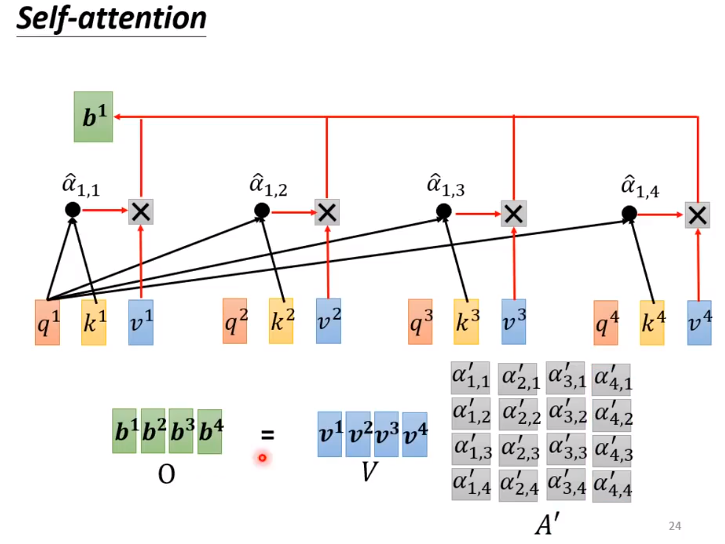

自注意力机制学习输入的向量序列向量与向量之间的关系, 找到与某个向量相关的向量

计算关联性的module如上两种, 以下用左边的例子

以下是计算的矩阵表示:

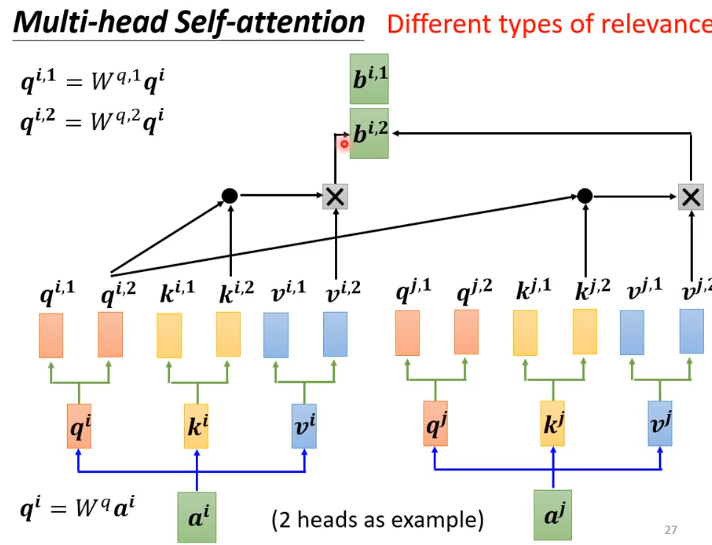

多头自注意力机制也有广泛应用

有时需要考虑向量在序列的位置