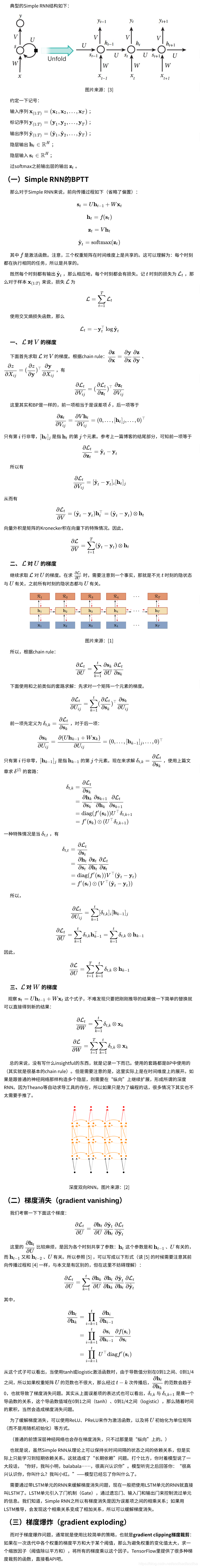

循环神经网络

转自: https://www.cnblogs.com/Determined22/p/6562555.html

关于梯度消失问题:

1.网络层次越深, 越容易引起梯度消失, 无论是纵向网络(bp), 还是横向网络(rnn), 梯度消失是由激活函数的导数位于[0,1]区间引起的

2.bp网络梯度消失会导致最前端的W学习不到, 而rnn梯度消失会引起记忆问题,只能学习到短期网络, 具体见https://www.jianshu.com/p/2512302f14c7

3.rnn梯度消失是因为误差间的相乘关系, lstm把这种关系改为了相加, 所以缓解了梯度消失问题