Spark history 配置

1:修改spark-defaults.conf文件。添加如下内容

spark.eventLog.enabled true spark.eventLog.dir hdfs://hadoop102:9000/sparklog spark.eventLog.compress true

spark.yarn.historyServer.address=hadoop102:18080

spark.history.ui.port=18080

2:属性说明

(1) spark.eventLog.enabled

是否记录Spark事件,用于应用程序在完成后的筹够WebUI。

(2) spark.eventLog.dir

设置spark.eventLog.enabled为true后,该属性为记录spark时间的根目录。在此根目录中,Spark为每个应用程序创建分目录,并将应用程序的时间记录到此目录中。用户可以将此属性设置为HDFS目录,以便History Server读取。

(3) spark.eventLog.compress

否压缩记录Spark事件,前提spark.eventLog.enabled为true,默认使用的是snappy。

3: 在HDFS中建立存放目录

上文已经设置好了存放History的目录HDFS文件目录,现在我们在HDFS中建立相应的目录专门存放文件。

root@master:~# hadoop dfs -mkdir /sparklog

root@master:~# hadoop dfs -chmod 777 /sparklog

4:配置spark-env.sh文件

export SPARK_HISTORY_OPTS="-Dspark.history.ui.port=18080 -Dspark.history.retainedApplications=3 -Dspark.history.fs.logDirectory=hdfs://hadoop102:9000/sparklog"

5:重启spark历史服务. spark目录

sbin/stop-history-server.sh

sbin/start-history-server.sh

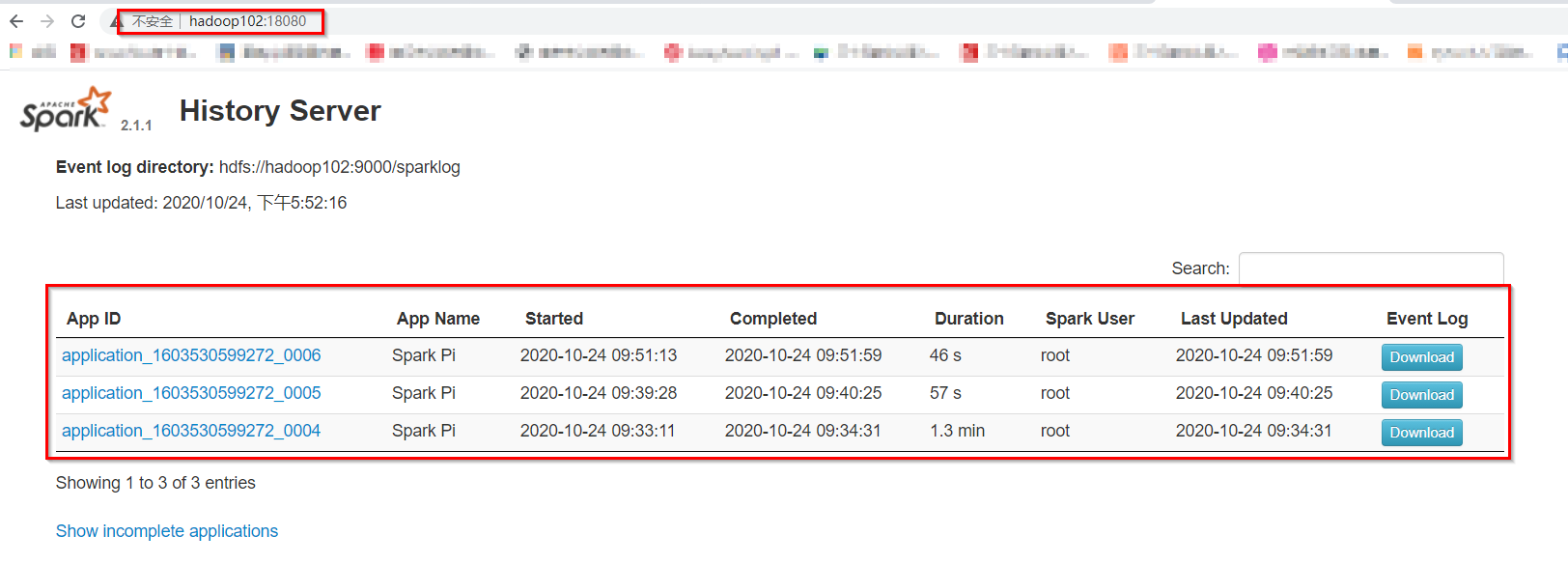

6:查看运行历史.

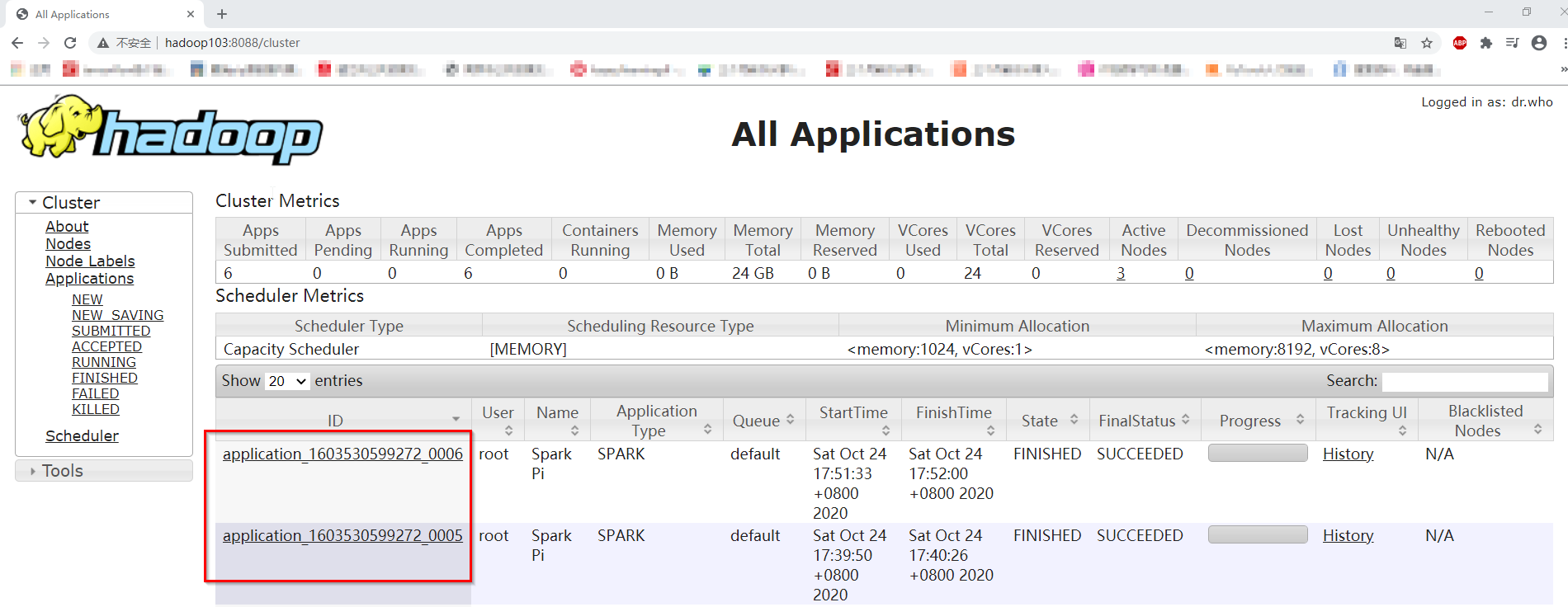

7:在hadoop上看history: 输入:http://hadoop103:8088/