5月深度学习班第1课机器学习中数学基础

梯度方向:上升的方向

梯度下降:沿着梯度的反方向下降,来最小化损失函数,也就是沿着梯度的反方向

泰勒级数:展开式通项

![]()

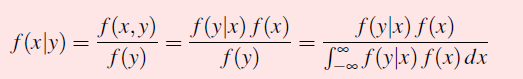

贝叶斯公式:后验概率=先验概率*条件概率

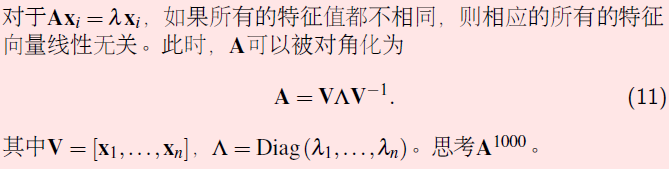

特征值与特征向量:特征值不同,特征向量线性无关

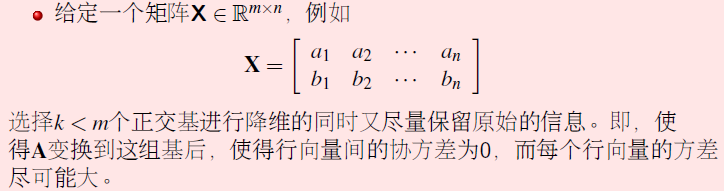

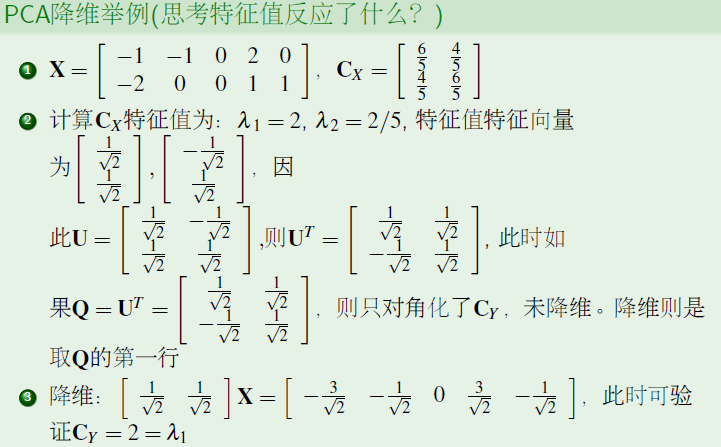

PCA:降维的同时尽可能的保留原始的信息

过程

1)先求解协方差矩阵

2)求解协方差矩阵的特征向量和特征值

3)特征值从大到小排列,选择特征值对应的特征向量

4)这些特征向量相互正交,作为正交基向量

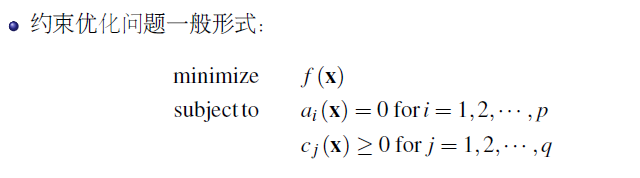

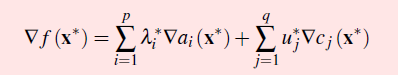

凸优化问题;一般的约束性最优化问题

求解约束问题的极值问题:把约束优化转化成无约束问题

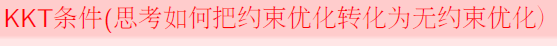

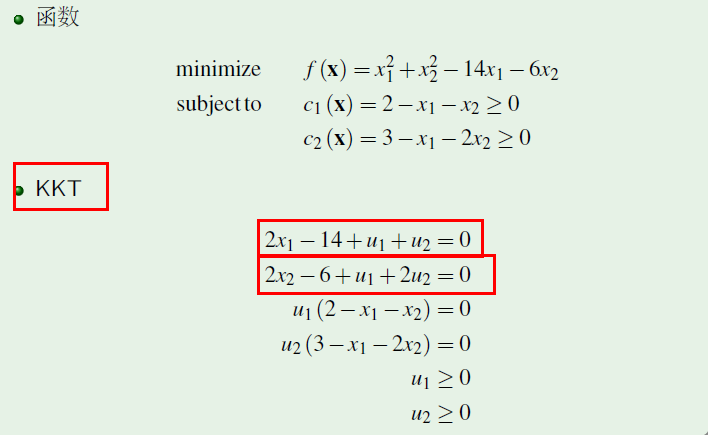

其中KKT条件,就是优化问题求解的可行域

转化方法:朗格朗日方法

Life is short, but I have a cat.

浙公网安备 33010602011771号

浙公网安备 33010602011771号