CDH入门教程1-1

CDH入门教程1-2 采集模块安装

第2章 数据采集模块安装

2.1 HDFS、YARN、Zookeeper安装

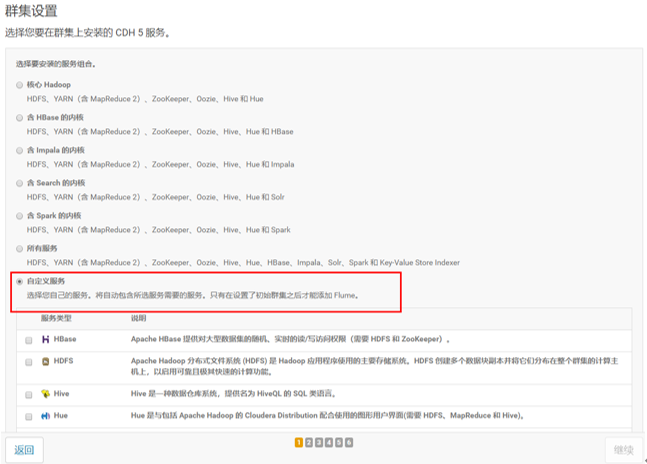

2.1.1 选择自定义安装

2.1.2 选择安装服务

2.1.3 分配节点

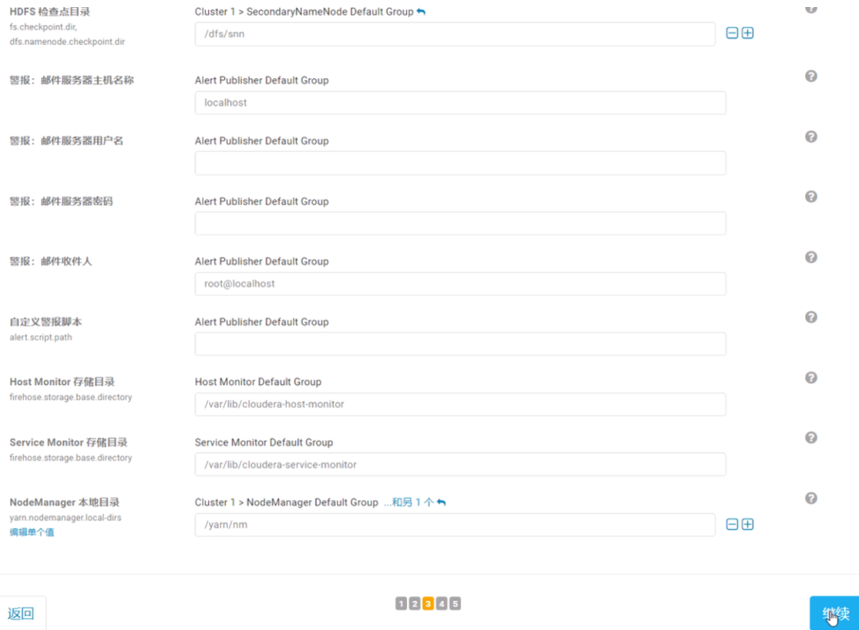

2.1.4 集群设置全部选默认即可

2.1.5 自动启动进程

2.1.6 修改HDFS的权限检查配置

关闭HDFS中的权限检查:dfs.permissions。

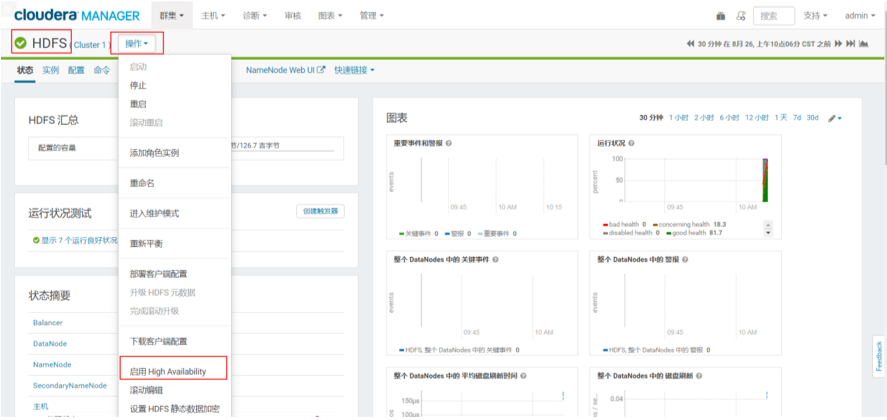

2.1.7 配置NameNode HA

1)进入HDFS页面点击启用High Availability

2)HA服务命名

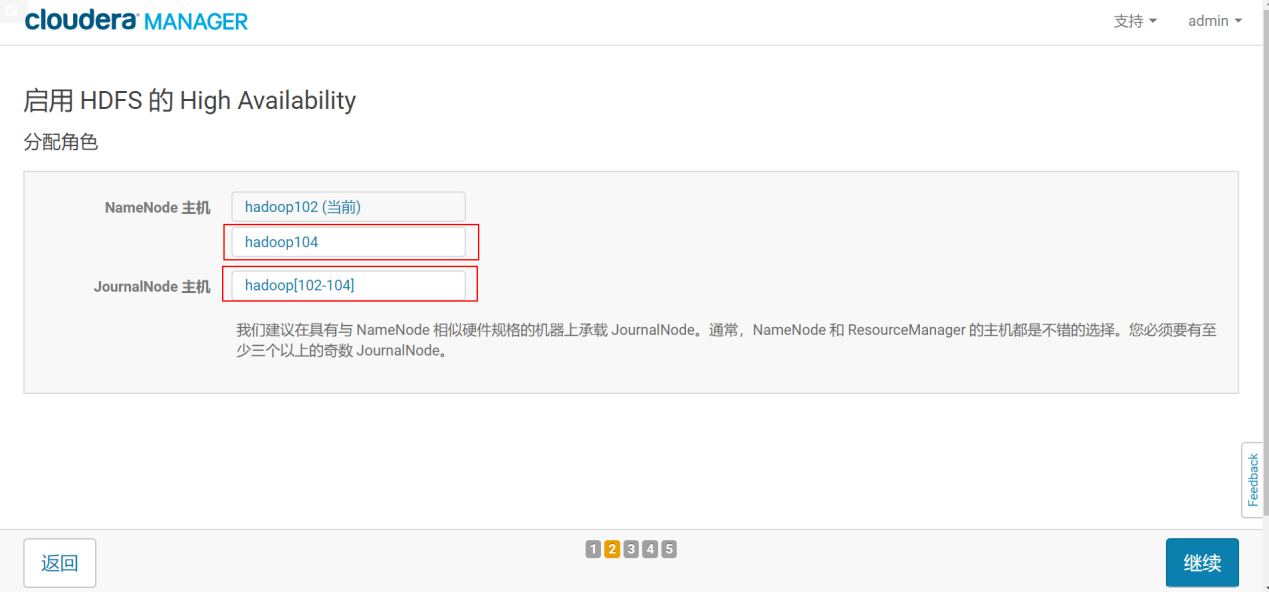

3)分配角色

4)审核更改

5)等待启动服务

2.2 Flume安装

2.2.1 Flume安装

1)添加服务

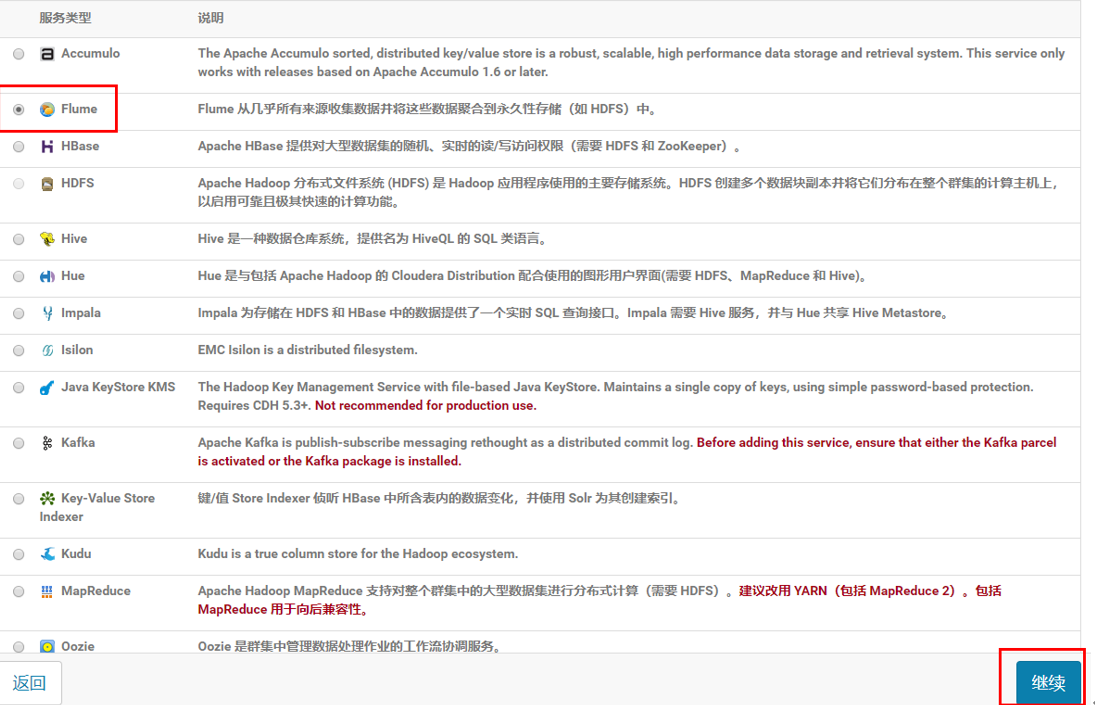

2)选择Flume,点击继续

3)选择节点

4)完成

2.2.2 Flume配置

(1)在CM管理页面上点击Flume

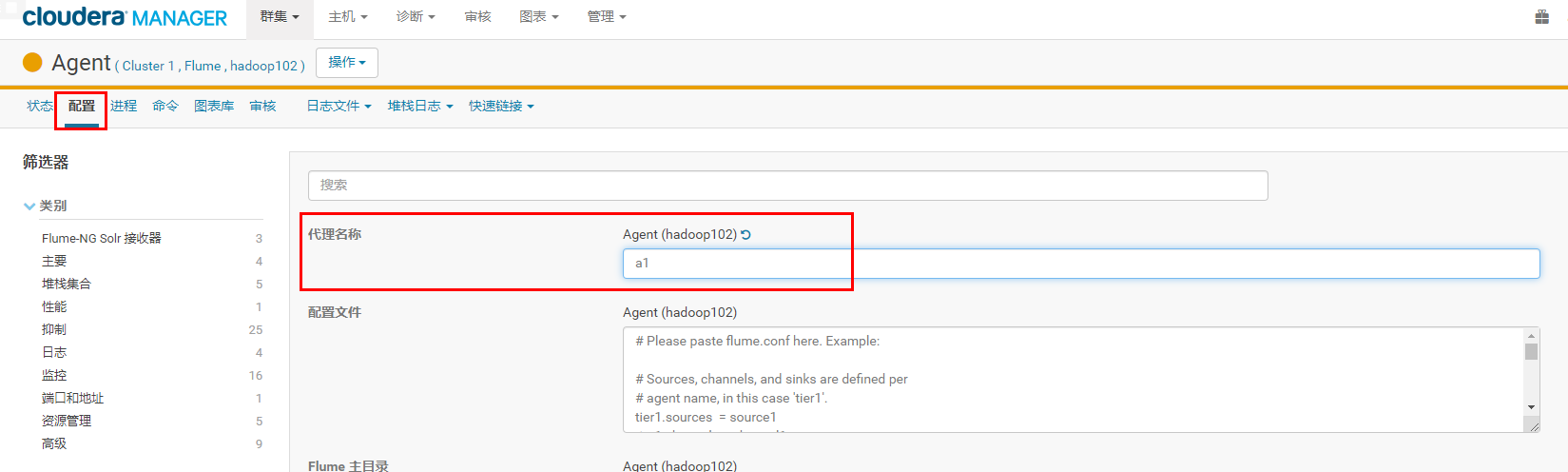

(2)在实例页面选择hadoop102上的Agent

(3)在CM管理页面hadoop102上Flume的配置中找到代理名称改为a1

2.2.3 Flume拦截器

项目中一般用flume采集日志的时候,大部分情况下会用到自定义的flume拦截器,例如我们之前学过的电商数仓项目。

由于自定义了flume拦截器,我们需要把自己写的代码打包放到集群上,apache版本的flume安装路径比较明显,我们直接放到flume的安装路径下的lib文件夹即可。CDH路径比较隐蔽,此时我们需要将jar包放到/opt/cloudera/parcels/CDH-5.16.2-1.cdh5.16.2.p0.8/lib/flume-ng/lib/文件夹下面。

2.3 Kafka安装

可以选择在线安装和离线包安装,在线安装下载时间较长,离线包安装时间较短。这里我们为了节省时间,选择离线安装。

2.3.1 导入离线包

1)在hadoop102上创建/opt/cloudera/csd目录

[root@hadoop102 parcel-repo]# mkdir -p /opt/cloudera/csd

2)上传KAFKA-1.2.0.jar到/opt/cloudera/csd目录,并修改所有者和所有者的组

[root@hadoop102 cloudera]# chown cloudera-scm:cloudera-scm /opt/cloudera/csd/ -R

3)上传KAFKA-4.1.0-1.4.1.0.p0.4-el7.parcel、KAFKA-4.1.0-1.4.1.0.p0.4-el7.parcel.sha1到/opt/cloudera/parcel-repo目录,并修改KAFKA-4.1.0-1.4.1.0.p0.4-el7.parcel.sha1名称为KAFKA-4.1.0-1.4.1.0.p0.4-el7.parcel.sha

[root@hadoop102 parcel-repo]# mv KAFKA-4.1.0-1.4.1.0.p0.4-el7.parcel.sha1 KAFKA-4.1.0-1.4.1.0.p0.4-el7.parcel.sha

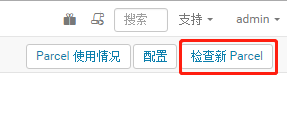

4)ClouderManager中选择Parcel->检查Parcel->Kafka点击分配->激活

5)ClouderManager中选择Parcel->检查Parcel->Kafka点击分配->激活

2.3.2 在线下载安装包(网络较慢,所以不选)

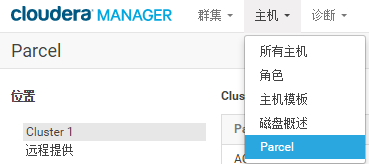

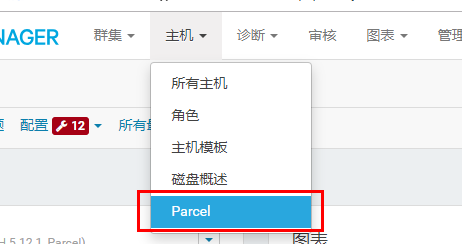

1)点击主机,选择Parcel

2)找到Kafka点击下载,下载完成后点击分配进行分配,然后点击激活,出现已分配,已激活则证明分配激活成功

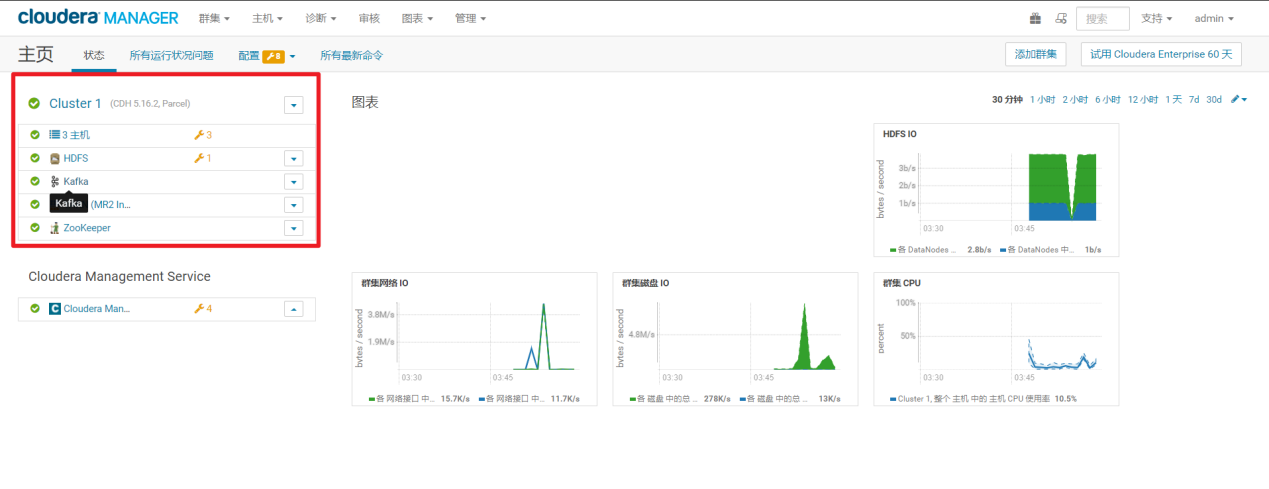

2.3.3 Kafka安装

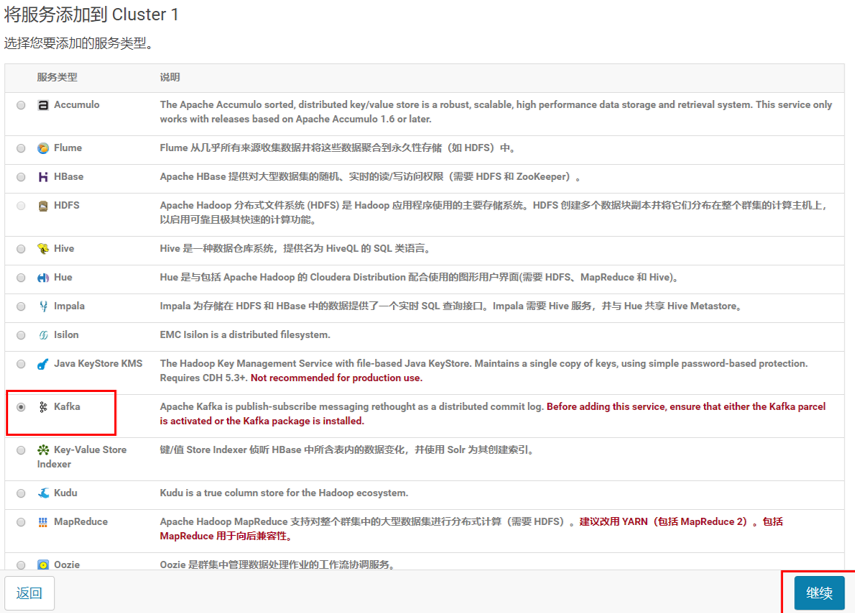

- 回到首页,点击添加服务

4)选择Kafka,点击继续

5)Kafka的Broker选择三台机器

6)修改Kafka的堆大小为256M

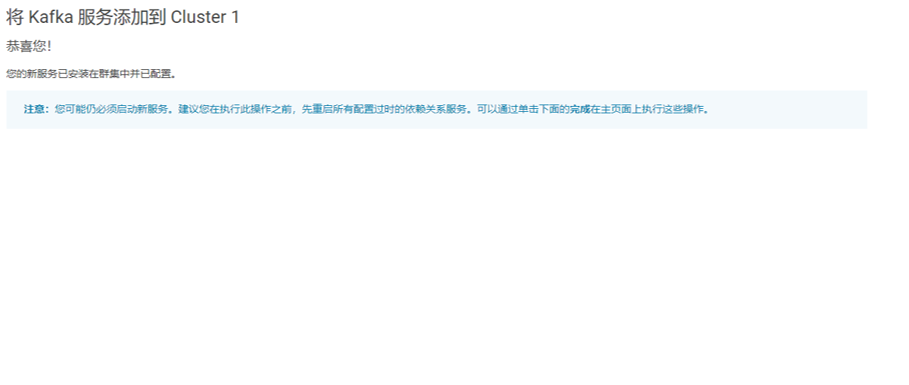

7)完成

8)kafka启动成功

2.3.4 查看Kafka Topic

[root@hadoop102 KAFKA]#

/opt/cloudera/parcels/KAFKA/bin/kafka-topics --zookeeper hadoop102:2181 --list

2.3.5 创建 Kafka Topic

进入到/opt/cloudera/parcels/KAFKA目录下创建:启动日志主题。

1)创建启动日志主题

[root@hadoop102 KAFKA]$ kafka-topics --zookeeper hadoop102:2181,hadoop103:2181,hadoop104:2181 --create --replication-factor 1 --partitions 1 --topic topic_start

2.3.6 生产消息

kafka-console-producer --broker-list hadoop102:9092 --topic topic_start

>hello world

>wangwang

2.3.7 消费消息

[root@hadoop103 KAFKA]$

kafka-console-consumer \

--bootstrap-server hadoop102:9092 --from-beginning --topic topic_start

--from-beginning:会把first主题中以往所有的数据都读取出来。根据业务场景选择是否增加该配置。

2.3.8 查看某个Topic的详情

[root@hadoop102 KAFKA]$ kafka-topics --zookeeper hadoop102:2181 --describe --topic topic_start

2.3.9 删除 Kafka Topic

1)删除启动日志主题

[root@hadoop102 KAFKA]$ kafka-topics --delete --zookeeper hadoop102:2181,hadoop103:2181,hadoop104:2181 --topic topic_start