OSLNet: Deep Small-Sample Classification with an Orthogonal Softmax Layer

本文用正交softmax层来减轻少样本分类利用NN做易过拟合的问题。思路是:对于分类器的分类权重层,令其正交化。就是分类器的权重向量两两正交化。原理比较清晰易懂,实现时将权重向量的部分链接进行移除(dropout),但是这个移除在训练和测试是固定的,不是学习的,没有在优化过程中进行限制。本文的方法叫做OSL(orthogonal softmax layer),下图是不同数据上分类器权重之间的角度,角度越大,泛化能力越好,精度越高。

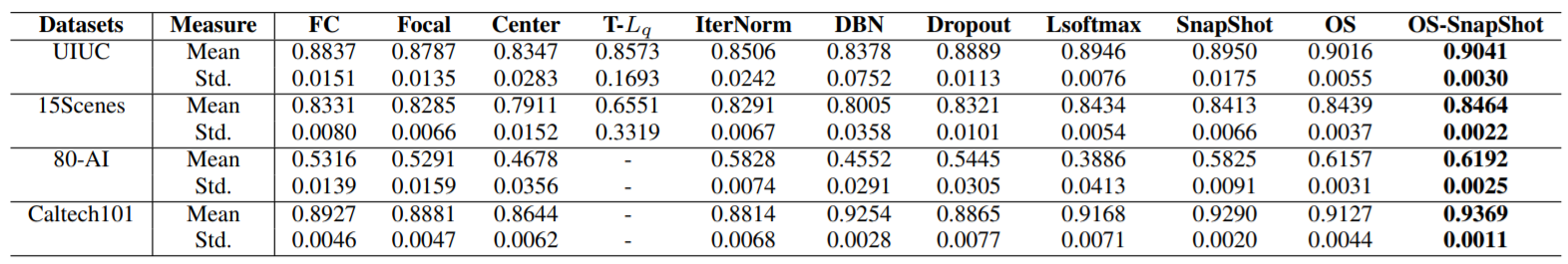

前面提到少样本(小数据集)分类的重要性在于避免过拟合,相关方法:数据增强、域适应、学习判别特征、ensemble方法、正则化(L2、Dropout)。为了保证分类器权重有大角度,OSL的方法是对权重进行去相关处理,就是分别将每个权重部分置零。

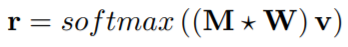

上式就是mask矩阵M与权重W的内积然后乘以输入v后进行softmax。M的格式就是:

其中M的对角线上的元素都是列向量,元素都为1,非对角线上的元素也都是列向量,元素都为0。通过与W相乘,就得到了不相关的权重矩阵。试想此时的权重矩阵极端情况下就变成了单位阵!所以是非相关。这就是该方案的思想,当然一个缺点就是特征维度得大于类数目,不然就是非满秩的,没法达到两两线性无关。

下图是dropout和osl的示意图:

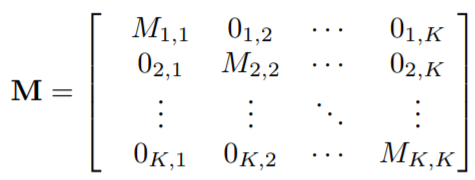

在小数据集上的表现也还行:

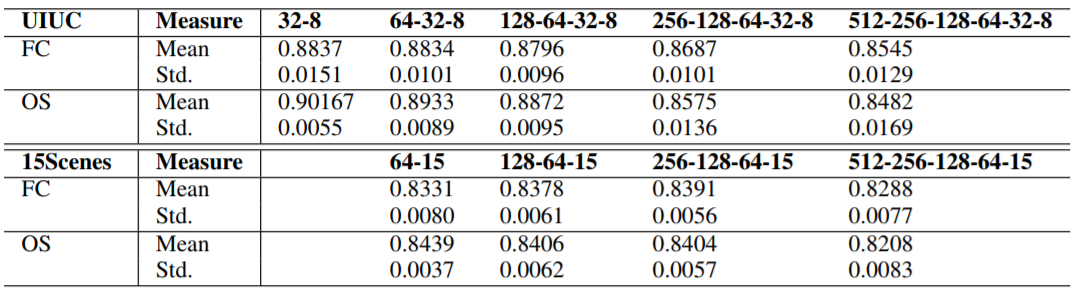

在网络变深的时候均会下滑(变深的时候就没那么抗打过拟合了):

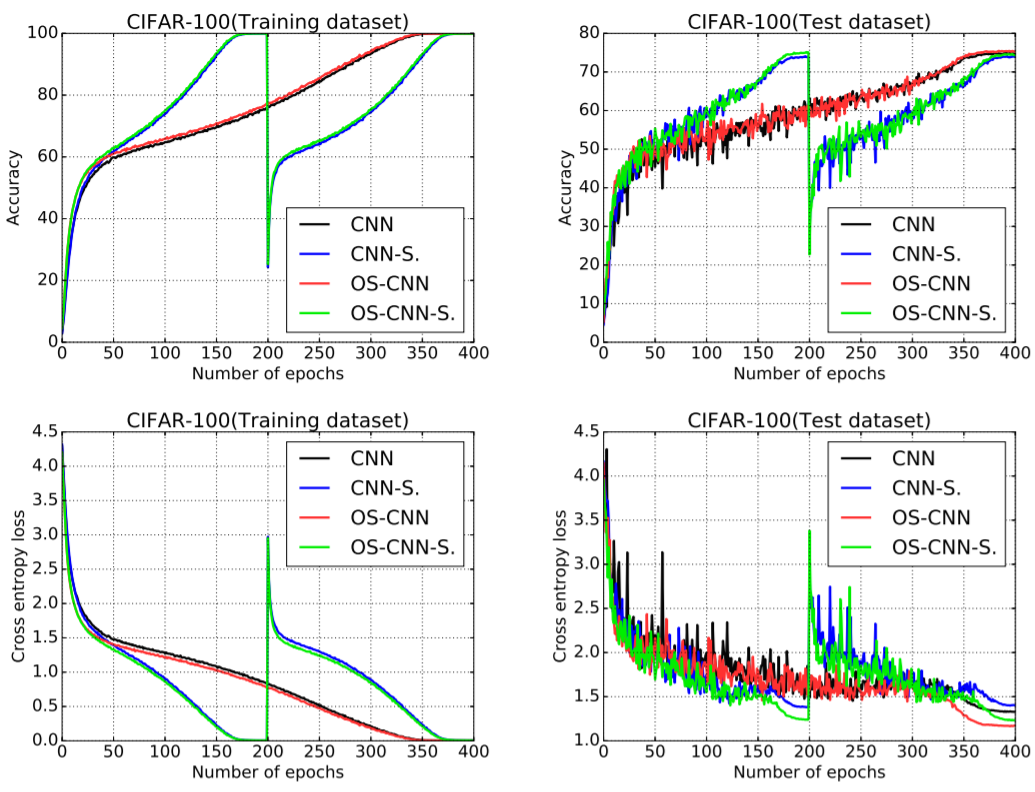

在大数据集上也和正常CNN差不多: