Wasserstein CNN: Learning Invariant Features for NIR-VIS Face Recognition

承接上上篇博客,在其基础上,加入了Wasserstein distance和correlation prior 。其他相关工作、网络细节(maxout operator)、训练方式和数据处理等基本和前文一致。以下是这两点改进的大概:

- Wasserstein convolutional neural network(WCNN)的低级层利用容易得到的大量VIS光谱训练,高级层划分为3部分:the NIR layer, the VIS layer and the NIR-VIS shared layer。前两层旨在学习模态明确特征(modality-specific features),最后一层学习模态不变特征子空间(modality-invariant feature subspace)。Wasserstein distance用在最后一层来估量两种异质图像特征分布的不相似性。即WCNN通过最小化NIR分布与VIS分布之间的Wasserstein 距离来得到深度不变表征。

- 为了避免小规模异质数据的过拟合,一个correlation piori引入到WCNN的全连接层中,最后同之前博客中一样,交替优化。这个correlation由一个非凸低秩限制来实现(a non-convex low-rank constraint)。当训练集较小时这个prior尤其重要。

文章的四大贡献:

- 端到端网络学习模态不变特征,这个结构自然的结合了不变特征提取和子空间学习。两个正交子空间分别建模身份及光谱信息,(一张人脸图其实包括了人脸身份信息+人脸光谱信息)。这个网络用来同时提前NIR和VIS特征。

-

Wasserstein distance引入,度量NIR和VIS模态的分布差异,相比之前的sample-level的度量,这个Wasserstein distance更有效减少两种模态的分布差异,提高性能。

- correlation prior引入,减轻在全连接层中小规模数据产生的过拟合问题,这个先验提高了WCNN在小数据集的表现。

- 在CASIA NIR-VIS 2.0 人脸数据集上的性能达到了SOTA。

异质人脸识别(验证)的四大类方法:

- mage synthesis、

- Feature representation、

- Subspace learning、

- Deep learning

网络结构

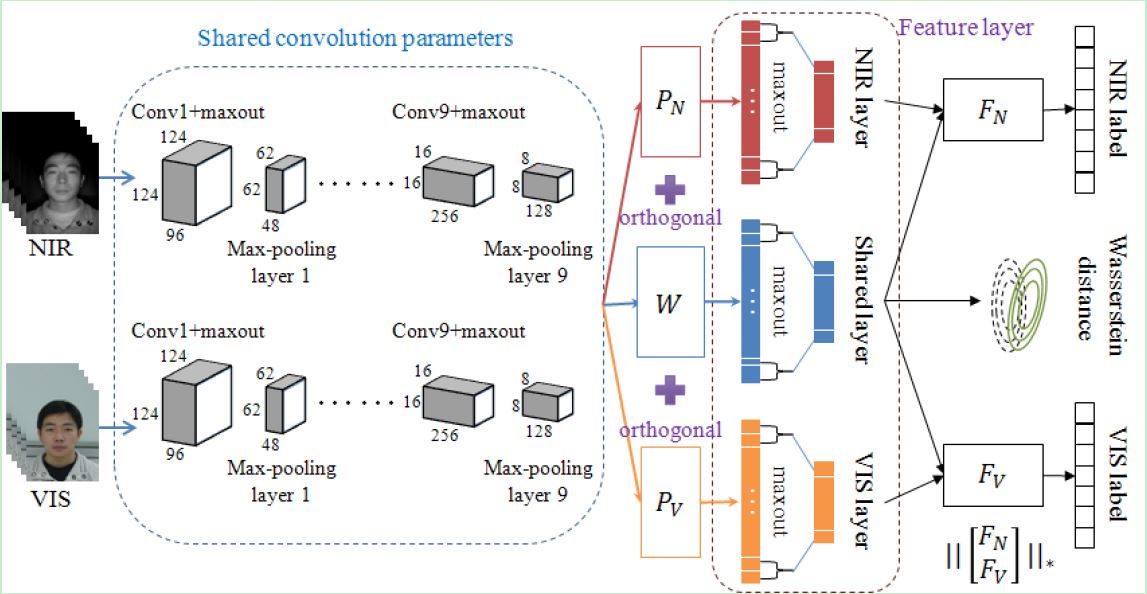

Fig 1. An illustration of our proposed Wasserstein CNN architecture. The Wasserstein distance is used to measure the difference between NIR

and VIS distributions in the modality invariant subspace (spanned by matrix W). At the testing time, both NIR and VIS features are exacted from

the shared layer of one single neural network and compared in cosine distance.

网络解释如下:

1. Modality Invariant Subspace

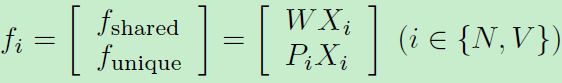

减轻NIR-VIS外观差异,即想办法移除掉光谱(外观)差异,那么只剩下identity信息就容易匹配了。之前的方法都是移除一些principal subspaces,假定这些子空间是包含光谱信息的。受此启发,这里引入三个映射矩阵(见上图):W,PN,PV。W用来将建模 modeling identity invariant information,P用来建模 variant spectrum information。所以输入两张图,得到三个特征:

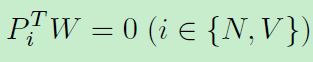

其中WX和PX分别表示共享特征和独立特征,考虑到子空间中分解特性,限制其互相无关:

这个限制可减少参数空间,减轻过拟合。将特征表示和子空间学习两个独立步骤和合为一步。

2. The Wasserstein Distance

NIR和VIS图像的gap是异质图像识别的主要问题。之前的方法引导sample-level的限制来解决这个gap。比如有contrastive loss和triplet loss等都施加在NIR-VIS sample pairs上。这些方法仅仅考虑NIR-VIS samples的关系而非NIR-VIS 分布的关系。近来Wasserstein distance在GAN中度量模型分布和真实分布扮演了重要的角色。受到Wasserstein GAN和BEGAN的启发,我们利用Wasserstein distance来测量NIR和VIS数据分布之间的一致性。假定在非线性特征映射后同一subject遵从高斯分布。施加 Wasserstein distance 在同一subject(即同一个体identity)的分布上。具体实现细节见paper,比较好理解。

3. Correlation Prior

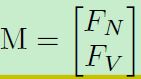

过拟合问题。NIR-VIS数据集通常比纯VIS数据集小得多。全连接的参数最多。本文将WCNN的全连接层分解为两个矩阵:FN、FV。分别对应NIR和VIS模态。我们希望M(下式)高度相关,使得M.T*M为一块对角矩阵。一个相关的M将减少估计的参数空间,减轻过拟合。进一步探索M的核范数。其余细节见paper。

4. loss

其中第一项为分类损失,第二项为W距离,第三项为proir约束。beta1=beta2=1,beta3=0.001,说明这个prior在这里不是很重要。

5. CONCLUSIONS

Same as before

浙公网安备 33010602011771号

浙公网安备 33010602011771号