机器学习数学知识积累之线性代数解析几何,微积分

解析几何

解析几何的基本思想是用代数的方法来研究几何,把空间的几何结构系统地代数化,数量化

向量的定义

一个有长度和方向的矢量,和标量(scalar)相对应

向量的大小(有向线段的长度)称为向量的模 $|\vec{a}|$

长度为1的向量称为单位向量

向量的平行(共线),共面和垂直

向量共线平行的充分必要条件是:存在一个标量$ \lambda $ 使得以下成立: $$\vec{a} = \lambda \vec{b}$$

向量共面的充分必要条件是:a,b,c之间存在线性变换关系使得以下成立:$$\vec{c} = \lambda \vec{b}+ \eta \vec{a}$$

向量垂直的充分必要条件是:$$\vec{a} \cdot \vec{b} = 0$$

向量的线性运算

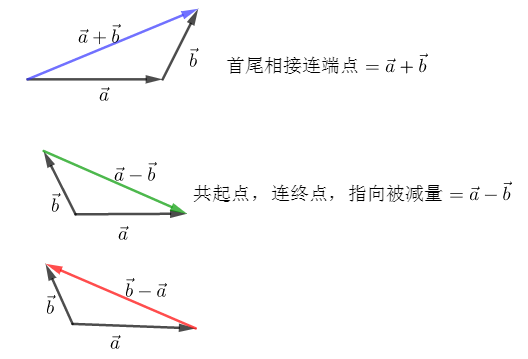

加法:三角形法则,平行四边形法则,多边形法则(多个向量尾首相连,最终A的起点到Z的终点连接起来即为所有这些向量的和)

减法

数乘:只改变向量长度,方向一致或相反(随这个数据正负而定)

向量加减法几何示意图

向量的代数表示

把空间中所有的向量的尾部都拉到坐标原点,这样N维点空间可以与N维向量空间建立一一对应关系:N维点空间中点(0,0,0…0)取作原点,那么每一个点都可以让一个向量和它对应,这个向量就是从坐标原点出发到这个点为止的向量。

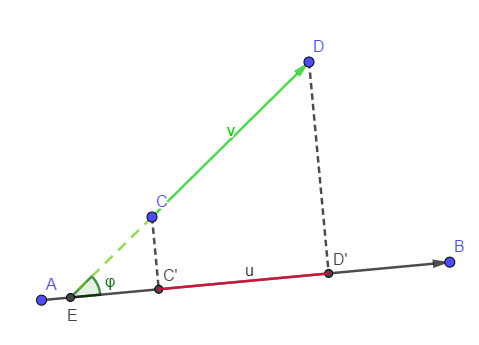

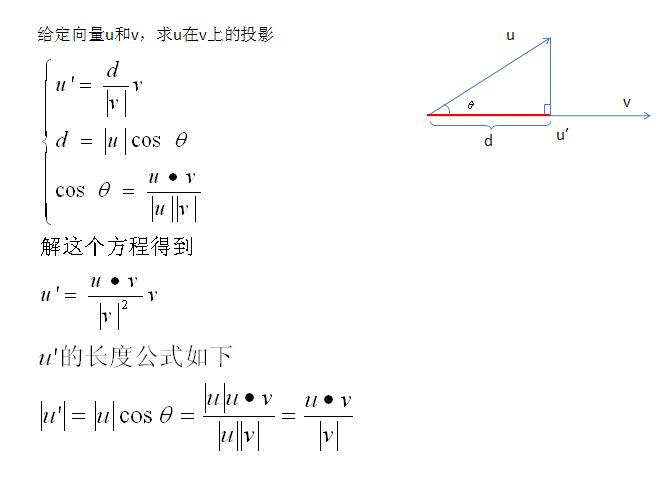

向量在轴上的投影

$C'和D‘$分别称为点$C,D$在轴u上的投影,向量$\vec{CD}$在轴u上的投影为C,D两点在u轴上的投影点$C',D'$组成的有向线段$\vec{C'D'}$的值,其绝对值等于向量$|\vec{C'D'}|$,其正负的符号由$\vec{C'D'}$的方向决定,当$\vec{C'D'}和u$轴同方向时值为正,反方向时值为负。记为$Prj_u\vec{CD}$

投影定理:

向量$\vec{CD}$在轴u上的投影等于向量的模乘以轴与向量的夹角的余弦:

$$Prj_u\vec{CD}=|\vec{CD}|cos(\varphi )$$

性质定理:

n个向量的和在轴上的投影等于两个向量在该轴上的投影之和.

$$Prj_u(a_1+a_2+..+a_n) = Prj_ua_1+Prj_ua_2+...+Prj_ua_n$$

向量的内积(数量积,点乘)和外积

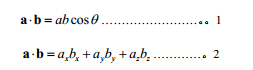

内积:两个向量的内积或者叫点乘结果是一个标量,其值等于a,b的模乘以其夹角的cos值。

$\overrightarrow{a} \cdot \overrightarrow{b}=|\overrightarrow{a}||\overrightarrow{b}|cos(\overrightarrow{a},\overrightarrow{b})=|\vec{b}|Prj_b\vec{a} = |\vec{a}| Prj_a\vec{b}$

如果使用平面直角坐标系来表示,则可以根据点乘的性质推导出来点乘结果等于坐标分别相乘后相加,这一点非常重要,实际上指明了点乘几何意义和代数算式之间的关联方式。

$\overrightarrow{a} \cdot \overrightarrow{b}= x_1x_2+y_1y_2+z_1z_2$

特别地,$$|\vec{a}| = \sqrt{\vec{a} \cdot \vec{a}} = \sqrt {a_x^{2}+a_y^{2}+a_z^{2}}$$

$$|\vec{AB}| = \sqrt{\vec{AB} \cdot \vec{AB}} = \sqrt {(A_x-B_x)^{2}+(A_y-B_y)^{2}+(A_z-B_z)^{2}}$$

内积的性质

$$a \cdot b = b \cdot a, (a+b) \cdot c = a \cdot c + b \cdot c, (ka) \cdot b = k (a \cdot b), a \cdot (kb+lc) = k(a \cdot b) + l(a \cdot c)$$

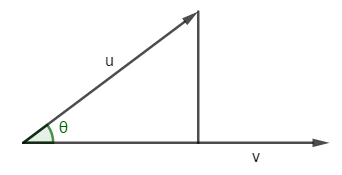

向量内积的几何意义

$\vec{u} \cdot \vec{v}$ 在几何上就是向量$\vec(u)$向向量$\vec{v}$做投影后再乘以$\vec{v}$的长度,就是一个向量在另一个向量上的投影d的积,也就是同方向的积

实际上上面向量内积几何意义反过来可以用来计算投影d: $ d = \frac{\vec{u} \cdot \vec{v}}{|\vec{v}|} $

向量模计算及性质

对于起始于原点(0,0)的单点向量$\vec{OA}$,其计算公式为:

$$|\vec{a}| = |\vec{OA}| = \sqrt{ \vec{a} \cdot \vec{a} } = \sqrt{x_A^{2}+y_A^{2}+...+z_A^{2}}$$

对于由空间两点A和B组成的向量,则需要先做对应坐标相减,再按照起始于原点的向量模计算公式来计算

$$|\vec{AB}| = \sqrt {\vec{AB} \cdot \vec{AB}} = |\vec{OA} - \vec{OB}| = |\vec{OC}| = \sqrt{(x_a-x_b)^{2}+(y_a-y_b)^{2}+...+(z_a-z_b)^{2}}$$

其中$C$点的坐标为$(x_A-x_B,y_A-y_B,z_A-z_B)$ (也可以简单地说$\vec{AB}$的坐标),也就是说向量$\vec{c} = \vec{OC}$ 是由自由变量$\vec{AB}$变换为经过欧式空间原点的单点向量$\vec{c}$,这样就好计算其模了

$$|k \vec{a}| = |k| |\vec{a}|$$

三角不等式

$$||\vec{a}| - |\vec{b}| |\leqslant | \vec{a} - \vec{b} |\leqslant | \vec{a}|+|\vec{b}|$$

$$||\vec{a}| - |\vec{b}| |\leqslant | \vec{a} + \vec{b} |\leqslant | \vec{a}|+|\vec{b}|$$

柯西-施瓦茨不等式

$$|\vec{a} \cdot \vec{b}| \leq |\vec{a}||\vec{b}|$$

向量的夹角

$$\theta = arccos\frac{\vec{a} \cdot \vec{b}}{ |\vec{a}||\vec{b}|}$$

向量正交

如果向量a和b垂直,那么a和b的内积为0,这时称两个向量a,b是正交的。

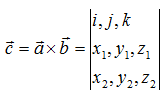

向量的叉乘(外积,向量积)

叉乘,也叫向量的外积、向量积。两个向量叉乘的结果仍为一向量,不妨设为(x3,y3,z3)。向量c的方向与a,b所在的平面垂直,且方向要用“右手法则”判断(用右手的四指先表示向量a的方向,然后手指朝着手心的方向摆动到向量b的方向,大拇指所指的方向就是向量c的方向)。大小为:

$\overrightarrow{a} \times \overrightarrow{b}= |\overrightarrow{a}| |\overrightarrow{b}| sin(\overrightarrow{a},\overrightarrow{b}) $

其向量坐标表示为:

$\overrightarrow{c} = (x,y,z) = (y1z2-z1y2, z1x2-x1z2, x1y2-y1x2)$

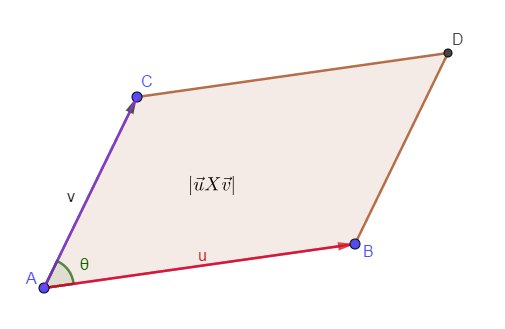

叉积的几何意义

向量叉积的模等于这两个向量组成的平行四边形的面积

根据这个叉乘的几何意义可以明显看到: $\vec{u}\times \vec{u} = 0$ ,因为向量和他自身围成的平行四边形面积为0

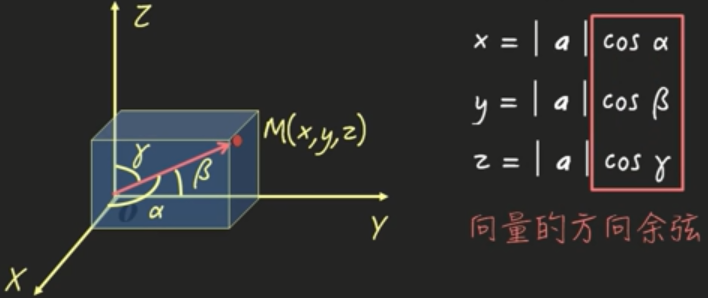

向量的方向余弦

平面和直线的方程

平面的点法式方程

已知$M_0(x_0,y_0,z_0)$为平面上的一点,向量$\vec{n}(A,B,C)$为其平面的一个法向量,则由于该平面上的任意一点$M(x,y,z)$和$M_0$组成的向量和法向量垂直,因此其点积必须为0

得到点法式方程:

$$A(x-x_0)+B(y-y_0)+C(z-z_0) = 0$$

平面的截矩式方程

$$\frac{x}{a} + \frac{y}{b} + \frac{z}{c} = 1$$

其中a,b,c为平面在x,y,z轴的截矩

平面的一般式方程

$$Ax+By+Cz+D= 0$$

其中$\vec{(A,B,C)}$构成直线的法向量

平面的三点式方程

根据向量混合积的几何意义可以推导出三点式方程

直线的参数式方程

经过一点$(x_0,y_0,z_0)$并且平行于$\vec{l,m,n}$的直线参数方程:

$$\left\{\begin{matrix}x = x_0+ tV_x\\ y = y_0 +tV_y\\ z = z_0 + tV_z \end{matrix}\right.$$

直线的标准方程(对称式方程)

将参数式方程中的t消去,即可得到:

$$\frac{x-x_0}{V_x} = \frac{y-y_0}{V_y} = \frac{z-z_0}{V_z}$$

其中$\vec{V_x,V_y,V_z}$被称为直线的方向向量

方向角和距离的计算

距离

点点距离:$d = |M_1M_2| = |\vec{M_1M_2}|=\sqrt{(x_2-x_1)^2+(y_2-y_1)^2+(z_2-z_1)^2}$

点面距离:$P_0(x_0,y_0,z_0)$到平面$Ax+By+Cz+D = 0$的距离

$$d = |\vec{Prj_n\vec{P_1P_0}}| = \frac{|n \cdot \vec{P_1P_0}|}{|n|}=\frac{A(x-x_0)+B(y-y_0)+C(z-z_0)}{\sqrt{A^2+B^2+C^2}}=\frac{Ax_0+By_0+Cz_0+D}{\sqrt{A^2+B^2+C^2}}$$

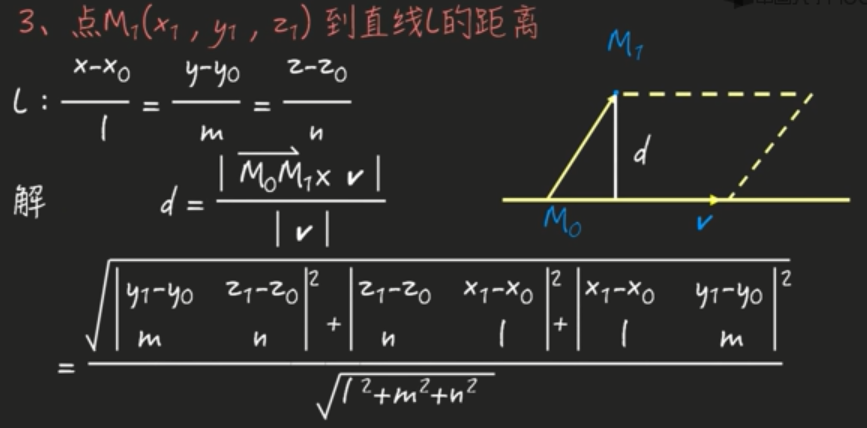

点线距离:

数域的n纬向量

称数域F上的n元有序数组为F上的n纬向量,一般写作行向量或者列向量

2,3纬的几何向量的加法和数乘运算也适合于n纬数域向量,也类似于矩阵的运算。

$$\alpha = \begin{pmatrix}\alpha_1\\ \alpha_2\\ ...\\ \alpha_n\end{pmatrix} \alpha \in R^n$$

线性相关

如果存在$\alpha和\beta$满足以下

$$\beta = k_1\alpha_1+k_2\alpha_2+..+k_m\alpha_m, \alpha_i \in F^n, k_i \in F$$

则称$\beta$是$\alpha_1,\alpha_m$的线性组合.(数乘及向量加法)。

$\beta$可以由$\alpha_1,\alpha_m$线性表示

$\beta,\alpha_1,\alpha_2,..,\alpha_m$是线性相关的。

否则,如果不存在非0的系数组使得$$k_1\alpha_1+k_2\alpha_2+..+k_m\alpha_m+ k_r\beta = 0, \alpha_i \in F^n, k_i \in F$$,这些向量就是线性无关的

线性相关判定

设m个n纬列向量$\alpha_1,\alpha_2,..,\alpha_m, \alpha_i \in R^n$, 则他们线性相关的充分必要条件是由这些列向量组成的矩阵A的秩小于向量的个数m

$R(A)< m$

等价于$AX=0$有非零解

$\beta 可由\alpha_1,\alpha_2,..,\alpha_m$线性表示 等价于 $AX = b$有解 等价于$R(A) = R(\bar A)$(A的秩等于A的增广矩阵的秩)

所谓增广矩阵,就是包括系数矩阵和常数列形成的矩阵。$\bar A = (A|b)$

向量组线性无关的充分必要条件是向量组的秩等于向量组所包含的向量个数

推论:向量个数大于向量维数的向量组必然线性相关

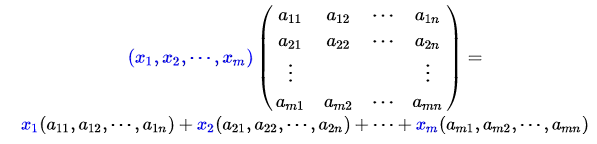

向量组之间的线性表出矩阵:

设向量组$b_1,b_2,...,b_s$可以由$a_1,a_2,..,a_r$线性表出,也就是一下方程

$$b_1 = k_{11}a_1+k_{21}a_2+...+k_{r1}a_r$$

$$b_2 = k_{12}a_1+k_{22}a_2+...+k_{r2}a_r$$

$$b_s = k_{1s}a_1+k_{2s}a_2+...+k_{rs}a_r$$

则

$$ (b_1,b_2,..,b_s) = (a_1,a_2,..,a_r)\begin{bmatrix}k_{11} & k_{12} & ... & k_{1s}\\ k_{21} & k_{22} & ... & k_{2s}\\ ... & ... & ... & ...\\ k_{r1} & k_{r2} & ... & k_{rs}\end{bmatrix} $$,

其中的$K$矩阵为线性表示的系数矩阵。

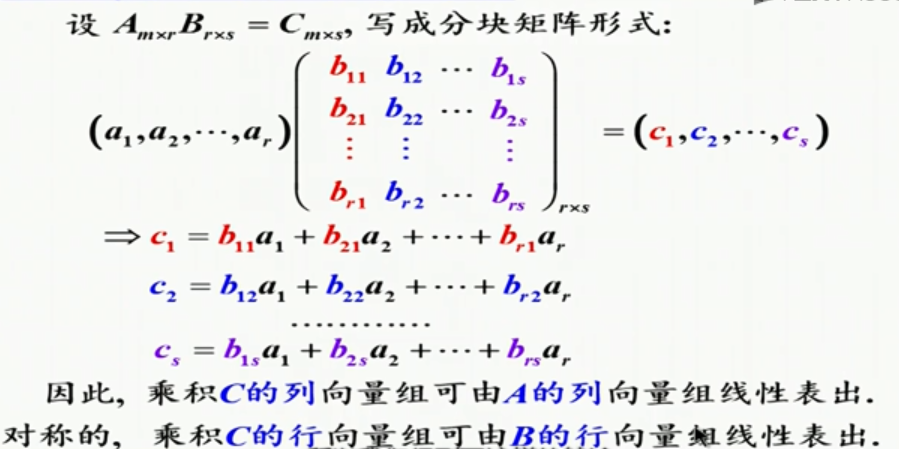

由矩阵得到向量组间的线性表示:

乘积矩阵的列组可以由第一个矩阵的列祖表出,乘积矩阵的行组可以由第二个矩阵的行组线性表出

向量空间

设$V\subseteq F^n, V\neq \O$,如果, $\forall \alpha,\beta \in V,\forall k \in F$,

1. $\alpha + \beta \in V$

2. $k \alpha \in V$

则称$V$是数F上的一个向量空间。

也就是说向量空间具有加法和数乘封闭性。

比如,有很多向量空间, $F^n, \begin{Bmatrix}0\end{Bmatrix}, R^3, R^2$,再比如线性方程的解空间:

$N(A)=\begin{Bmatrix}X \in R^n|AX = 0\end{Bmatrix}$,由于满足该空间中的加法及数乘封闭性,因此也是一个向量空间

再比如,基张成的空间:

设$\alpha, \beta \in F^n$,记 $V=L(\alpha,\beta)=\begin{Bmatrix}k_1\alpha+k_2\beta|k_1,k_2 \in F\end{Bmatrix}$, $V$就是$\alpha, \beta$张成的向量空间

向量空间的基底,纬数,坐标,以及基向量的纬度

向量空间的最大无关组就称为向量空间的基

向量空间的纬数是其基(最大无关组)的向量个数,基向量的纬数是基向量包含的分量的个数

向量的纬数 $\geq$ 向量空间的纬数

比如(1,0,0),(0,1,0)线性无关,其张成的向量空间为三维空间中的一个平面($R^{3}$的子空间),该空间的维数为2(因为最大无关组向量的个数为2),但是向量本身是三维的。

也就是说三维向量可能存在二维平面(实质是三维空间中的一个平面里),但是二维向量不可能存在于三维空间中,因为三维空间是由至少三维的向量基张成的,因此二维向量只能再加一个纬度才可能存在三维空间中。

向量空间的任何向量都可以由基底线性表示,其表示系数被称为该向量在给定基底$\alpha_1,\alpha_2,..,\alpha_m$下的坐标,比如:

$\alpha = x_1\alpha_1+x_2\alpha_2+..+x_m\alpha_m$

这里的$(x_1,x_2,x_m)^T$就为向量$\alpha$的坐标。注意:不同基底,其坐标就会不同哦

自然基

$R^{n}$空间中,我们单独取单个分量长度为1而其他分量长度为0的向量$e_1=(1,0,0,0..0),e_2=(0,1,0,0..0),..,e_r=(0,0,0,0..1),$形成的一个向量组自然是正交的,称为自然基。

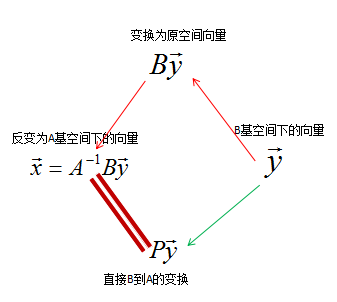

过度矩阵与向量空间中不同基底下的坐标转换公式

https://blog.csdn.net/qq_25847123/article/details/79374501

设V是一个向量空间,给出其两组列向量基:

$\alpha_1,\alpha_2,..,\alpha_m以及\beta_1,\beta_2,..,\beta_m$,那么对于$\forall \alpha \in V$

$$\alpha = x_1\alpha_1+x_2\alpha_2+..+x_m\alpha_m = (\alpha_1 \alpha_2 .. \alpha_m)X, X=(x_1 x_2 .. x_m)^T$$

$$\alpha = y_1\beta_1+y_2\beta_2+..+y_m\beta_m = (\beta_1 \beta_2 .. \beta_m)Y, Y=(y_1 y_2 .. y_m)^T$$

那么不同基底下X和Y两者之间是什么关系呢?

我们先来考察基底之间的线性关系,引入"过度矩阵P"的概念,来刻画不同基底之间的变换关系。比如:

$$(\alpha_1 \alpha_2 .. \alpha_m)\begin{pmatrix}P_{11} & .. & P_{1m}\\ P_{21} & .. & P_{2m}\\ .. & .. & ..\\ P_{m1} & .. & P_{mm}\\ \end{pmatrix}_{m \times m}=(\alpha_1 \alpha_2 .. \alpha_m)P$$

上述过度矩阵P必然是可逆$m阶$方阵,坐标Y和坐标X之间存在以下关系:

$Y = P^{-1}X$

这就是不同基底下的坐标转换公式

我们知道$(\alpha_1 \alpha_2 .. \alpha_m)$实际上描述了一个由基底组成的线性变换

规范正交基

设$\alpha_1,\alpha_2,..,\alpha_m,$是向量空间$V$的一组基,满足以下条件:

1.$|\vec{\alpha_i}| = 1, i=1,2,..,m$ 规范

2.$ \vec{\alpha_i} \cdot \vec{\alpha_j} = 0, i\neq j $ 正交

则称$\alpha_1,\alpha_2,..,\alpha_m$为向量空间V的规范正交基

例:$$e_1=\begin{pmatrix}1\\0\end{pmatrix}e_2=\begin{pmatrix}0\\1\end{pmatrix}$$

$$\alpha_1=\begin{pmatrix}\sqrt{2}/2\\-\sqrt{2}/2\end{pmatrix}\alpha_2=\begin{pmatrix}\sqrt{2}/2\\\sqrt{2}/2\end{pmatrix}$$

都是$R^2$的规范正交基

规范正交基的优点:

假设$\alpha_1,\alpha_2,..,\alpha_m$为空间$V$的一组规范正交基,则对于任意$\alpha \in V, \beta \in V$

1. $\alpha = x_1\alpha_1+x_2\alpha_2+..+x_m\alpha_m$中的系数可以通过以下内积计算$x_i = \vec{\alpha} \cdot \vec{\alpha_i}$求得,也就是说:任意向量使用另外的规范正交基表示时,其坐标(表示系数)可用该向量分别与基底做点积获得

2.任意两个用规范正交基表示的坐标向量$\alpha = (x_1,x_2,..,x_m)\begin{pmatrix}\alpha_1\\ ..\\ \alpha_m \end{pmatrix},\beta = (y_1,y_2,..,y_m)\begin{pmatrix}\alpha_1\\ ..\\ \alpha_m \end{pmatrix}$,其内积计算就等于相应系数相乘之和

$$\vec{\alpha} \cdot \vec{\beta} = x_1y_1+x_2y_2+..+x_my_m$$

施密特正交化求解规范化正交基

思路:给定线性无关的向量组$\alpha_1,\alpha_2,..,\alpha_m$,令$\beta_1=\alpha_1, \beta_2 = \alpha_2 - \frac{\alpha_2 \cdot \beta_1}{\beta_1 \cdot \beta_1}\beta_1, \beta_3 = \alpha_3 - \frac{(\alpha_3,\beta_1)}{(\beta_1,\beta_1)}\beta_1 - \frac{(\alpha_3,\beta_2)}{(\beta_2,\beta_2)}\beta_2 $..

减去前面向量方向的分量即可得到。。

规范化,则使用$\gamma_1 = \frac{\beta_1}{|\beta_1|} $...即可

(规范)正交矩阵

若 $A^TA=AA^T=E_n$则$A$就是正交矩阵,也就是说如果一个矩阵他的逆矩阵等于其转置矩阵,则该矩阵被称为正交矩阵

比如:$$\begin{pmatrix}1 & 0\\ 0 & 1\end{pmatrix},\begin{pmatrix}1 & 0\\ 0 & -1\end{pmatrix},\begin{pmatrix}0 & 1\\ -1 & 0\end{pmatrix},\begin{pmatrix}cos\theta & -sin\theta\\ sin\theta & cos\theta\end{pmatrix}$$

标准正交基到标准正交基的过度矩阵也为正交矩阵

正交矩阵的重要性质:

如果$A$为正交矩阵,则$AX \cdot AY = X \cdot Y$,也就是说正交矩阵去乘两个列向量,保持其内积不变。这个性质说明用正交矩阵去乘会保留所有内积的性质。

正交矩阵保持内积不动,保持长度不动,保持夹角不动:

$|AX|=|X|, AX和AY的夹角和X与Y的夹角相等$

1.$A^{-1} = A^T$

2.$|A| = 1, or |A| = -1$

3.两个正交矩阵的乘积依然是正交矩阵

正交矩阵的判定定理:

$A=(\alpha_1,\alpha_2,..,\alpha_n) \in R^{n \times n}$是正交矩阵的充分必要条件是:$\alpha_1,\alpha_2,..,\alpha_n$是$R^n$的规范正交基

$R^n$的规范正交基到规范正交基的过度矩阵必然是正交矩阵

正交矩阵是规范正交基到规范正交基的过度矩阵

共轭矩阵

设$A=(a_{ij})_{m\times n}$ 为复数域上的矩阵,则$\bar A = (\bar a_{ij})_{m \times n}$称为$A$的共轭矩阵

矩阵的特征值和特征向量及其几何意义

设A是n阶方阵,如果$AX = \lambda X, X \neq 0$,则称$\lambda$是矩阵A的一个特征值, $X$是矩阵$A$的属于特征值$\lambda$的一个特征向量.

注意: $X$只与一个$\lambda$对应,如果$\lambda$确定,却可能有无数多个特征向量,这些特征向量组成特征空间。

特征值和特征向量的计算

特征方程:

$$|\lambda E -A| =0$$

求解上面的方程即可解得特征值$\lambda$.对于n阶方阵,其特征方程将为n次的。

如果n > 5将不再有解析解,只能通过计算机数值算法逼近,后面讨论。

n阶矩阵A的特征方程的两种表达方法:

$$|\lambda E -A| =\begin{vmatrix}\lambda-a_{11} & -a_{12} & .. & -a_{1,n-1} & -a_{1n}\\ -a_{21} & \lambda-a_{22} & .. & -a_{2,n-1} & -a_{2n}\\ -a_{n-1,1} & -a_{n-1,2} &.. & \lambda-a_{n-1,n-1} & -a_{n-1,n} \\ -a_{n1} & -a_{n,2} & .. & -a_{n,n-1} & \lambda-a_{nn}\end{vmatrix}=(\lambda-\lambda_1)(\lambda-\lambda_2)..(\lambda-\lambda_n)$$

特征向量的求解:

$$(\lambda E -A)X = 0$$

上述方程的所有解称为矩阵A的$\lambda$的特征子空间$(\lambda_0E -A)$

特征向量在人脸识别中的应用,强力推荐阅读:

https://blog.csdn.net/smartempire/article/details/21406005

特征值的性质:

1.n阶方阵在复数域中具有n个特征值。但不一定有n个实数特征值,但是如果方阵是一个对称矩阵,则必然有n个实特征值(有可能有重根!)

2.设$\lambda_1,\lambda_2,...,\lambda_n$是n阶方阵A的n个特征值,则

a. $\lambda_1+\lambda_2+..+\lambda_n = a_{11}+a_{22}+..+a_{nn}=tr(A)$,其中$tr(A)$被称为矩阵A的迹

b.$\lambda_1\lambda_2..\lambda_n = |A|$

c. 如果A可逆,$\lambda$是A的特征值,则: 1)$\lambda^{-1}$是$A^{-1}$的特征值。 2) $|A|\lambda^{-1}$是伴随矩阵$A^{*}$的特征值

如果A可逆,则其特征向量也是$A^{-1}$和$A^{*}$的特征向量

d. 如果$\lambda$是$A$的特征值,那么$f(\lambda)$必然是$f(A)$的特征值,比如$f(\lambda) = a_0+a_1\lambda+a_2\lambda^{2} , f(A) = a_0E+a_1A+a_2A^{2} $

https://blog.csdn.net/fuming2021118535/article/details/51339881

线性变换

线性变换(矩阵乘法)可以和函数做类比:

自变量$x$经过函数$f(x)$的作用后输出$y$,如下

$$x\rightarrow f(x)\rightarrow y$$

向量$\vec{x}$经过线性变换$L(\vec{x})$作用后(也可以说左乘一个矩阵)输出向量$\vec{y}$,如下

$$\vec{x}\rightarrow L(\vec{x}) \rightarrow \vec{y}$$

凡是满足以下运算的就定义为线性变换

- $L(\vec{v} + \vec{w}) = L(\vec{v}) + L(\vec{w})$ 向量的加法运算

- $L(c\vec{v}) = cL(\vec{v})$ 向量的数乘运算

线性变换作用后向量空间变换前后有以下特点:

- 所有直线变换后依然为直线

- 所有均匀分布的点变换后依然均匀分布

- 原点在变换前后保持不变

线性变换是操作线性空间的手段,这种变换往往只需要几个数字组成的矩阵就能准确描述。对于二维向量空间,我们可以将线性变换视为对二维空间基向量$\vec{i}, \vec{j}$的作用来确定,往往用变换后形成的$\widehat{\vec{i}},\widehat{\vec{j}}$分别作为矩阵的一列形成的矩阵来描述这个线性变换。

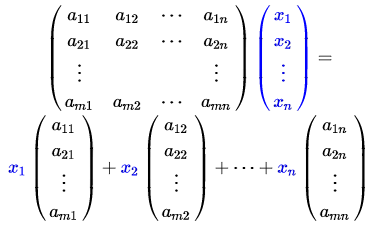

将该线性变换应用到一个向量$$\begin{pmatrix}x\\ y \end{pmatrix}$$上去的话,这里我们用坐标的形式来表示向量,则就等价于左乘一个矩阵

$$\begin{pmatrix}a & b\\ c & d\end{pmatrix} \vec{\begin{pmatrix}x\\ y\end{pmatrix}} = x \vec{\begin{pmatrix}a\\ b\end{pmatrix}}+y\vec{\begin{pmatrix}b\\ d\end{pmatrix}}$$

以后我们看到一个左乘一个矩阵就应该联想到它对线性空间做了变换

矩阵是线性变换的表达形式,每一个列我们都可以看作线性变换的子步骤,比如

$\begin{pmatrix}1 & 1\\ 0 & 2\end{pmatrix}$这个矩阵代表的变换我们可以这样理解:先对$\vec{i}$从$(1,0)$变换到$(1,1)$,随后再对$\vec{j}$从$(0,1)$变换到$(0,2)$

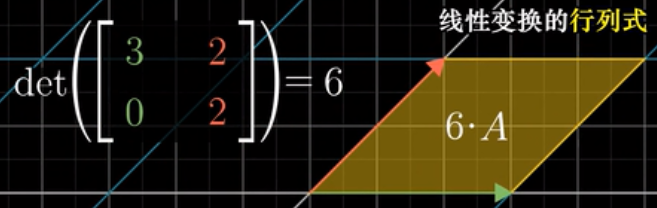

线性变换后的空间不降纬的充分必要条件是其行列式不等于0,因为如果等于0,则缩放系数就成了0,无法无损恢复信息。

线性变换的矩阵函数观点

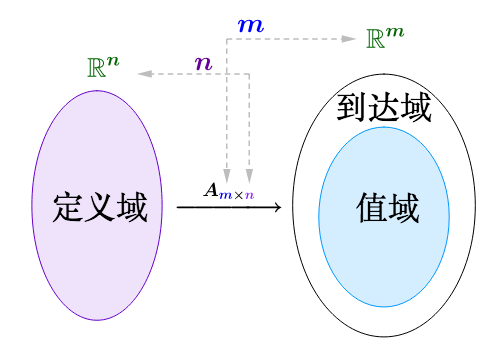

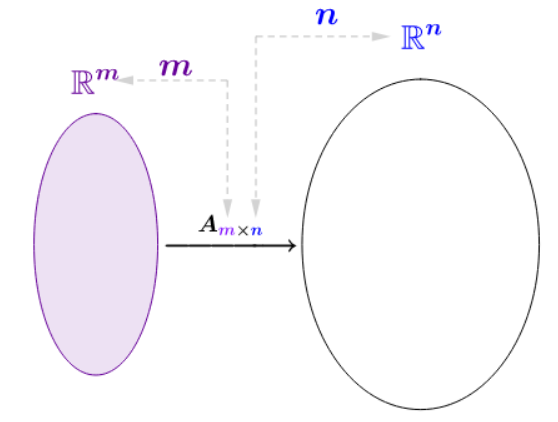

矩阵函数的定义域值域:($A^{m\times n}$):

左乘

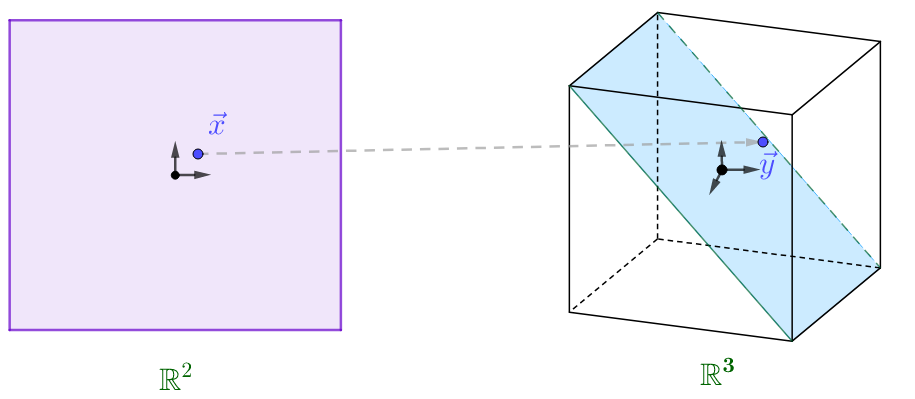

例如,矩阵$A = \begin{pmatrix}1 & -1\\ 1 & 1\\ 1 & 2\end{pmatrix}$是一个3行两列的矩阵,他将一个二维的向量映射成为三维的向量,如下图:

右乘

向量线性变换后向量的坐标

设$\alpha = x_1\varepsilon_1+x_2\varepsilon_2+..+x_n\varepsilon_n = (\varepsilon_1,\varepsilon_2,..,\varepsilon_n)X, X=(x_1,x_2,..,x_n)^T$,也就是说$\alpha$关于基低$\varepsilon_1,\varepsilon_2,..,\varepsilon_n$的坐标为$X$,则经过矩阵A做线性变换后的向量$A\alpha$在$\varepsilon_1,\varepsilon_2,..,\varepsilon_n$基低下的坐标等于$AX$

线性变换的矩阵

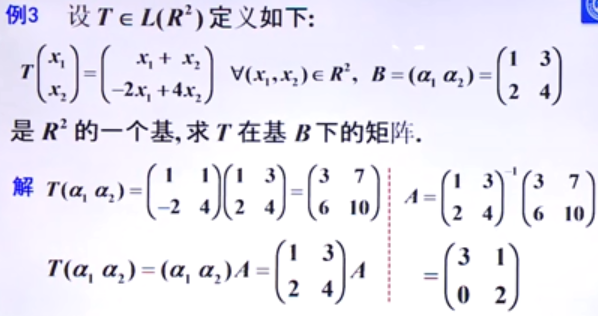

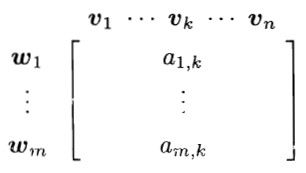

下图列出一个求解线性变换矩阵的例子:

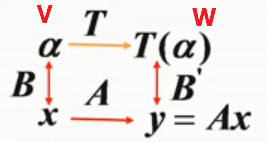

在$V->W$线性变换矩阵A的作用下,在V中向量基底B下的坐标,经过线性变换后,在W中基底$B^'$上的坐标计算方法:

再给一个形象的图:

把每一个写成基向量

的线性组合,所需要的系数就构成了矩阵的第

列。这就是求解线性变换对应矩阵的方法

线性变换的矩阵为何要强调是在某组基下?

https://www.zhihu.com/question/22218306

定理:

设$\alpha_1,\alpha_2,..,\alpha_n;及\beta_1,\beta_2,..,\beta_n$是线性空间$V$的两组基,$P$是$\alpha到\beta$的过度矩阵,一个线性变换,矩阵$A,B$分别是线性变换$L$针对$\alpha,\beta$两组基下的矩阵,也就是说$L$作用到两组基低向量组后对应的为基低乘以矩阵$A和B$:$L(\alpha_1,\alpha_2,..,\alpha_n) = (\alpha_1,\alpha_2,..,\alpha_n)A;L(\beta_1,\beta_2,..,\beta_n)=(\beta_1,\beta_2,..,\beta_n)B$则$A,B$必然是相似矩阵,相似变换P就是这里的过度矩阵$P^{-1}AP=B$。

行列式

看下面的线性方程组:

$$\left\{\begin{matrix}a_{11}x_1 & +a_{12}x_2 & = b_1\\ a_{21}x_1 & +a_{22}x_2 & = b_2 \end{matrix}\right.$$

其解和行列式有关,定义:

$D = \begin{vmatrix}a_{11} & a_{12}\\ a_{21} & a_{22}\end{vmatrix}=a_{11}a_{22}-a_{12}a_{21}$,

$D_1 = \begin{vmatrix}b_{1} & a_{12}\\ b_{2} & a_{22}\end{vmatrix}=b_{1}a_{22}-b_{2}a_{12}$,

$D_2 = \begin{vmatrix}a_{11} & b_{1}\\ a_{21} & b_{2}\end{vmatrix}=a_{11}b_{2}-b_{1}a_{21}$

则

当$D\neq 0$时,方程组有唯一解,其解为:$$x_1 = \frac{D_1}{D} , x_2 = \frac{D_2}{D} , $$

推广出去就是cramer法则:

$$\left\{\begin{matrix}a_{11}x_1 +& a_{12}x_2+ & a_{1n}x_n & = b_1\\ a_{21}x_1 +& a_{22}x_2+ & a_{2n}x_n & = b_2\\ a_{n1}x_1 +& a_{n2}x_2 + & a_{nn}x_n& = b_n \end{matrix}\right.$$

如果系数行列式不等于0,则有唯一解,其解为对应替换常数后的行列式的值除以原系数行列式的值

行列式的几何意义

行列式是一个scalar标量数值,可以看作对应线性变换将$\vec{i}, \vec{j}$组成的正方形(对三维空间则是立方体)拉升或者收缩线性空间后,该正方形(正方体)面积(体积)放大或者缩小的倍数比例。

逆序:

一个数的排列对所有元素如果不是从小到大的顺序排列我们就说产生了一个逆序,对所有元素分别数出其前面产生的逆序数加起来就是这个排列的逆序。

$\tau (P_1,P_2,...P_n) $

比如:$\tau (3,1,2) = 0 + 1+ 1 =2 $ 我们称为偶排列

而$\tau (1,3,2) = 1$则称之为奇排列

逆序有如下的性质:

任意调换两元素,则改变全排列的奇偶性

n阶行列式的一般定义:

$$\begin{vmatrix}a_{11} & a_{12} & ... & a_{1n}\\ a_{21} & a_{22} & ... & a_{2n}\\ ... & ... & ... & ...\\ a_{n1} &_{n2} & ... & a_{nn}\end{vmatrix}=\sum_{P_1P_2...P_n}(-1)^{\tau (P_1P_2...P_n)}a_{1P_1}a_{2P_2}...a_{nP_n}$$

其计算有以下特点:

- 其定义为所有不同行不同列元素乘积并取逆序相关对应符号后相加

- 共有$n!$项数据

- 每一项符号按照以下规则:行下表自然排列后,看列下标

- 对应排列的逆序奇偶性,偶排列取正,奇排列取负。或者列下表自然排列后,就看行下标对应排列的逆序奇偶性决定

根据行列式的代数定义式,可知:

- 三角行列式的值为所有对角线上元素的乘积

- 对角行列式的值为对角线上元素的乘积

行列式的性质:

- $D' = D$ ,关于列的性质关于行也一定是成立的。

- 换行行列式的值变号,换列行列式的值变号

- 若某两行相同或者两列相同,行列式的值必为0,因为$D=-D$,所以$D=0$

- 行或列的公因子可以提出到行列式

- 某两行或者某两列成比例,行列式的值比为0

- 行(列)两项和可拆开

- 消法变换(某一行、列乘以一个数加到另一行、列)不改变行列式的值

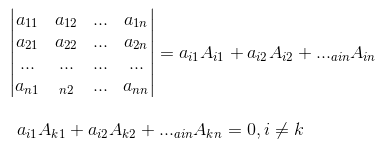

行列式按照某行或列展开

余子式

$M_{ij}$表示去掉该元素所在行所在列剩下的原始元素降阶形成的新行列式我们称为余子式

代数余子式

代数余子式为余子式加上对应的符号

$A_{ij} = (-1)^{i+j}M_{ij}$

$$\begin{vmatrix}a_{11} & a_{12} & ... & a_{1n}\\ a_{21} & a_{22} & ... & a_{2n}\\ ... & ... & ... & ...\\ a_{n1} &a_{n2} & ... & a_{nn}\end{vmatrix}= a_{i1}A_{i1}+ a_{i2}A_{i2}+...a_{in}A_{in}$$

$$a_{i1}A_{k1}+ a_{i2}A_{k2}+...a_{in}A_{kn} = 0, i\neq k$$

如果下面的线性方程组有非零解,则系数行列式必为0,

$$\left\{\begin{matrix}a_{11}x_1 +& a_{12}x_2+ & a_{1n}x_n & = 0\\ a_{21}x_1 +& a_{22}x_2+ & a_{2n}x_n & = 0\\ a_{n1}x_1 +& a_{n2}x_2 + & a_{nn}x_n& = 0 \end{matrix}\right.$$

则

$$\begin{vmatrix}a_{11} & a_{12} & a_{1n}\\ a_{21} & a_{22} & a_{2n}\\ a_{n1} & a_{n2} & a_{nn} \end{vmatrix}=0$$

矩阵

矩阵的线性运算:

加减+数乘组成了线性运算

矩阵的乘法:

$$A = \begin{pmatrix}a_{11} & a_{12} & .. & a_{1n}\\ a_{21} & a_{22} & .. & a_{2n} \\ a_{m1} & a_{m2}& .. & a_{mn}\end{pmatrix}_{mXn}$$

$$B = \begin{pmatrix}b_{11} & b_{12} & .. & b_{1p}\\ b_{21} & b_{22} & .. & b_{2p} \\ b_{n1} & b_{n2}& .. & b_{np}\end{pmatrix}_{nXp}$$

则$$C = AB = \begin{pmatrix}c_{11} & c_{12} & .. & c_{1p}\\ c_{21} & c_{22} & .. & c_{2p} \\ c_{m1} & c_{m2}& .. & c_{mp}\end{pmatrix}_{mXp}$$

需要注意的是:矩阵满足乘法的条件是A的列数=B的行数, A的行数决定乘积的行数,B的列数决定乘积的列数,A的列和B的行好像抵消掉了一样。

$$c_{ij} = \sum_{x=1}^{n}a_{ix}b_{xj}$$

矩阵乘法不同观点考察:行观点 .vs. 列观点 .vs. 点积观点

行观点:

行观点常见的应用场景为:行向量 X 矩阵 = 行向量 ;$XA=Y$,行观点表达的是矩阵中每个行向量的线性组合。此时矩阵出现在右侧,我们称为右乘。可以将左面的X推广到多个行组成的矩阵形成矩阵乘法

列观点:

列观点常见的应用场景是:矩阵 X 列向量 = 列向量; $AX = Y$.列观点要表达的是矩阵中每个列向量的线性组合。此时矩阵出现在左侧,我们称为左乘,可以将右面的X推广到多列形成矩阵的乘法

点积观点

常见的应用场景为:行向量 X 列向量 = 标量,常用于矩阵乘法的代数运算。

$c_{ij} = A_iB_j$

结果矩阵$C$中的第i行第j列元素等于A的第i个行向量和B的第j个列向量点积

矩阵乘法的应用:

以下线性方程组

$$\left\{\begin{matrix}a_{11}x_1+ & .. & a_{1n}x_n &=b_1 \\ a_{m1}x_1+ & .. & a_{mn}x_n &=b_m\end{matrix}\right.$$

可以写成矩阵乘法的形式:$AX = \beta $

其中$A$为系数矩阵,$\beta$为常数向量$X$为自变量向量

线性变换的叠加:

设$$\left\{\begin{matrix}x_1 = a_{11}y_1+a_{12}y_2+..+a_{1n}y_n\\ x_n = a_{n1}y_1+a_{n2}y_2+..+a_{nn}y_n\end{matrix}\right.$$

$X=AY$

而

$$\left\{\begin{matrix}y_1 = b_{11}z_1+b_{12}z_2+..+b_{1n}z_n\\ y_n = b_{n1}z_1+b_{n2}z_2+..+b_{nn}z_n\end{matrix}\right.$$

$Y=BZ$

则$X$和$Z$之间的关系可以这样表达:

$$X=A(BZ)=(AB)Z$$

也就是说$X,Z$之间的关系可以用矩阵$AB$来表达

方阵行列式的乘法公式:

$$|AB| = |A| |B|$$

行列式的值等于特征值的乘积 $|A| = \prod \lambda _i$

推论:

$$|AB| = |BA| = |A| |B|$$

$|A'B| = |AB|$ $|A^{-1}BA| = |B|$

$|kA|=k^{n}|A|$

转置矩阵:

$$A=\begin{pmatrix}a_{11} &.. a_{1n} \\ a_{m1} &.. a_{mn}\end{pmatrix} mXn$$

$$A^{T}=A' = \begin{pmatrix}a_{11} &.. a_{m1} \\ a_{1n} &.. a_{mn}\end{pmatrix} a_{ij} = a'_{ji} 为 nXm$$

转置矩阵的性质:

$(AB)^{T} = B^{T}A^{T}$

$|A^T| = |A|$

一个矩阵和他本身的转置矩阵乘积必然是一个对称矩阵$A^TA = (A^TA)^T$,正如下面的图示。这一个重要性质在比如协方差矩阵PCA降维时非常有用!

假如给定一个数据集:$$X = (X_1,X_2,...,X_n)^T, X_i=(X_{i1},X_{i2},..,X_{im})$$

我们对m个特征数据列分别做数据中心化,使得特征随机变量均值为0,则有

$$C=X^TX=\sum_{i=1}^{n} X_i^TX_i$$

矩阵$C$为数据集$X$的协方差矩阵,是一个实对称矩阵!

协方差矩阵(实对称矩阵)的特征值分解

$$C=X^TX = Q\Sigma Q^T$$

其中$Q$为$C$矩阵的特征向量,互相正交,$\Sigma$则是其特征值组成的对角矩阵。 PCA降维时就是找到对应最大特征值对应的特征向量

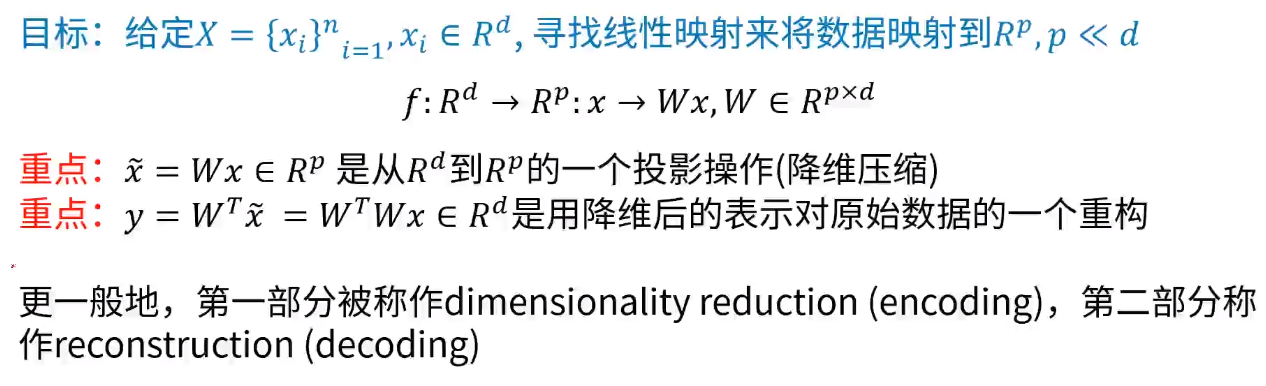

PCA降维核心思想

W为pxd矩阵,p为降维的目标维数,W由$X^TX$协方差矩阵的前p个最大特征值对应的特征向量组成的矩阵。由于特征向量反映了矩阵数据变化最快的方向,而这里协方差矩阵的数据意义为数据方差,因此也代表着数据方差变化最快的方向,也就是最能反映数据特征的方向,这就是PCA降维的几何解释

对称矩阵:$A=A^T$:

- 实对称矩阵的特征值都是实数

- 实对称矩阵的任一特征值都有一个实特征向量

- 实对称矩阵不同特征值的实特征向量互相正交

- 实对称矩阵一定可以相似对角化

反对称矩阵:$A=-A^T$

可逆矩阵

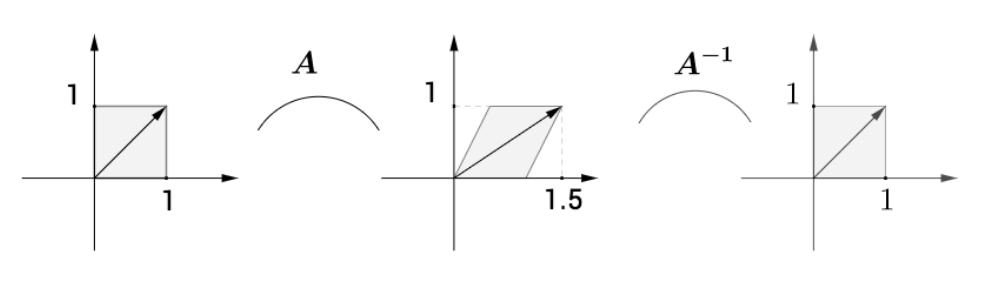

设A为n阶方阵,若存在n阶方阵B,使得:$AB = BA = E_n$,则称$A$是可逆矩阵,$B为A$的可逆矩阵,记为$B=A^{-1}$

逆矩阵的几何意义就是将图形变回原来的样子

可逆矩阵的性质:

- 如果A可逆,则其A的拟矩阵是唯一的。

- 如果A可逆,则A的逆矩阵也是可逆的$(A^{-1})^{-1} = A$

- 如果A,B都是n阶可逆矩阵,则$(AB)^{-1} = B^{-1}A^{-1}$ :乘积的逆等于反序后逆阵的乘积

- $(kA)^{-1} = k^{-1}A^{-1}$

- $(A')^{-1} = (A^{-1})'$

- $|A||A^{-1}| = 1$

可逆矩阵的判定:

伴随矩阵:

给定n阶方阵A,

$$A = \begin{pmatrix}a_{11} & a_{12} &.. & a_{1n}\\ a_{21} & a_{22} &.. & a_{2n}\\ a_{n1} & a_{n2} &.. & a_{nn}\end{pmatrix}$$

将矩阵A的第一行每一个元素$a_{ij}$对应的代数余子式当作新矩阵$A^{*}$的第一列,矩阵$A$的第二行每个元素对应的代数余子式当作新矩阵的第2列。。。最后形成的矩阵$A^{*}$我们称为$A$矩阵的伴随矩阵

$$A^{*} = \begin{pmatrix}A_{11} & A_{12} &.. & A_{1n}\\ A_{21} & A_{22} &.. & A_{2n}\\ A_{n1} & A_{n2} &.. & A_{nn}\end{pmatrix}$$

引理:

$$A^{*}A = AA^{*} = |A|E_n$$

可逆判定定理:n阶方阵$A$可逆的充分必要条件是:$det(A) = |A| \neq 0$

并且其逆矩阵可用以下方法计算:

$$A^{-1} = \frac{1}{|A|}A^{*}$$

由于矩阵代表着线性变换,矩阵可逆就是线性变换可以逆操作恢复,而如果行列式为0,则应用变换后就将损失相应的信息,我们可以直观想象直线无法逆转恢复平面

矩阵的初等变换

$$\begin{matrix}. & 行 & 列 \\ 换法 & r_i\leftrightarrow r_j & c_i\leftrightarrow c_j \\ 倍法& k \cdot r_i,k\neq 0 & k \cdot c_i,k\neq 0 \\消法 & r_j+k \cdot r_i,k\neq 0 & c_j+k \cdot c_i,k\neq 0\end{matrix}$$任何一个矩阵

- 任何一个矩阵通过初等行变换都能变换出一个行阶梯形

- 任何一个矩阵通过初等行变换都能形成行最简形

- 任何一个矩阵通过初等行变换(相当于矩阵左乘)和列变换(相当于矩阵右乘)都能变换成标准型$\begin{pmatrix}E_r & 0\\ 0 & 0\end{pmatrix}$,也称称为等价标准型

初等行变换不改变列向量组的线性相关性;初等列变换不改变行向量组的线性相关性

等价矩阵

如果矩阵A经过初等行列变换(分别对应矩阵的左乘和右乘)能成为B,则称A和B等价,也就是说存在两个可逆矩阵$P,Q$使得以下式子成立: $PAQ = B$,则称$A,B$等价。P和Q分别对应着一系列行变换(左乘)和列变换(右乘)的累积效应

相似矩阵

设$A,B$都是n阶矩阵,若存在可逆矩阵$P$,使得$P^{-1}AP=B$,则称$A,B$相似,记为$A \sim B$

相似的性质:

1. 反身性: $A \sim A$

2. 对称性: $A \sim B \Rightarrow B \sim A$

3. 传递性: $A \sim B, B \sim C \Rightarrow A \sim C$

注意:相似矩阵的条件强于等价矩阵。相似的矩阵一定等价,等价的矩阵却不一定相似

相似矩阵的性质

- 相似矩阵必有相同的特征值

矩阵的秩

子阵,子方阵为矩阵

子式为对应子方阵的行列式,

非零子式为子方阵行列式不为0情况下的值及对应的子方阵

矩阵A的所有非零子式的最高阶数被成为矩阵A的秩$R(A),r(A),rank(A)$

比如$$\begin{pmatrix}1 & 1 & 2 & 2\\ 2 & 2 & 4 & 4\end{pmatrix}$$的秩为1

秩的性质:

对$mXn$阶的矩阵$A$,其秩有以下性质:

- $0\leq R(A) \leq min (m,n)$

- $R(A')=R(A)$

- $R(kA)=R(A)$

- $R(AB) \leq min \{R(A),R(B)\}$ 非常重要,矩阵相乘之后,秩不会大于最小秩矩阵的秩

矩阵经过初等变换不改变矩阵的秩

矩阵的行秩等于列秩

初等矩阵

对单位矩阵经过一次初等变换(换法,倍法,消法)得到的矩阵为初等矩阵

初等矩阵都是可逆矩阵

初等矩阵求解逆矩阵比较方便

一次行变换可以用在矩阵左边乘以一个初等矩阵来刻画,一次列变换可以用在矩阵右边乘以一个初等矩阵来刻画

定理:

$A$矩阵可逆的充分必要条件是存在有限的初等矩阵$P_1,P_2,..,P_s$使得$A=P_1P_2..P_s$

可逆矩阵必然可以通过初等变换化为单位阵

A经过行变换生成B的充分必要条件是:存在一个可逆矩阵P,使得PA = B

A经过列变换生成B的充分必要条件是:存在一个可逆矩阵Q,使得AQ = B

A经过初等(行、列)变换生成B的充分必要条件是:存在两个可逆矩阵P,Q使得PAQ = B

可逆矩阵左乘或右乘不改变矩阵的秩

设A为mxn的矩阵$R(A) =r$,则存在可逆阵P,Q,使得$PAQ=\begin{pmatrix}E_r & 0\\ 0 & 0\end{pmatrix}$

矩阵特征值重要性质:

针对一个矩阵增加一个 delta*I的单位对角矩阵,其新的特征值则全部变更为+delta