如何让服务在流量暴增的情况下保持稳定输出

服务自适应降载保护设计

设计目的

- 保证系统不被过量请求拖垮

- 在保证系统稳定的前提下,尽可能提供更高的吞吐量

设计考虑因素

- 如何衡量系统负载

- 是否处于虚机或容器内,需要读取cgroup相关负载

- 用1000m表示100%CPU,推荐使用800m表示系统高负载

- 尽可能小的Overhead,不显著增加RT

- 不考虑服务本身所依赖的DB或者缓存系统问题,这类问题通过熔断机制来解决

机制设计

-

计算CPU负载时使用滑动平均来降低CPU负载抖动带来的不稳定,关于滑动平均见参考资料

- 滑动平均就是取之前连续N次值的近似平均,N取值可以通过超参beta来决定

- 当CPU负载大于指定值时触发降载保护机制

-

时间窗口机制,用滑动窗口机制来记录之前时间窗口内的QPS和RT(response time)

- 滑动窗口使用5秒钟50个桶的方式,每个桶保存100ms时间内的请求,循环利用,最新的覆盖最老的

- 计算maxQPS和minRT时需要过滤掉最新的时间没有用完的桶,防止此桶内只有极少数请求,并且RT处于低概率的极小值,所以计算maxQPS和minRT时按照上面的50个桶的参数只会算49个

-

满足以下所有条件则拒绝该请求

-

当前CPU负载超过预设阈值,或者上次拒绝时间到现在不超过1秒(冷却期)。冷却期是为了不能让负载刚下来就马上增加压力导致立马又上去的来回抖动

-

averageFlying > max(1, QPS*minRT/1e3)-

averageFlying = MovingAverage(flying)

-

在算MovingAverage(flying)的时候,超参beta默认取值为0.9,表示计算前十次的平均flying值

-

取flying值的时候,有三种做法:

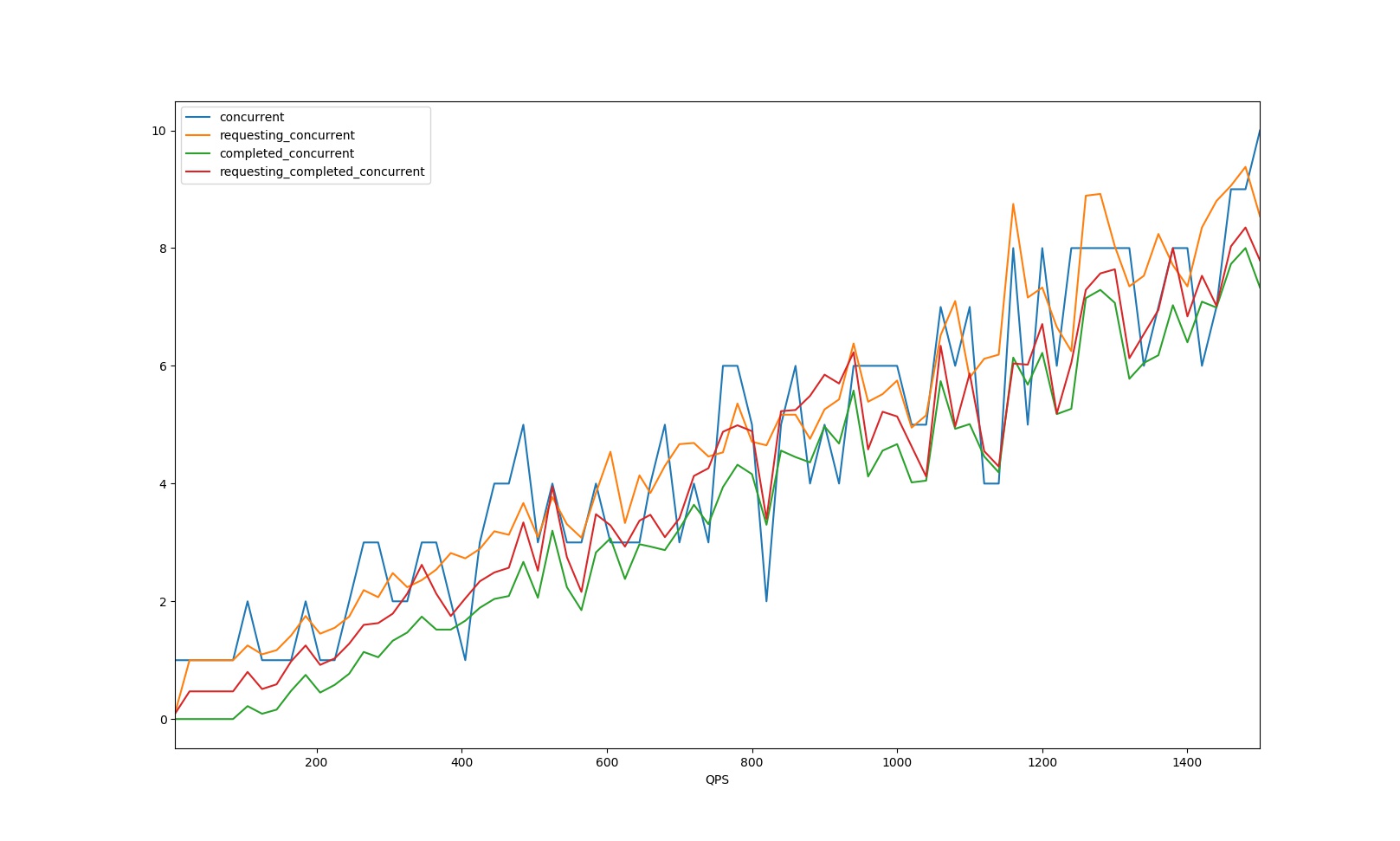

- 请求增加后更新一次averageFlying,见图中橙色曲线

- 请求结束后更新一次averageFlying,见图中绿色曲线

- 请求增加后更新一次averageFlying,请求结束后更新一次averageFlying

我们使用的是第二种,这样可以更好的防止抖动,如图:

-

QPS = maxPass * bucketsPerSecond

- maxPass表示每个有效桶里的成功的requests

- bucketsPerSecond表示每秒有多少个桶

-

1e3表示1000毫秒,minRT单位也是毫秒,QPS*minRT/1e3得到的就是平均每个时间点有多少并发请求

-

-

降载的使用

- 已经在rest和zrpc框架里增加了可选激活配置

- CpuThreshold,如果把值设置为大于0的值,则激活该服务的自动降载机制

- 如果请求被drop,那么错误日志里会有

dropreq关键字

参考资料

项目地址

https://github.com/tal-tech/go-zero

好未来技术

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· winform 绘制太阳,地球,月球 运作规律

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

· 上周热点回顾(3.3-3.9)