数据挖掘项目:

AUC: https://zhuanlan.zhihu.com/p/360765777

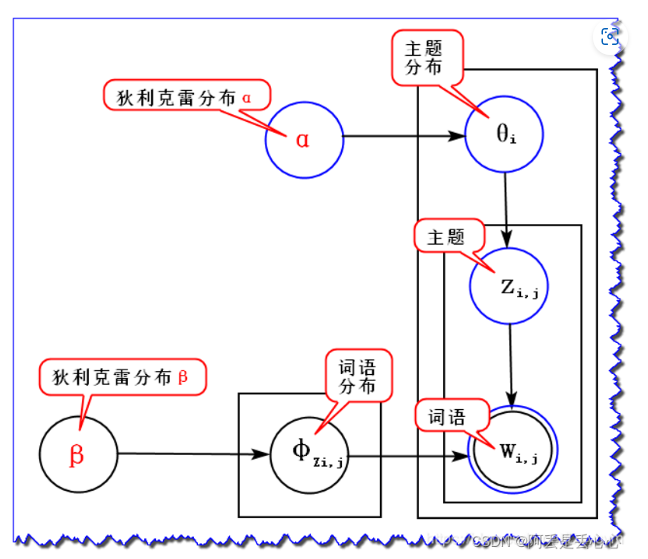

LDA 主题模型 一文详解LDA主题模型 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 怎么确定LDA的topic个数? - 知乎 (zhihu.com)

(61条消息) Kdd Cup 2013 总结2_kdd cup 2013 track1_pf1492536的博客-CSDN博客

通俗易懂理解——Skip-gram的负采样 :https://zhuanlan.zhihu.com/p/39684349

深入浅出Word2Vec原理解析 - 知乎 (zhihu.com)

一文搞懂熵(Entropy),交叉熵(Cross-Entropy) - 知乎 (zhihu.com)

一站式解决:隐马尔可夫模型(HMM)全过程推导及实现 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 条件随机场 - 搜索结果 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 如何通俗地讲解 viterbi 算法? - 知乎 (zhihu.com)

文本挖掘的分词原理 - 刘建平Pinard - 博客园 (cnblogs.com) -维特比算法与分词

Karush-Kuhn-Tucker (KKT)条件 - 知乎 (zhihu.com) 最大熵模型原理小结 - 刘建平Pinard - 博客园 (cnblogs.com)

条件随机场CRF(一)从随机场到线性链条件随机场 - 刘建平Pinard - 博客园 (cnblogs.com)

CRF的理解:https://zhuanlan.zhihu.com/p/87638630

(99+ 封私信 / 80 条消息) 逻辑回归 - 搜索结果 - 知乎 (zhihu.com)

利用crf++进行实体识别 - 知乎 (zhihu.com) 【实际操作!!】

NLP之CRF应用篇(序列标注任务) - 喂你在哪 - 博客园 (cnblogs.com)

从Encoder到Decoder实现Seq2Seq模型 - 知乎 (zhihu.com)

(61条消息) 循环神经网络(RNN, Recurrent Neural Networks)介绍_一只鸟的天空的博客-CSDN博客

(99+ 封私信 / 80 条消息) RNN 中为什么要采用 tanh,而不是 ReLU 作为激活函数? - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) ELMO模型 - 搜索结果 - 知乎 (zhihu.com)

最通俗易懂的BiLSTM-CRF模型中的CRF层介绍 - 知乎 (zhihu.com)

中文NER任务实验小结报告——深入模型实现细节 - 知乎 (zhihu.com)【很详细!!】

【白话NLP】什么是词向量 - 知乎 (zhihu.com)

牛客网 - 找工作神器|笔试题库|面试经验|实习招聘内推,求职就业一站解决_牛客网 (nowcoder.com)

BERT模型详解 - 李理的博客 (fancyerii.github.io)

BERT中的激活函数GELU:高斯误差线性单元 - 知乎 (zhihu.com)

十分钟理解Transformer - 知乎 (zhihu.com)

NLP中的RNN、Seq2Seq与attention注意力机制 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) transformer - 搜索结果 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 如何评价 BERT 模型? - 知乎 (zhihu.com)

一个框架看懂优化算法之异同 SGD/AdaGrad/Adam - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) sgd adam - 搜索结果 - 知乎 (zhihu.com)

Adam那么棒,为什么还对SGD念念不忘 (3)—— 优化算法的选择与使用策略 - 知乎 (zhihu.com)

【机器学习】决策树(上)——ID3、C4.5、CART(非常详细) - 知乎 (zhihu.com)

【机器学习】决策树(下)——XGBoost、LightGBM(非常详细) - 知乎 (zhihu.com)

除了Bert最新的NLP神器 https://zhuanlan.zhihu.com/p/89763176

Adaboost+指数损失+Trick https://www.zhihu.com/search?type=content&q=Adaboost%20%E7%AE%97%E6%B3%95%20%E6%8C%87%E6%95%B0%E6%8D%9F%E5%A4%B1

(61条消息) Focal Loss损失函数(超级详细的解读)_BigHao688的博客-CSDN博客

几种常见的聚类外部评价指标 - 知乎 (zhihu.com)

【数学】kd 树算法之详细篇 - 知乎 (zhihu.com)

【机器学习】Cross-Validation(交叉验证)详解 - 知乎 (zhihu.com)

零次学习(Zero-Shot Learning)入门 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 有哪些比BERT-CRF更好的NER模型? - 知乎 (zhihu.com)

Hierarchical Softmax(层次Softmax) - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 为什么在使用xgboost的时候要对特征按重要性筛选? - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 模型训练中出现NaN Loss的原因及解决方法 - 搜索结果 - 知乎 (zhihu.com)

Maxout激活函数以及特点? - 知乎 (zhihu.com)

深度学习领域最常用的10个激活函数,一文详解数学原理及优缺点 - 知乎 (zhihu.com)

详解深度学习中的Normalization,BN/LN/WN - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) Transformer不同batch的长度可以不一样吗?还有同一batch内为什么需要长度一样? - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) bert面试细节 - 搜索结果 - 知乎 (zhihu.com)

超细节的BERT/Transformer知识点 - 知乎 (zhihu.com)

Transformer中K 、Q、V的设置以及为什么不能使用同一个值 - Jerry_Jin - 博客园 (cnblogs.com)

一篇文章搞定GBDT、Xgboost和LightGBM的面试 - 知乎 (zhihu.com)

机器学习系列2——XGB常考面试题总结 - 知乎 (zhihu.com)

史上最细节的自然语言处理NLP/Transformer/BERT/Attention面试问题与答案 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) transformer中multi-head attention中每个head为什么要进行降维? - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 深度学习中Attention与全连接层的区别何在? - 知乎 (zhihu.com)

超细节的 BatchNorm/BN/LayerNorm/LN 知识点 - 知乎 (zhihu.com)

浅谈 Transformer-based 模型中的位置表示 - 知乎 (zhihu.com)

各种transformer的改进 - 知乎 (zhihu.com)

(61条消息) 全连接层的作用是什么?(nn.Linear())_马鹏森的博客-CSDN博客

举个例子讲下transformer的输入输出细节及其他 - 知乎 (zhihu.com) 【很全】

(99+ 封私信 / 80 条消息) 哪位大神讲解一下Transformer的Decoder的输入输出都是什么?能解释一下每个部分都是什么? - 知乎 (zhihu.com)

真·万字长文:可能是全网最晚的chatgpt技术总结 - 知乎 (zhihu.com)

一文读懂ChatGPT模型原理 - 知乎 (zhihu.com)

NLP系列之预训练模型(一):BERT/RoBERTa/ALBERT/ELECTRA、ERNIE - 知乎 (zhihu.com)

面试中理解ALBERT?(NLP面经) - 知乎 (zhihu.com)

https://zhuanlan.zhihu.com/p/463666907 图神经网络

中文NER最新屠榜力作——LEBERT - 知乎 (zhihu.com)

NLP新宠——浅谈Prompt的前世今生 - 知乎 (zhihu.com)

(99+ 封私信 / 80 条消息) 如何理解 Swin Transformer 和 Vision Transformer不同任务上的差异? - 知乎 (zhihu.com)

机器学习方法—优雅的模型(一):变分自编码器(VAE) - 知乎 (zhihu.com)

降维方法小结和理解:PCA、LDA、MDS、ISOMAP、SNE、T-SNE、AutoEncoder - 知乎 (zhihu.com)

图像应用:

Vision Transformer 超详细解读 (原理分析+代码解读) (一) - 知乎 (zhihu.com)

图解Swin Transformer - 知乎 (zhihu.com)

未看:

中文NER的正确打开方式: 词汇增强方法总结 (从Lattice LSTM到FLAT) - 知乎 (zhihu.com)

【总结】推荐系统——召回篇【1】 - 知乎 (zhihu.com)