Kubernetes日志收集

关于kubernetes的日志分好几种,针对kubernetes本身而言有三种:

1、资源运行时的event事件。比如在k8s集群中创建pod之后,可以通过 kubectl describe pod 命令查看pod的详细信息。

2、容器中运行的应用程序自身产生的日志,比如tomcat、nginx、php的运行日志。比如kubectl logs redis-master-bobr0。这也是官方以及网上多数文章介绍的部分。

3、k8s各组件的服务日志,比如 systemctl status kubelet。

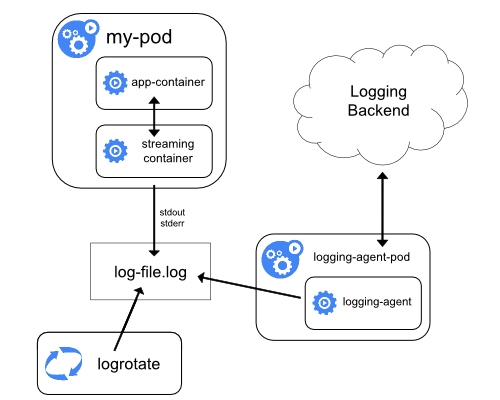

容器日志收集的方式通常有以下几种:

1、容器外收集。将宿主机的目录挂载为容器的日志目录,然后在宿主机上收集。

2、容器内收集。在容器内运行一个后台日志收集服务。

3、单独运行日志容器。单独运行一个容器提供共享日志卷,在日志容器中收集日志。

4、网络收集。容器内应用将日志直接发送到日志中心,比如java程序可以使用log4j 2转换日志格式并发送到远端。

5、通过修改docker的--log-driver。可以利用不同的driver把日志输出到不同地方,将log-driver设置为syslog、fluentd、splunk等日志收集服务,然后发送到远端。

从docker1.8起docker内置了fluentd log driver,docker默认的LogDriver是json-driver,将日志以JSON文件的方式存储。

#docker info |grep 'Logging Driver' Logging Driver: json-file |

Docker支持的LogDriver具体来说有以下几种,详情请参考docker官网。

Driver Description none No logs will be available for the container and docker logs will not return any output. json-file The logs are formatted as JSON. The default logging driver for Docker. syslog Writes logging messages to the syslog facility. The syslog daemon must be running on the host machine. journald Writes log messages to journald. The journald daemon must be running on the host machine. gelf Writes log messages to a Graylog Extended Log Format (GELF) endpoint such as Graylog or Logstash. fluentd Writes log messages to fluentd (forward input). The fluentd daemon must be running on the host machine. awslogs Writes log messages to Amazon CloudWatch Logs. splunk Writes log messages to splunk using the HTTP Event Collector. etwlogs Writes log messages as Event Tracing for Windows (ETW) events. Only available on Windows platforms. gcplogs Writes log messages to Google Cloud Platform (GCP) Logging. nats NATS logging driver for Docker. Publishes log entries to a NATS server. |

容器输出到控制台的日志,都会以 *-json.log 的命名方式保存在 /var/lib/docker/containers/ 目录下。

kubernetes 官方推荐的方案是 Flunetd+ElasticSearch+Kibana。网上常见的日志收集器还有filebeat、logspout等。

在每个node上各运行一个Flunetd容器,对本节点 /var/log 和 /var/lib/docker/containers/ 两个目录下的日志进行采集,然后汇总到elasticsearch集群,最后通过kibana展示。

为了让fluentd在每个node上运行一份,这里有几种不同的方法:

1、直接在Node宿主机上安装fluentd。这种方法适合elk都安装在物理机上的场景。

2、利用kubelet的–config参数,为每个node分别运行一个静态fluentd pod。

3、利用daemonset来让fluentd分别在每个node上运行一个pod。(daemontset是k8s的一种资源对象)

官方使用的是第三种方式,将ElesticSearch和kibana都运行在k8s集群中,然后用daemonset运行fluentd。具体实现过程github上有示例文件,这里不做详细描述。

除了容器应用的日志之外,还有一个重要的部分就是,程序自身的日志。一般情况下,会将程序日志写到固定目录文件、或者写入到中间件保存和读取。

这部分日志的处理,可以直接通过日志文件收集、或者是让开发程序的同学修改程序把日志输出到中间件或者是直接输出到elk上。

参考:

https://docs.docker.com/engine/admin/logging/overview/

https://docs.docker.com/engine/admin/logging/json-file/

https://docs.docker.com/engine/reference/commandline/dockerd/

浙公网安备 33010602011771号

浙公网安备 33010602011771号