深度学习之参数更新方法(全是转载,哭笑)

https://blog.csdn.net/u012328159/article/details/80311892

https://zhuanlan.zhihu.com/p/21486826

http://www.mamicode.com/info-detail-1931210.html

推荐看这个 https://blog.csdn.net/tsyccnh/article/details/76270707

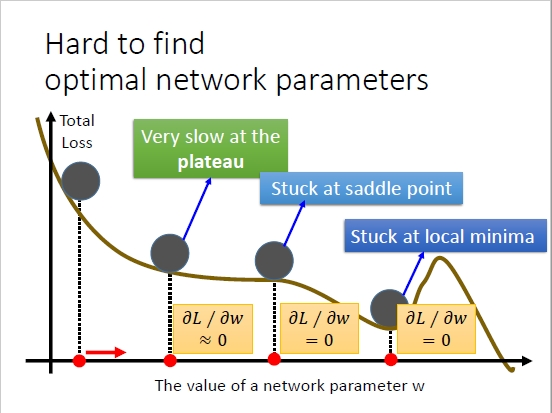

随机梯度下降法(stochastic gradient descent 简写SGD)的缺点,如图所示:

Y轴表示损失函数,X轴表示神经网络的权重参数W。

缺点:有时候梯度下降很慢,有时候W取值处在某个鞍点,有时候W取值在某个谷点而导致损失函数取得局部最小值。