李宏毅-逻辑回归

1、logical 回归与liner 回归的区别

logical 返回值是0到1之间,因为通过了sigmoid函数(函数值0到1)得到的值,具体推导见视频。线性回归返回值可以是任何值

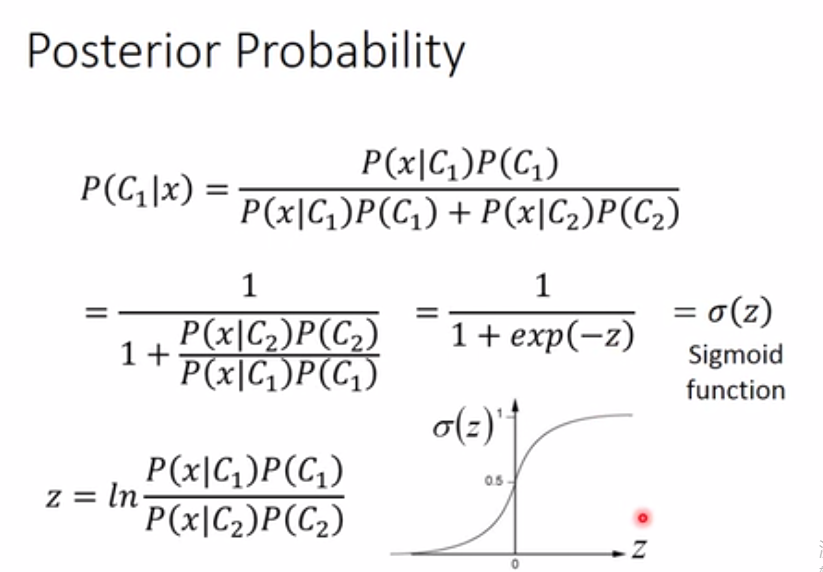

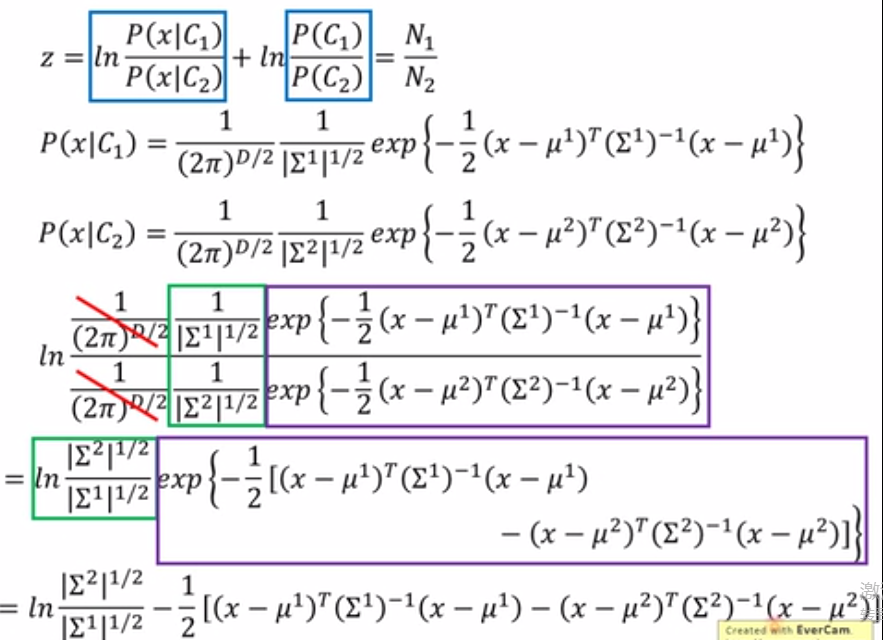

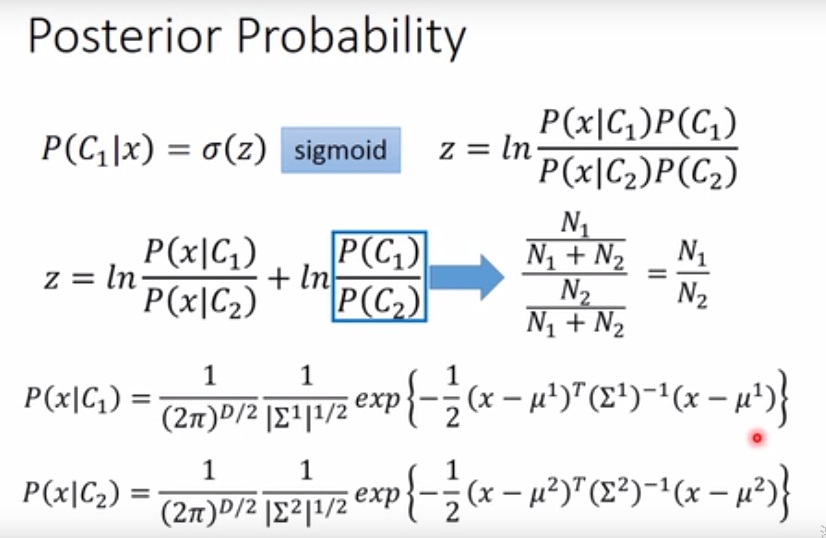

2、逻辑回归推导过程。朴素贝叶斯分类->sigmoid函数->

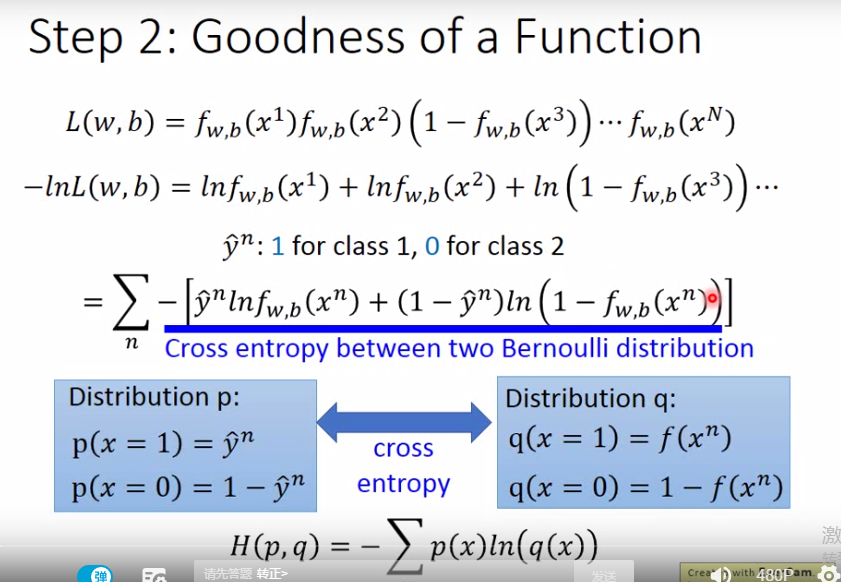

loss function表示成每一个样本分类结果值(Fwb(x)的函数值)其实就是sigmoid函数,将所有样本的函数相乘,我们的目标是求得最大的L(w,b),这是的wb就是我们的最终目标,在上一节classification中提到过,也可以通过穷举w,b得到最大L(w,b)。下面步骤中,将L(w,b)转化为-lnL(w,b),目的是将等号右边连乘转换成加法,简化计算。负号是将求最大L转换成求最小值。交叉熵函数用于评估两个分布函数的近似程度,即真实函数值与预测值之间的相关程度。

步骤1:找一个拟合数据的函数,逻辑回归将wx+b放到sigmoid函数里面,输出0到1的概率。

为什么放到sigmoid函数?

因为sigmoid是从朴素贝叶斯公式,分子分母同时消值得到的,wx+b的形式的由z通过高斯分布函数化简得到的模型。

步骤2:找一个loss function评估模型好坏

交叉熵函数最初模型的是f(x1)*f(x2)*f(x3)...f(xn)。经过取对数值,加负号整理式子,得到。

步骤3:用梯度下降对loss function minimize

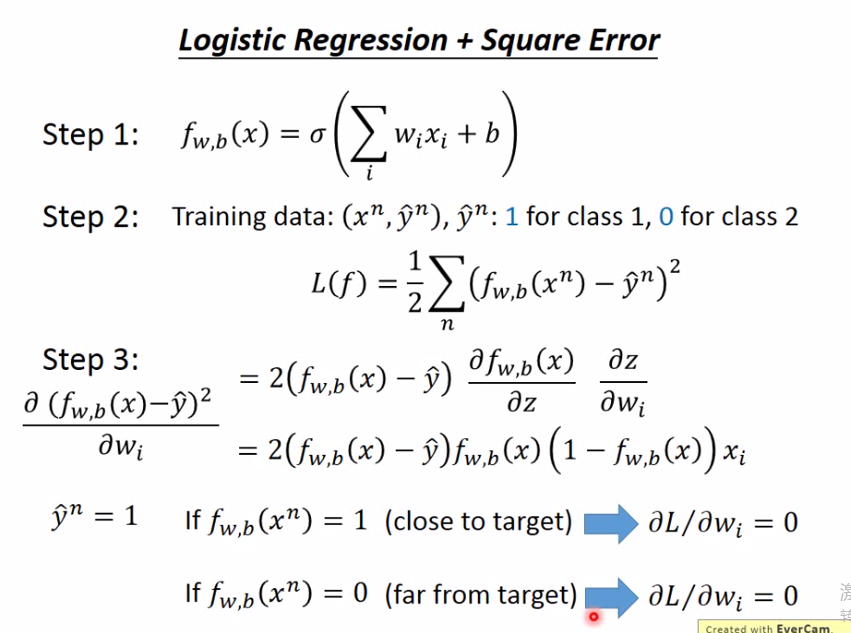

3、 为什么 sigmoid 函数不用均方差?

对w进行偏微分,会出现,当预测值与真实值差距远,loss function也会趋近于0。当初始值离目标值很远的时候,收敛就很慢。

浙公网安备 33010602011771号

浙公网安备 33010602011771号