【论文阅读笔记】Transformer ——《Attention Is All You Need》

论文地址:https://arxiv.org/pdf/1706.03762

模型地址:https://github.com/huggingface/transformers

Introduction

- RNN,LSTM 处理时序信息的局限性:无法并行,部分历史信息会在后面丢弃

- 编码器与解码器结构

- proposed transformer:纯注意力机制

Background

- CNN 替换 RNN:无法对时序信息进行建模——自注意力可以解决;CNN 可以多个输出通道——多头注意力机制

- Memory-Network

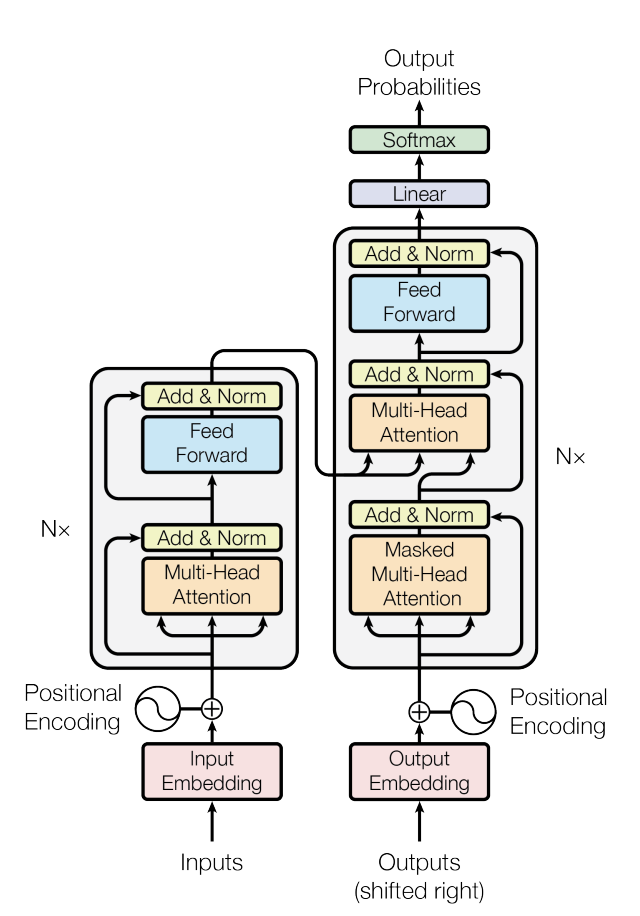

Model Architecture

图 1:Transformer 架构

- Encoder:

- Decoder:

Encoder

2 个子层:

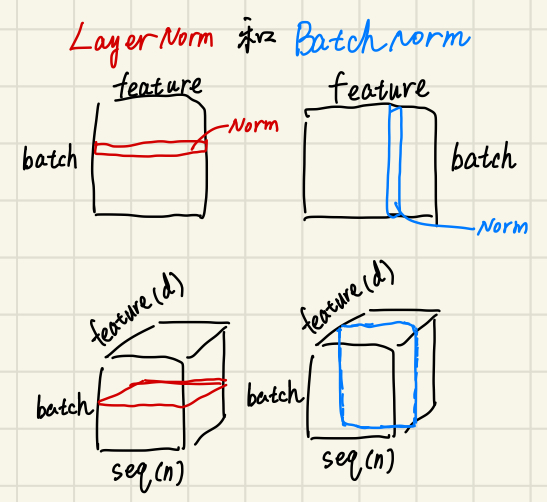

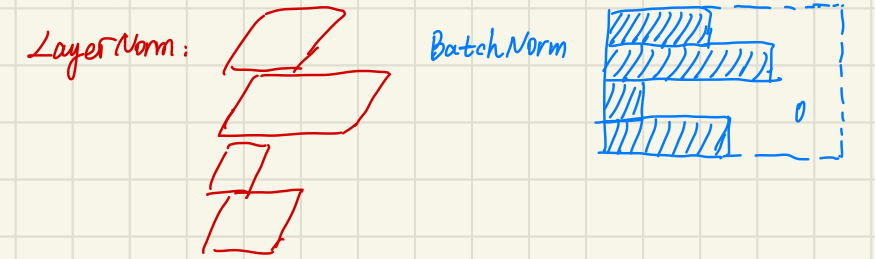

LN and BN

- 如果 feature 长度不同:BN 更加不稳定!

- 预测过程

- BN:要记录全局的

- LN:每个样本内部计算,不受全局影响,受长度影响很小

Decoder

3 个字层:

Attention

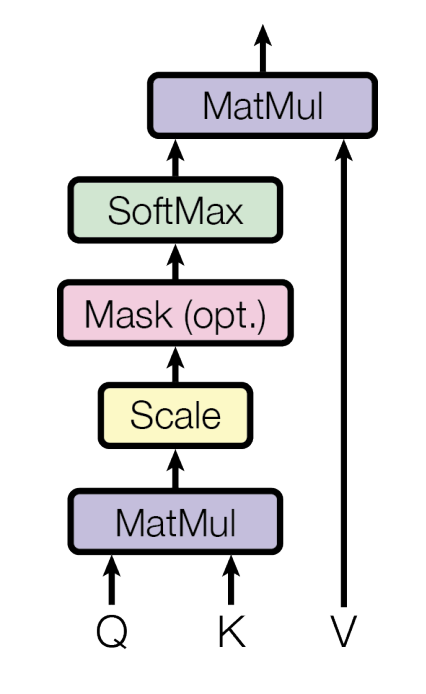

图 2:dot-product attention 结构

其中

为什么是 scaled dot-product attention?

- 因为点乘非常简单,两次矩阵乘法易于并行计算

- 当

Mask 操作

Multi-head Attention

能够学习到不同的投影,不同特征。计算公式如下:

Feed-Forward

Postion Encoding

加入时序信息:

Why self-attention

本文作者:shikean@Tianjin University

本文链接:https://www.cnblogs.com/keanshi/p/18535710

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步