【论文阅读笔记】大模型推理加速 —— FastV

论文地址:https://arxiv.org/pdf/2403.06764

代码地址:https://github.com/pkunlp-icler/FastV

Introduction

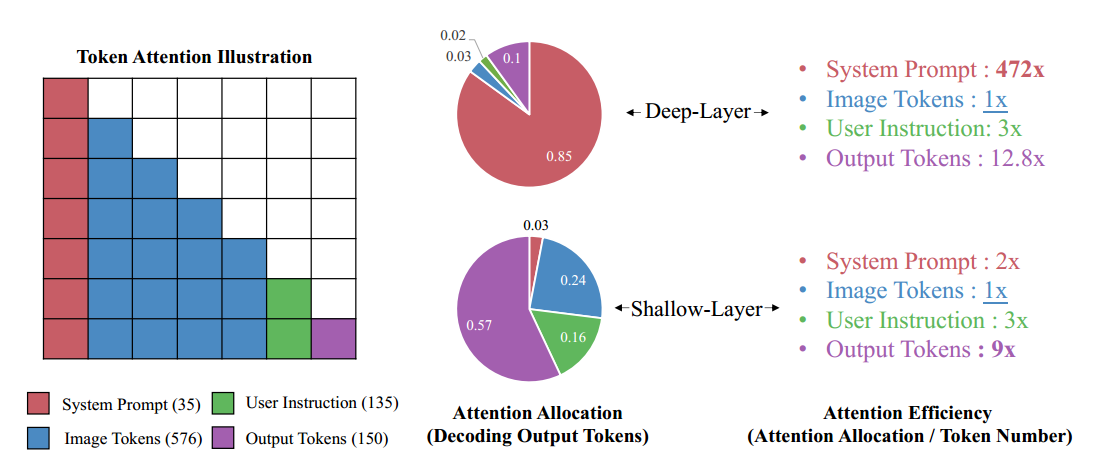

- 现象(问题):大多数 LVLM 在深层的 attention 分数很低;

- 推测:视觉信号的冗余导致在千层会被聚合为 "anchor" token,在深层中,网络更关注这些 "anchor";

- FastV:应用于某一层中,前面的 layer 正常计算,后面的根据 threshold 随机丢弃;

Inefficient Visual Attention in VLLMs

Preliminaries

给定 image-question pair

两种分数

另

结果分析

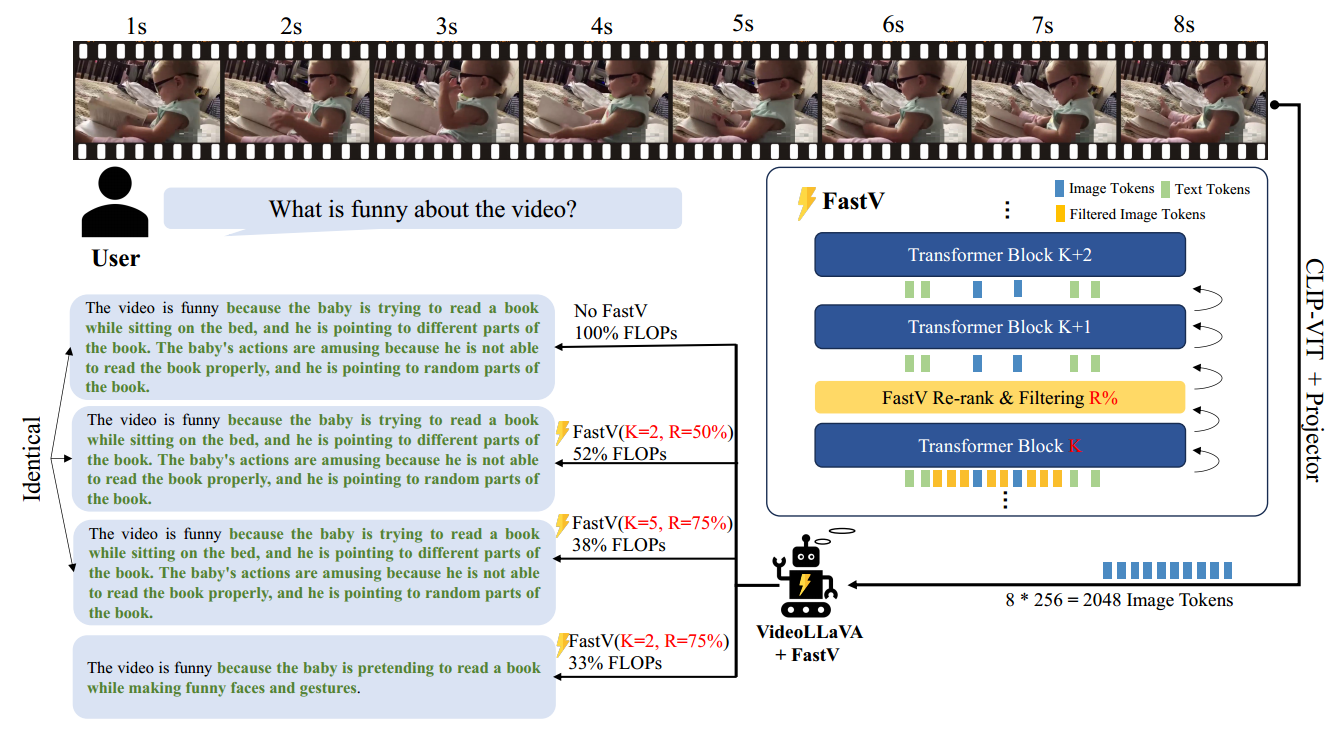

FastV

Overview

Re-rank and Filtering module (core)

在第

Thought

Same as LoRA, so straightforward that everyone can make delevopment based on this. It's a good start for MLLM's inference using plug-and-play module.

本文作者:KeanShi

本文链接:https://www.cnblogs.com/keanshi/p/18489607

版权声明:本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行许可。

分类:

论文阅读笔记

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步