python+scrapy环境搭建步骤描述

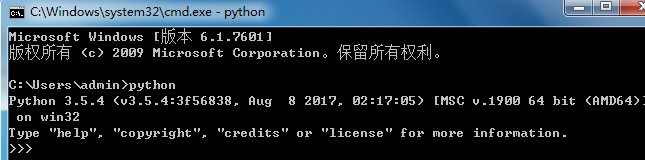

Python3(3.5.4)搭建爬虫系统步骤描述:

1.下载python安装包,路径:https://www.python.org/downloads/windows/ 选择3.5.4版本64位的安装文件,如果不能下载可直接联系我,地址见底。

2.下载安装完成后直接cmd输入python,可正常查看版本,以本人为例:

注:安装过程中请注意一定要请勾选pip安装并加入到环境变量中,否则后续无法正常安装第三方类库。

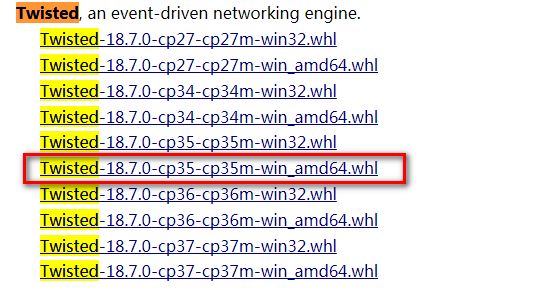

3.安装爬虫框架必须依赖的第三方类库Twisted,在使用pip安装时会出现下载文件失败而无法安装问题,所以我直接下载源文件,然后cmd进入下载文件

目录下是用pip install 下载文件全名 安装即可,下载地址如下: https://www.lfd.uci.edu/~gohlke/pythonlibs/ 搜索Twisted 然后找到跟本地Python版本匹配的whl文件

,比如我本地安装Python3.5.3 64位,name下载的文件就应该选择:

4.安装selenimu 自动化web包,cmd进入任意目录,执行 pip install selenium

5.安装pymysql 连接mysql包,cmd进入任意目录,执行pip install pymysql

6.安装pillow图片处理包, pip install piplow

7.安装pypiwin32 操作底层dll包,pip install pypiwin32

8.安装requests 发送web请求包 pip install requests

9.安装scrapy 爬虫框架包 pip install scrapy

10.安装解析网页内容包 pip install bs4。

11.截止以上十步爬虫所主要依赖第三方类库安装完成,下一步验证爬虫框架。

11.进入cmd,输入scrapy 查看scrapy是否安装成功。

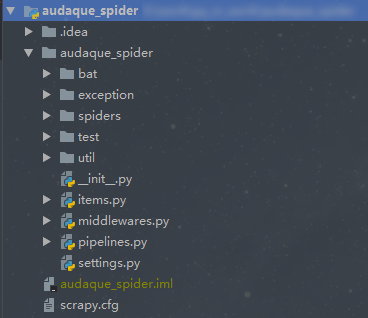

12在cmd中进入任意目录,输入scrapy startproject testproject 创建一个机遇scrapy的爬虫工程,目录结构如下>

13.创建完工程后,可通过scrapy genspider mydomain mydomain.com 命令创建一个名字为mydomain 网站为mydomain.com的爬虫。

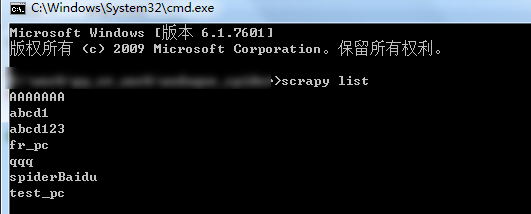

14创建完爬虫后,在工程目录下执行scrapy list 查看刚才创建的爬虫是否成功,如下:

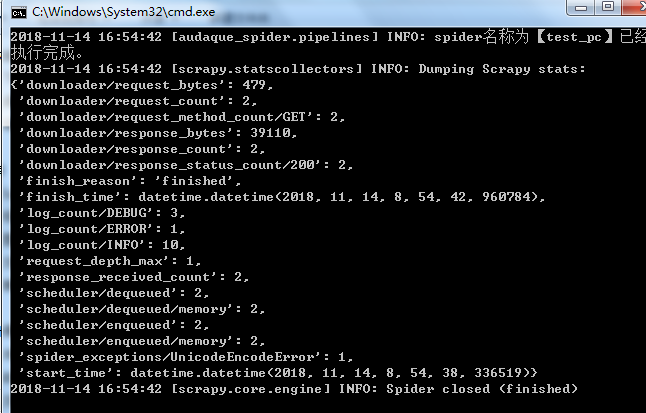

15.不修改爬虫内容,测试爬虫是否正常运行,执行如下命令:

scrapy crawl 爬虫名称(比如我的工程执行 scrapy crawl test_pc)如下:

至此,一个简单的爬虫系统从头到最后运行的过程全部搭建完成。

另:本人微信ma0603kang 邮箱:ma0603kang@163.com,如果有什么问题可以联系我。