激光雷达多模态融合相关

KeyWords: 环境感知,多模态融合

核心参考:

滑铁卢大学的一篇综述论文[1]写的很好

同时也借鉴了国内的论文导读论文导读

Motivation & Review

图像数据与点云存在着巨大的差别

| 图像数据 | 点云 | |

|---|---|---|

| be like |  |

|

| Permutation 排列 | Ordered | Orderless |

| Data Structure | Regular | Irregular |

| Data Type | Discrete 离散的 | Continuous |

| Dimension | 2D | 3D |

| Coordinates 视角 | Projective 投影的 | Euclidean 欧氏几何的 |

| Resolution 空间分辨率 | High | Low |

融合数据的特征/信号表示形式(Feature/Signal Representation)

- 单纯融合:RGB-D不太行,2D场景太受限;点云上加RGB,有分辨率不匹配的问题

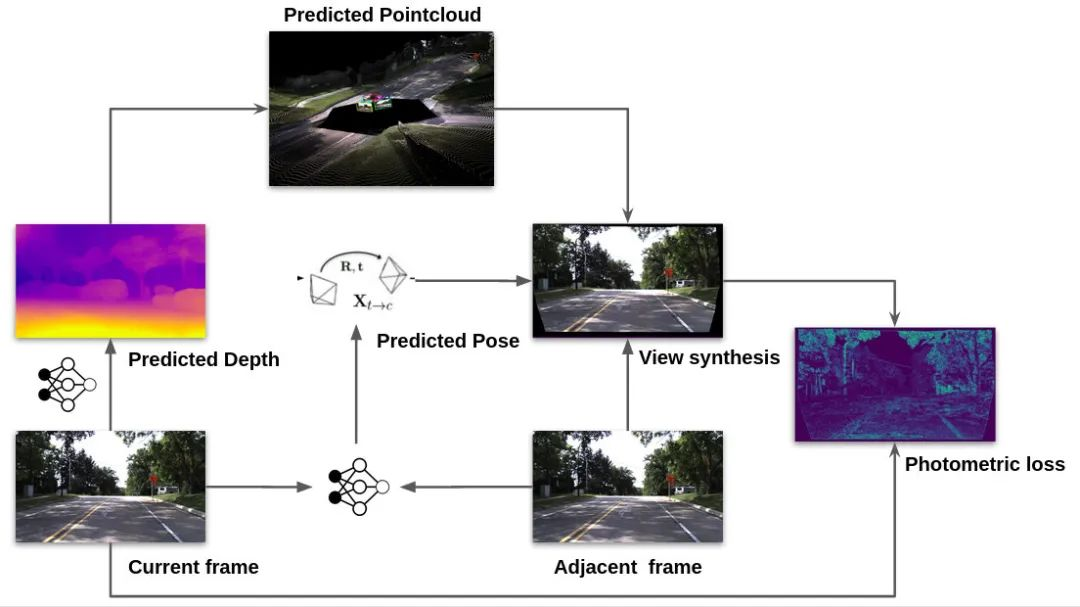

改进:使用深度补全or点云上采样,对相邻连续帧引入自监督,或者进行单目学习,比如自监督模型PackNet

TODO

- 先将两种数据转换为其他数据表现形式:体素化点云(voxelized point cloud)[2]、晶格(lattice)[3]。未来的研究可以探索其他新颖的中间数据结构,例如图(graph)、树(tree)等,从而提高性能。

几何约束 Encoding Geometric Constraint

时间上下文Encoding Temporal Context

神经网络搜索结构( NASNet[4])

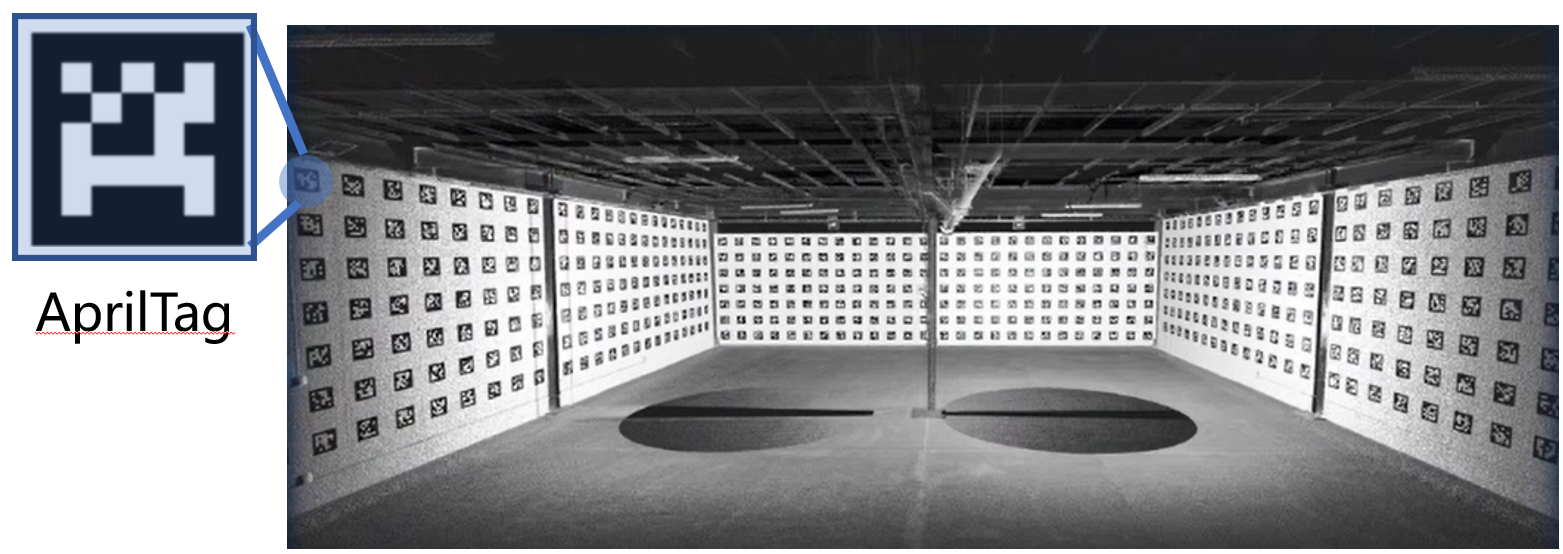

传感器类型与标定

| 类型 | 内容 | 方式 | 备注 |

|---|---|---|---|

| Lidar内参标定 | 不同路的激光探头的相对角度 | 未知 | 厂商给的参数未必一定对 |

| Lidar-to-GPS外参标定 | Lidar的原点与GPS有个平移 | 在室外开8字开几圈 | |

| Lidar-to-Lidar外参标定 | R,T,放缩 | (Iterative Closest Point,ICP)迭代最近点算法 | 详情见博客 |

| Lidar-to-Camera外参标定 | 两个有个RT | 具体算法见博客-Lidar-Camera 联合标定算法 | |

| Camera-to-Camera外参标定 | 外参标定 | 室内场景会使用标定间进行标定 | 标定间一般使用高精度的地标雷达进行扫描 |

| 自然场景中 Lidar-to-Camera外参标定 | 外参标定 | 利用标志物,如交通牌的锐利边缘(点云有很大的depth变化) | |

| 自然场景中 Bifocal cameras外参标定 | 内外参验证 | 把两个部分的图片进行变换重叠,观察是否具有重影 | 厂商给的参数未必一定对 |

| Camera-to-Radar外参标定 | t与pitch角标定 | 测量相机pitch角度与t | radar一定是水平的,而camera不一定 |

外参自校准

在实际应用中因为震动等原因,出厂的标定数据可能会有微小的偏差,因此需要进行自校准。自校准目前有两种解决方案,运动引导[5]和无目标[6]

TODO 有机会学习一下

时间同步

晶振时间戳(基本完备),不过经常还是会出现时间差,是一个工程上较为常见的小bug,但是会导致严重的融合问题。

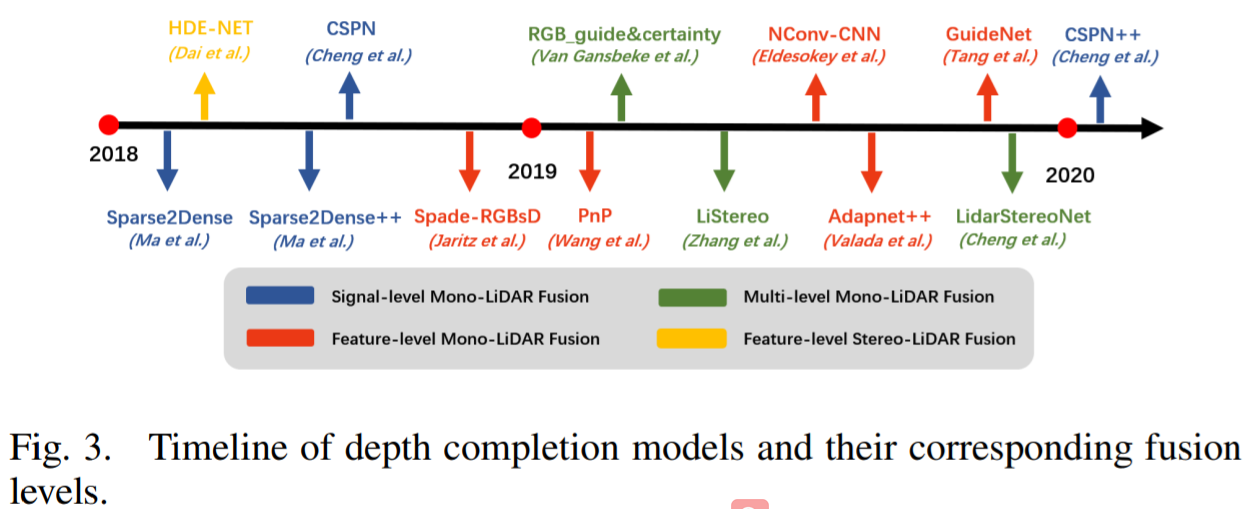

深度补全

激光点云具有稀疏性,进行上采样

同甘融合来引导上采样

encoder-decoder结构

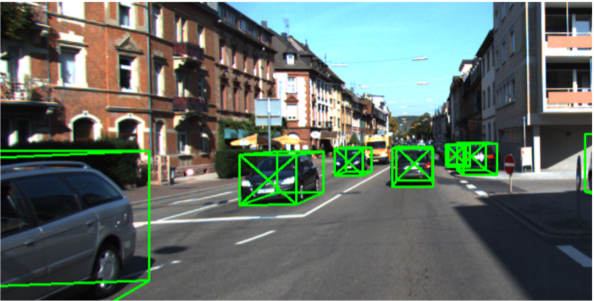

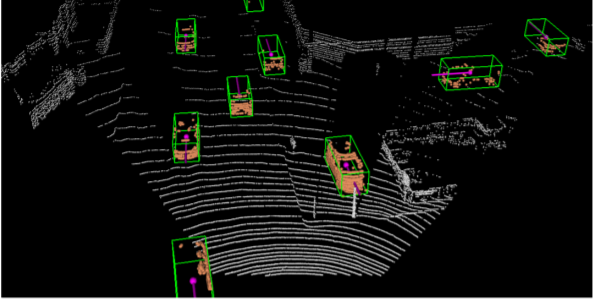

3D-object Det(经典1)

核心参考:知乎专栏-自动驾驶环境感知-激光雷达:3D物体检测算法

LiDAR的优势:能够非常精确的测量物体在3D空间中的位置和形状,性能远超Camera和Rader

Multi-view

Voxel

Point

Point + Voxel

基本概念

- 输入:\((x,y,z,R)\) 其中R为反射强度

- 输出:3D BBox(BoundingBox): \((x_0,y_0,z_0,h,w,l, \theta),\ \theta\)为3D旋转角度

- Det结果的评价

3D IoU(Intersection over Unoin), 也即两个3D框(GT(Ground Truth) & Det(Detecion)) 重合部分的比例,设定阈值,超过即为TP,反之即为FN。如果凭空出框就是FP。

根据TP,FN,FP的相关比例能够得到一个综合的评价指标

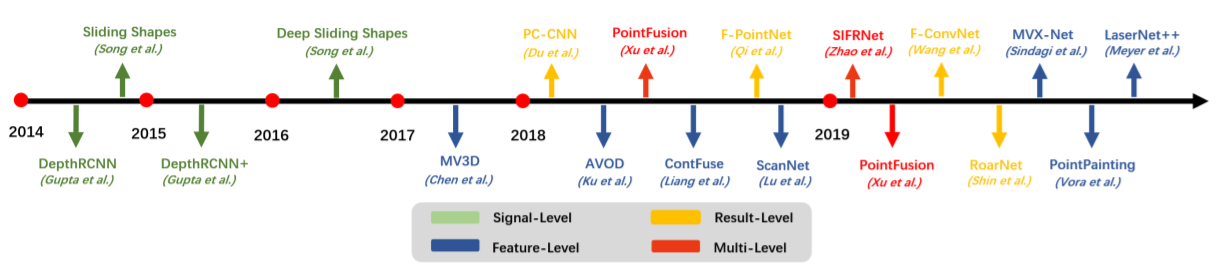

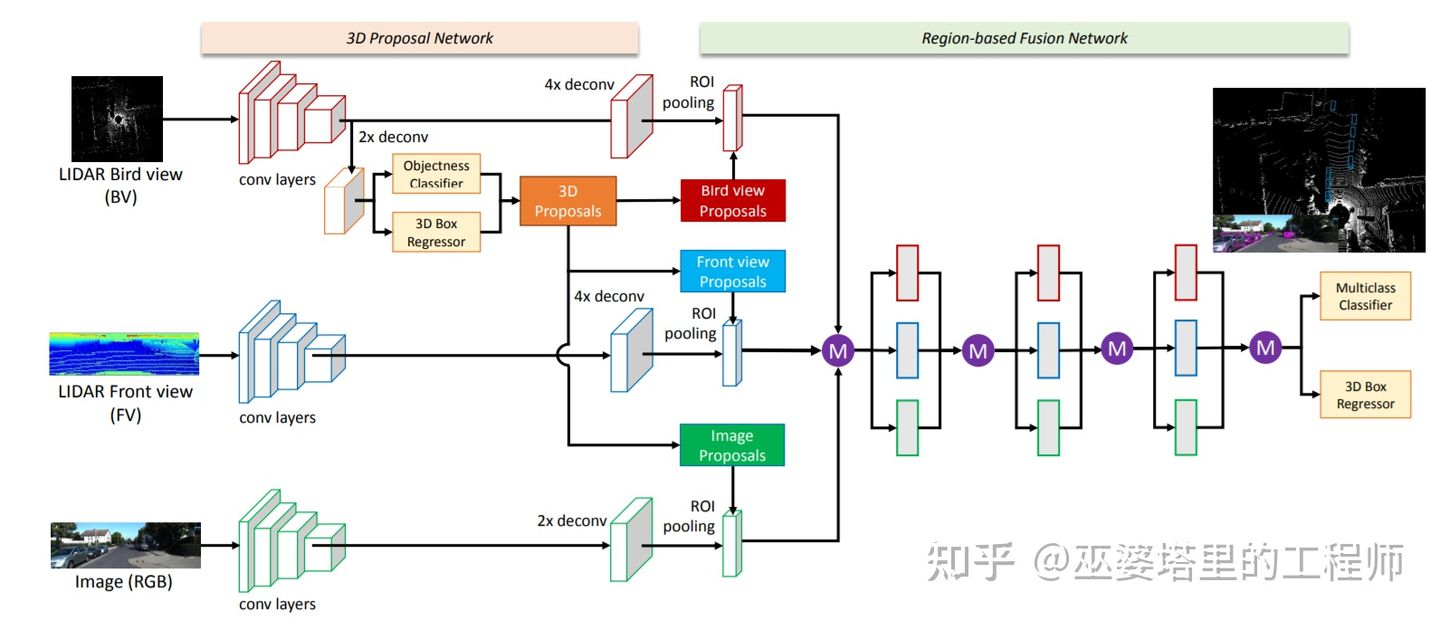

编年史

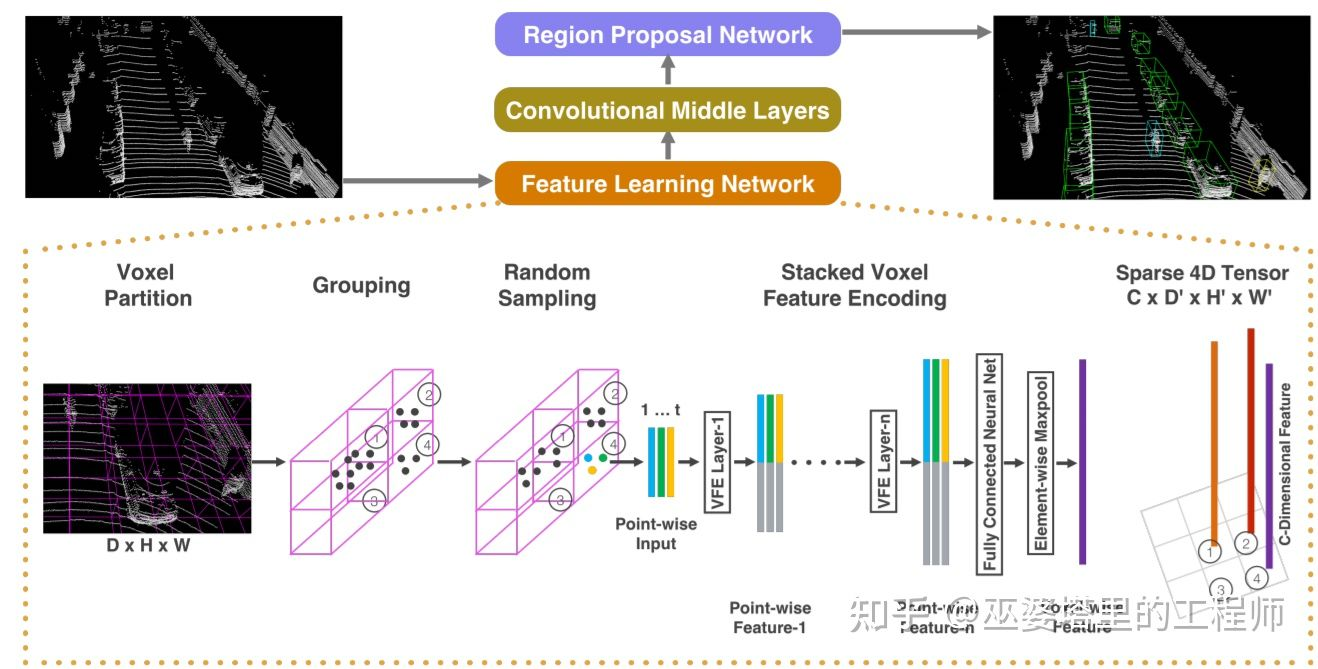

### 萌芽期 Det相关的算法最早都起步于CV领域,CV领域经典算法层出不穷,出现了R-CNN,Faster R-CNN,YOLO,以及衍生出许多当前SOTA的CenterNet #### VeloFCN^[Qian et al., 3D Object Detection for Autonomous Driving: A Survey, 2021] 将3D点云转换到正视图(Front View)再套用图像det,不过因为造成了信息缺失,丢失了深度信息,效果很差 #### MV3D^[Chen, et al., Multi-view 3d object detection network for autonomous driving, CVPR, 2017] 17年的MV3D增加了一个新的视角:鸟瞰图 BEV(Bird's Eye View),加上VeloFCN的正视图,与2D数据进行融合,一同进行检测(R-CNN)  ### 起步期 2017年 #### VoxelNet^[Zhou and Tuzel, Voxelnet: End-to-end learning for point cloud based 3d object detection, CVPR, 2018.] CVPR 2018的一篇文章,作者是苹果公司的两位研究员。 步骤: 1. Grouping: 将点云量化到一个均匀的3D网格中 2. Random Sampling: 每个网格中随机采样固定数量的点(不足就重复),输入点坐标为 $(x,y,z,R,\Delta X,\Delta Y,\Delta Z)$ 3. Stacked Voxel Feature Encoding: 全连接层被用来提取点的特征,然后每个点的特征再与网格内所有点的特征均值进行拼接,得到新的点特征。这种特征的优点在于同时保留了单个点的特性和该点周围一个局部小区域(网格)的特性。这个点特征提取的过程可以重复多次,以增强特征的描述能力 4. 最终网格内的所有点进行最大池化操作(Max Pooling),以得到一个固定长度的特征向量 5. 输出为4D Tensor,$(x,y,z,f)$,f为feature map。为了套用3D的检测算法,本文使用多次3D卷积压缩z维度的大小至2: $(H\times W \times 2 \times C')$,然后将最后连个维度合并$(H\times W \times 2C')$。然后使用RPN(Region Proposal Network)进行 3D BBox 生成。 从上面的介绍可以看出,VoxelNet的框架非常简洁,也是第一个可以真正进行端对端的学习的点云物体检测网络。实验结果表明,这种端对端的方式可以自动地从点云中学习到可用的信息,比手工设计特征的方式更为高效  #### PointNet++^[Qi et al., Pointnet++: Deep hierarchical feature learning on point sets in a metric space, NeurIPS, 2017.]2D、3D语义分割(经典2)、实例分割

SOT(Single-Object Tracking), MOT(Multi-Object Tracking)

Track-by-Detection

TODO

One shot modle

TODO

1. 具体应用

深度补全

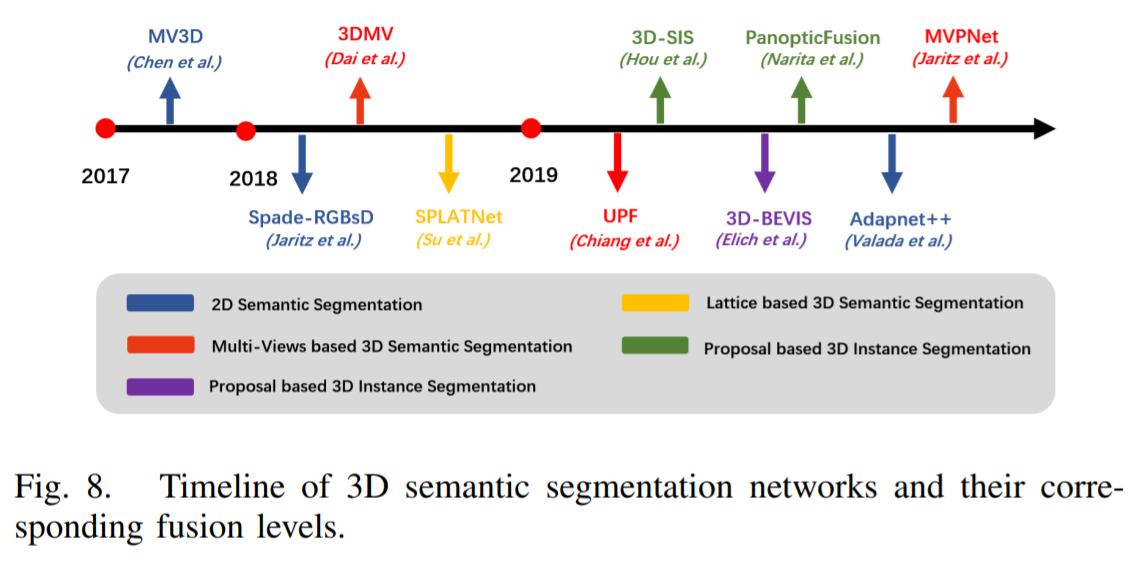

语义分割

目标检测及跟踪

特种场景

???真的能做得更好

找找应用场景!

未来趋势

2D——3D

单任务——多任务

信号级——多级融合

早期融合

晚期融合

时间上下文

融合策略

决策层融合

决策+特征层融合

用一种数据生成Proposal,再将proposal与另一种数据结合生成Det结果。结合的方式就是将proposal与另一种data统一到相同的坐标系下

F-PointNet[7]

由图像数据生成2D物体候选框,然后将这些候选框投影到3D空间。每个2D候选框在3D空间对应一个视椎体(Frustum),并将落到视椎体中所有点合并起来作为该候选框的特征。视椎体中的点可能来自前景的遮挡物体或者背景物体,所以需要进行3D实例分割来去除这些干扰,只保留物体上的点,用来进行后续的物体框估计(类似PointNet中的处理方式)。这种基于视椎的方法,其缺点在于每个视椎中只能处理一个要检测的物体,这对于拥挤的场景和小目标(比如行人)来说是不能满足要求的。

IPOD[8]

IPOD提出采用2D语义分割来替换2D物体检测。首先,图像上的语义分割结果被用来去除点云中的背景点,这是通过将点云投影到2D图像空间来完成的。接下来,在每个前景点处生成候选物体框,并采用NMS去除重叠的候选框,最后每帧点云大约保留500个候选框。同时,PointNet++网格被用来进行点特征提取。有了候选框和点特征,最后一步采用一个小规模的PointNet++来预测类别和准确的物体框(当然这里也可以用别的网络,比如MLP)。IPOD在语义分割的基础上生成了稠密的候选物体框,因此在含有大量物体和互相遮挡的场景中效果比较好。

上面两个方法分别通过2D图像上的物体检测和语义分割结果来生成候选框,然后只在点云数据上进行后续的处理。

SIFRNet[9]

提出在视椎体上融合点云和图像特征,以增强视椎体所包含的信息量,用来进一步提高物体框预测的质量。

特征层融合

参考文献

[5] Chen et.al., Multi-View 3D Object Detection Network for Autonomous Driving, 2016.

[6] Ku et.al., Joint 3D Proposal Generation and Object Detection from View Aggregation, 2017.

[7] Liang et.al., Deep Continuous Fusion for Multi-Sensor 3D Object Detection, 2018.

[8] Vora et.al., PointPainting: Sequential Fusion for 3D Object Detection, 2019.

[9] Sindagi et.al., MVX-Net: Multimodal VoxelNet for 3D Object Detection, 2019.、、、

Cui et.al., Deep Learning for Image and Point Cloud Fusion in Autonomous Driving: A Review, 2020. arXiv ↩︎

S. Gupta, R. Girshick, P. Arbelez, and J. Malik, “Learning rich features from rgb-d images for object detection and segmentation,” Lecture Notes in Computer Science, p. 345360, 2014. [Available](http://dx.doi.org/10.1007/978-3-319-10584-0 23) ↩︎

X. Lv, Z. Liu, J. Xin, and N. Zheng, “A novel approach for detecting road based on two-stream fusion fully convolutional network,” in 2018 IEEE Intelligent Vehicles Symposium (IV), 2018, pp. 1464–1469. ↩︎

Y. Xing, C. Lv, L. Chen, H. Wang, H. Wang, D. Cao, E. Velenis,and F.-Y. Wang, “Advances in vision-based lane detection: algorithms,integration, assessment, and perspectives on acp-based parallel vision,”IEEE/CAA Journal of Automatica Sinica, vol. 5, no. 3, pp. 645–661,2018. ↩︎

A. S. Huang, D. Moore, M. Antone, E. Olson, and S. Teller, “Findingmultiple lanes in urban road networks with vision and lidar,” Au-tonomous Robots, vol. 26, no. 2-3, pp. 103–122, 2009. ↩︎

P . Y . Shinzato, D. F. Wolf, and C. Stiller, “Road terrain detection:Avoiding common obstacle detection assumptions using sensor fusion,”in 2014 IEEE Intelligent V ehicles Symposium Proceedings, 2014, pp.687–692. ↩︎

Qi et.al., Frustum Pointnets for 3d Object Detection from RGB-D Data, 2018. ↩︎

Yang et.al., IPOD: Intensive Point-based Object Detector for Point Cloud, 2018. ↩︎

Zhao et.al., 3D Object Detection Using Scale Invariant and Feature Re-weighting Networks, 2019. ↩︎

浙公网安备 33010602011771号

浙公网安备 33010602011771号