KBQA调研——Improving Multi-hop Knowledge Base Question Answering by Learning Intermediate Supervision Signals

相较于EmbedKGQA的改变:

疑问:这里和EmbedKGQA并没有区别,怀疑用的源代码的复现文章。

一篇封闭域的KBQA模型——Key Value-Memory networks (KV-MemNN):

在特定领域的多数据来源——KB或者文章来进行答案的推理

模型首先获得与问句相关的所有的三元组,将topic entity+关系 作为Key

尾实体作为Value

Key强调,模型通过点积运算为每个记忆单元分配一个归一化的相关权重,作为问题(question)与记忆单元中每个Key表示之间的相关概率;

Value读取,模型通过取所有value和相关权重的加权和来读取所有寻址存储器的值,并使用输出表示中间推理结果,然后用于更新问题(question)表示。

idea:可以使用问题找到与问题相关的子图的方式来得到question的另外一种表示

这样送入模型的是(1)question->RoBERTa->h (2)topic entity of question (3)question->sub Graph ->low dimension

注意除了上述构造问题子图的方式之外还可以使用PullNet(对GRAFT-NET的改进)来进行,其中“Pull”分类器受到弱监督,仅使用 QA 对进行监督。 它首先通过 GRAFT-Net 选择种子实体节点,并在每个迭代步骤中选择一个新颖的分类模型。 然后,通过多次预定义的操作迭代,将越来越多的额外有价值的实体和句子引入当前图中,最终答案可以通过与 GRAFT-Net Haitian 等人相同的程序确定。 (2018 年)。 实验上,PullNet 比 Haitian 等人的现有最先进方法显着提高。

经典的IR解决方案:

基于表示学习 IR 的方法将问题和相关实体转换为相同维度空间中的分布式向量表示,并将 KGQA 任务视为问题的分布式表示与候选答案之间的语义匹配 Bin et al。

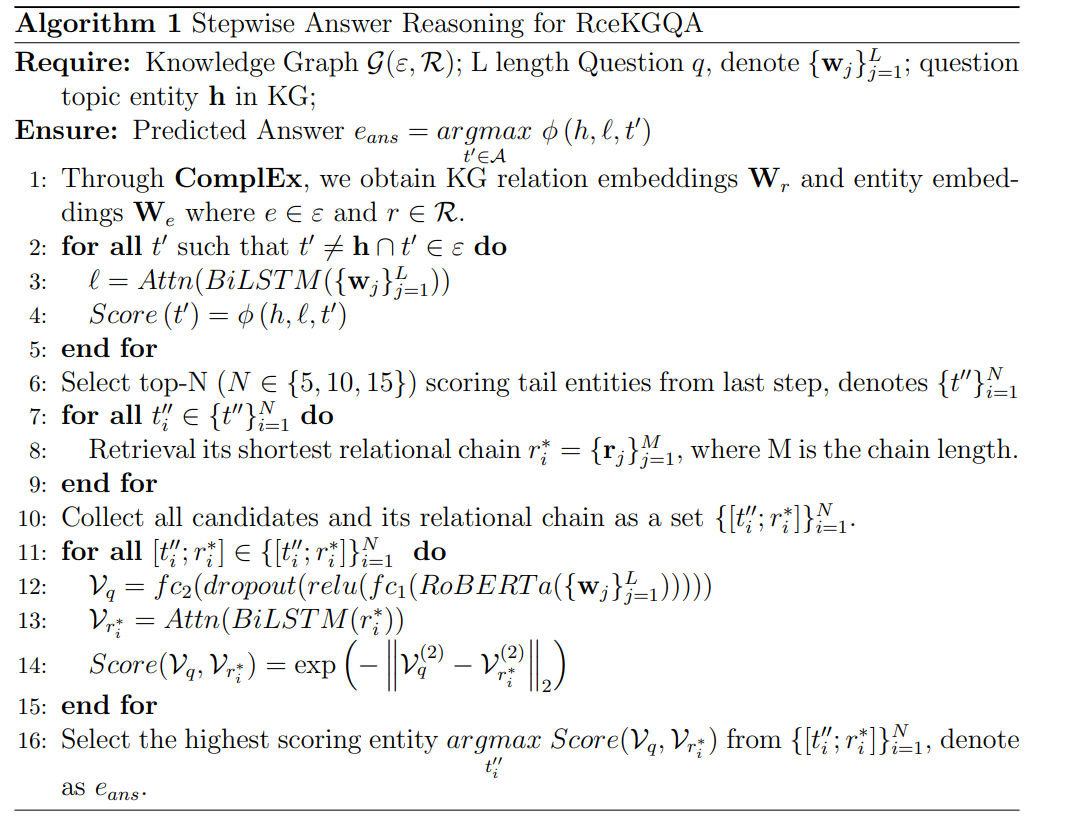

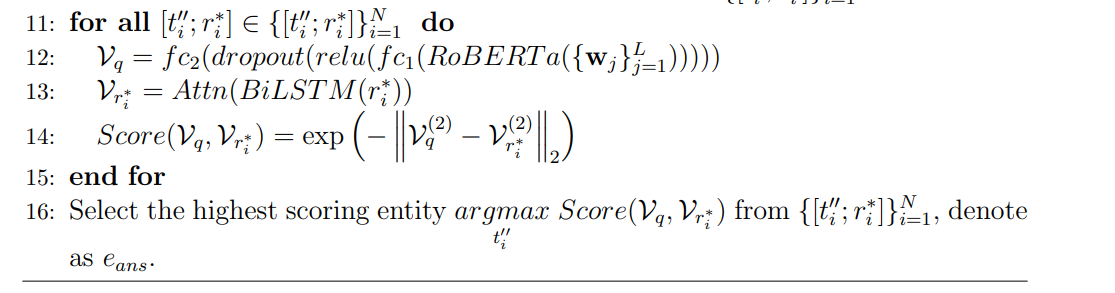

,注意本篇文章的算法是:

改进点是:

没涉及到问题表示的部分!!

负样本的个数: