[大数据学习研究] 错误排查,Hadoop集群部分DataNode不能启动

错误现象

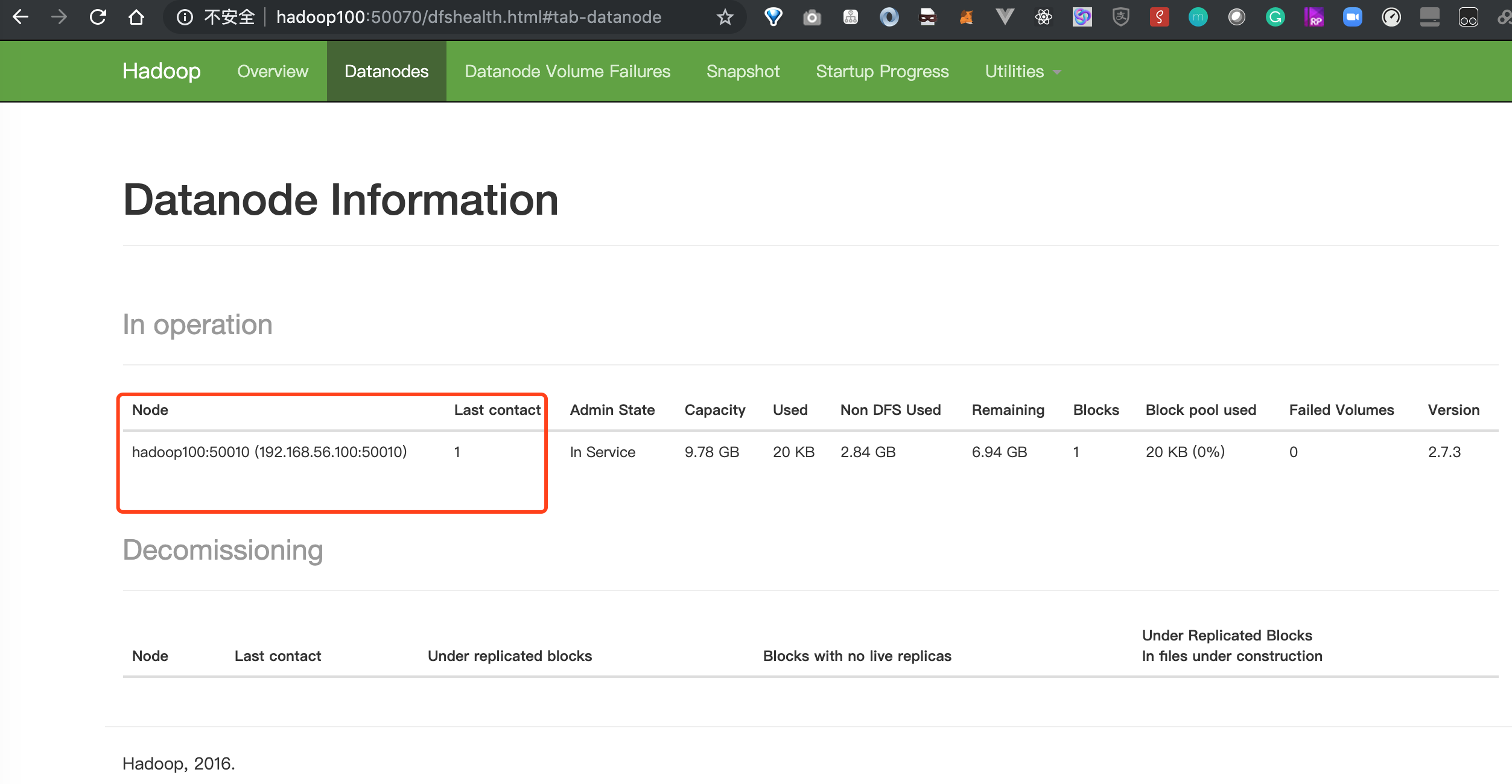

不知道什么原因,今天发现我的hadoop集群启动后datanode只有一台了,我的集群本来有三台的,怎么只剩一台了呢?

用jps命令检查一下,发现果然有两台机器的DataNode没有启动。

可能原因:

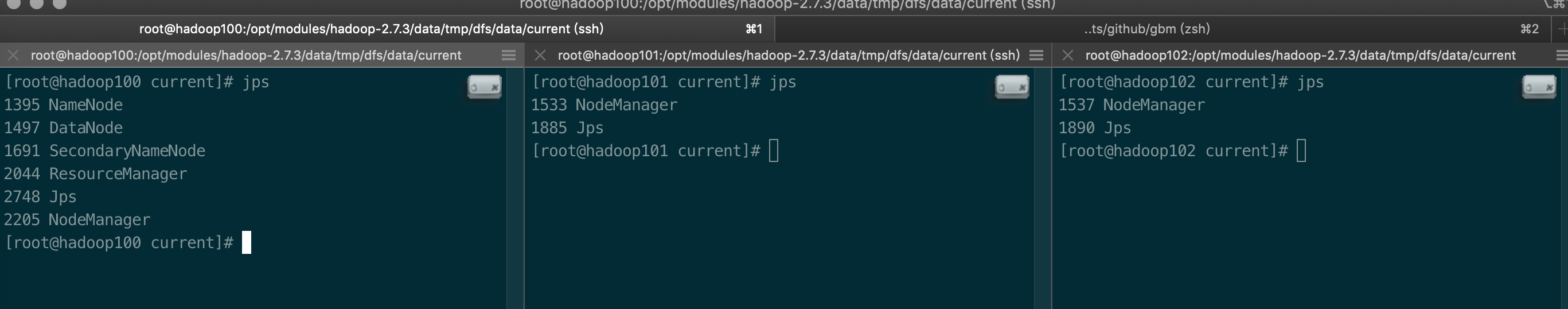

1. 我之前遇到过的问题,由于多次运行hdfs namenode -format, 造成了clusterId不一致,检查一下:进入到/opt/modules/hadoop-2.7.3/data/tmp/dfs/data/current目录下,cat显示一下VERSION文件的内容,检查集群中的几台机器的ClusterID是不是一致。我的机器这三台机器的clusterid是一致的,看起来没问题。如果要是不一致的话,需要改过来,改成一致的,然后用 hadoop-daemon.sh start datanode 就可以启动datanode了,我的不是这个问题引起的,还得继续排查。

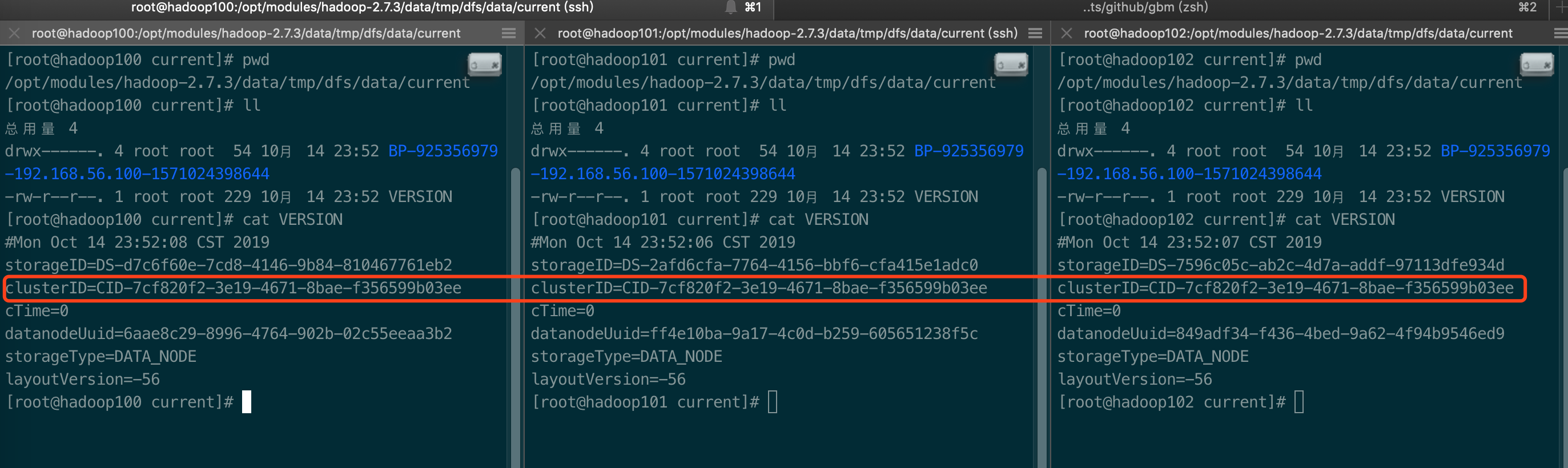

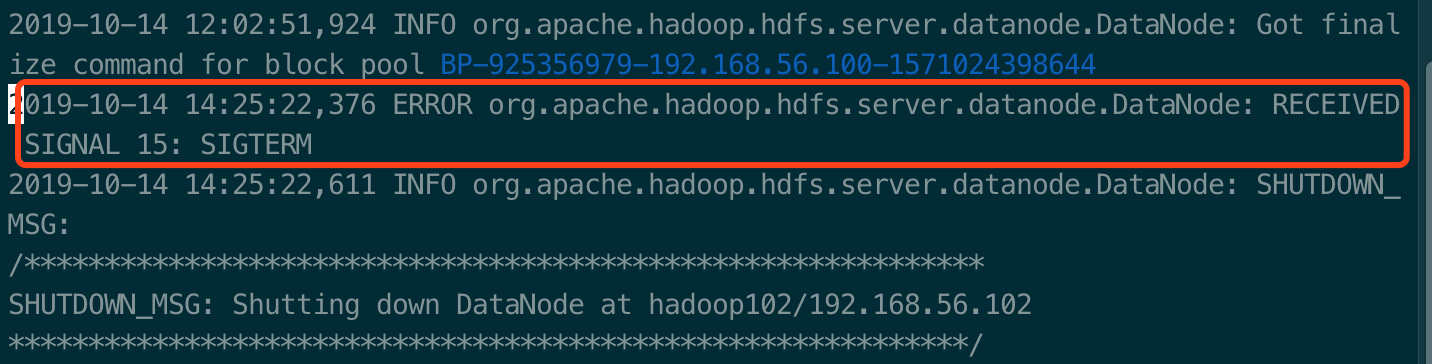

2. 不知道什么原因,还是看看日志,进入的出问题的机器上的logs目录下,打开日志文件,跳到最后,从后面往前看,终于在一堆INFO里面看到一条ERROR:

[root@hadoop101 logs]# pwd

/opt/modules/hadoop-2.7.3/logs

[root@hadoop101 logs]# vi hadoop-root-datanode-hadoop101.log

2019-10-14 14:25:22,376 ERROR org.apache.hadoop.hdfs.server.datanode.DataNode: RECEIVED SIGNAL 15: SIGTERM

解决问题

什么原因引起的不清楚,放狗搜了一下,有人说重启服务就好了,当然还是要试一下这个重启大法。关闭服务,再重启一下相关服务,就解决了,好没趣。

stop-all.sh 等带完成 start-dfs.sh start-yarn.sh

另外,这个帖子里说调用一下hadoop dfsadmin -refreshNodes就好了,但我没用上,反正先重启就搞定了,要还有下次的话再试试吧。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 提示词工程——AI应用必不可少的技术

· Open-Sora 2.0 重磅开源!

· 字符编码:从基础到乱码解决

2012-10-15 Failed to add FS to collection at ResourceService.SetResource in Map 3D 2013

2010-10-15 To install 64-bit ODBC drivers

2009-10-15 Autodesk 2011系列新产品DevDay将于12月在北京/上海举行