hadoop伪态式分布

hadoop伪态式分布

准备工作

1、关闭防火墙

service iptables stop systemctl disable firewalld.service

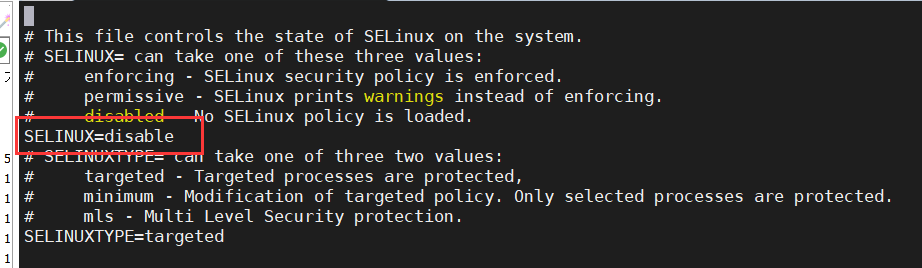

2、修改SELinux安全策略

vi /etc/selinux/config

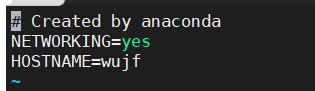

3、添加机器名称

vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=wujf

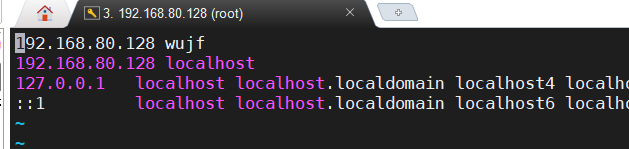

4、修改本地host文件(IP地址为虚拟机的地址)

vi /etc/hosts

JDK配置

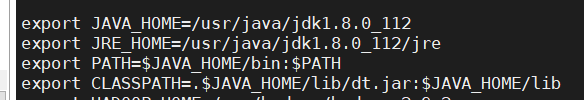

1、使用以下命令进入环境变量配置文件,配置环境变量

vi /etc/profile

2、在文件底部添加环境变量,保存并退出

export JAVA_HOME=/usr/java/jdk1.8.0_112

export JRE_HOME=/usr/java/jdk1.8.0_112/jre

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib

3、更新配置(语句①)并查询JDK是可以运行(语句②)

source /etc/profil

java

hadoop安装

1、在usr下创建文件夹hadoop

cd /usrmkdir hadoop

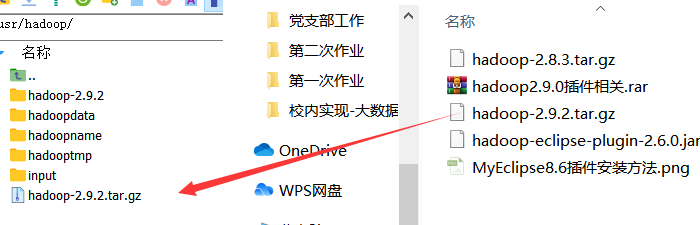

2、通过MobaXterm将Hadoop安装包拉入文件夹

3、解压文件

tar -zxvf hadoop-2.9.2.tar.gz

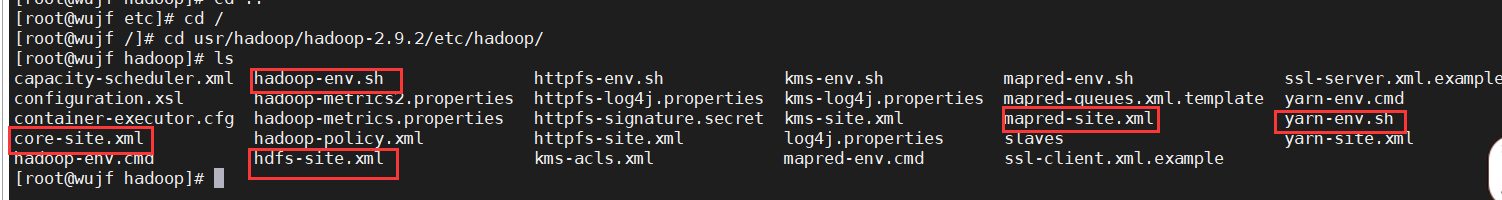

4、进入解压出的文件,准备配置

cd /hadoop-2.9.2/etc/hadoop

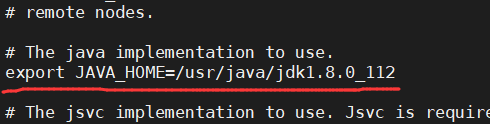

5、修改hadoop-env.sh文件

vi hadoop-env.sh

在指定位置添加语句(自己安装的JDK路径)

export JAVA_HOME=/usr/java/jdk1.8.0_112

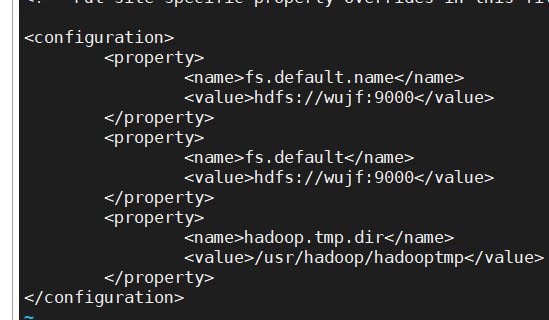

6、修改core-site.xml文件

vi core-site.xml

在

<property> <name>fs.default.name</name> <value>hdfs://wujf:9000</value></property><property> <name>fs.default</name> <value>hdfs://wujf:9000</value></property><property> <name>hadoop.tmp.dir</name> <value>/usr/hadoop/hadooptmp</value></property>

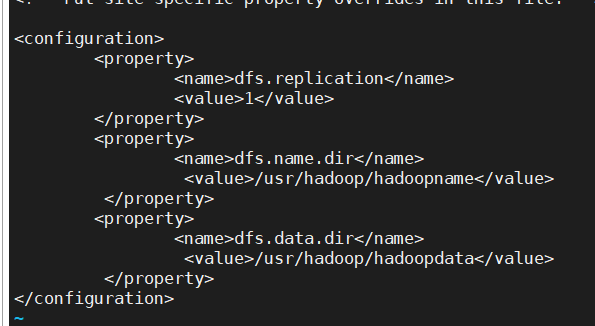

7、修改hdfs-site.xml文件

vi hdfs-site.xml

在

<property> <name>dfs.replication</name> <value>1</value></property><property> <name>dfs.name.dir</name> <value>/usr/hadoop/hadoopname</value></property><property> <name>dfs.data.dir</name> <value>/usr/hadoop/hadoopdata</value></property>

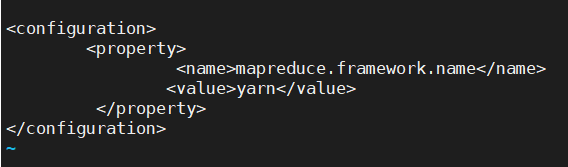

8、先移动文件(语句①),在进行修改mapred-site.xml.template文件语句②

mv mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

在

<property> <name>mapreduce.framework.name</name> <value>yarn</value></property>

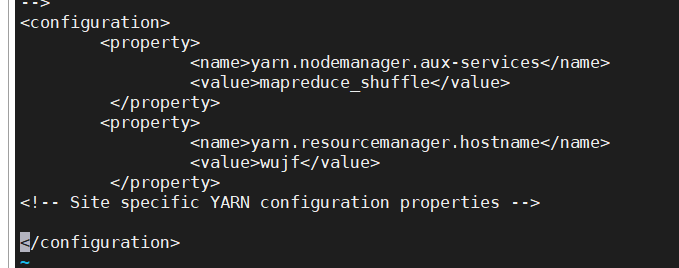

9、修改yarn-site.xml文件

vi yarn-site.xml

在

<property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value></property><property> <name>yarn.resourcemanager.hostname</name> <value>wujf</value></property>

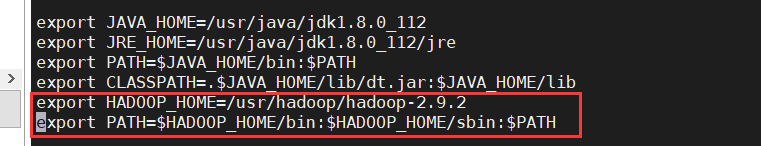

10、将hadoop的安装路径添加到环境变量中

vi /etc/profile

在文件末尾添加一下语句(注意路径)

export HADOOP_HOME=/usr/hadoop/hadoop-2.9.2export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

11、添加成功后更新配置

source /etc/profile

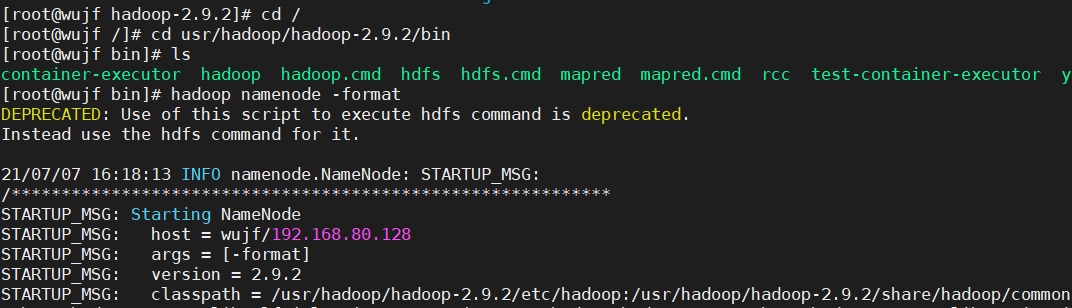

12、更新配置后进入hadoop的bin目录下进行格式化

cd usr/hadoop/hadoop-2.9.2/binhadoop namenode -format

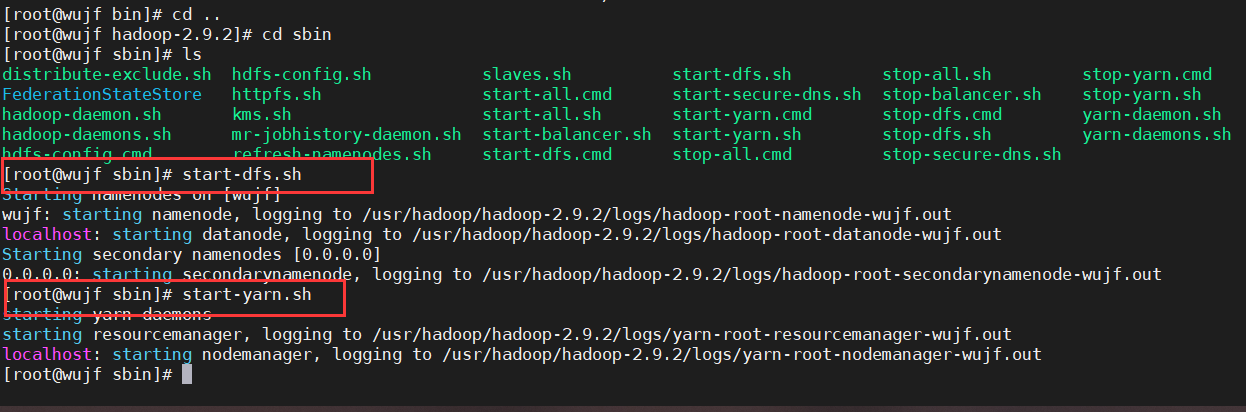

13、进入hadoop的sbin目录下,启动hadoop(需要启动两个文件,先①再②),根据提示输入密码(密码为虚拟机密码)

start-dfs.shstart-yarn.sh

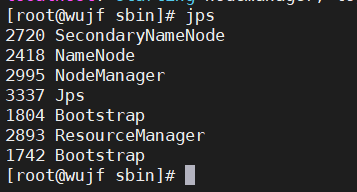

14、查看JPS进程

jps

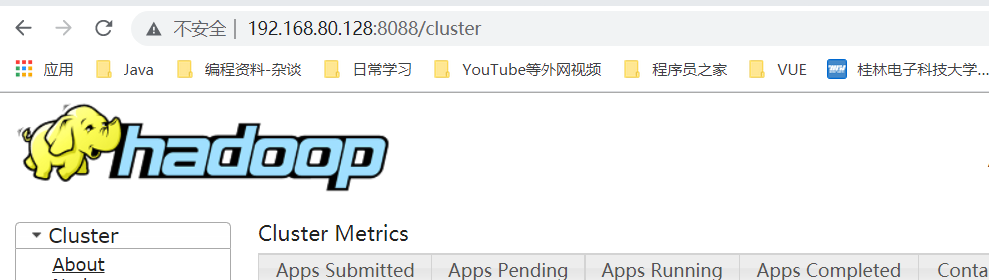

15、安装成功,可以访问50070端口和8088端口

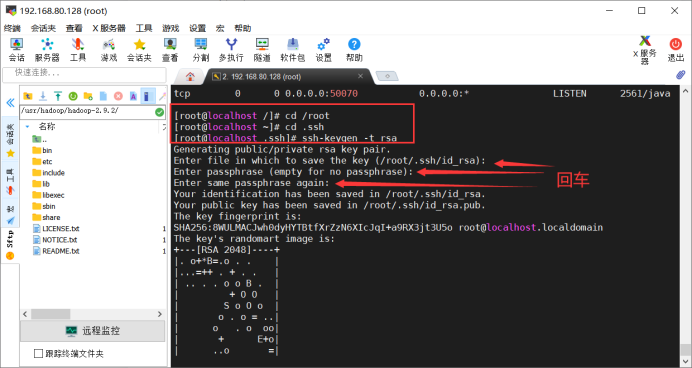

16、配置本地免秘钥登录

cd /rootcd .sshssh-keygen -t rsa

17、测试登录

cat id_rsa.pub >> authorized_keysssh wujf

18、测试启动(语句①)、关闭(语句②)

start-all.shstop-all.sh

浙公网安备 33010602011771号

浙公网安备 33010602011771号