HDFS的常用操作命令

HDFS的常用操作命令

提示

如果使用JPS查询发现没有DATANODE,则将本地目录中的hadoop文件中的Hadoopdata删除

删除后格式化hadoop

hadoop namenode -format

重新启动hadoop

start-all.sh

操作指令

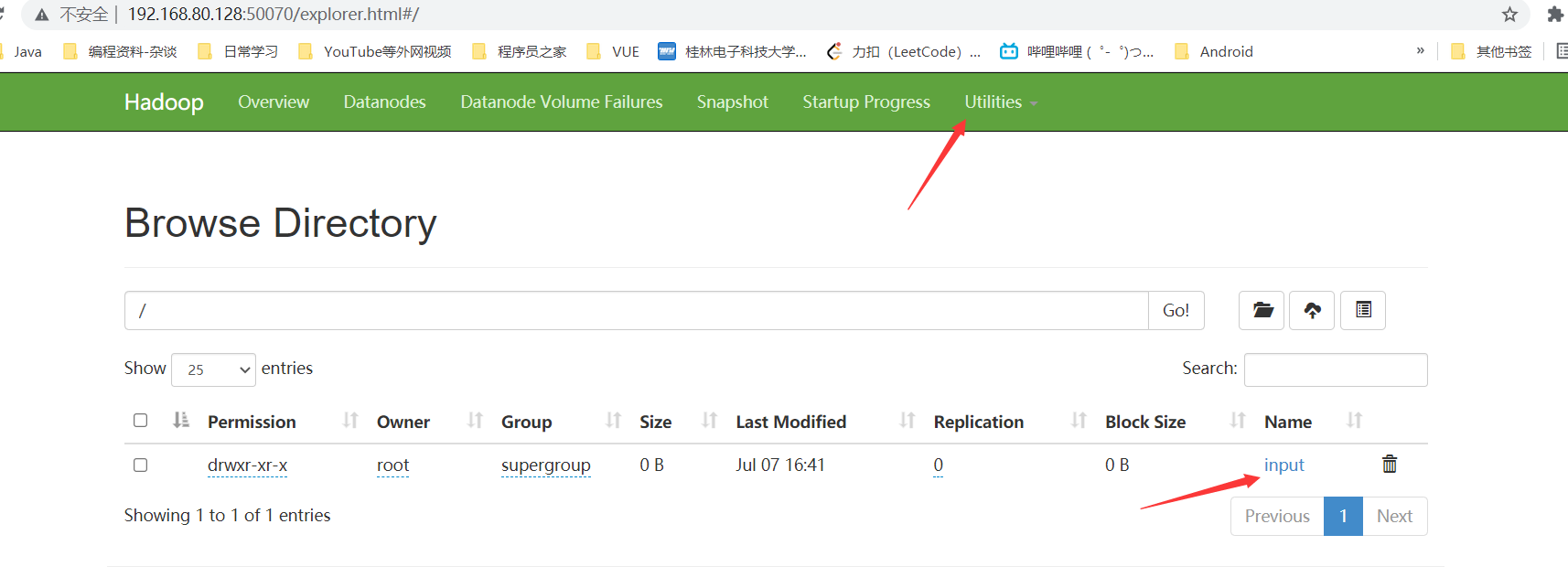

①创建input文件夹

hadoop fs -mkdir /input

在端口50070中可以查看到已经创建的文件夹

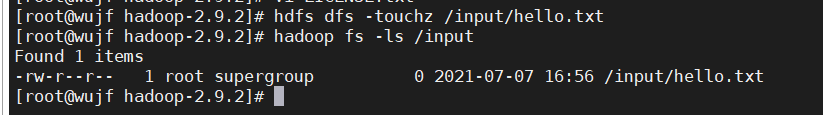

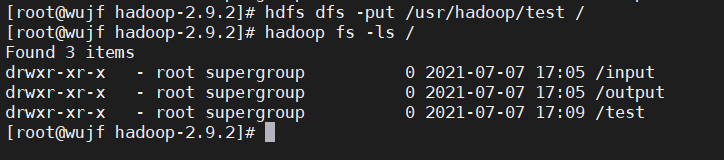

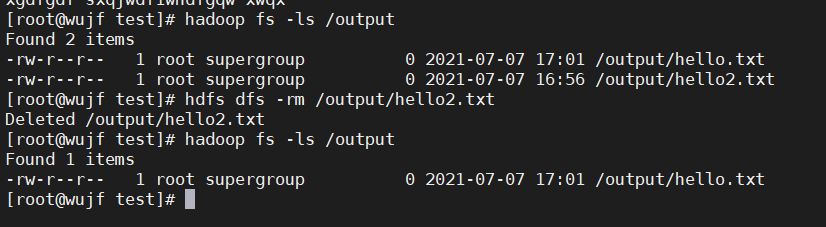

②查看列表文件夹

#hdfs dfs -ls 路径

hadoop fs -ls /

③创建文件

#hdfs dfs -touchz 路径

hdfs dfs -touchz /input/hello.txt

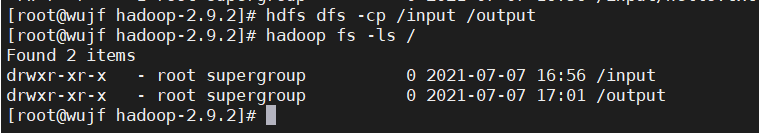

④复制文件

#hdfs dfs -cp 源目录 目标目录

hdfs dfs -cp /input /output

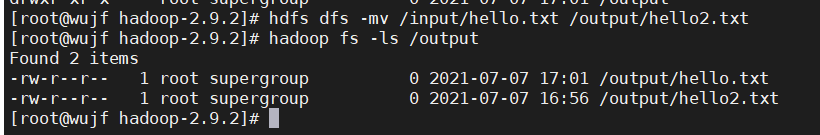

⑤移动文件

#hdfs dfs -mv 源目录 目标目录

hdfs dfs -mv /input/hello.txt /output/hello2.txt

⑥上传文件

#hdfs dfs -put 源文件夹 目标文件夹

hdfs dfs -put /usr/hadoop/test /

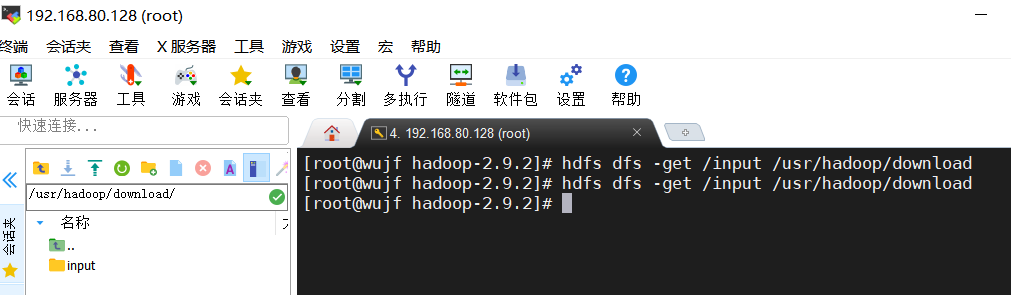

⑦下载文件

#hdfs dfs -get 源文件夹 目标文件夹hdfs dfs -get /input /usr/hadoop/download

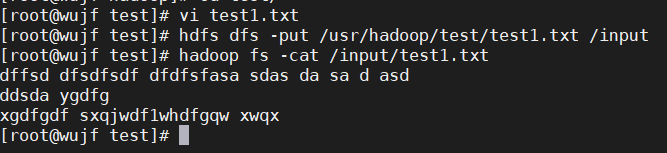

⑧显示文件内容(先上传一个有内容的txt文本)

--上传的test1.txt 的文本内容--

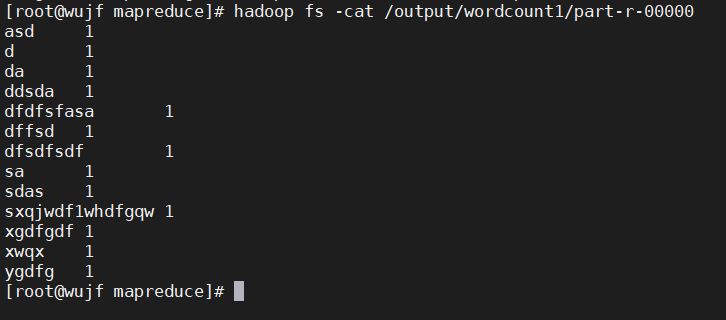

dffsd dfsdfsdf dfdfsfasa sdas da sa d asdddsda ygdfgxgdfgdf sxqjwdf1whdfgqw xwqx

#hadoop fs -cat 路径 #从头查看 #hadoop fs -tail 路径 #从尾查看hadoop fs -cat /input/test1.txthadoop fs -tail /input/test1.txt

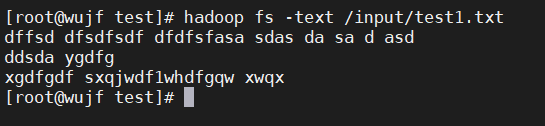

#hadoop fs -text 路径hadoop fs -text /input/test1.txt

⑨删除文件

#hdfs dfs -rm 目标文件 #rm不可以删除文件夹#hdfs dfs -rm -R 目标文件 #递归删除(慎用)hdfs dfs -rm /output/hello2.txt

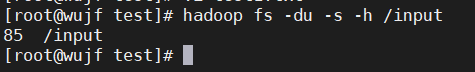

⑩统计文件夹大小信息

#hadoop fs -du -s -h 路径hadoop fs -du -s -h /input

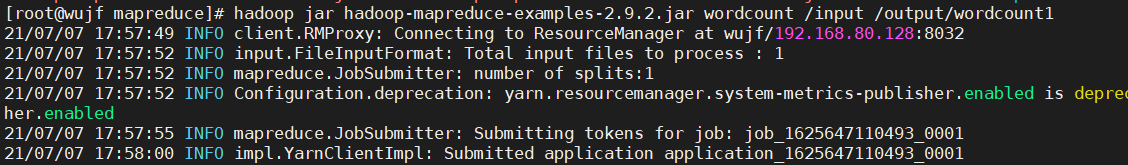

搭建完成之后的一个小玩意

运行统计的一个脚本

脚本路径 hadoop->share->hadoop->mapreduce

#hadoop jar hadoop-mapreduce-examples-2.9.2.jar wordcount 源路径 目标路径hadoop jar hadoop-mapreduce-examples-2.9.2.jar wordcount /input /output/wordcount1

查看运行脚本统计出的单词数

hadoop fs -cat /output/wordcount1/part-r-00000

浙公网安备 33010602011771号

浙公网安备 33010602011771号