SparkStandalone--HA搭建

不需要设置master在哪个节点上,只要在配置了HA模式的Spark集群上,任何一台机器都可以启动Master

需要先启动zookeeper

zkServer.sh start

三台节点

[root@node1 conf]# pwd

/opt/app/spark-2.3.1/conf

[root@node1 conf]# mv spark-env.sh.template spark-env.sh

[root@node1 conf]# mv slaves.template slaves

[root@node1 conf]# vim slaves

{

node1

node2

node3

}

[root@node1 conf]# vim spark-env.sh

{

export SPARK_MASTER_WEBUI_PORT=8888

# 高可用需要用到哪些节点

export SPARK_DAEMON_JAVA_OPTS="-Dspark.deploy.recoveryMode=ZOOKEEPER -Dspark.deploy.zookeeper.url=node1:2181,node2:2181,node3:2181 -Dspark.deploy.zookeeper.dir=/spark-ha"

}

[root@node1 sbin]# pwd

/opt/app/spark-2.3.1/sbin

[root@node1 sbin]# vi spark-config.sh

{

export JAVA_HOME=/opt/app/jdk1.8.0_321

}

[root@node1 sbin]# mv start-all.sh start-spark-all.sh

[root@node1 sbin]# mv stop-all.sh stop-spark-all.sh

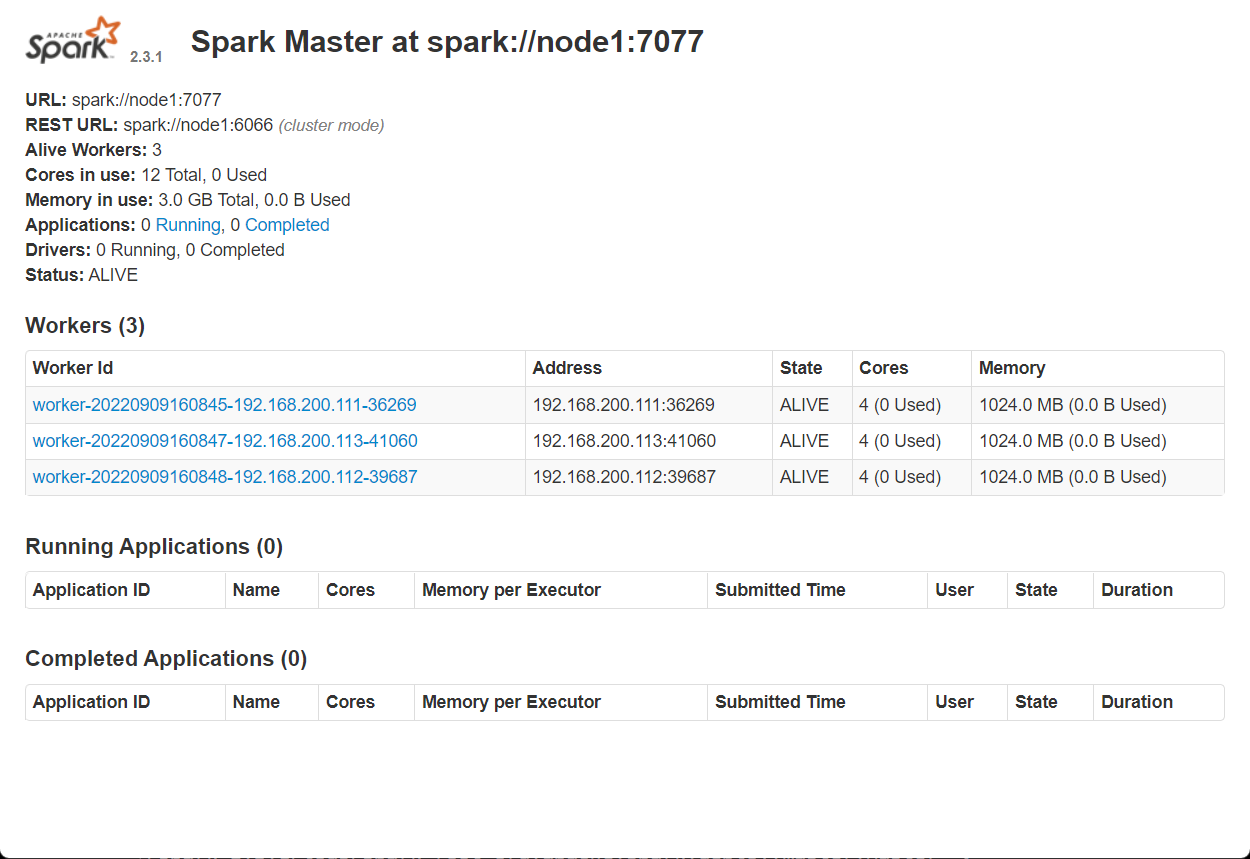

访问地址

http://192.168.200.111:8888/

启动任意多个Master

[node2]# start-master.sh

[node3]# start-master.sh

本文来自博客园,作者:jsqup,转载请注明原文链接:https://www.cnblogs.com/jsqup/p/16673164.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号