当集群中的空间不够时,增加结点动态扩容(服役新节点) (在不关机的情况下,增加一台datanode)

克隆

克隆当前的虚拟机

修改3台虚拟机的ip地址和主机名

vim /etc/sysconfig/network-scripts/ifcfg-ens33

将IPADDR修改为192.168.200.225

重新启动网络服务使其生效

systemctl restart network

配置主机名的映射

vi /etc/hostname

将克隆的node1修改为new

vi /etc/hosts

增加

192.168.200.226

重启reboot

ssh的免密登录

cd /root/.ssh

ssh-keygen -t rsa

敲三个回车

执行命令ssh-copy-id node1

执行命令ssh-copy-id node1

删除metaData

[root@new hadoop-2.8.5]# pwd

/opt/app/hadoop-2.8.5

[root@new hadoop-2.8.5]# rm -rf metaData/

在hdfs的namenode所在结点的Hadoop的安装目录的etc/hadoop目录下创建一个dfs.hosts文件 填写dfs需要的服役的节点信息

[root@node1 hadoop]# touch dfs.hosts

[root@node1 hadoop]# vi dfs.hosts

node1

new

在namenode所在节点的hdfs-site.xml文件中,增加一个配置项dfs.hosts值指向我们刚刚创建的dfs.hosts文件

[root@node1 hadoop]# vi hdfs-site.xml

<!--dfs.hosts代表改文件中的地址都为白名单,可以访问NameNode节点,与NameNode节点通信-->

<property>

<name>dfs.hosts</name>

<value>/opt/app/hadoop-2.8.5/etc/hadoop/dfs.hosts</value>

</property>

刷新节点状态信息

在namenode结点执行hdfs dfsadmin -refreshNodes刷新数据节点状态信息

开启datanode节点

在新节点通过hadoop-daemon.sh start datanode开启dn

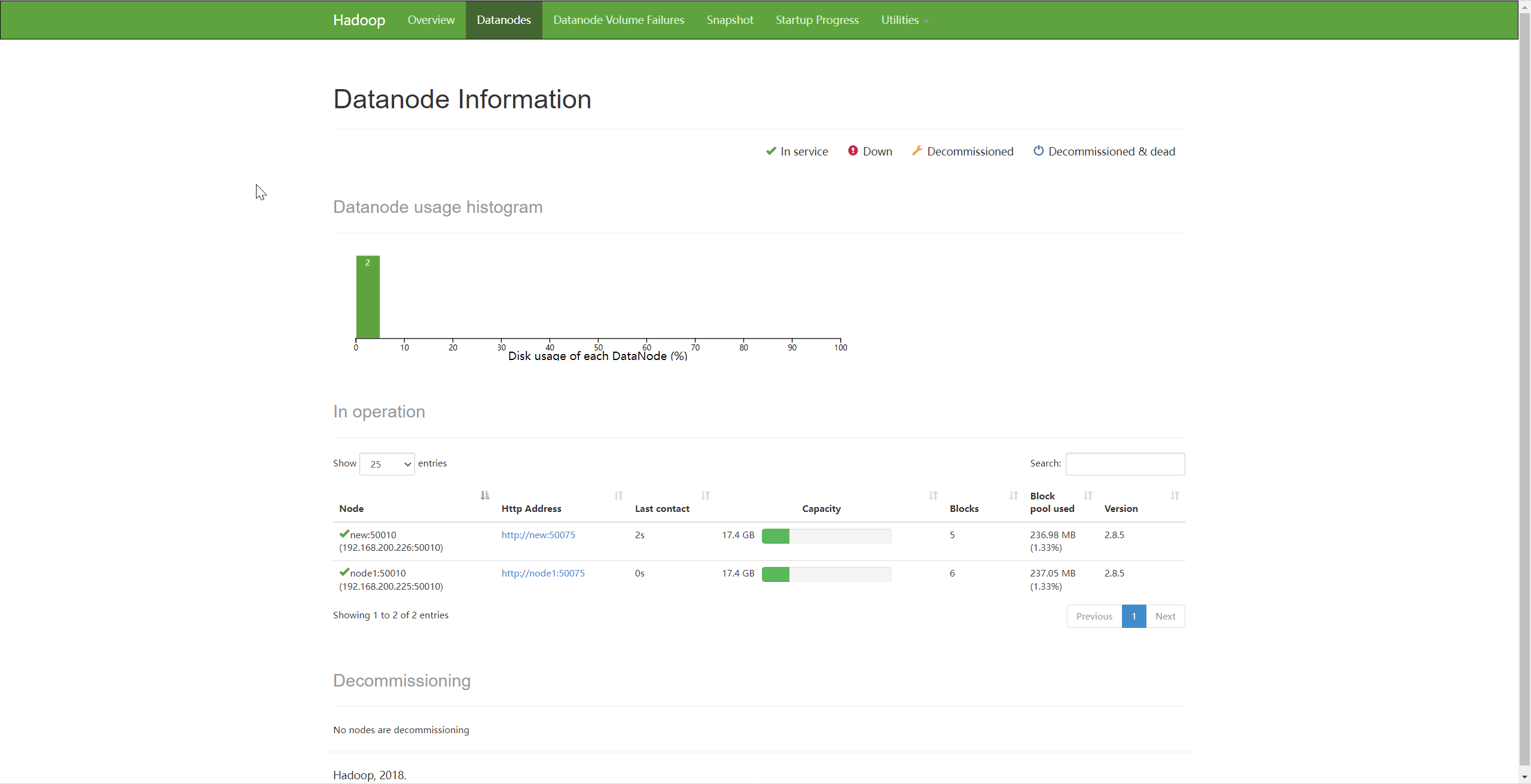

增加服役节点成功

本文来自博客园,作者:jsqup,转载请注明原文链接:https://www.cnblogs.com/jsqup/p/16502918.html

浙公网安备 33010602011771号

浙公网安备 33010602011771号