idea配置本地spark本地开发环境

2020-08-22 13:47 倪平凡 阅读(1824) 评论(0) 收藏 举报1.配置JDK

省略

2.配置scala

省略

3.配置hadoop

1.下载所需要的hadoop版本,并解压

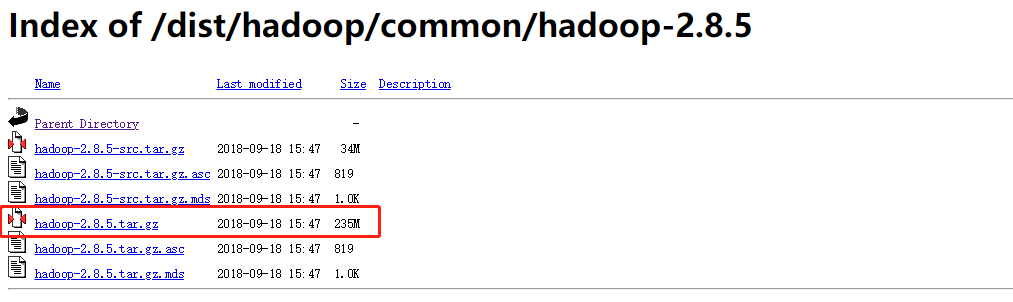

https://archive.apache.org/dist/hadoop/common/

下载之后解压到一个目录下,例如: F:\bigdata\software\hadoop-2.8.5

2.配置环境变量

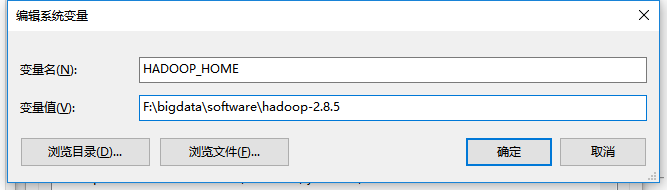

编辑系统环境变量,配置HADOOP_HOME

Path中添加:%HADOOP_HOME%\bin

3.替换HADOOP_HOME/bin下的文件

下述链接下载winutils-master,解压,获取和自己hadoop对应的版本,将其bin下的所有文件拷贝至HADOOP/bin下,并将重复的替换掉

链接:https://pan.baidu.com/s/11TiFjgd6qmBUJW9kIHPS4g

提取码:1111

4.配置spark

1.下载和hadoop对应的spark版本

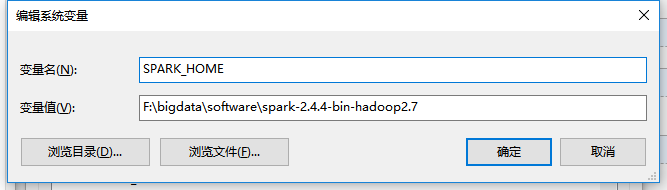

2.解压,配置环境变量

系统环境变量配置SPARK_HOME:

Path中添加:%SPARK_HOME%\bin

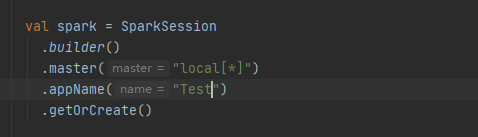

5.idea本地开发

浙公网安备 33010602011771号

浙公网安备 33010602011771号