机器学习周刊第五期:一个离谱的数据可视化Python库、可交互式动画学概率统计、机器学习最全文档、快速部署机器学习应用的开源项目、Redis 之父的最新文章

这个网站用可视化的方式讲解概率和统计基础知识,很多内容还是可交互的,非常生动形象。

大家好,欢迎收看第五期机器学习周刊

本期介绍7个内容,涉及Python、概率统计、机器学习、大模型等,目录如下:

- 一个离谱的Python库

- 看见概率,看见统计

- 2024机器学习最强文档

- Gradio

- 顶级程序员如何使用LLM

- TinyLlama

- 微软宣布利用大型语言模型改进文本嵌入

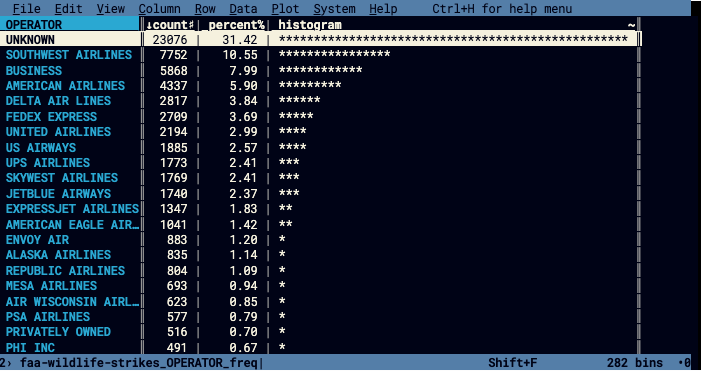

1、一个离谱的Python库

地址:https://www.visidata.org/docs/

pip3 install visidata

VisiData是一款免费的开源工具,可让您在计算机终端中快速打开、探索、汇总和分析数据集。VisiData 可处理 CSV 文件、Excel 电子表格、SQL 数据库和许多其他数据源。

界面如下所示:

甚至还能在命令行中做可视化,酷是真酷,就是看了半天不清楚有什么使用场景。

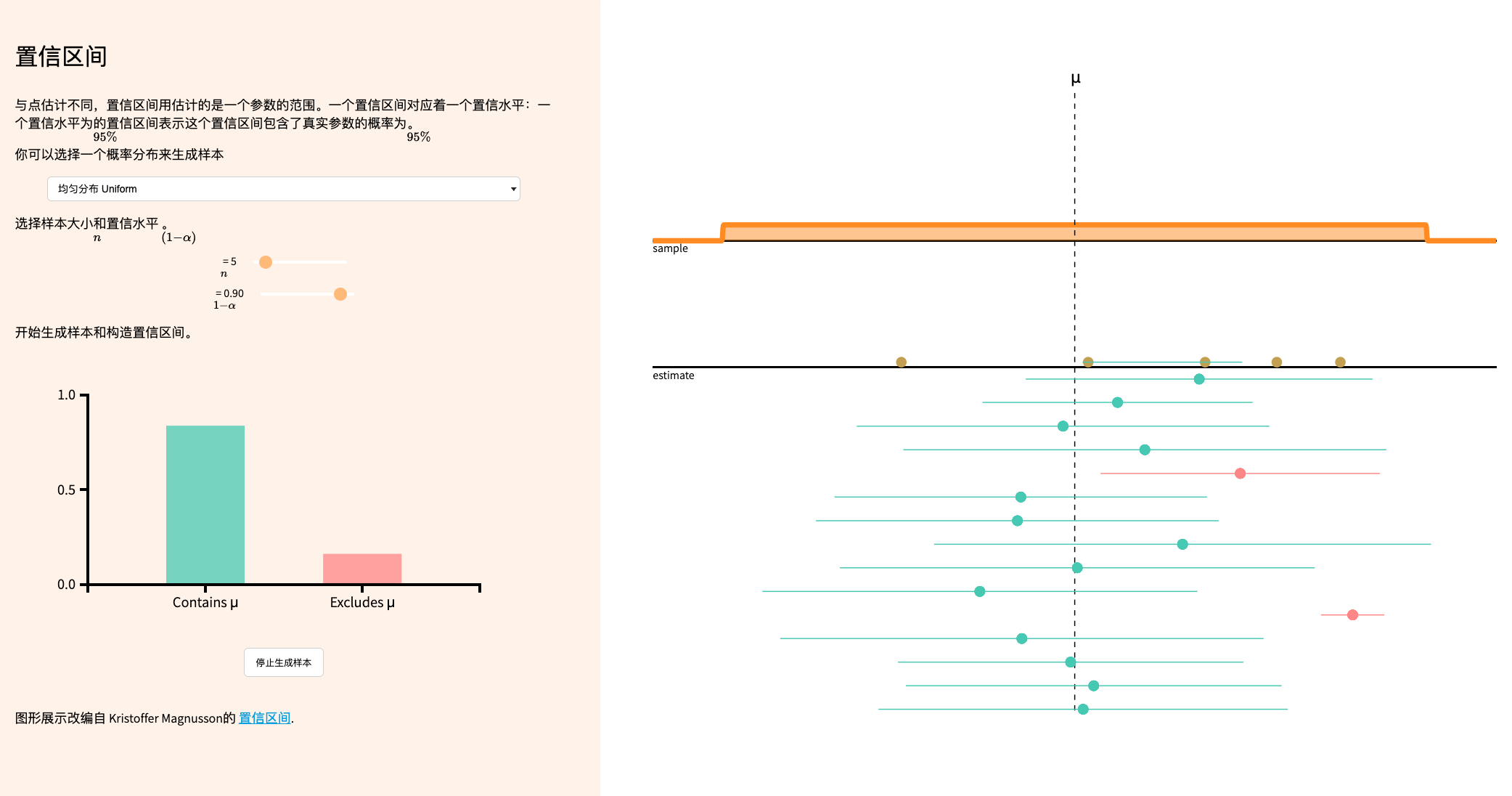

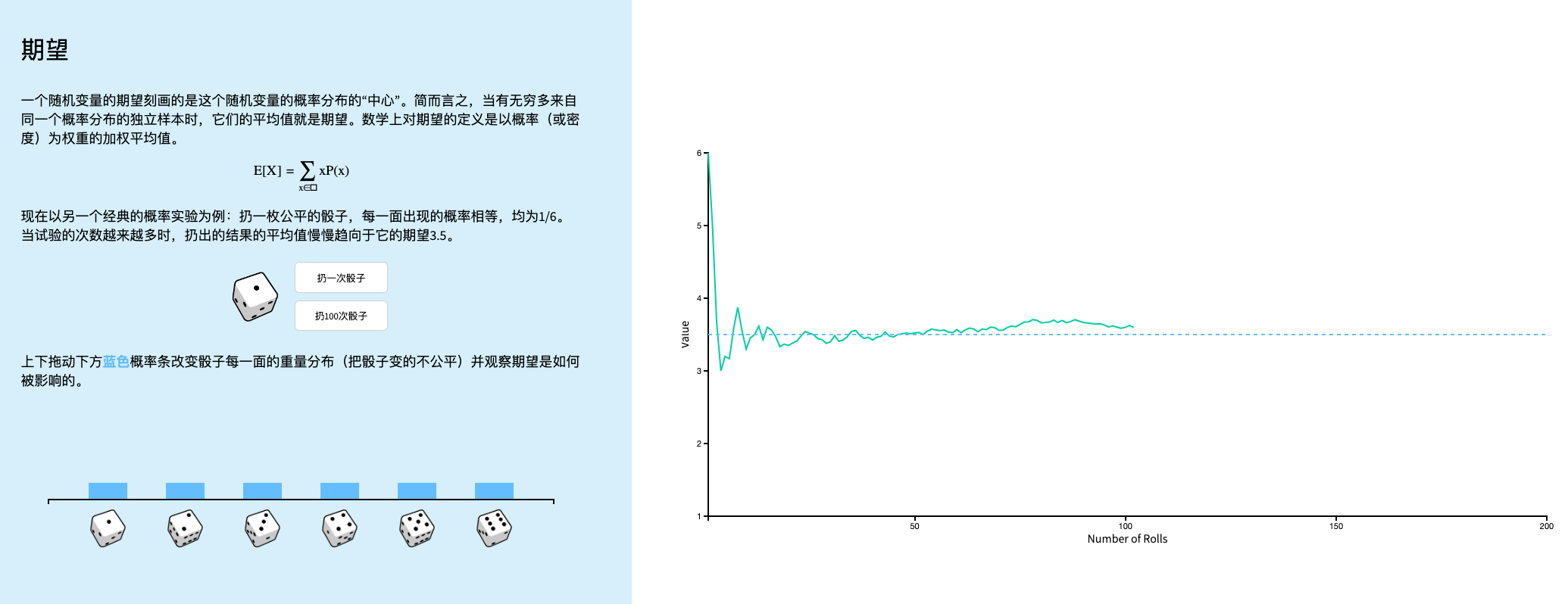

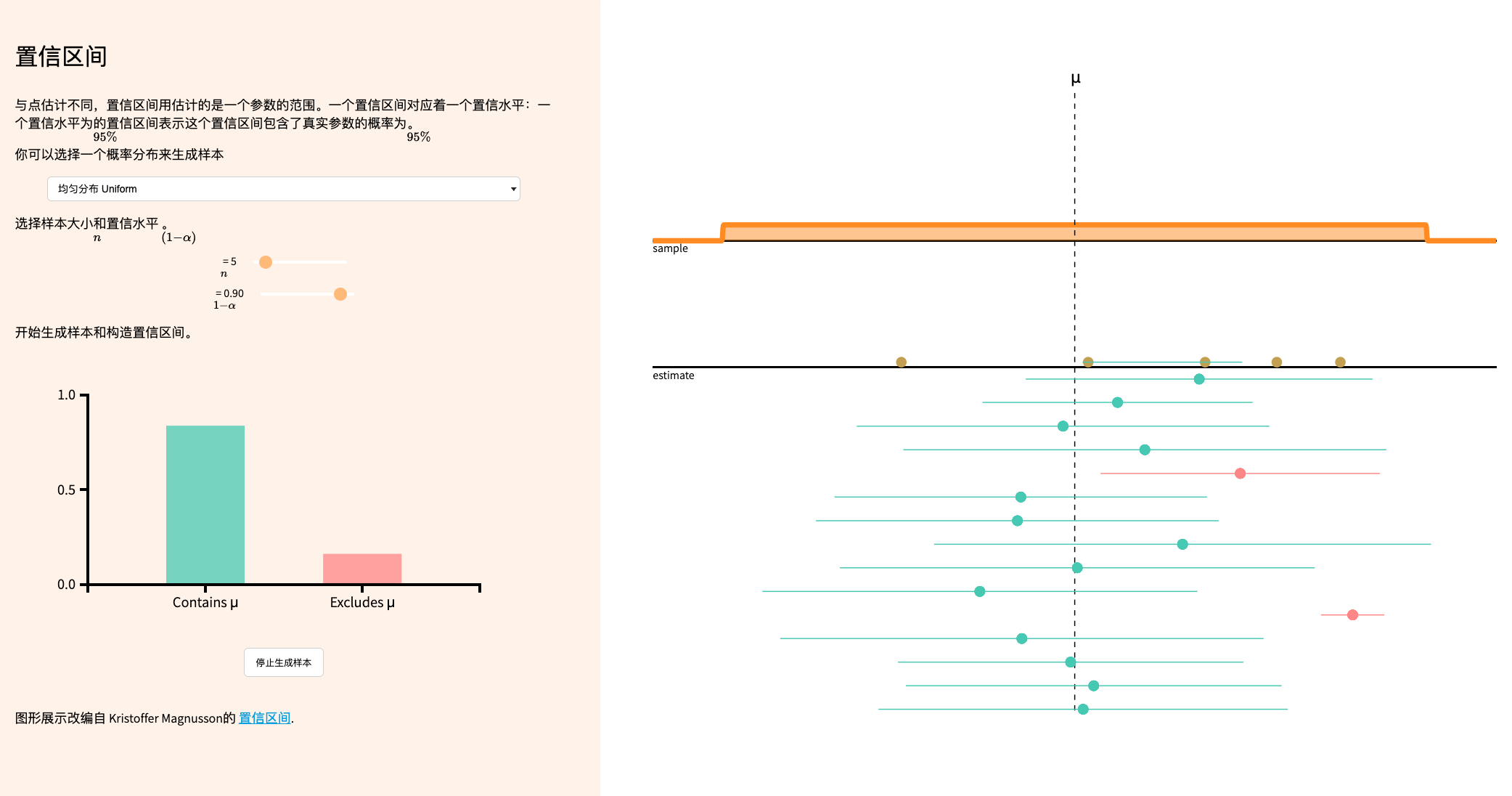

2、看见概率,看见统计

地址:https://seeing-theory.brown.edu/basic-probability/cn.html

这个网站用可视化的方式讲解概率和统计基础知识,很多内容还是可交互的,非常生动形象。

章节目录如下:

- 基础概率论

- 进阶概率论

- 概率分布

- 统计推断:频率学派

- 统计推断:贝叶斯学派

- 回归分析

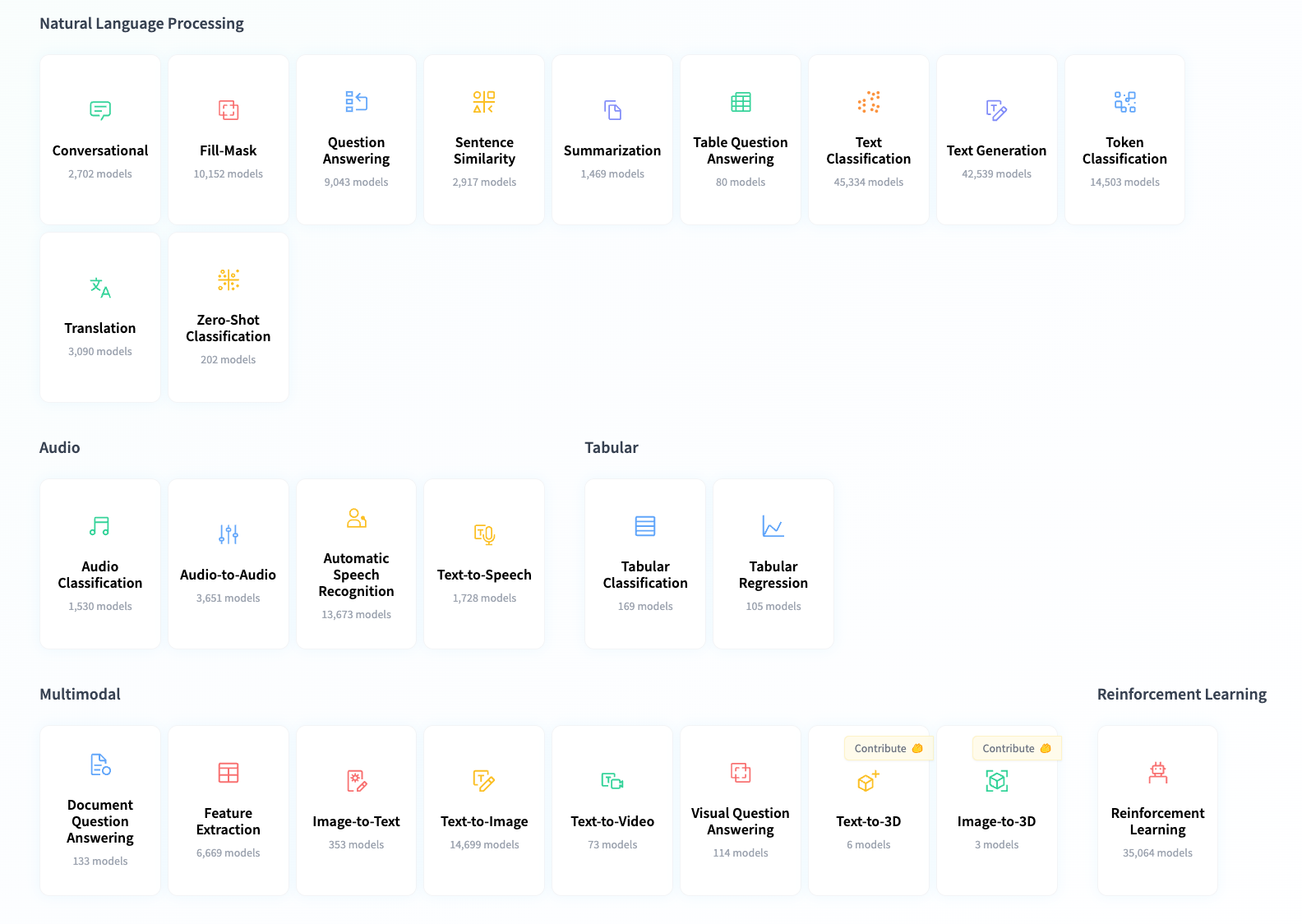

3、2024机器学习最强文档

地址:https://huggingface.co/tasks

HuggingFace这个页面我愿称之为机器学习最强文档,囊括了各种机器学习任务,比如表格数据预测、NLP、机器视觉、音频、多模态、强化学习等任务所需的全部内容(演示、用例、模型、数据集等等)

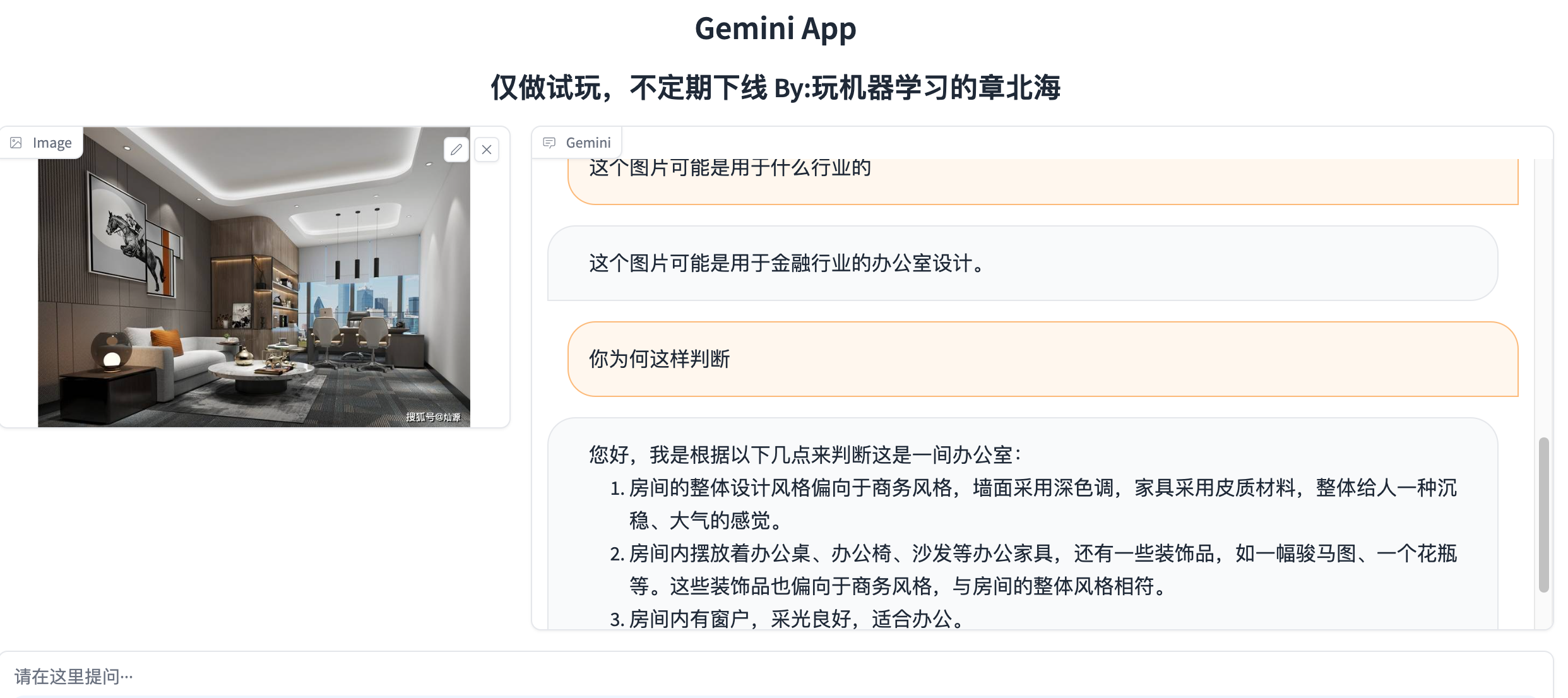

4、G𝚛𝚊𝚍𝚒𝚘

Gradio是一个可以快速部署机器学习应用的开源项目,我用它做过很多小工具。如果你第一次听说gradio,强烈建议赶快用起来。最近它更新到了4.13版,完美兼容Python 3.12 。

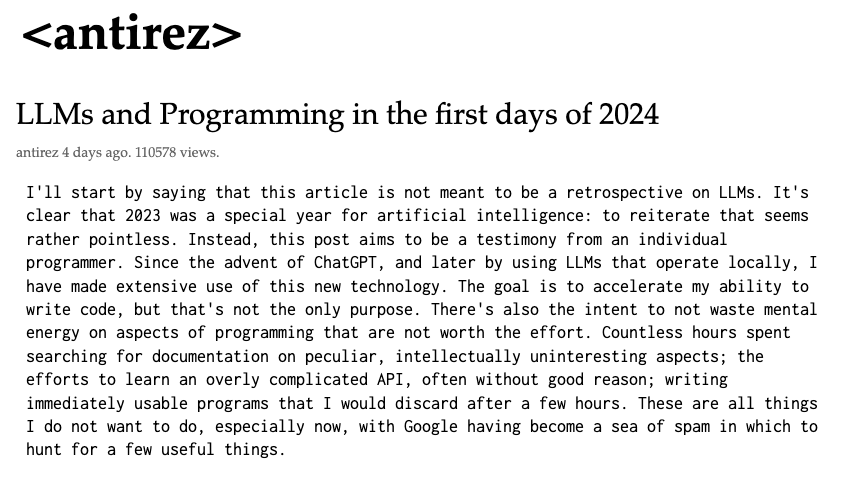

5、Redis 之父的最新文章

地址:http://antirez.com/news/140

翻译:https://blog.zhanglearning.com/posts/2024年初的LLMs与编程/

Redis 作者写了篇文章,非常详细地分享他在工作中使用 LLM 编程的体验,我们可以一窥顶级程序员是如何使用大模型的。这篇文章很我让ChatGPT提取了摘要,用Claude-2-100K完成了翻译,我没有做校对:

- 在2023年,人工智能尤其是可以在设备上本地使用的LLMs取得了显著的进步,作者广泛利用这项技术来加速他的编程能力。

- 起初,作者主要使用LLMs来处理文档和避免在编程中的无聊/不感兴趣的部分。然而,随着时间的推移,他学会了何时使用LLMs最有帮助,以及何时它们可能会减慢他的速度。

- LLMs在推理和插值方面的能力有限,它们不能超越它们被训练的内容。虽然它们不能替代人类程序员,但如果适当使用,它们可以是有用的辅助工具。

- 作者提供了几个例子,展示了LLMs如何帮助他更快地编写代码,例如在框架之间切换、用一种不熟悉的语言编程,或分析他不完全理解的网络输出时。

- 当任务虽然无聊但对作者的目标有用时,LLMs也适用于编写一次性/临时脚本。

- 系统编程需要更强的推理能力,这通常是LLMs所缺乏的。作者提供了一个例子,其中LLMs在提供相关代码时,仍然难以解释一个低级别的数据格式。

- 总之,LLMs最好被用作程序员的辅助工具而不是替代品。有了经验,人们可以学习如何以及何时有效地利用它们来处理不同的编程任务。但它们的能力仍然有限,并且可能不会扩展到所有领域,比如系统编程。

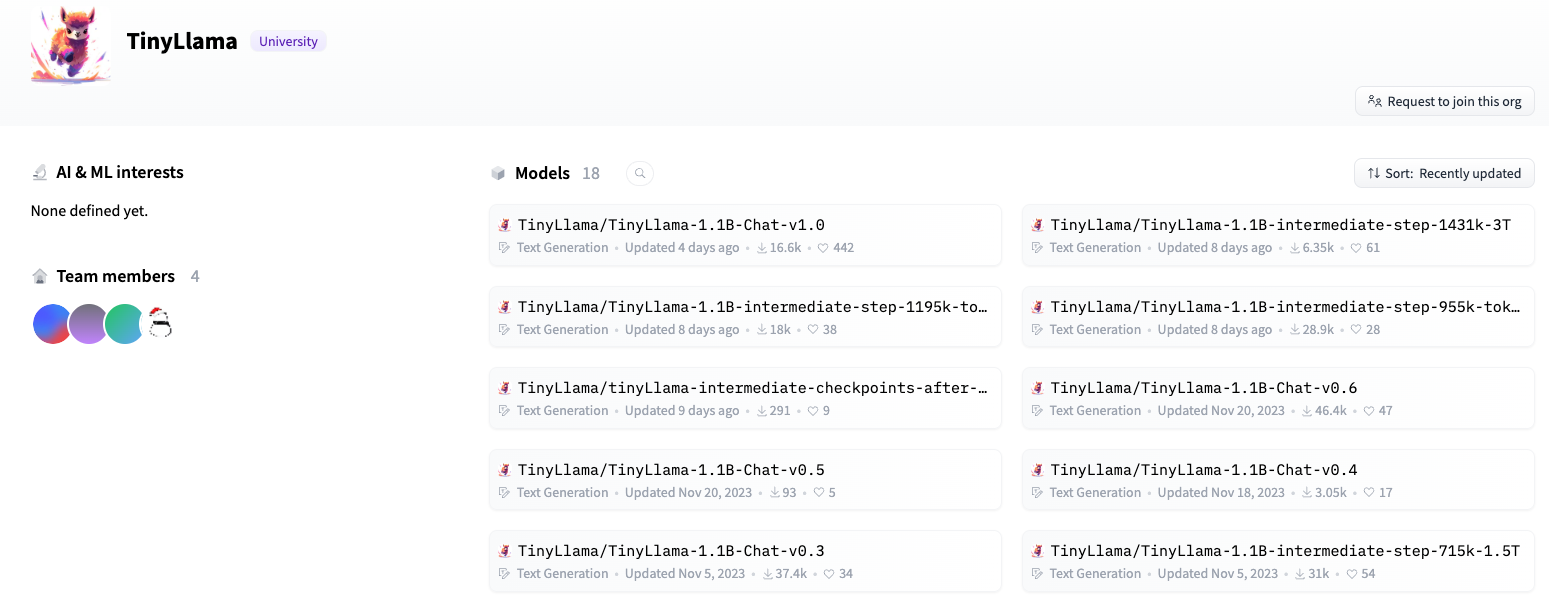

6、TinyLlama

模型地址:https://huggingface.co/TinyLlama

TinyLlama 发布1.0版本,1.1B 参数,基于3万亿 tokens 训练,与 LLaMa 2 完全相同的架构和分词器,

从他们的Github能看到完整的训练过程。

7、微软宣布利用大型语言模型改进文本嵌入

论文: https://arxiv.org/pdf/2401.00368.pdf

最后推荐一篇微软最近发布的论文,介绍了一种新颖且简单的方法,该方法不需要构建复杂的训练管道或依赖于手动收集的数据集,仅使用合成数据和少于 1k 的训练步骤即可获得高质量的文本嵌入。

浙公网安备 33010602011771号

浙公网安备 33010602011771号