数据中心网络

云计算

与云计算相对的是传统计算。在传统计算的背景下,如果我们需要假设服务器,必须自己购买硬件资源,如CPU、硬盘、网卡等。然而在当今信息爆炸的时代,自己花费资金去购买并维护大型的服务器机房是非常不划算的。

在云计算的背景下,云计算服务商为我们提供了所有的软硬件资源,如果我们需要假设服务器,只需要向云计算服务商租用即可。云计算服务商的机房就叫做数据中心,云计算的出现推动了数据中心网络的发展。

IaaS、Paas、SaaS

- IaaS: Infrastructure-as-a-Service(基础设施即服务)

- PaaS: Platform-as-a-Service(平台即服务)

- SaaS: Software-as-a-Service(软件即服务)

公有云、私有云和混合云

- 公有云:这是云计算部署最常见的一种方式。计算资源由第三方云服务提供商拥有和运营。来自不同组织的企业或个人,共享资源池中的资源。

- 私有云:计算资源由第三方或组织自己拥有和运营。所有的计算资源,只面向一个组织开放。这种方式资源独占,安全性更高。

- 混合云:公有云+私有云。例如,平时业务不多时,使用私有云资源,当业务高峰期时,临时租用公有云资源。这是一种成本和安全的折中方案。

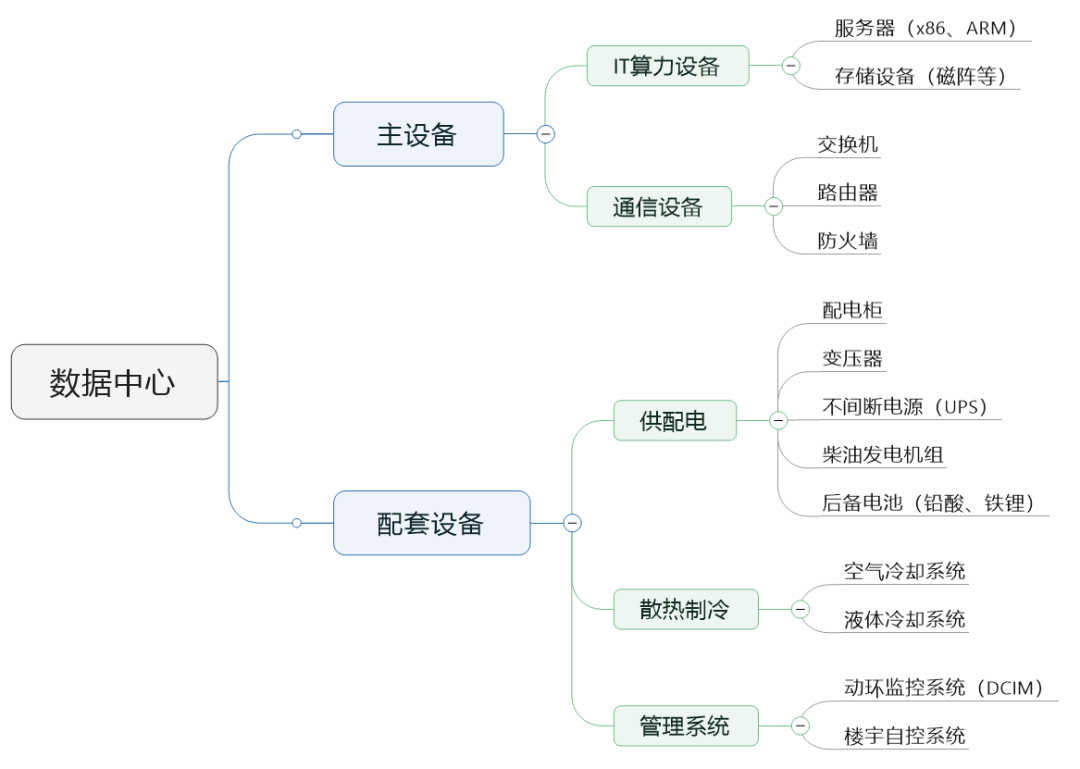

数据中心

IDC:Internet Data Center

数据中心网络的三大要素

我们所有的手机、电脑、超算本质上都在处理三件事:计算、存储和通信。

计算:CPU——GPU——NPU,集中式——分布式

存储:机械硬盘——固态硬盘

通信:网线——光纤,电交换——光交换,传统树型拓扑——新型拓扑,TCP/IP——RDMA

网线——光纤

- 速度:光在二氧化硅中的传播速度:2亿米/秒,非直线传输;电在铜线中的传播速度:2.3亿米/秒,直线传输。

- 带宽:光的频率可以很高,复用范围宽,带宽可达10Tbit/s;电的频率较低,复用范围小,带宽可达10Gbit/s。

- 传输距离:光信号衰减小,干扰小,传输距离100km;高频电信号用于长距离传输时信号衰减快、易受干扰,传输距离100m。

目前基本上都实现了光纤入户(FTTH),有些甚至实现了光纤入屋(FTTR)。

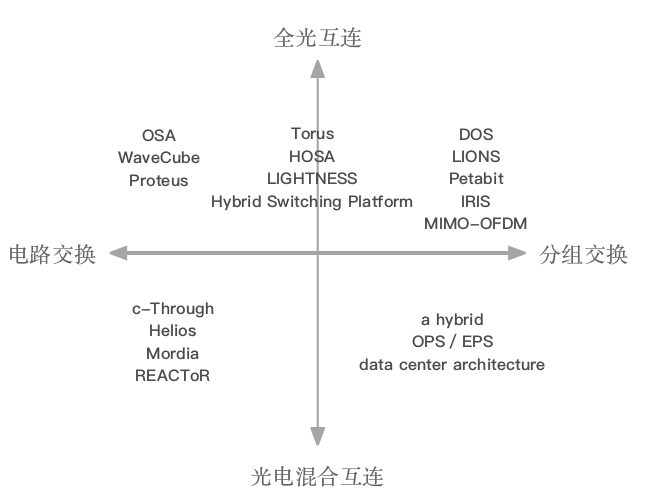

电交换——光交换

光电混合互连

光电混合互连是目前采用的主要技术,即在传输过程中使用光,而在交换节点上使用电,但是这就需要在交换节点上进行光电和电光转换。

光路交换技术

对应于电路交换(CS域)。

空分、时分、波分、码分

分组交换技术

对应于分组交换(PS域)。

优点

- 光纤中承载的是光信号,通过光交换机时无需进行光电和电光转化。可以减少光电变换的损伤,提高信号质量。

- 运行与信号速率无关。光交换机仅仅是将光信号反射而不考虑速率,设备速率可随传输速率的扩展而扩展。可以不受电交换时电子器件速度的限制,提高信号交换的速度。

缺点

- 扩展性差。这些架构最多提供数千个交换端口,无法实现服务器级的全光互连。在这些网络中,仍然需要使用少量电交换机完成机架内互连或簇内互连。

- 全光器件发展不成熟。缺乏深度和快速光记忆器件,且光器件的集成度较低。

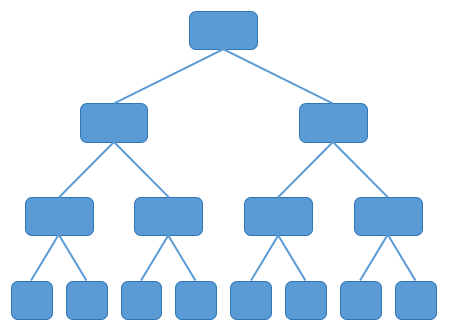

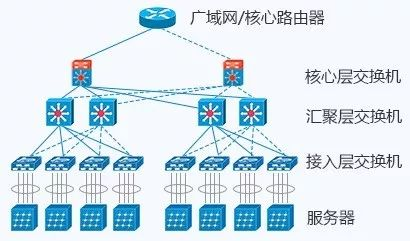

传统树型拓扑——新型拓扑

传统树型拓扑

流量汇聚问题:核心层交换设备需要处理大量来自底层的数据,从而使得根节点处的链路带宽成为制约整个网络性能的通信瓶颈。

Fat-tree拓扑

Fat-tree是目前主流的拓扑结构。

基本理念:使用大量低性能的交换机,构建出大规模的无阻塞网络,对于任意的通信模式,总有路径让他们的通信带宽达到网卡带宽。

缺点

- 扩展性差。扩展规模在理论上受限于核心交换机的端口数目,不利于数据中心的长期发展要求。

- 容错性差。对底层交换设备故障非常敏感,当底层交换设备故障时,难以保证服务质量。

- 东西向通信能力弱。拓扑结构的特点决定了网络不能很好的支持one-to-all及all-to-all网络通信模式,不利于部署MapReduce、Dryad等现代高性能应用,目前的数据中心通信从南北向通信向东西向通信转变。

- 交换机数量多。网络中交换机与服务器的比值较大,即使对于交换机的性能要求不高,但数量导致的网络设备成本依然很高。

Dcell、Bcube

以交换机为中心的拓扑结构不适合进行东西向通信,因此出现了以服务器为中心的拓扑结构,如Dcell、Bcube等。

但这种结构使用的交换机数量较多,增加了设备成本。

TCP/IP——RDMA

TCP/IP

缺点:

- 高时延。TCP/IP协议栈在接收/发送报文时,内核需要做多次上下文切换,每次切换需要耗费5us~10us左右的时延。

- CPU高负载。TCP/IP网络需要主机CPU多次参与协议栈内存拷贝,网络规模越大,带宽越高,CPU在收发数据时的调度负担就越大,导致CPU持续高负载。

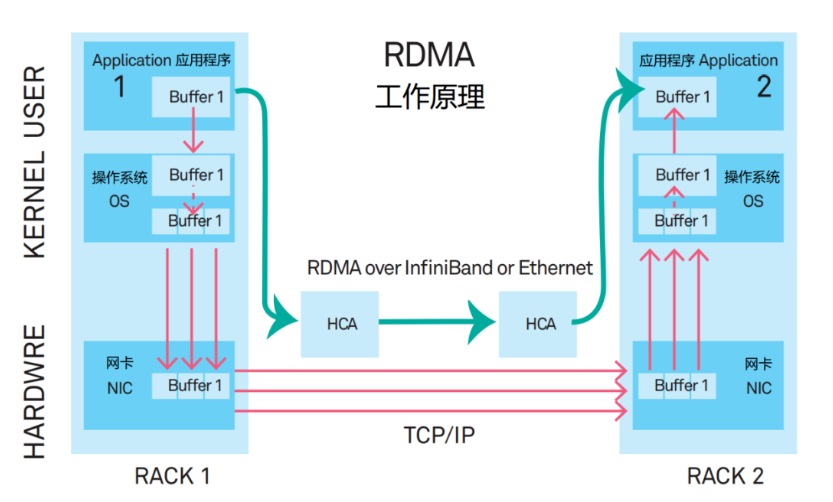

RDMA

优点:

- 低时延。RDMA的内核旁路机制,允许应用与网卡之间的直接数据读写,将服务器内的数据传输时延降低到接近1us。

- CPU低负载。RDMA的内存零拷贝机制,允许接收端直接从发送端的内存读取数据,极大的减少了CPU的负担,提升CPU的效率。

承载方式

Infiniband

- 封闭架构,私有协议

- 无法兼容现网,运维复杂

- 不需要设计完善的丢包保护机制,InfiniBand可以实现无损无丢包。

Ethernet

- 标准化已完成

- 兼容性好,易运维

- 需要解决丢包问题,否则RDMA性能急剧下降。————超融合数据中心网络智能无损技术。

浙公网安备 33010602011771号

浙公网安备 33010602011771号