RLChina2022-实践课三:强化学习算法

MDP算法

MDP被定义为一个元组(S,A,P,r,R)

S:所有状态集合

A:在环境力里面智能体所作动作的集合

P:状态转移函数P(s'|s,a),智能体在当前s下,执行a之后,转移到是s'的概率

R:奖励函数R(s,a),表示在环境s下执行动作a之后获得的立即奖励,有时候还需要知道s'是多少才能共同决定奖励是多少。

r:折损因子[0,1]取值,对未来奖励进行折损,符合人类更加看重当下的奖励行为;另外使收益不是无限大,使迭代停止

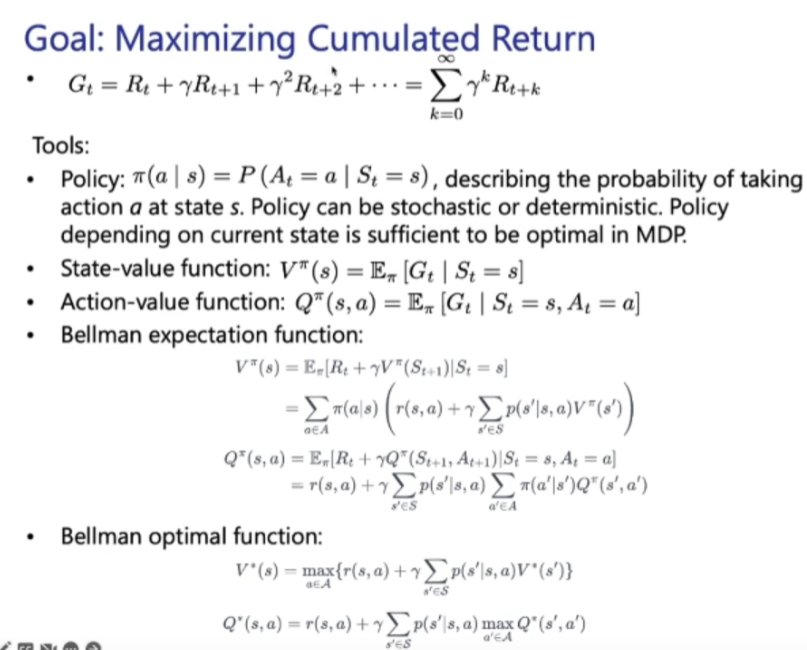

贝尔曼期望函数、贝尔曼最优函数