Ceph 故障修复记录(持续更新)

2019-05-17 18:13 云物互联 阅读(590) 评论(0) 收藏 举报目录

问题:故障域与副本数导致的 PG 不正常

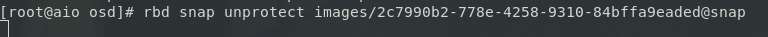

缘起:执行 rbd snap unprotect 执行卡死。

调查:Ceph 集群 PG 不正常。

原因:因为该环境是一个 All-in-one 的环境,CRUSH bucket 默认为 Host 级别,与此同时 Pool: default.rgw.control 的 Replication Size: 3,min_size: 2。在这样的前提下就要求 Ceph 集群中至少必须存在 2 个节点,在数据写入的时候写入到 2 个不同的故障域中,以此来保证高可用特性。

解决:将 Pool: default.rgw.control 的 min_size 设置为 1。

ceph osd pool set default.rgw.control min_size 1

转载请注明作者:JmilkFan 范桂飓

浙公网安备 33010602011771号

浙公网安备 33010602011771号